Hadoop综合大作业

1.用Hive对英文长篇小说进行词频统计。

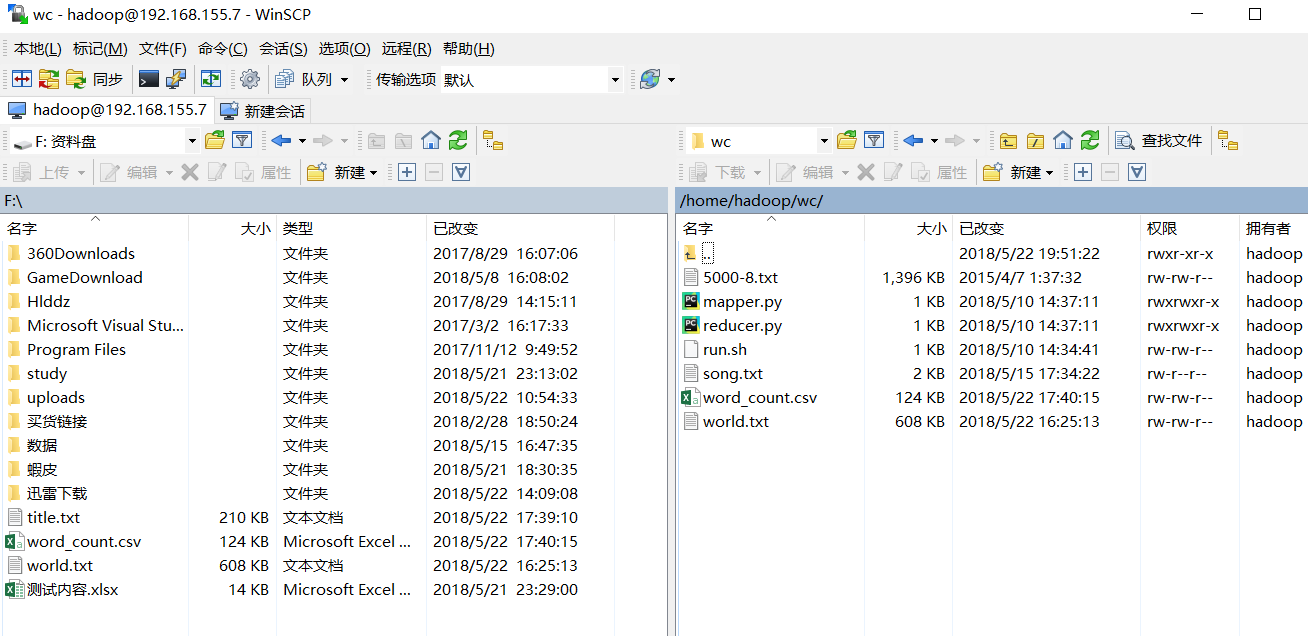

- 利用WinSCP 英语长篇小说文本文件放于 /home/hadoop/wc 目录下:

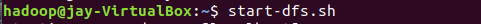

- 启动hadoop:

- 上传到hdfs/data文件中

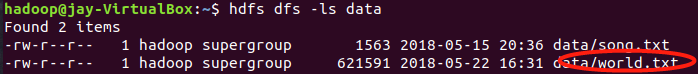

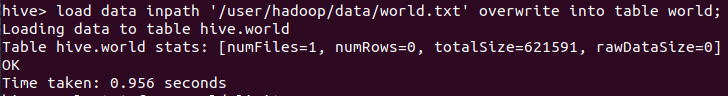

- 启动Hive

- 在hive数据库创建表 world:

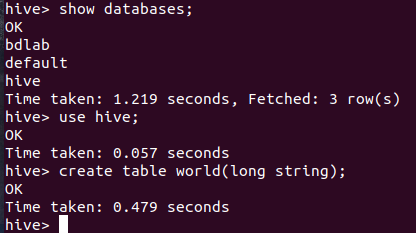

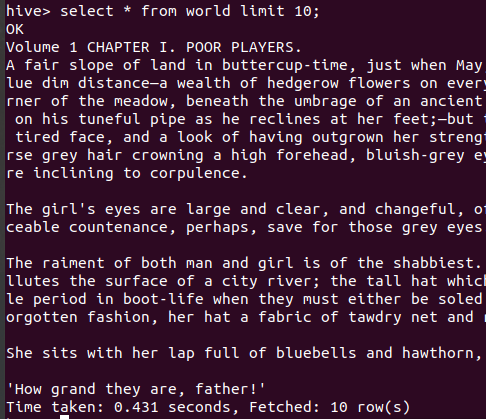

- 导入文本world.txt并查看:

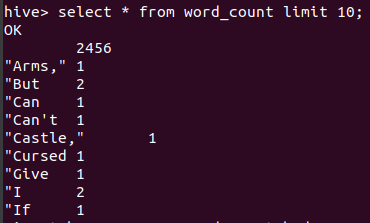

- 用HQL进行词频统计并保持到表 word_count

2.用Hive对爬虫大作业产生的csv文件进行数据分析

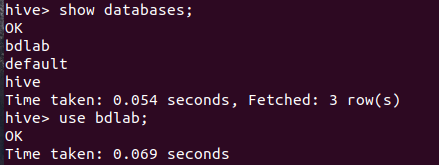

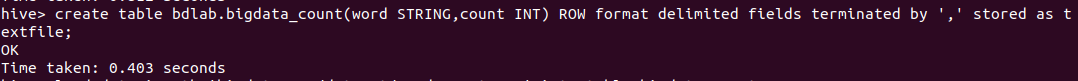

- 同上,将爬虫大作业产生的csv文件放入bdlab数据库表bigdata_count中:

- 创建用于存放csv数据目录:

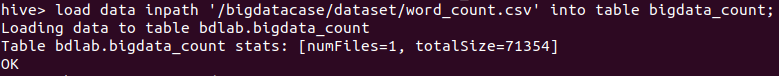

- 把文件放入文件夹中

- 查看文件中的数据:

- 导入数据库表中

- 查看数据:

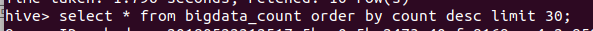

- 分析数据,取得数据表中count计数前30位数据:

可以看出大多数字眼都是围绕C# JAVA 数据库 net 等!

浙公网安备 33010602011771号

浙公网安备 33010602011771号