信息的度量

信息(information)

信息是消息或信号随机变化中的“不确定性”,是消息中包含的本质内容。确定的消息中不含有信息。

必应老师说

信息量(information content)

信息的度量

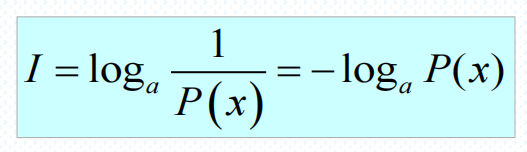

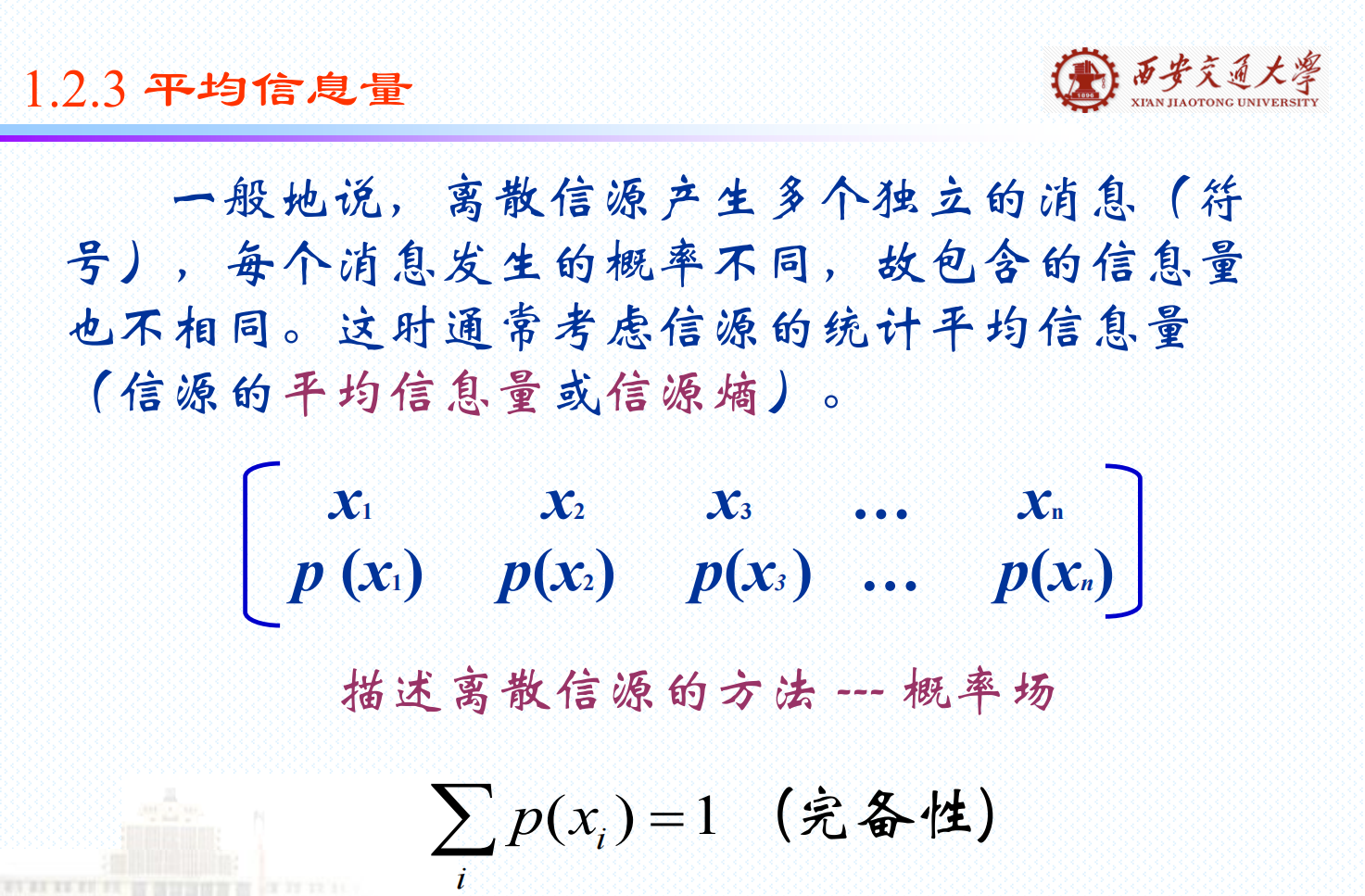

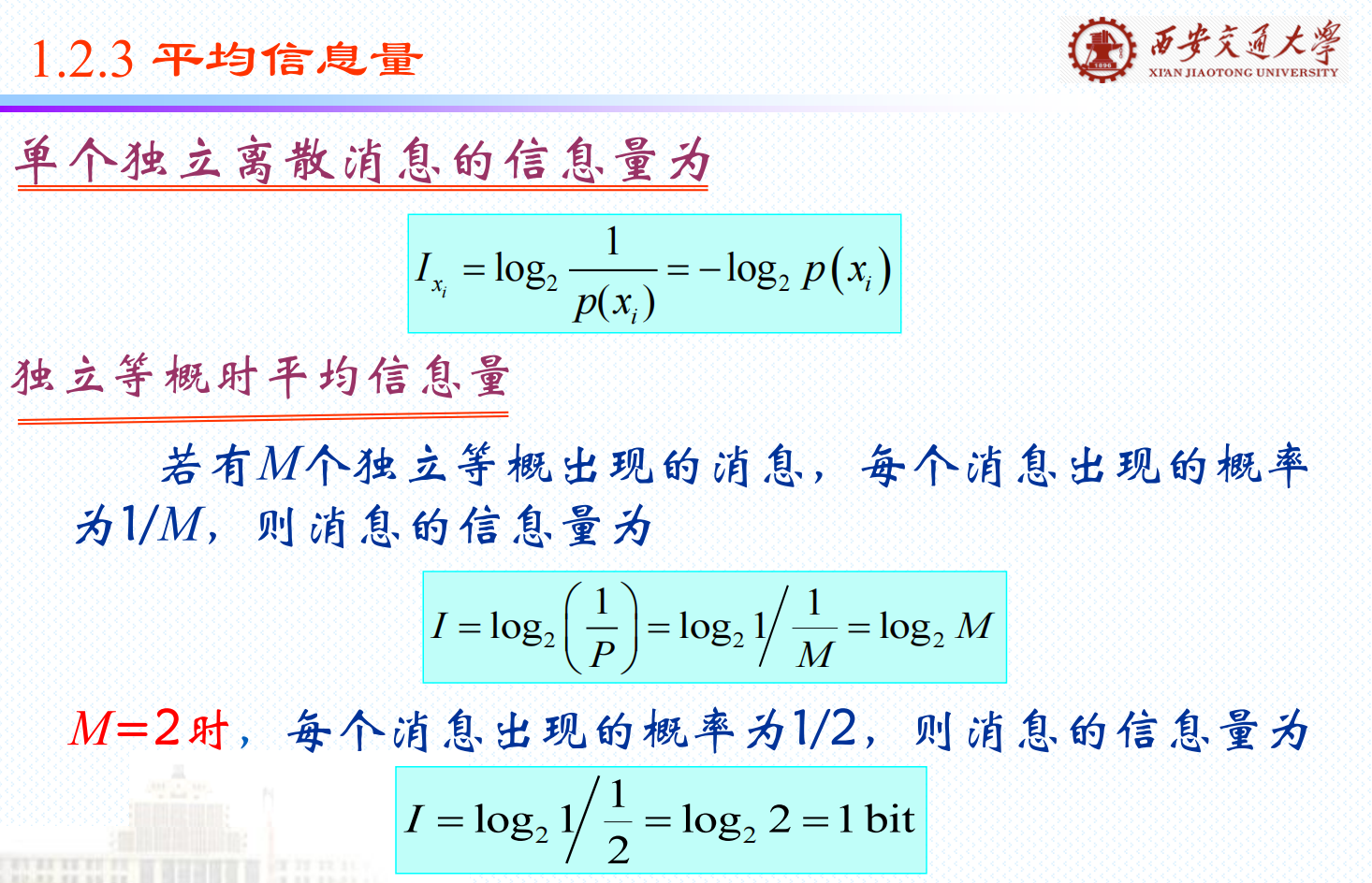

(1)信息量 I 是概率P(x)的函数。

(2) P(x)越小,I 越大;反之,I 越小。

P(x) =1,I 为零; P(x) =0,I 为无穷大。

(3)若干个互相独立事件构成的消息,所含信息量等

于各独立事件信息量之和。—— 信息具有可加性。

- 自然推出用一下关系表示

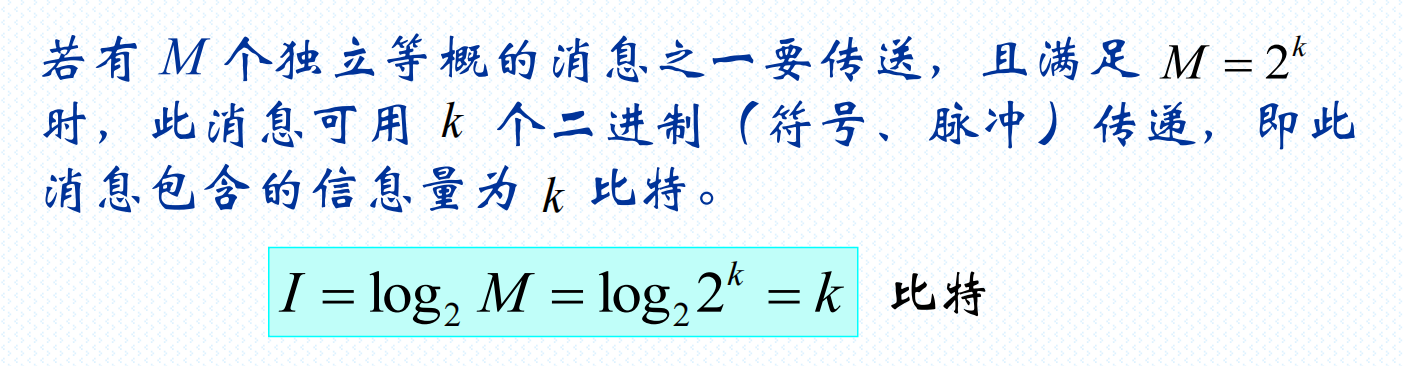

即:消息包含的信息量为消息出现概率的倒数的对数。

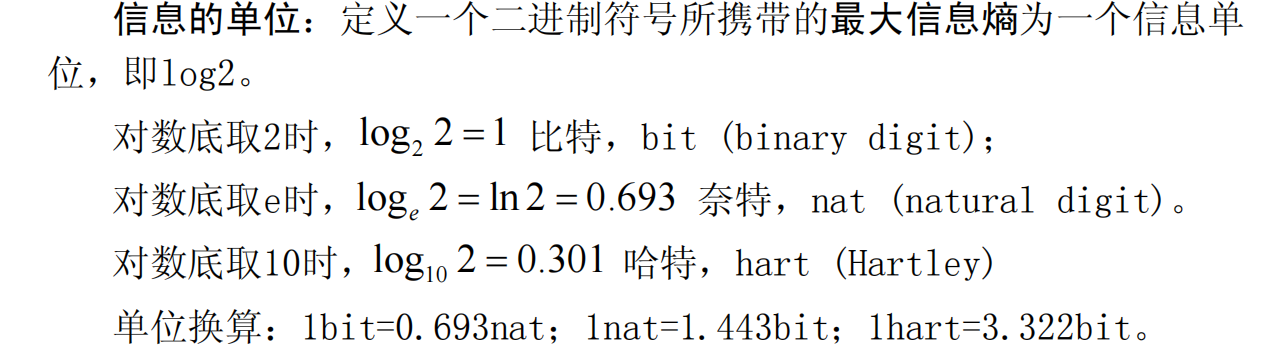

单位

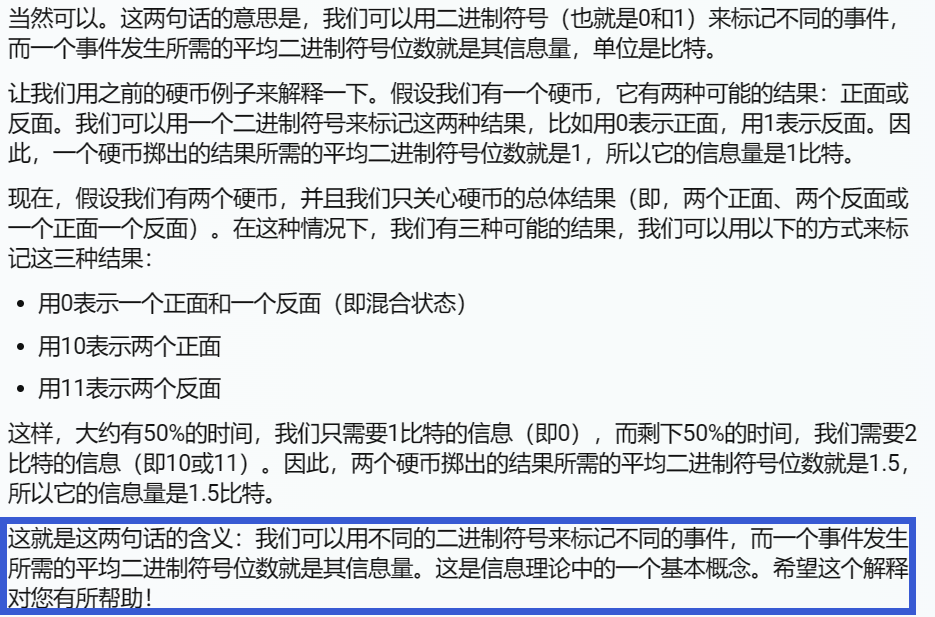

掷硬币

熵

一个系统的熵是我们对该系统状态的不确定性。它是完全描述系统状态所需的预期比特数。在两枚硬币翻转的例子中,我们对结果有 1.5 比特的不确定性。如果有一场有 8 匹马参加的赛马比赛,而我们对每匹马一无所知,那么我们对比赛结果的不确定性就是 3 比特。

信息

信息,简单地说,就是在获得新知识的情况下,我们的不确定性降低了多少。在赛马比赛中,如果我发现有四匹马获胜的几率为零,那么我的不确定性就会降低到两个比特。因此,这将是一个比特的信息。如果有人告诉我,我掷出的两枚硬币是一样的,这又会是多少信息呢?

信息必须是关于某种事物的

信息必须是可获取的,并且是关于我们正在测量的熵的情况的,这样的信息才不会为零。我们可以被告知,欧罗巴上有七万亿加仑的水,这在某些情况下是信息,但在试图预测赛马结果时就不是了。同样,一本历史教科书可能会帮助我们减少对英国第十七任国王的不确定性,但如果不是用我们熟悉的语言编写,它的作用就微乎其微了。

信息是物理的

所有信息都必须有某种形式的物理实例,无论是纸上的墨水、计算机中的内存状态,甚至是你大脑中神经元的状态。信息是两个物理对象之间的关联。例如,一个城市的街道可能与该城市地图上的线条相关,因此地图可以给我们关于该城市的信息。

信息是相互的

因为信息是两个物理事物之间的关联,所以它也是双向的。如果A给了我们关于B的3比特信息,B也会给我们关于A的3比特信息。从我们之前的例子来看,如果一张地图给了我们关于一个城市的信息,那么这个城市本身也会给我们同样多的关于地图的信息。

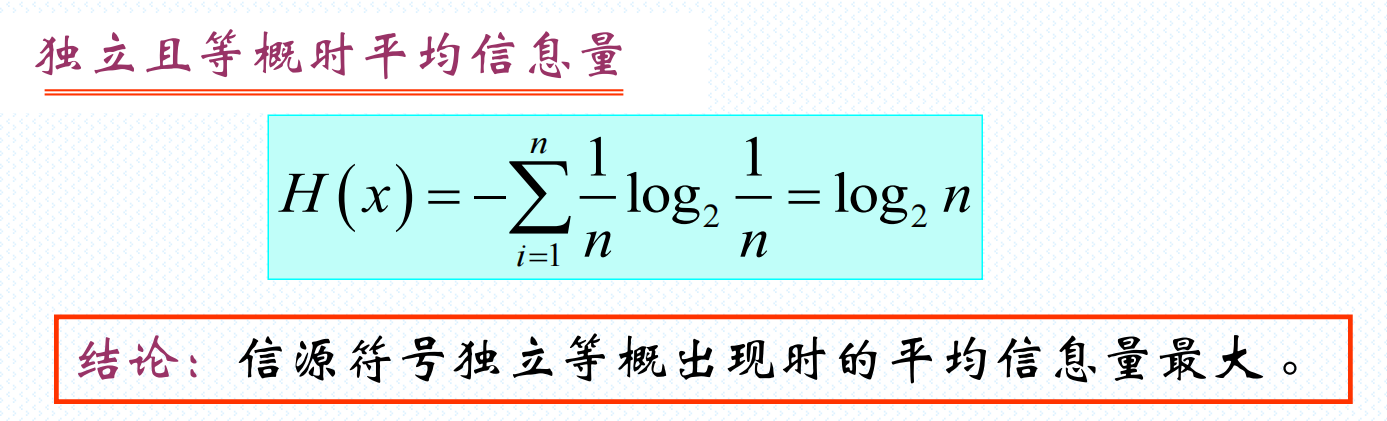

计算熵

如果情况X的所有n个可能的结果是同等可能的,那么我们关于哪一个将会发生的不确定性可以通过H(X) log2(n)比特来计算这对于8匹马是清楚的,log2(8) 3。如果所有的概率都不相等,我们该怎么办?

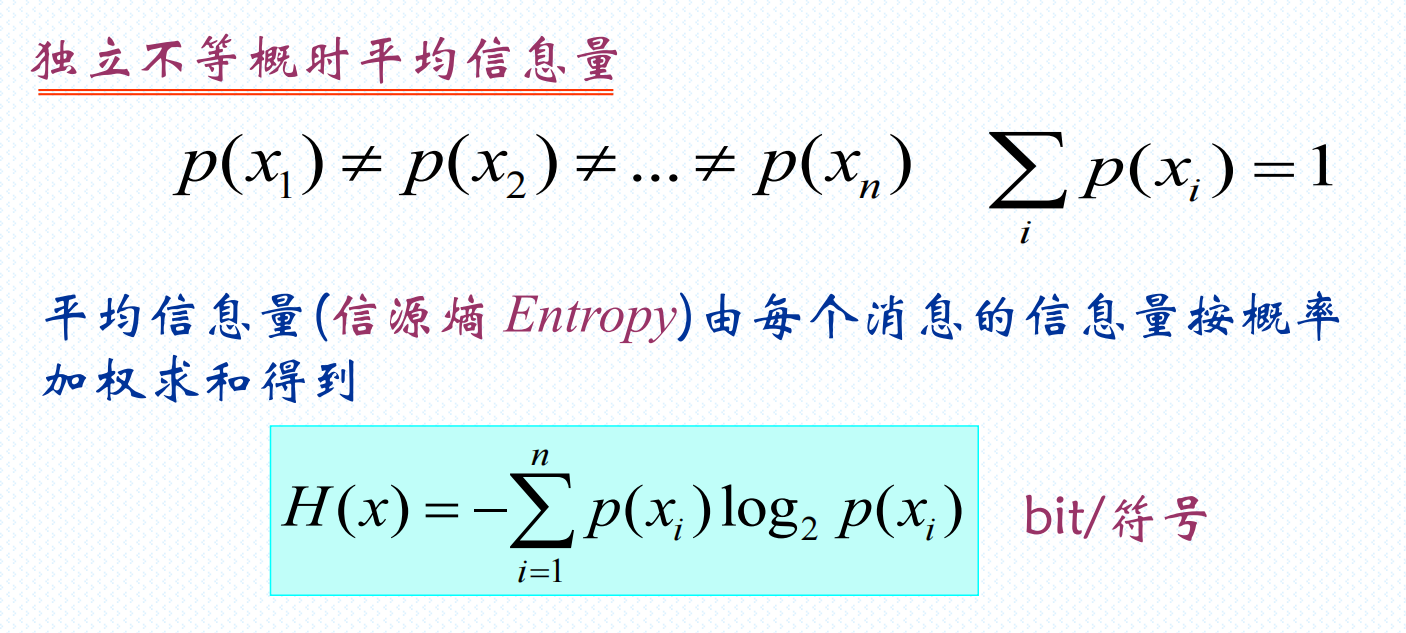

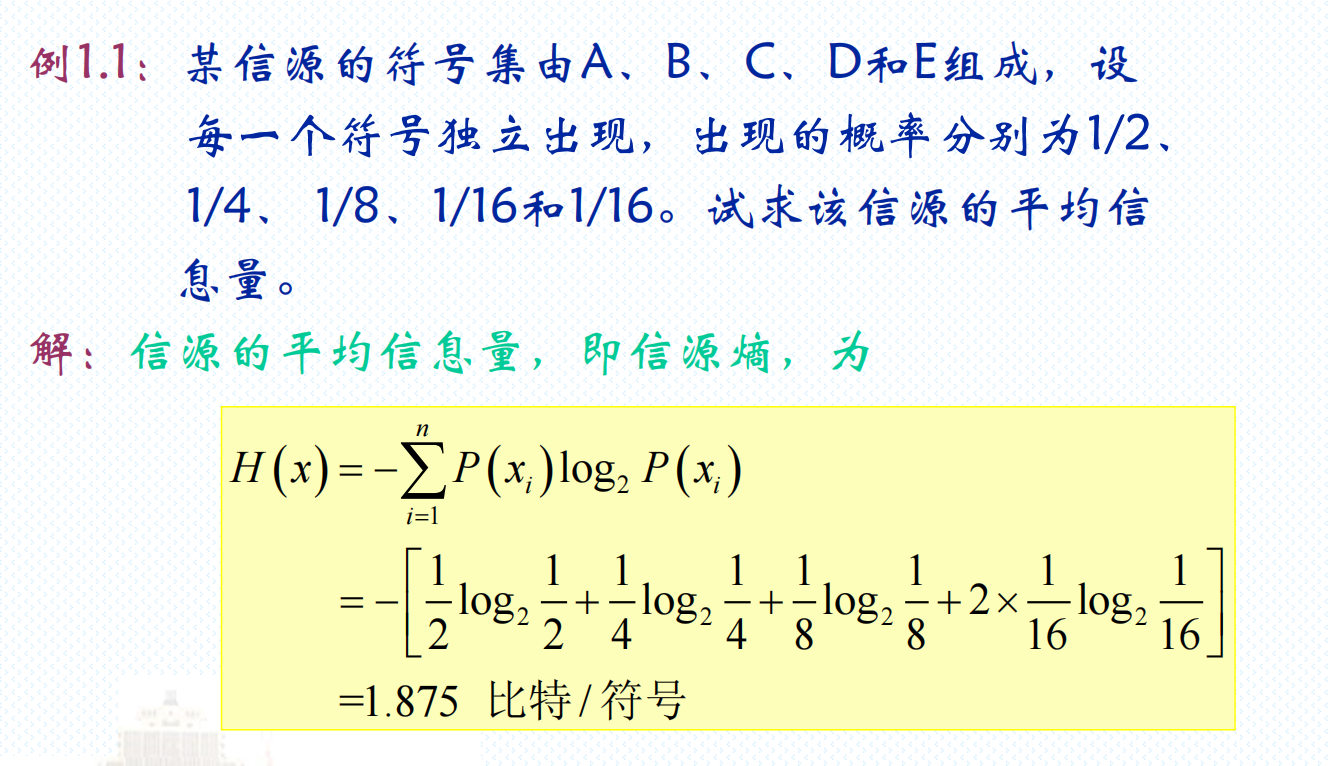

平均信息量

以上均为离散情况