深度学习中常见的损失函数分为两种:分类损失和回归损失

Log loss即交叉熵损失:https://blog.csdn.net/google19890102/article/details/79496256

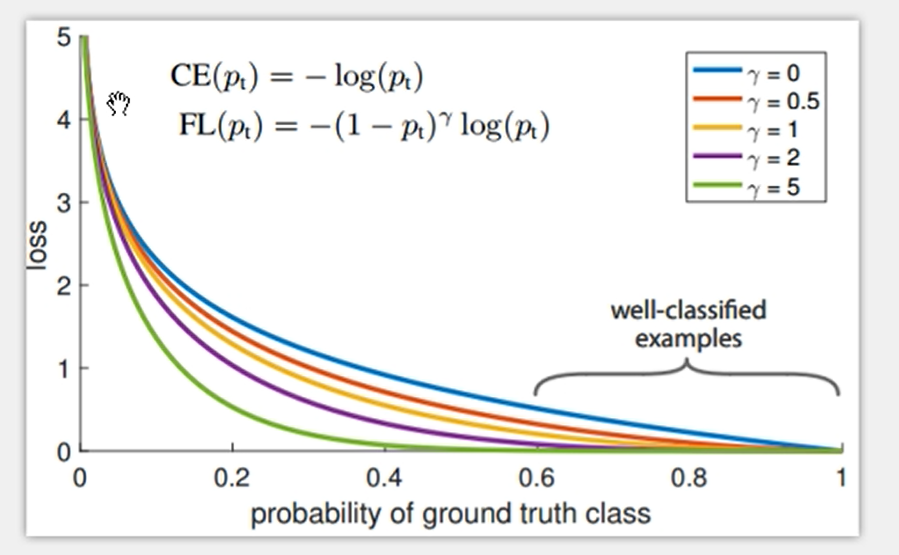

Focal Loss:

设计理念:网络在学习的时候往往有大量的负样本(背景),这些样本相对容易学习,置信度很高导致loss值很小,大量的负样本置信度聚集在0.6-1.0间,淹没需要学习的正样本,每个batch会更新大量的负样本权值,导致学习效率降低和网络性能;Focal Loss的想法是降低简单样本的损失,将网络的梯度更新偏向0-0.4置信度的样本,增强网络的分类性能。在损失函数设计时可以采取类似的想法,让网络学习偏向需要重点学习的部分,对于简单不重要的部分可以简化学习。

1

浙公网安备 33010602011771号

浙公网安备 33010602011771号