引言:

深度学习的本质是用多层的神经网络找到一个可以被学习的复杂的函数实现语音识别,图像识别等功能。

多层神经网络的结构:

多层神经元的组成,每一层的输入都等于上一层的输出。

应用领域:cv,nlp

监督学习:

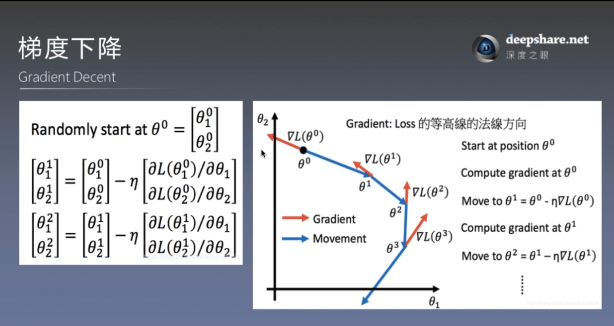

需要计算一个目标函数来测量出实际输出与预计输出之间的误差(距离),机器通过修改其参数来减小误差(距离)(反向传播的过程),这些参数称为权重,可以看作定义输出与输出之间关系的旋钮。一般利用梯度下降算法来实现反向传播。梯度下降:可以形象的比作为一个人从山顶下到山谷的过程,不断的往梯度最大反方向(最陡峭的方向)走一步,最后到达山谷。在这个过程中有可能到达局部最小值,有相应的算法解决该问题。

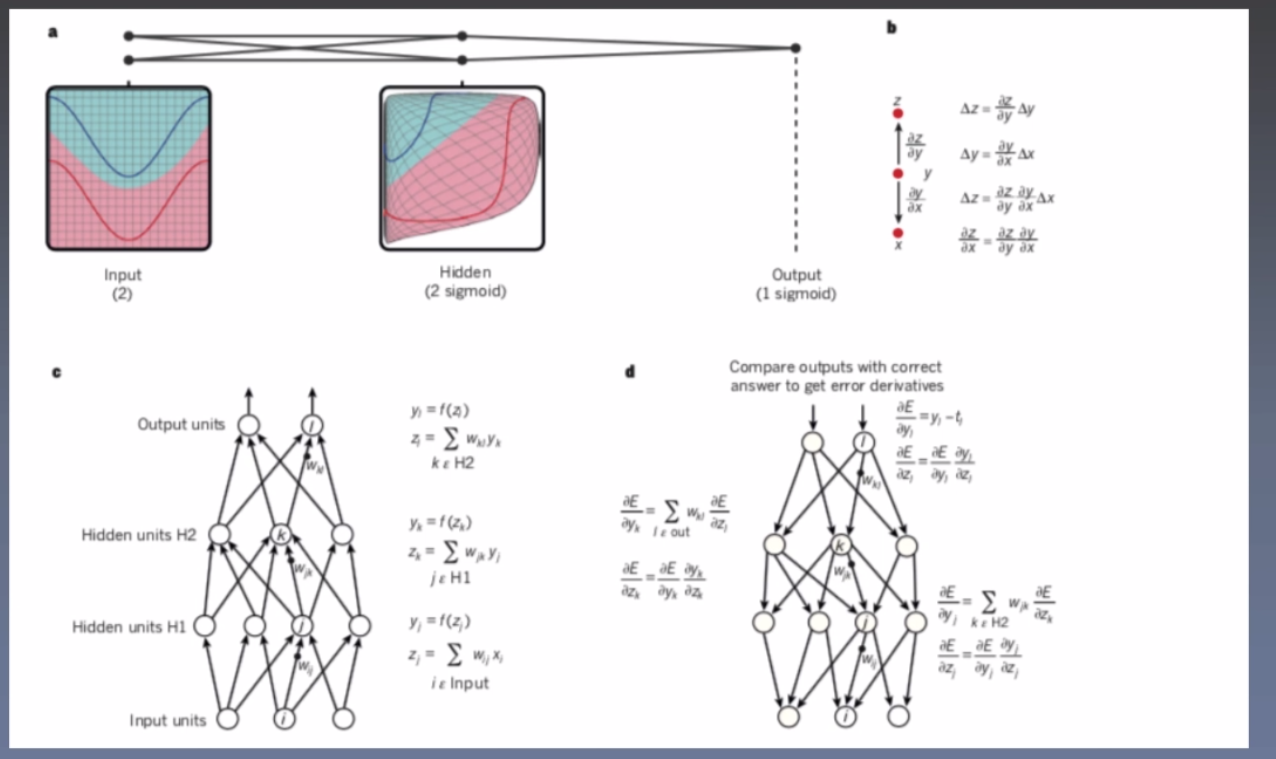

反向传播算法:

在每个隐藏层计算每个单元输出的误差导数,从输出层的误差开始,将每层的误差乘以该神经元函数的梯度一直传递到输入层。

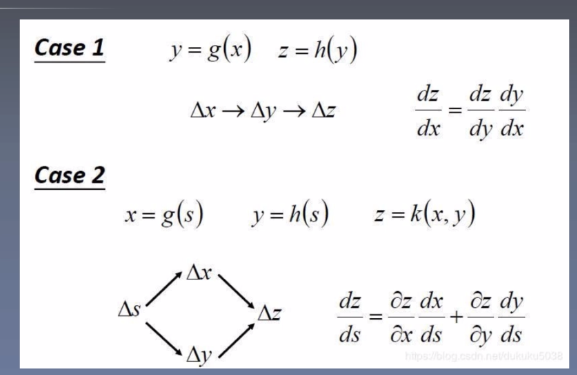

链式法则:

卷积神经网络:

卷积神经网络的过程:

1.预处理的数据加偏置用于卷积的计算(卷积核遍历)

2.将得到的结果通过非线性激活函数的处理(如Relu激活函数)

3.池化操作(取平均值或最大值,以保留显著特征,提升模型对畸变的容忍能力)

4.全连接

cnn的优势:大量减少参数,增加效率,减小计算复杂度

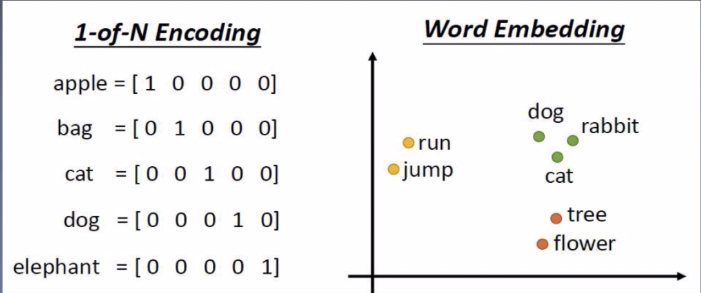

分布表示和语言模型:

1-of-N Encoding:词典中词的位置表示词的含义(维度可能较大)

Word Embedding:将词转换到向量空间,向量空间中距离较近的位置词的含义相似

Sentence Embedding相当于Word Embedding的升级版,原理与其类似

循环神经网络:

特点:RNN在每个时间点链接参数值,参数只有一份;神经网络除了输出以外,还会建立在以前的‘记忆’的基础上;内存的要求与输入的规模有关;带有存储功能的神经网络

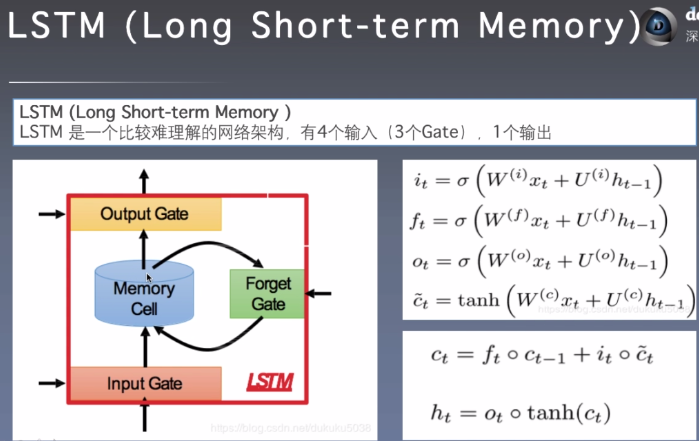

LSTM(Long Short-term Memory):

一种特殊的RNN,比普通的RNN有更好的表现,能处理更长的序列,主要解决长序列问题中梯度消失或者梯度爆炸的问题。

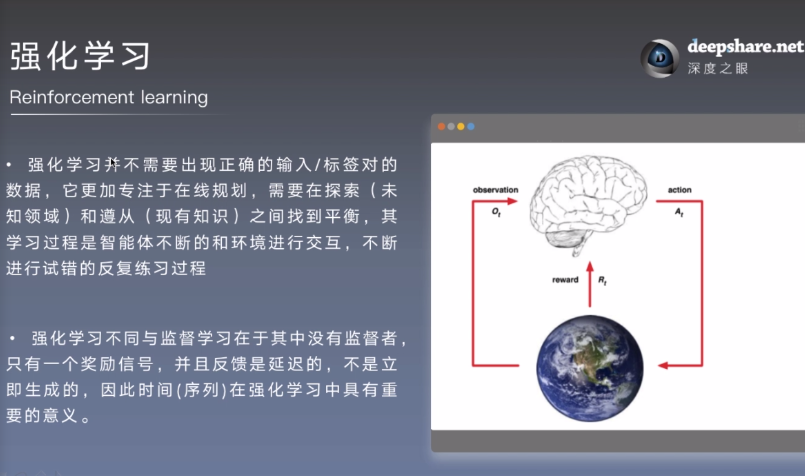

强化学习:

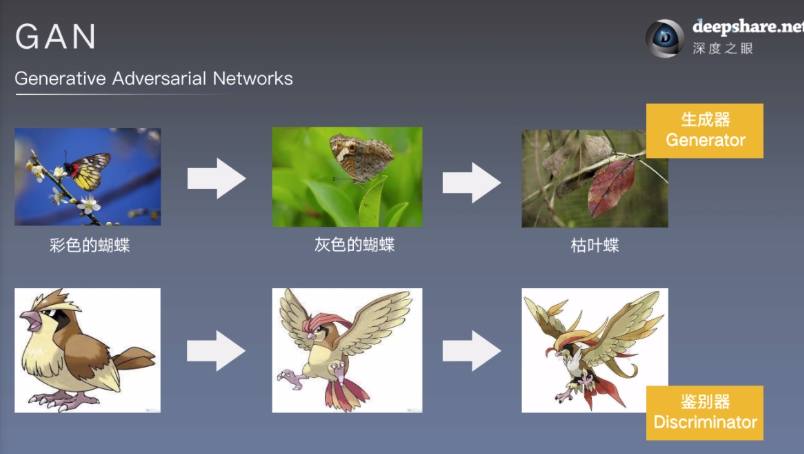

GAN(生成对抗网络):

自监督学习:

1

浙公网安备 33010602011771号

浙公网安备 33010602011771号