Communication Efficient Large-Scale Training with Adam's Convergence Speed

概

本文提出了一种 Adam 预训练的 1-bit SGD 优化方法.

1-bit Adam

-

在数据并行的分布式训练中, 需要将各个节点的梯度 allreduce 在一起, 这里面不可避免存在一些通信代价.

-

为此, 本文希望在梯度交换前, 先将梯度进行(量化)压缩, 以减少通信代价.

1-bit SGD

-

首先, 我们讲实现 1-bit SGD 的可能性.

-

vanilla SGD:

-

SGD 带压缩的梯度:

这里 , 表示总的节点数, 分别表示量化与反量化操作.

-

显然如果不进行任何处理, 累积的误差是非常惊人的. 幸而, 之前的工作提出了一种误差补偿 (error compensation) 机制:

因此误差不会累积.

-

这里需要说明一下具体的流程:

- 每个 node 计算得到梯度 , 以及上一次量化的误差 , 传递如下信号:

- 计算当前的误差累积:

- 每个 node 计算得到梯度 , 以及上一次量化的误差 , 传递如下信号:

-

因此, 1bit-SGD 是没法降低显存在占用的, 因为我们要维护额外的 , 它的作用主要是降低平均梯度时所带来的通信代价.

-

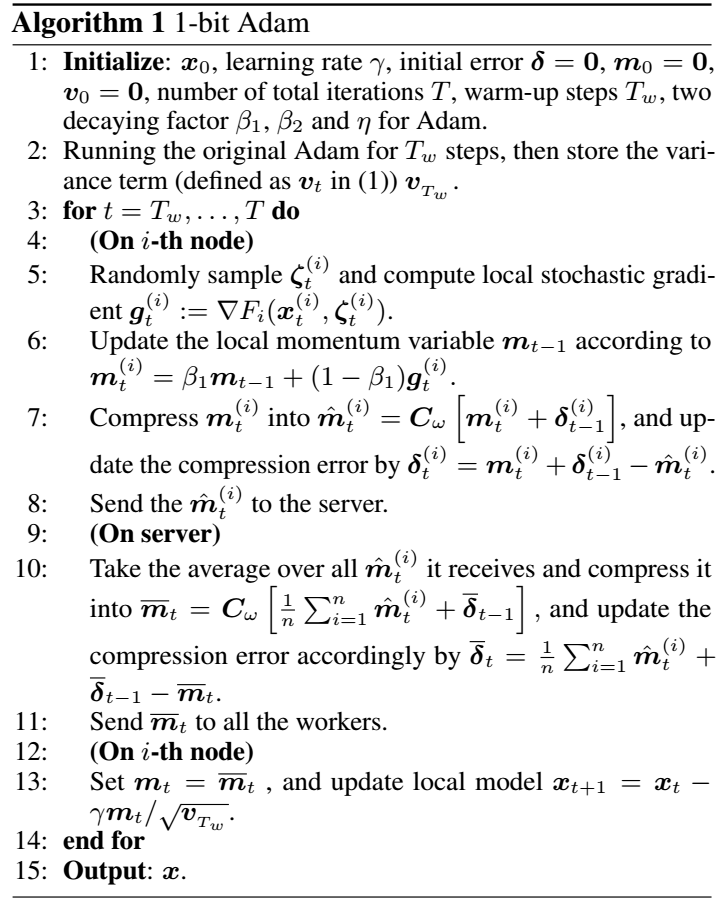

然而, 上面的推导依赖对梯度的线性累积, 如果是 Adam 这种非线性的优化器, 误差补偿也没法阻止误差的累积. 因此, 本文所提出的 1-bit Adam 的流程如下:

- 在一开始, 采用正常的 Adam 进行更新, 得到二阶动量的一个估计 (因为作者发现, Adam 的二阶动量在训练一段时间后趋于稳定);

- 固定二阶动量, 并开始量化梯度, 转而采用 1-bit SGD 的格式更新.

-

所以本质上, 1-bit Adam 还是一个 1-bit SGD 方法, 相当于设置了一个更合理的学习率? 实际上, 作者的二阶动量会逐步区域稳定的这个假设也是不合理的, 至少我做实验的经常会观察的逐步增加的二阶动量.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-02-13 Are Loss Functions All the Same?