Convergence of Adam Under Relaxed Assumptions

Li H., Jadbabaie A. and Rakhlin A. Convergence of adam under relaxed assumptions. NeurIPS, 2023.

概

本文探讨了 Adam 再较弱的假设下的收敛性. 作者的证明思路非常有趣, 虽然条件看着还是有些不对劲.

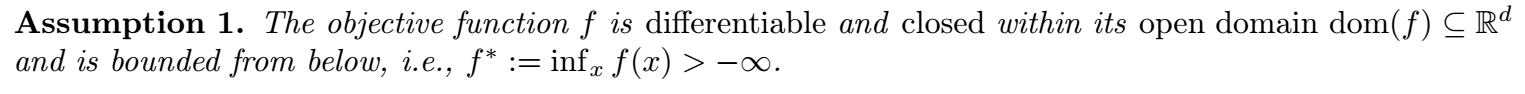

符号说明

- , 非凸目标函数;

- , 是一些随机 source, 可用于模拟训练过程中的随机因素 (如 mini-batch sampling);

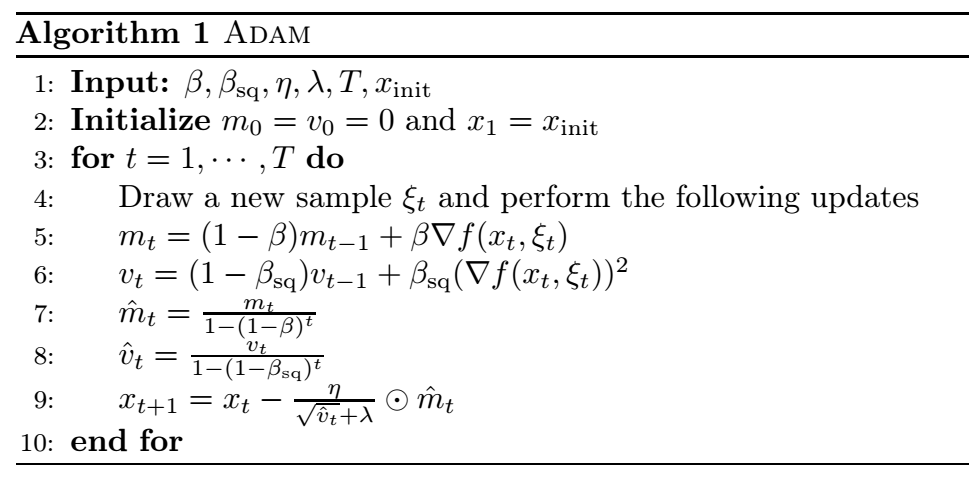

- 上述算法是 Adam 的完整流程, 需要注意的是, 这里的 在常规的实现中为 .

思路

-

作者的证明思路是围绕:

其中

-

倘若我们能够假设 是 -smooth 的, (1) 是可以容易证明的. 但是作者搞了一个 (, )-smooth 这个局部 smooth 的条件 (更弱一点). 从而需要证明在这个条件下有着类似 -smooth 的性质, 文中 Section 5 和 Appendix B 都在讨论这一点.

-

有趣的是, 作者先假设 下所需性质成立, 然后再证明 (通过反证法).

-

有了 (1), 剩下的难点在于如何 bound 住 , 更准确地说, 是如何次线性地 bound 住:

我们需要注意, 这里的难点在于:

- 是通过 随机梯度得到的;

- 就是本身的误差积累如何能够保证次线性.

-

作者用概率上的方法 (Azuma-Hoeffding inequality) 证明了:

-

请注意我标黄的地方:

- 这是个概率上成立的结果;

- 不看 是线性增长的, 想要规避这一点需要保证 是一个很小的量. 事实上作者也这么做了.

-

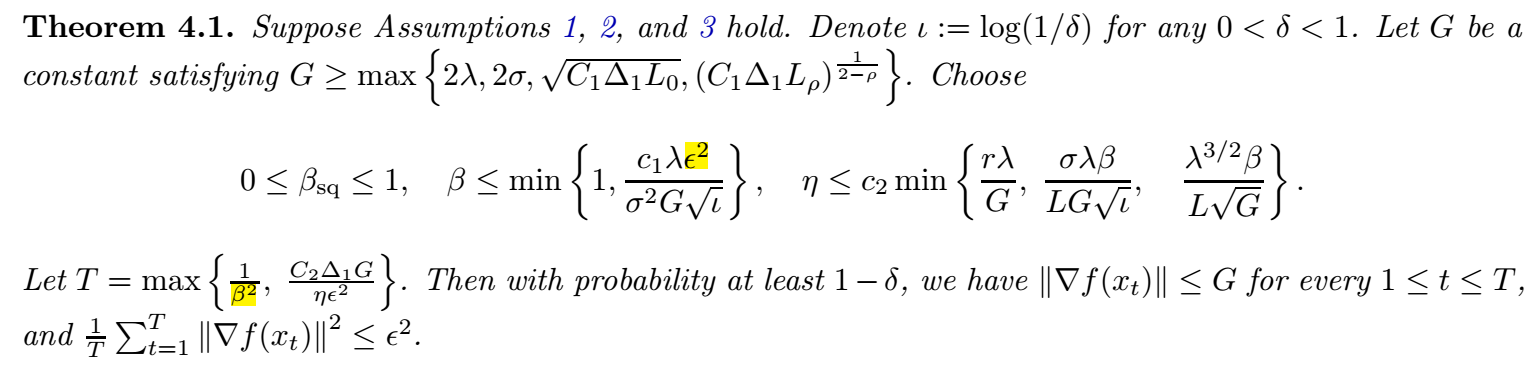

下面是主要的结果:

- 感觉美中不足的点就是 的选择, 一定是一个非常非常小的值, 而且这个 取得小和常规的不一样, 是更倾向于平均的结果, 即相当于一般情况取个 的感觉, 这个太不符合实际了. 而且 的这种取法也不妥当, 有点掩盖了真实的收敛速度.

分类:

数值解

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-01-13 Going Deeper with Convolutions (GoogLeNet)