PACT: Parameterized Clipping Activation for Quantized Neural Networks

概

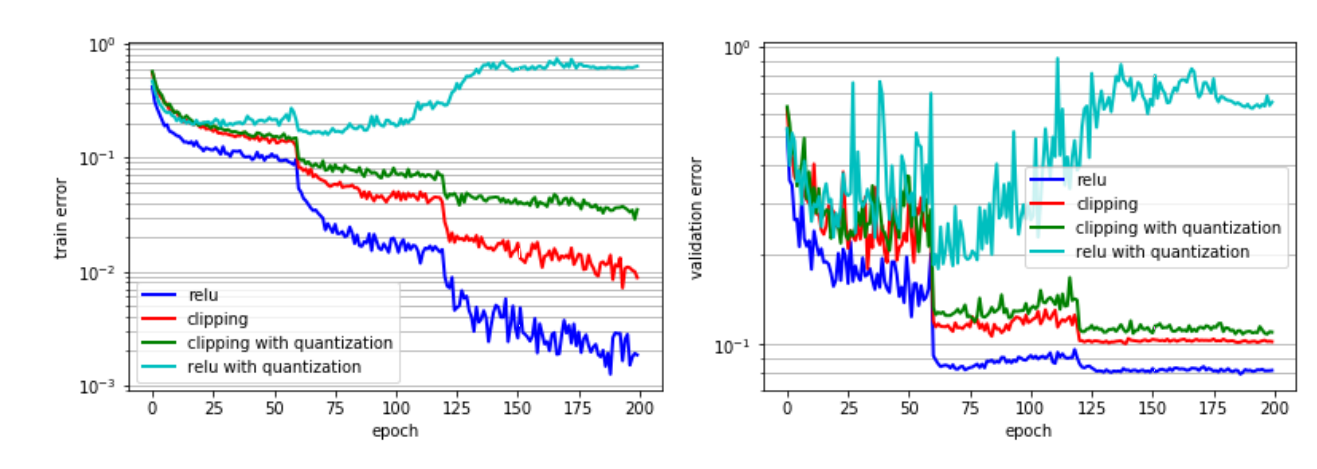

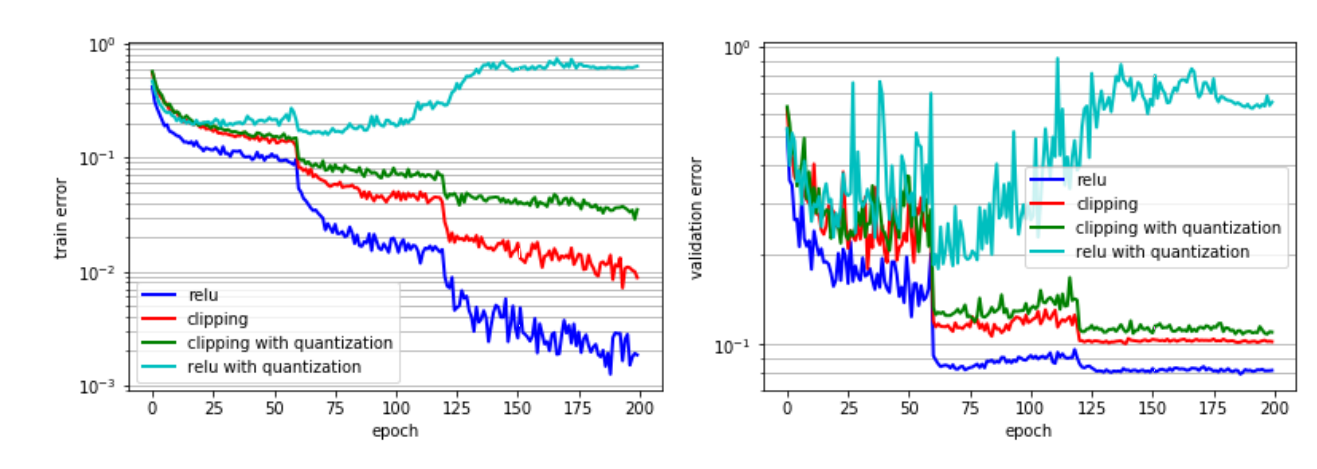

本文提出对网络中的激活值进行裁剪以实现更低量化.

主要内容

-

作者的思想很简单, 作者认为正常的 relu 往右是无界的, 这会对量化造成困难. 所以, 作者的做法就是对 relu 右侧进行一个截断:

-

并且训练的时候通过 STE 进行训练:

其中 .

本文提出对网络中的激活值进行裁剪以实现更低量化.

作者的思想很简单, 作者认为正常的 relu 往右是无界的, 这会对量化造成困难. 所以, 作者的做法就是对 relu 右侧进行一个截断:

并且训练的时候通过 STE 进行训练:

其中 .

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix