Hu Z., Liu C., Feng X., Zhao Y., Ng S., Luu A. T., He J., Koh P. W. and Hooi B. Uncertainty of thoughts: Uncertainty-aware planning enhances information seeking in large language models. NeurIPS, 2024.

概

通过判断问题所导致的不确定性降低程度来衡量一个问题的重要性.

UoT

-

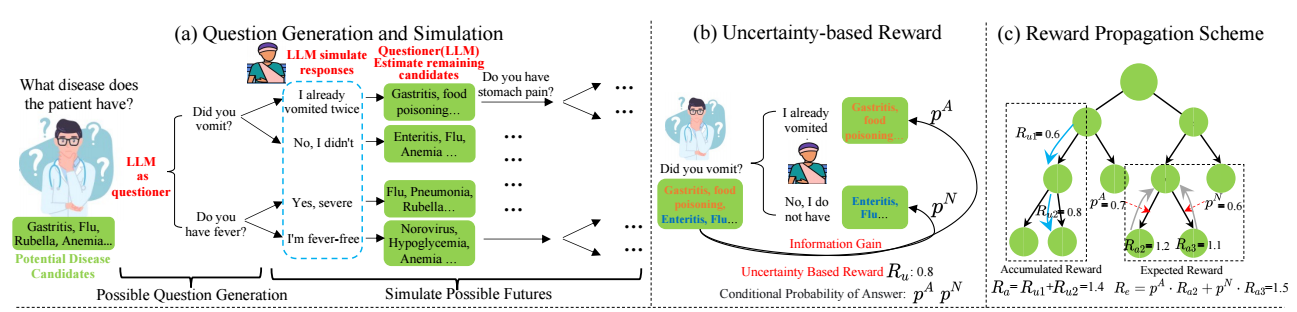

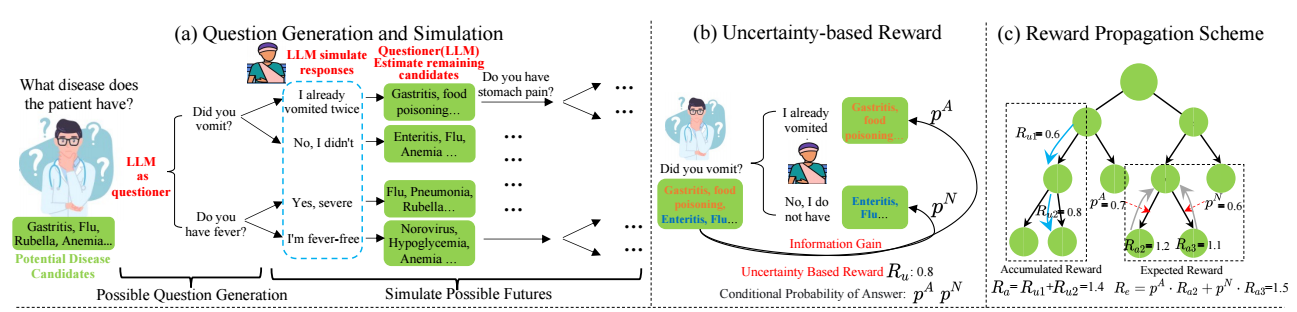

如上图 (a) 所示, 为了判断一个病人的具体病症, 我们可以通过多种 "问题链" 来实现. 当然了, 我们希望问题链能尽可能地问更少的问题, 增加诊断的效率.

-

假设在用户解答问题 q 前, 有 Ω 种可能的病症, 对于具体的回答:

- 'Yes' (肯定回答): 导致可能的病症蜕变为 ΩY;

- 'No' (否定回答): 导致可能的病症蜕变为 ΩN.

-

一个有效率的问题应当尽可能使得 |ΩY|=|ΩN| (我们假设 ΩY∩ΩN=∅) 以实现最大限度地不确定性的降低.

-

让我们定量地看一看, 假设 Ω={ωi} 中每个病症的概率为 p(ωi) (通常, 取 p(ωi)=1/|Ω|, 但有些时候, 或许我们会给每个病症设定不同的先验, 毕竟每个病症出现的概率是不一样的), 此时当前的不确定性可以有如下的信息熵度量:

H(Ω)=−∑ip(ωi)logp(ωi).

-

现在, 由于问题 q, Ω=ΩY∩ΩN, 我们有:

p(ω|ΩY)=p(ω)/∑ω∼ΩYp(ω′),p(ω|ΩN)=p(ω)/∑ω∼ΩNp(ω′).

-

对于两个 subset, 我们有:

H(ΩY)=−∑i:wi∈ΩYp(ωi|ΩY)logp(ωi|ΩY),H(ΩN)=−∑i:wi∈ΩNp(ωi|ΩN)logp(ωi|ΩN).

-

由此, 我们可以计算问题 q 所对应的条件熵:

H(Ω|q,a)=−p(a=yes)H(ΩY)−p(a=no)H(ΩN),

而且

p(a=yes)=p(ΩY),p(a=no)=p(ΩN).

-

于是, 作者采用问题 q 前后的信息熵的变化作为不确定性的降低程度 (实际上是互信息):

IG(Ω):=H(Ω)−H(Ω|q,a).

-

这个只是一个问题 q 的度量. 实际上, 作者让 LLM:

- 提出 m 个问题, 并设想 m 个问题分别给出肯定和否定答案后, 所对应的 Ω 的变化;

- 对于每个 subset, 重复 1.

-

如此一来, 我们会有一个树状的结构, 一个好的问题, 不仅要求它对于接下来的不确定性分割是最优的, 而对于后续的也是如此的. 所以作者额外设计了 reward propagation 机制:

-

Accumulated Reward:

Ra(v):=Ru(v)+{0v is rootRa(Parent(v))otherwise.

-

Expected Reward:

Ra(v):=⎧⎪

⎪⎨⎪

⎪⎩Ra(v)if v is a leaf; otherwise:pYvRe(vY)+pNvRe(vN)if v is an Answerer Node;1m∑mw∈Children(v)Re(w)if v is a Questioner Node.

代码

[official-code]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2023-11-17 Decoupling the Depth and Scope of Graph Neural Networks

2021-11-17 Scalable Rule-Based Representation Learning for Interpretable Classification