Are Graph Augmentations Necessary? Simple Graph Contrastive Learning for Recommendation

概

对比学习用在协同过滤中通常会对图的结构进行变换, 但是作者发现其实并没有这个必要, 只需要对 Embedding 添加扰动就能获得最好的性能.

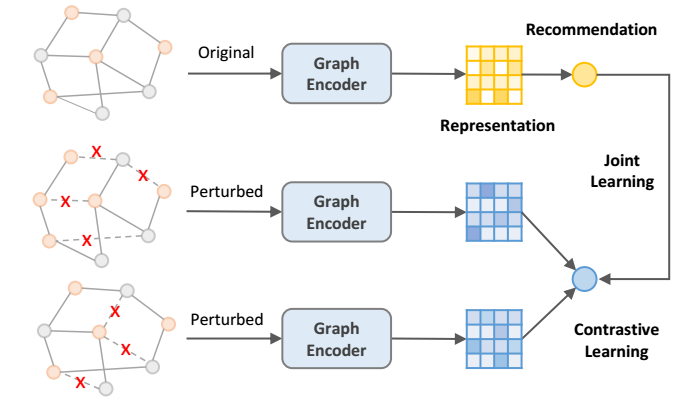

Graph CL

-

协同过滤中的对比学习, 通常采用如下的损失:

其中

其中 分别 embedding 的两个 view, 比如 SGL 中通过对图结构 mask 得到两个 view. 此外, 是 normalization 后的.

-

作者探究了如下的一种有趣的变种 (称为 SGL-WA):

即, 只有一个 view.

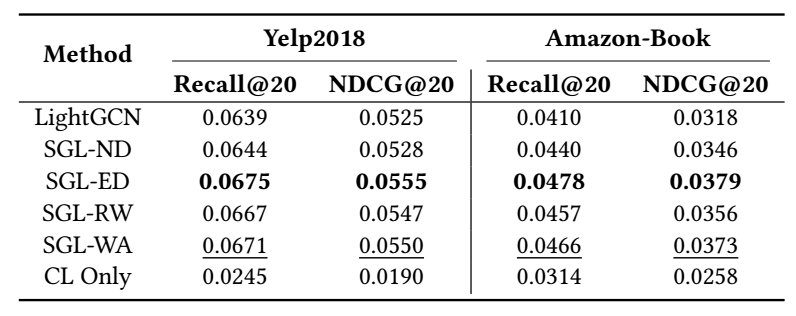

- 如上表所示, SGL-WA 的结果几乎和 SGL-ED 差不多了, 这说明, SGL 真正有用的部分其实是对比损失部分而不是 view 的产生方式.

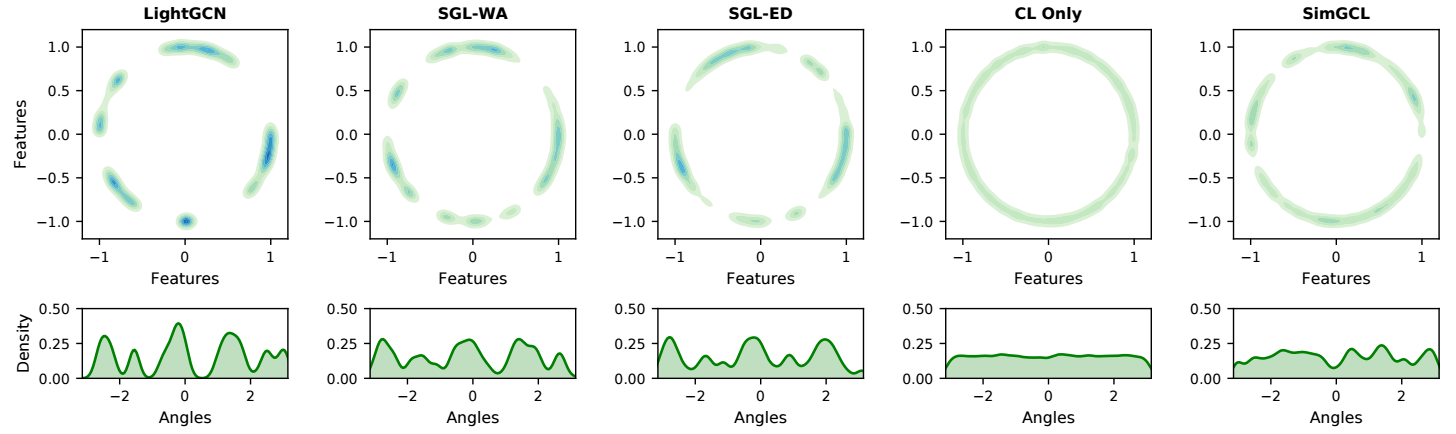

- 进一步地, 作者探究对比损失能够带来些什么呢? 作者发现, 对比损失的作用, 实际上是让 embedding 分布更加均匀 (这个其实纯研究对比损失的已经指出来了).

SimGCL

-

于是, 作者的相反就很简单了, 通过如下的方式制造两种不同的 view:

其中 ?

-

对于 LightGCN 这个 backbone, 每一层都会添加独立的噪声.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2023-10-16 PyG

2022-10-16 UltraGCN: Ultra Simplification of Graph Convolutional Networks for Recommendation