BAdam: A Memory Efficient Full Parameter Optimization Method for Large Language Models

概

本文介绍了一种 Block corrdinate descent (BCD) 的训练方式.

BAdam

-

当模型本身很大的时候, 训练它会成为一个很大的问题, 所以现在会流行一些 LoRA 等低质方法用于更快速地更新模型.

-

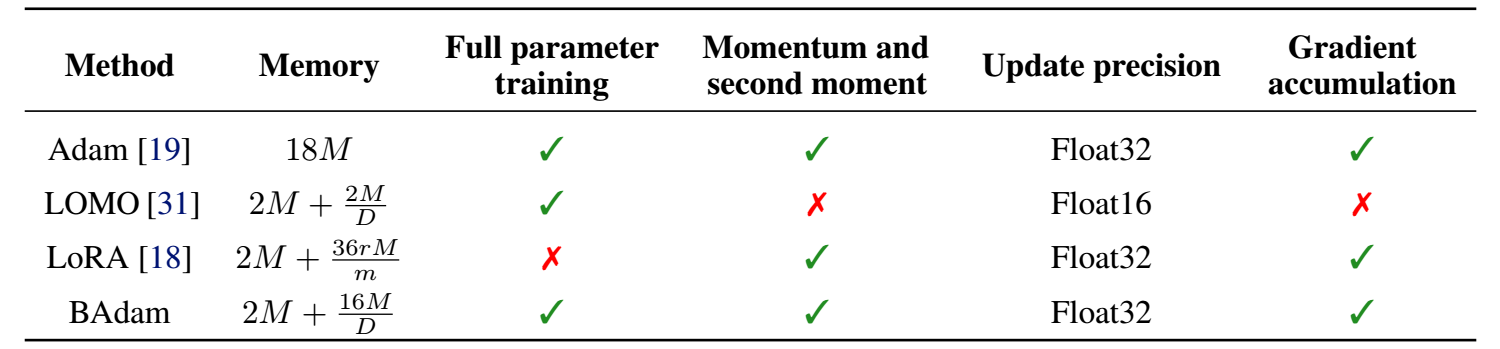

这个问题其实很大程度上是因为常用地 Adam 至少需要缓存 2x 模型的量, 所以本文提出的 BAdam 就是希望能够每次仅更新其中的一个 block.

-

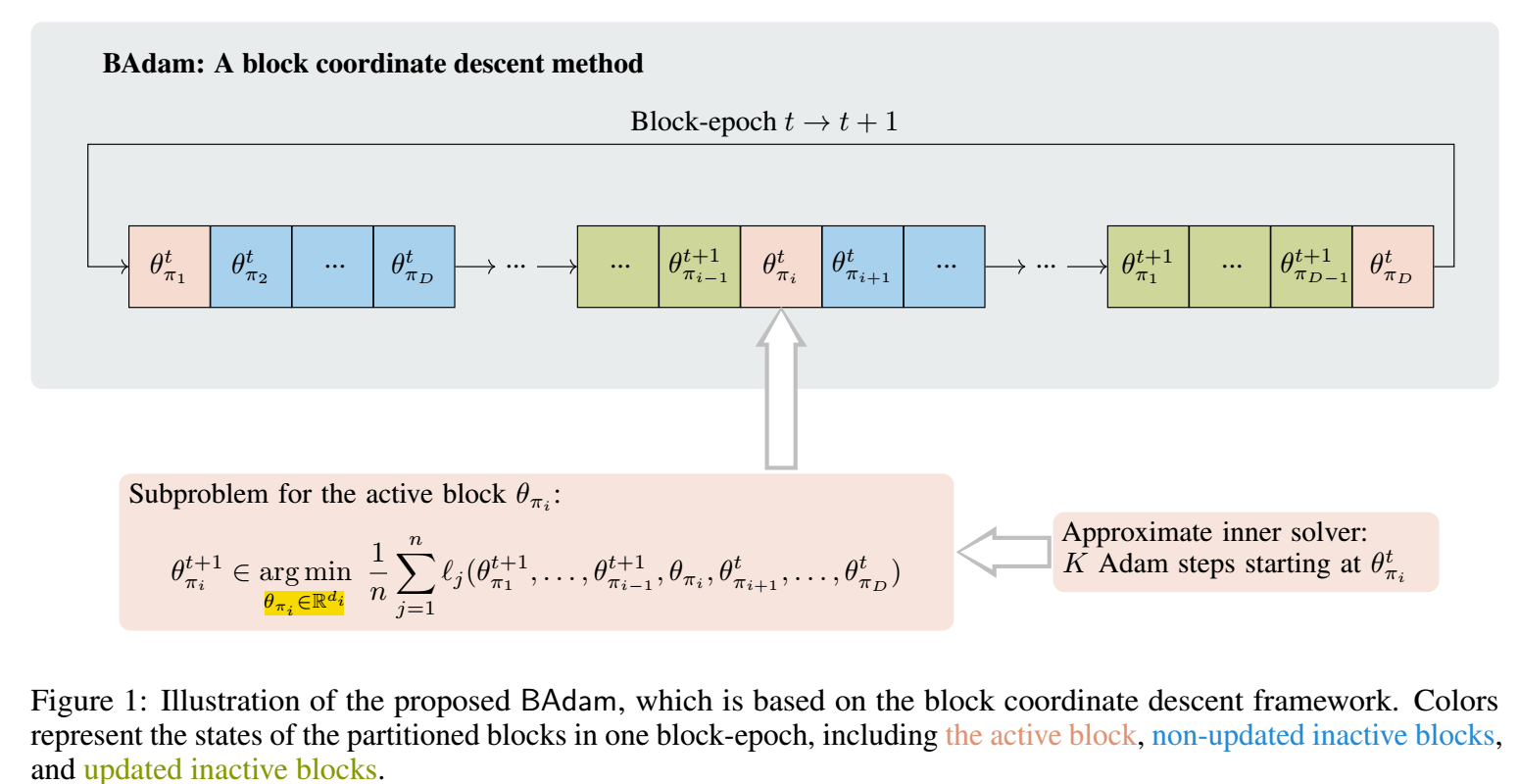

BAdam 将整个模型分成 份: , 并假设其中的参数为 .

-

每一次那个更新, 仅更新其中的某一个 block:

-

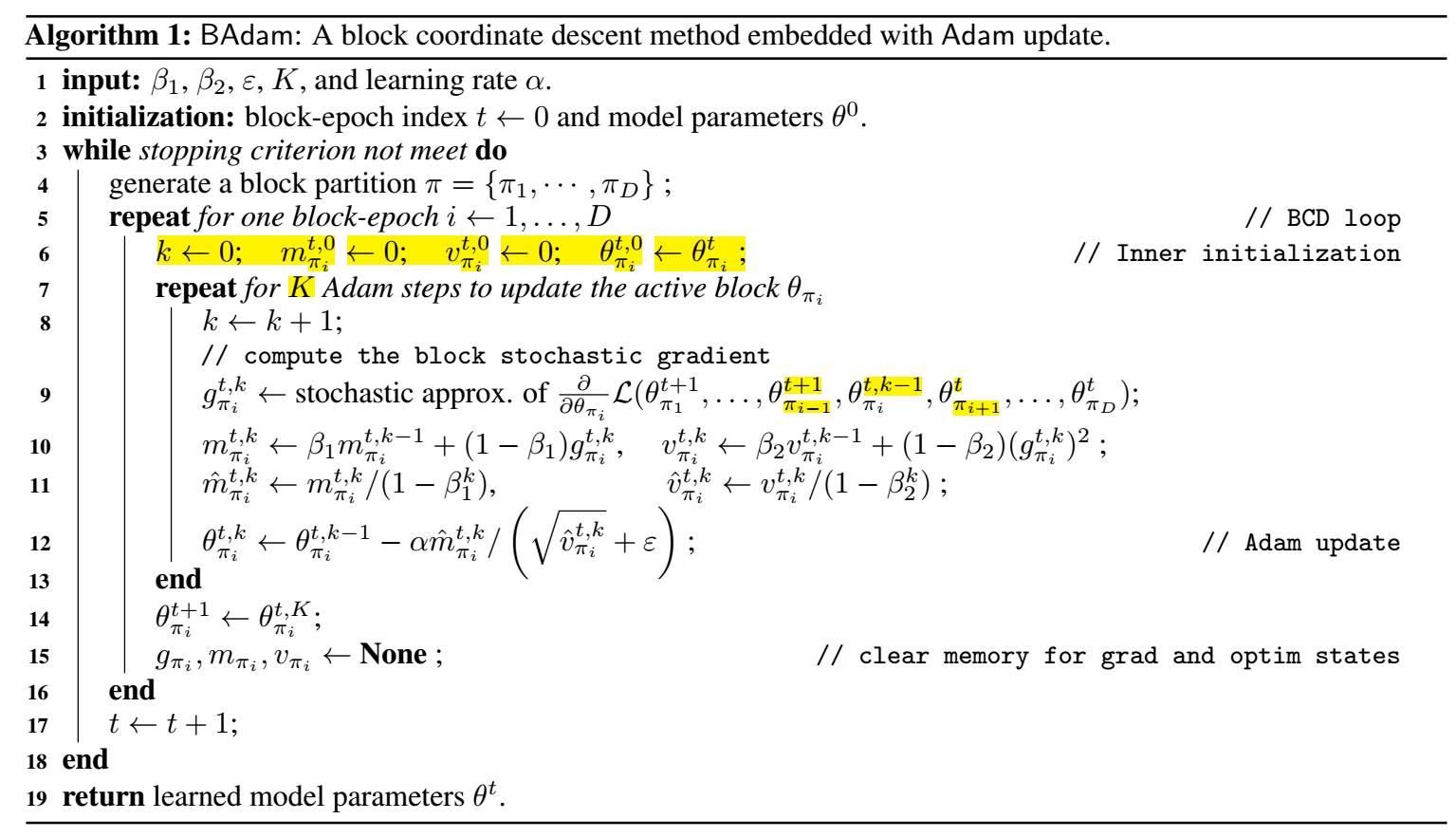

具体的算法如下, 注意到, 对每个 block 会更新 K 次:

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2022-08-27 DropEdge: Towards Deep Graph Convolutional Networks on Node Classification