AdaBelief Optimizer: Adapting Stepsizes by the Belief in Observed Gradients

概

本文提出了一种 Adam 优化器上的改进, 能够更加有效地设计步长.

AdaBelief

-

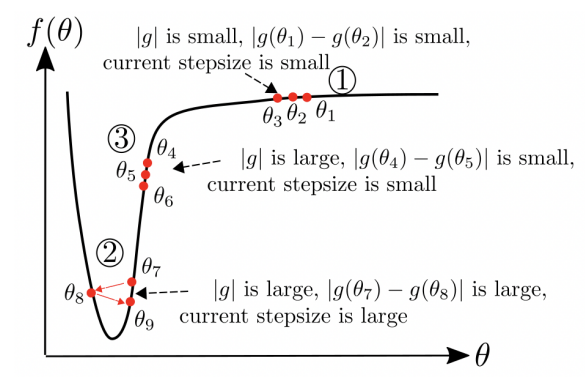

AdaBelief 的初衷很简单, 如上图所示, 据此我们分析三种情况下的合理步长.

-

对于第一种情况, 梯度 很小, 此时理想的 optimizer 理应给予一个较大的步长, Adam 的确有能力做到这一点 (估计的方差比较小);

-

对于第二种情况, 梯度 很大, 且位于极小值附近, 理应设置一个较小的步长, Adam 也有能力做到这一点 (此时估计的方差比较大);

-

对于第三种情况, 梯度 很大, 但是此时可以设置一个较大的步长, 但是实际上 Adam 依然给予一个较小的步长. 由于前后梯度差异很大, 所以 AdaBelief 实际上依然可以给予一个较大的步长.

注: 根据 github 的 issue 里, 有人发现 对于替代 SGD 的一个重要性, 注意到, 当 足够大的时候, 后面会收敛到相同的值, 此时 AdaBelief 的表现就和 SGD 类似了. 所以这也可能是为什么 AdaBelief 也能够在 CV 上取得比较好的结果原因之一.

注: 我不是很清楚 Update

是怎么来的, 好像和 online learning 有点关系.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix