Fu D. Y., Dao T., Saab K. K., Thomas A. W., Rudra A. and Re C. Hungry hungry hippos: towards language modeling with state space models. 2022.

概

Mamba 系列第五作: H3.

H3

-

感觉 H3 是之前的 linear attention 和 SSM 的一个结合, 它所做的只是把 linear attention 中的部件改成了 SSM 的结构.

-

attention 的平方复杂度一直是一个问题, 给定 Qi,Ki,Vi∈Rd,i=1,…,N (N 为序列长度), linear attention 解决这个问题的思路是:

Oi=∑ij=1Sim(Qi,Kj)Vj∑ij=1Sim(Qi,Kj)∈Rd,

其中对于一般的 softmax attention, Sim(q,k)=eqTk, linear attention 则是

Sim(q,k)=ϕ(q)Tϕ(k),

ϕ 是某个 non-linear function.

-

由此一来, 我们就会有:

Oi=ϕ(Qi)T∑ij=1ϕ(Kj)VTjϕ(Qi)T∑ij=1ϕ(Kj),

令

Si=i∑j=1ϕ(Kj)VTj∈Rd×d,zi=i∑j=1ϕ(Kj)∈Rd,di=ϕ(Qi)Tzi∈R.

我们有

Oi=ϕ(Qi)TSidi.

-

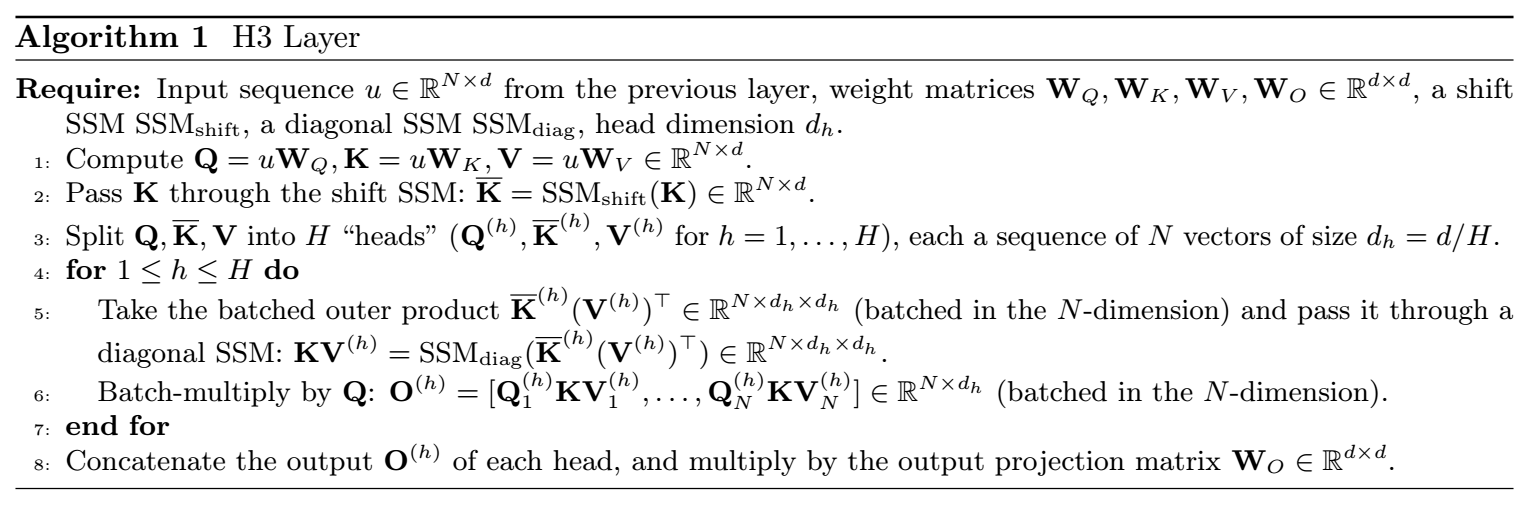

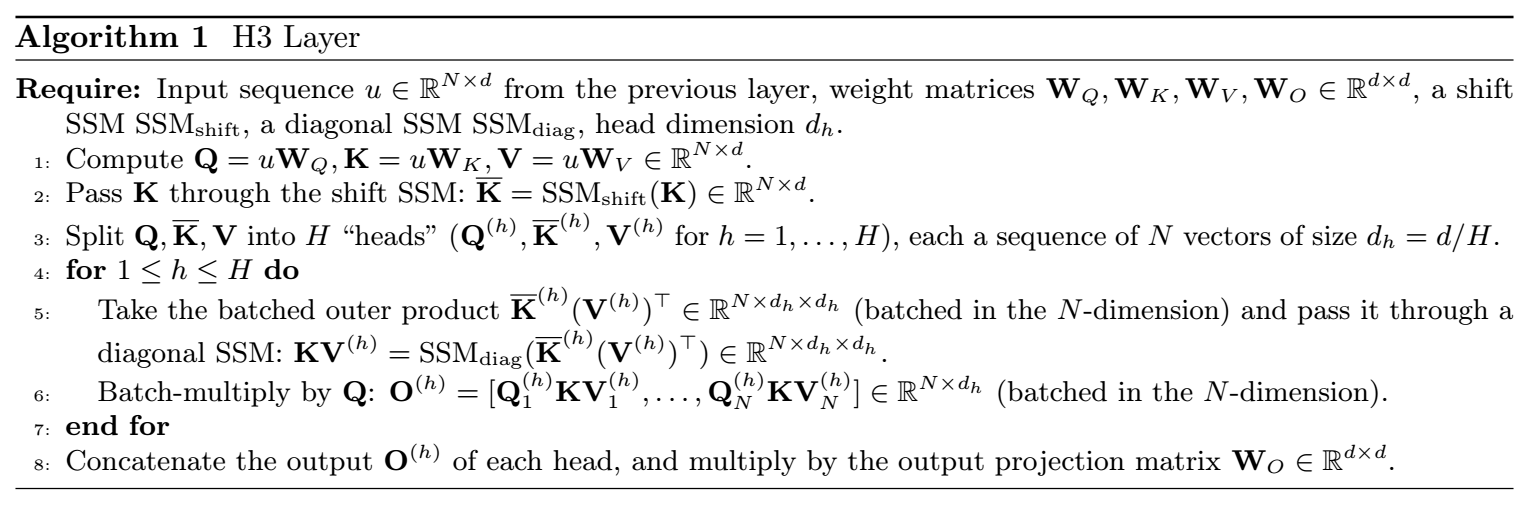

H3 就是把:

ϕ(K)→SSMshift(K)⊙V,Si→SSMdiag(SSMshift(K)⊙V),

最后我们有

O=Q⊙SSMdiag(SSMshift(K)⊙V).

-

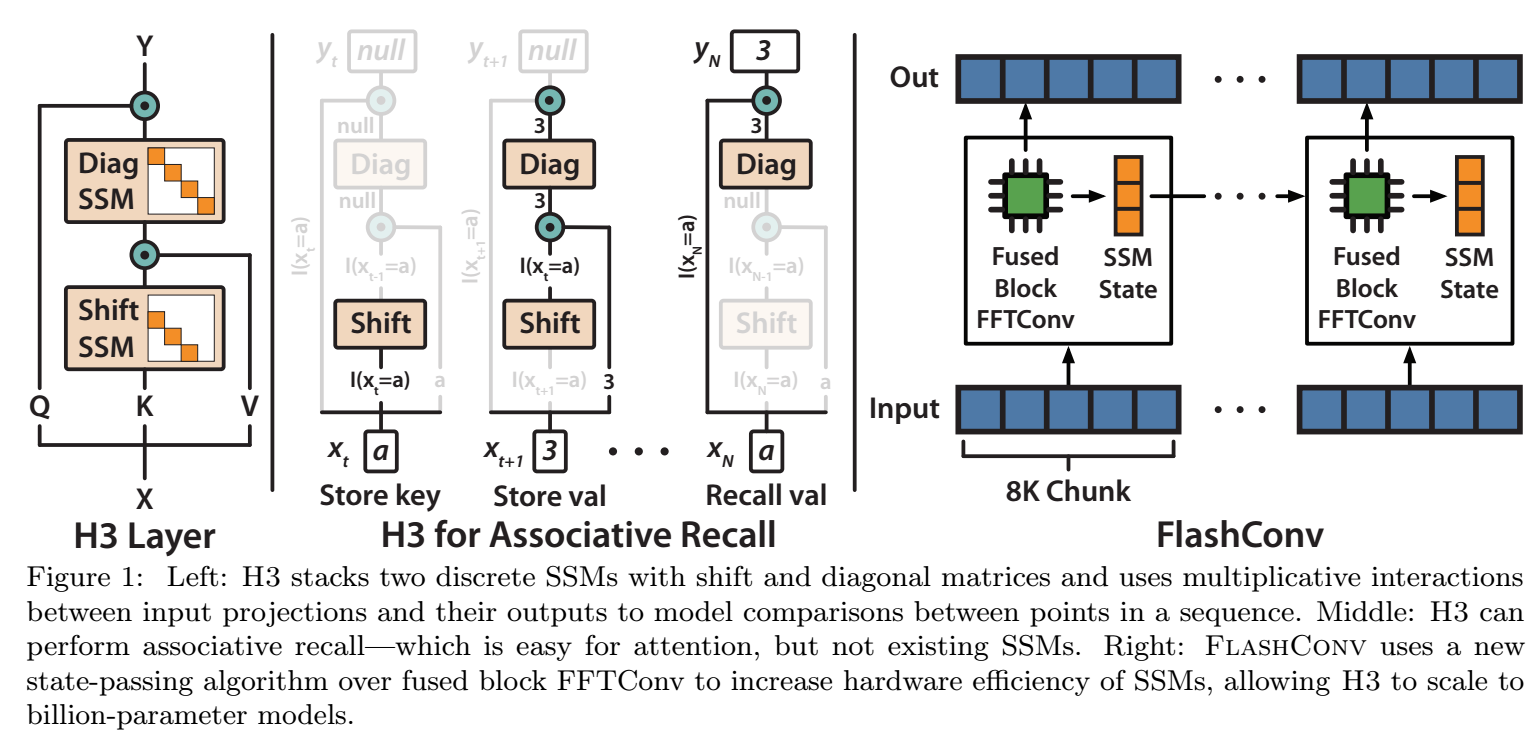

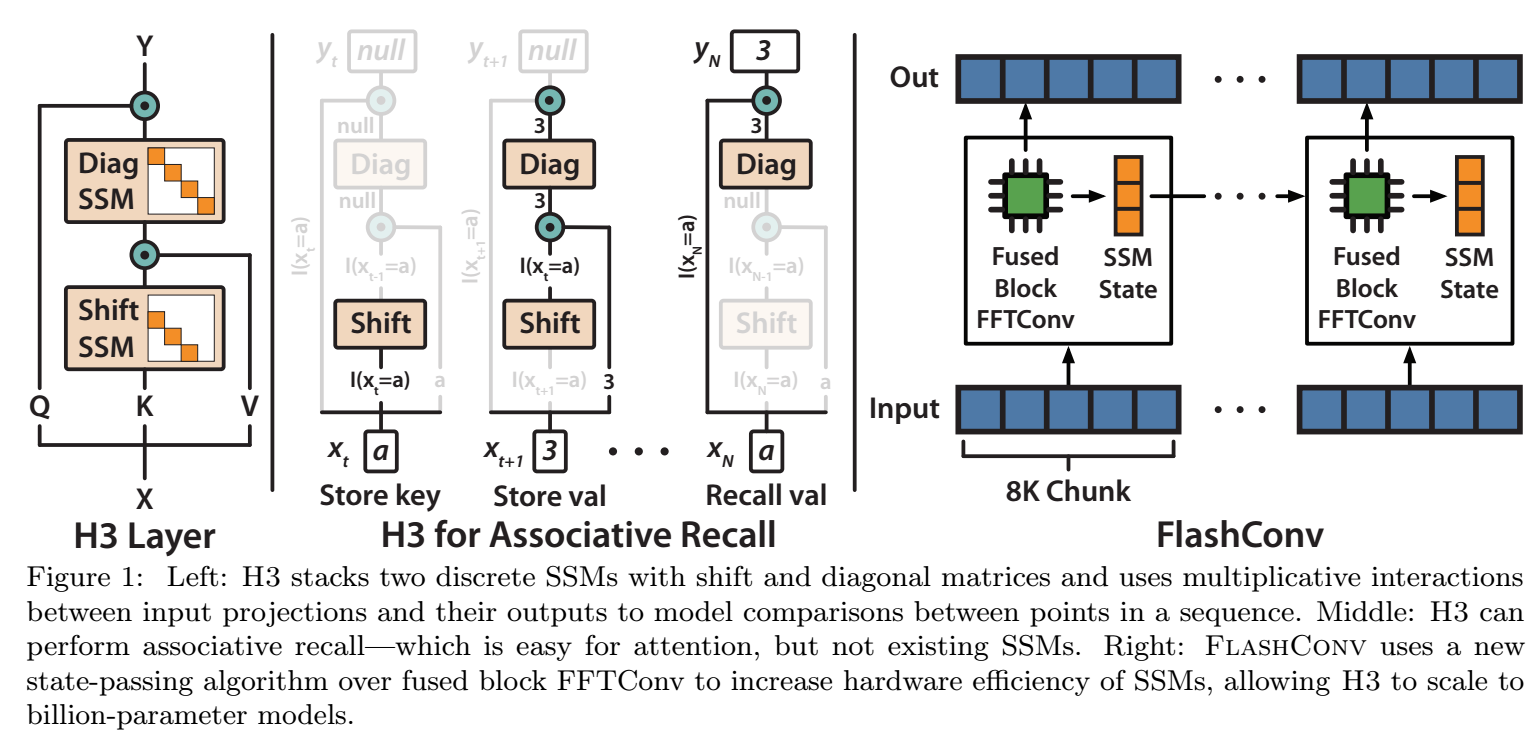

模型结构如下:

注: 作者额外讨论了加速算法, 感兴趣的请回看原文.

代码

[official-code]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix