HiPPO: Recurrent Memory with Optimal Polynomial Projections

概

看下最近很火的 Mamba 的前身. 本文其实主要介绍的是一个如何建模历史信息在正交基上的稀疏的变化情况.

Motivation

-

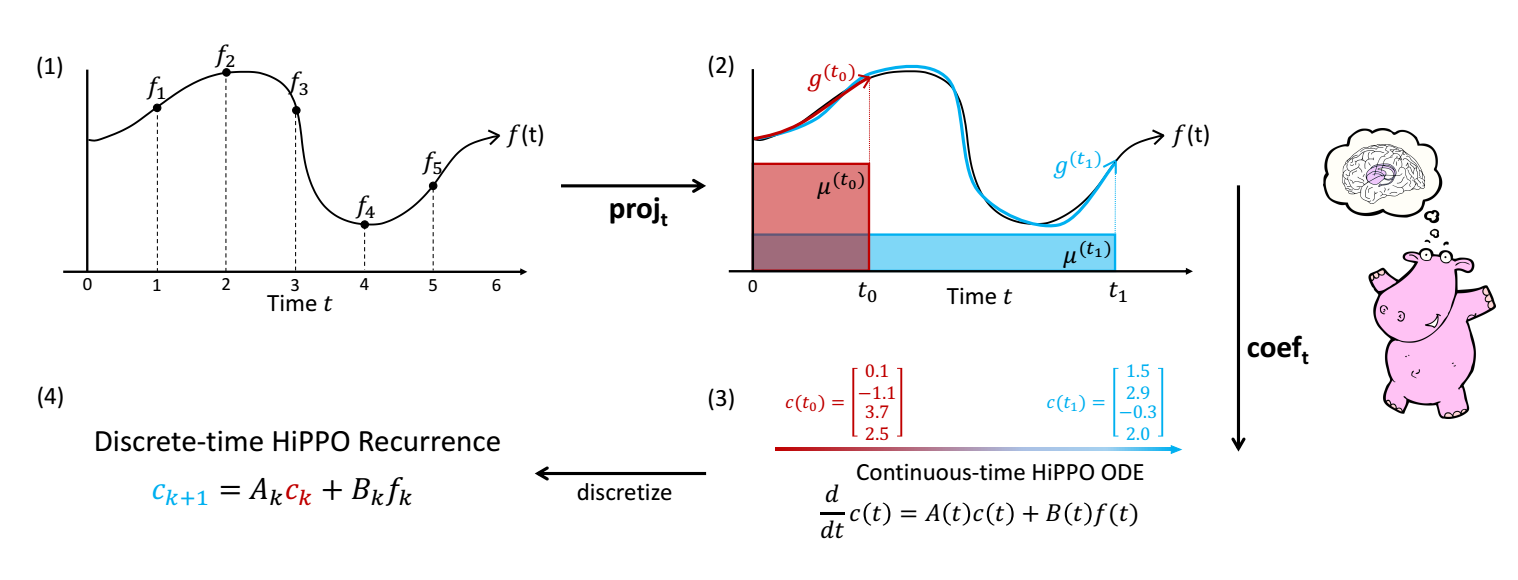

对于一个函数 (如上图 (1)), 我们希望找到一个东西去记忆它. 需要注意的是, 我这里用的词是 '记忆' 而不是 '建模'. 这二者有些相似, 但是侧重点不一样:

- 建模: 如果是一个建模问题, 那大概的思路就是通过一个模型 (如神经网络) 去拟合 , 故而往往是一个 一个模型;

- 记忆: 给定过去的序列 , 通过某种方式去 '压缩' 它. 毫无疑问, 最直接的记忆手段就是把过去的历史全部存起来, 但是其实这种方式或许是不那么优雅的 (当然这种方式也有成功的例子, 如 transformer). 故而 记忆 是动态的, 一个模型是可以应对多个 的.

-

下面我们先把视角放到连续的版本上去, 后面在介绍如何离散化. 故我们现在的目标是: **通过有限的单元去记忆 .

-

作者的思想其实很简单, 把 投影到 个正交基 上, 然后保存在其上的系数:

-

其实我认为作者做出的最大的贡献就是正交基 随着时间 有规律的变化, 测度 随着时间 有规律的变化.

-

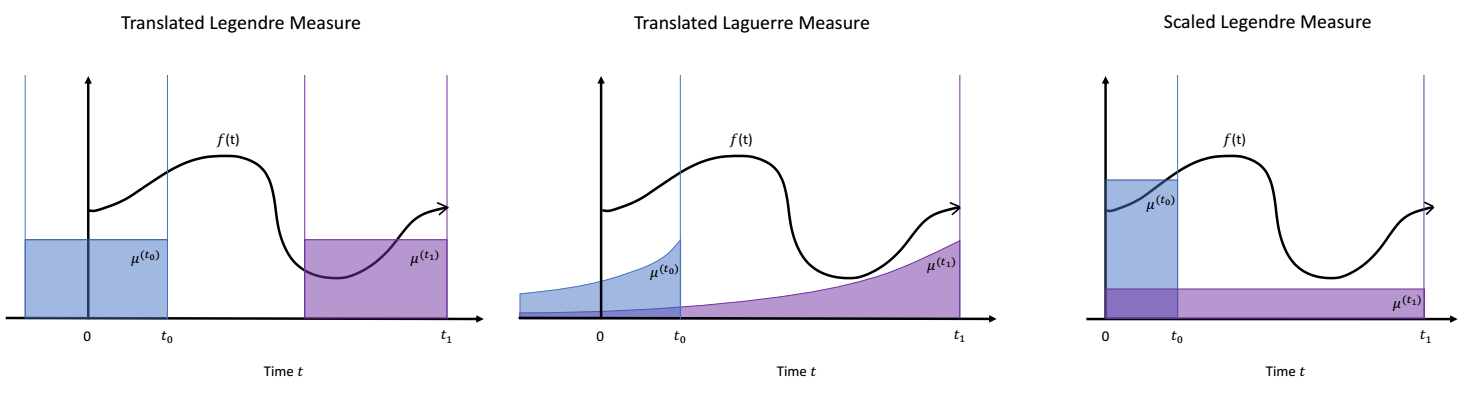

让我们来先理解测度 的含义, 我们可以把它简单理解成一个概率分布, 我们假设 为它的密度函数, 通过它可以描述过去时刻的重要性:

- 短期均匀记忆 (Translated Legendre Measure):它对过去 时间段赋予了相同的权重;

- 指数衰减记忆 (Translated Laguerre Measure):越久远的记忆, 衰减的越厉害, 它有一个问题, 的时候它也会有权重.

- 长期均匀记忆 (Scaled Legendre Measure):对过去的记忆统一进行均匀记忆.

- 短期均匀记忆 (Translated Legendre Measure):

-

故, HiPPO 可以通过设计不同的测度 来反映不同的记忆方式, 虽然指数衰减记忆直觉上更符合, 但是实际中长期均匀记忆作者更为推荐.

-

到此, 问题其实依旧非常严峻, 的表达式其实是比较困难 (对于我来说), 牛逼的是, 作者证明了对于上述的三种记忆方式, 大体上可以统一表示为:

-

实际上 (1) 就定义了 的变化过程, 描绘了测度 下最优的一种压缩模式. 我们可以通过一些离散方法来近似这个 ODE. Generalized Bilinear Transformation (GBT):

-

(1) 等价于

-

(2) 取近似点为 , 可得近似:

可得:

-

即为 Euler 近似, 为 Backward Euler 近似, 为 Bilinear 近似.

-

-

故而, 我们只需要算出 , 就可以迭代更新 了, 下面直接给出上述三种方式的 :

- 短期均匀记忆 (Translated Legendre Measure):

- 指数衰减记忆 (Translated Laguerre Measure):

- 长期均匀记忆 (Scaled Legendre Measure): 首先它的形式为:

其中

-

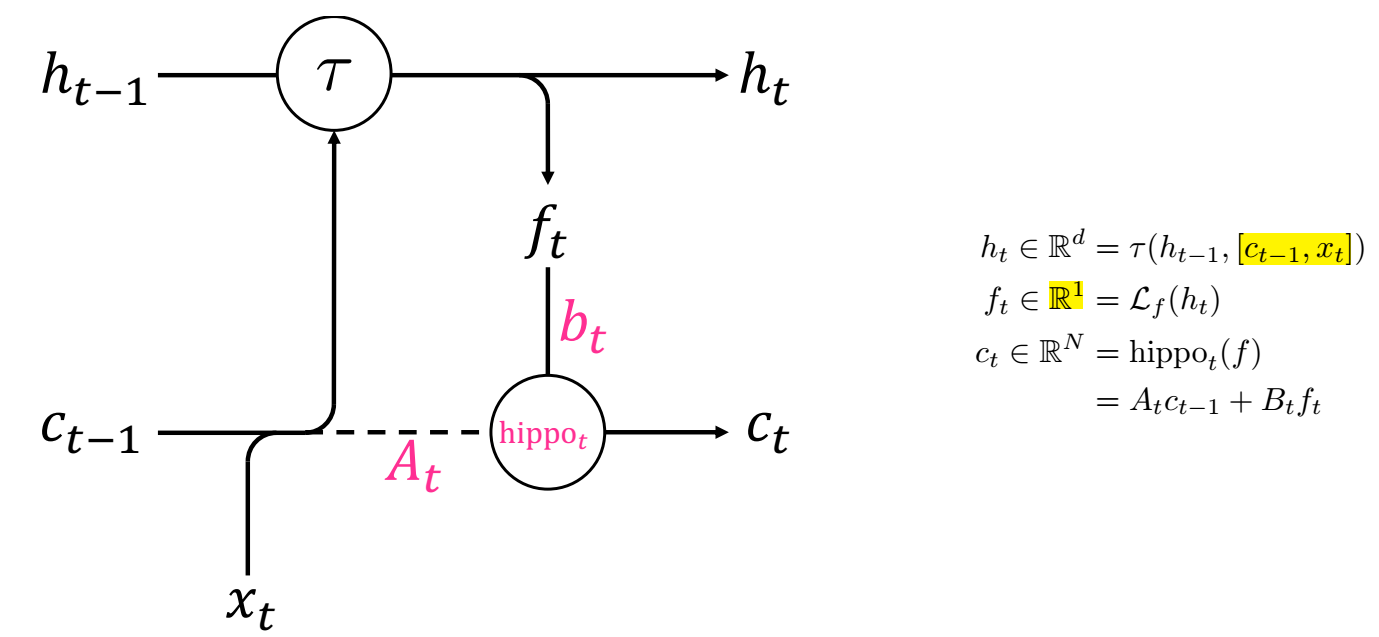

OK, 现在让我们看看如何把这个记忆功能用到 RNN 中:

-

如上图所示, 在更新 RNN 的状态 的时候, 除了 , 额外把系数 作为输入, 特别的 的信号来源是通过 把 压缩到 1 维实现的. 从这一点来看, 目前的 Hippo 设计的还是比较粗糙的?

-

最后讲一下证明关键点:

- 对于上述的测度, 它的正交基是现成的 (有很好的求导的性质);

- 分布积分的求导和转换 的变换很巧妙.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2022-06-05 Catch the Black Sheep: Unified Framework for Shilling Attack Detection Based on Fraudulent Action Propagation

2022-06-05 Learning from Labeled and Unlabeled Data with Label Propagation

2021-06-05 Noise

2021-06-05 Exponential family of distributions