Unlearn What You Want to Forget Efficient Unlearning for LLMs

Chen J. and Yang D. Unlearn what you want to forget: efficient unlearning for llms. 2024.

概

本文提出一种 Unlearning layer 去帮助 LLMs '遗忘' 一些数据.

符号说明

- , large language model (LLM):

- , updated model;

- , training dataset;

- , data to be forgot;

- .

Unlearning Layers

-

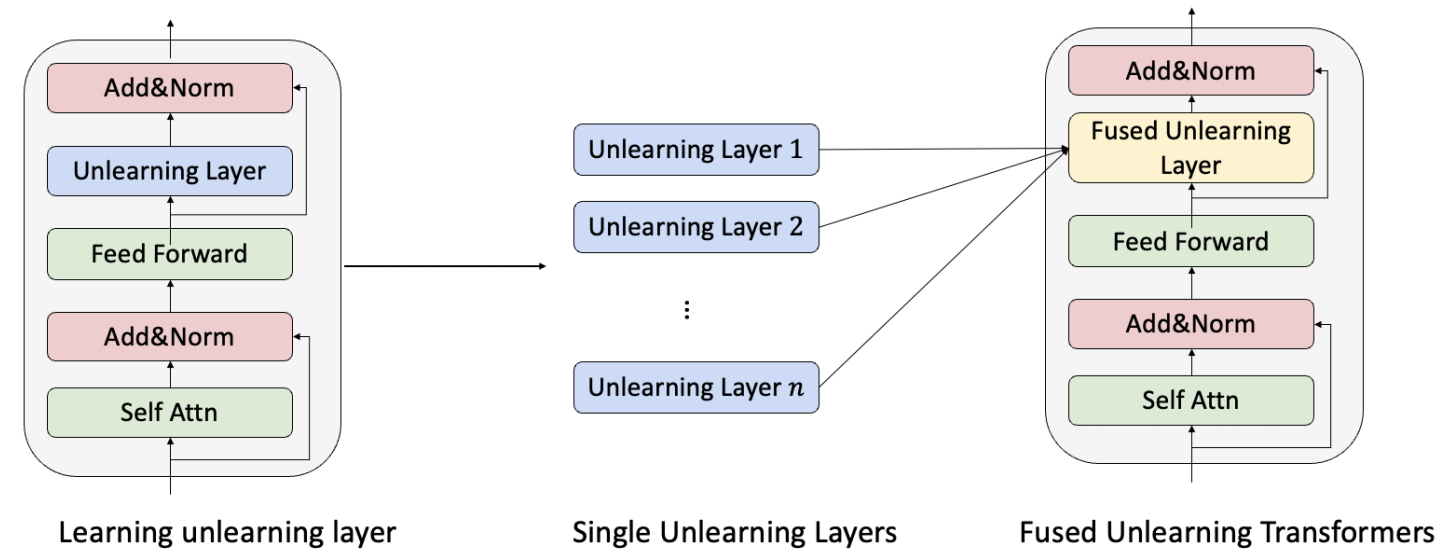

作者希望通过微调 Unlearning Layer 来使得模型能够忘掉数据 , 如上图所示, 就是加载每个 block 中, 它的结构式一个简单的线性层.

-

为了达到这个目标作者首先引入 KL 散度:

即对于一般的数据点, 的输出要和原来的 靠近, 对于需要遗忘的数据点, 则需要和原来的数据点原理 (难道远离就是遗忘吗? 我感觉比较均匀分布会不会更好一点?)

-

其次为了保证下游任务的性能, 引入 task loss:

-

最后是 LM 的预训练损失, 确保 LM 本身也忘掉数据 ,

-

最后总的损失为:

Fusing Unlearning Layers

- 作者还讨论了, 假如我们依次遗忘了 次数据, 即有 , 如何将这些 unlearning layers 综合起来呢? 作者选择求解如下的 :它有显式解如下:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· winform 绘制太阳,地球,月球 运作规律

2023-06-02 Self-Supervised Hypergraph Convolutional Networks for Session-based Recommendation

2020-06-02 Adversarially Robust Generalization Requires More Data