Understanding and Mitigating the Label Noise in Pre-training on Downstream Tasks

概

本文讨论如果预训练模型在训练的时候存在噪声, 会对后续的任务有什么影响, 并提出了一些解决方案.

符号说明

- , inputs;

- , labels;

- , clean dataset, ;

- , noisy pre-training dataset.

- , pre-trained features;

经验性的结果

-

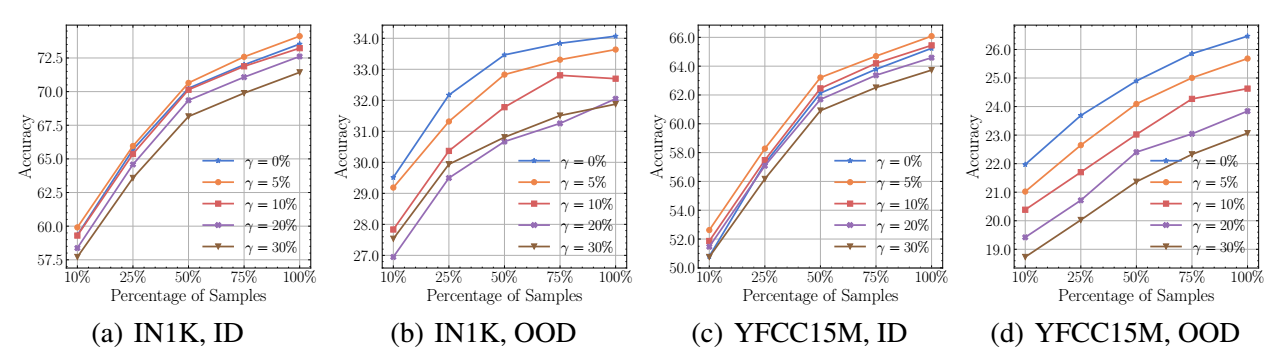

如上图所示, 当给数据集添加不同比例的噪声, ID (In-domain) 的情况会比 OOD (Out-of-domain) 的情况好很多.

-

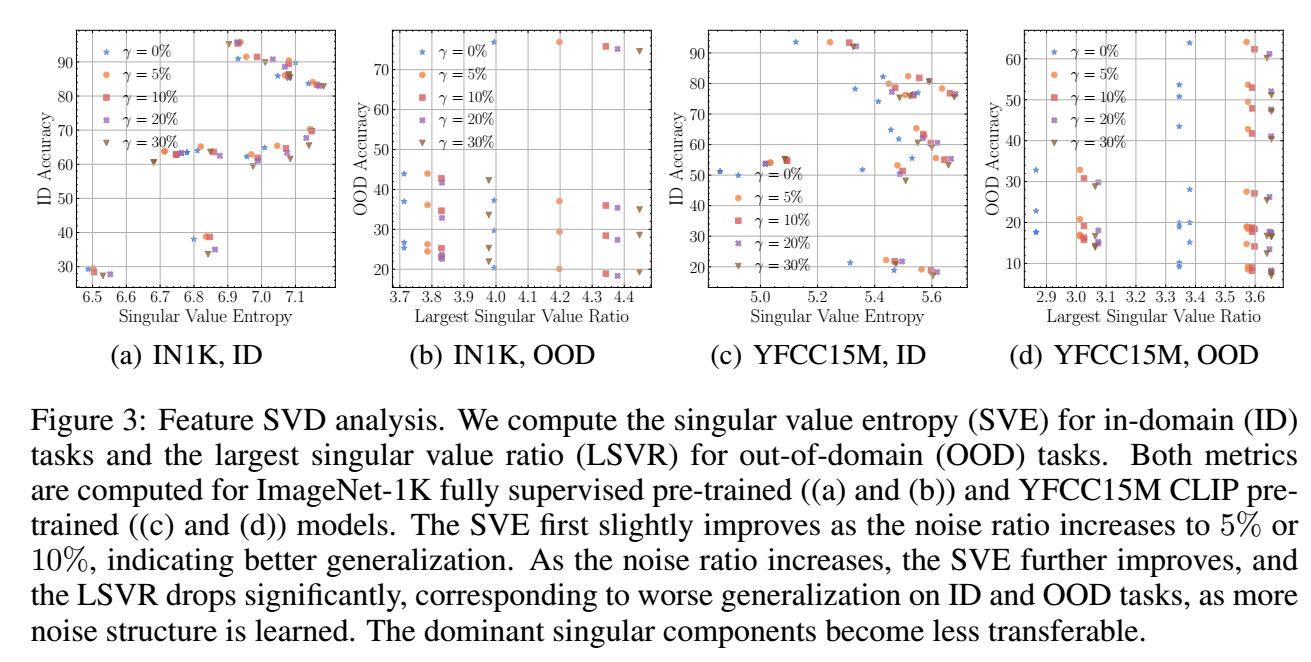

让我们额外定义一些指标, 它们会告诉我们噪声的一些其它影响.

-

Singular Value Entropy (SVE):

奇异值谱的熵反映了预训练得到的特征蕴含的结构, 越大说明其中的结构越丰富.

-

Largest Singular Value Ratio (LSVR):

LSVR 反映的是最大奇异值的情况.

- 如上图所示 (没看懂), 结论如下:

- 稍稍增加一定比例的噪声数据反而有利特征的泛化性;

- 当继续增加噪声数据的比例的时候, SVE 和 LSVR 继续增加 (即 pre-trained faetures 具有越来越多的结构性), 这个时候就没法再继续提高泛化性了.

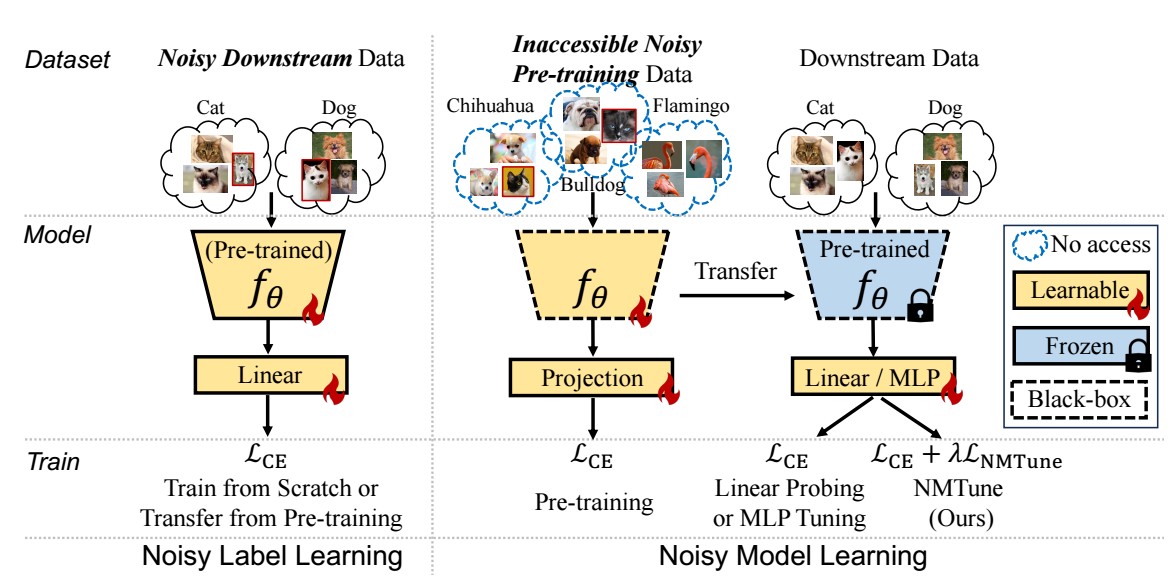

Noisy Model Learning

- 于是作者提出了一宗 noisy model learning 的方法, 它实际上一个训练的时候的正则化项:其中注意, .

代码

分类:

杂学

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2021-05-30 DAG-GNN: DAG Structure Learning with Graph Neural Networks

2019-05-30 matplotlib 高阶之patheffect (阴影,强调)