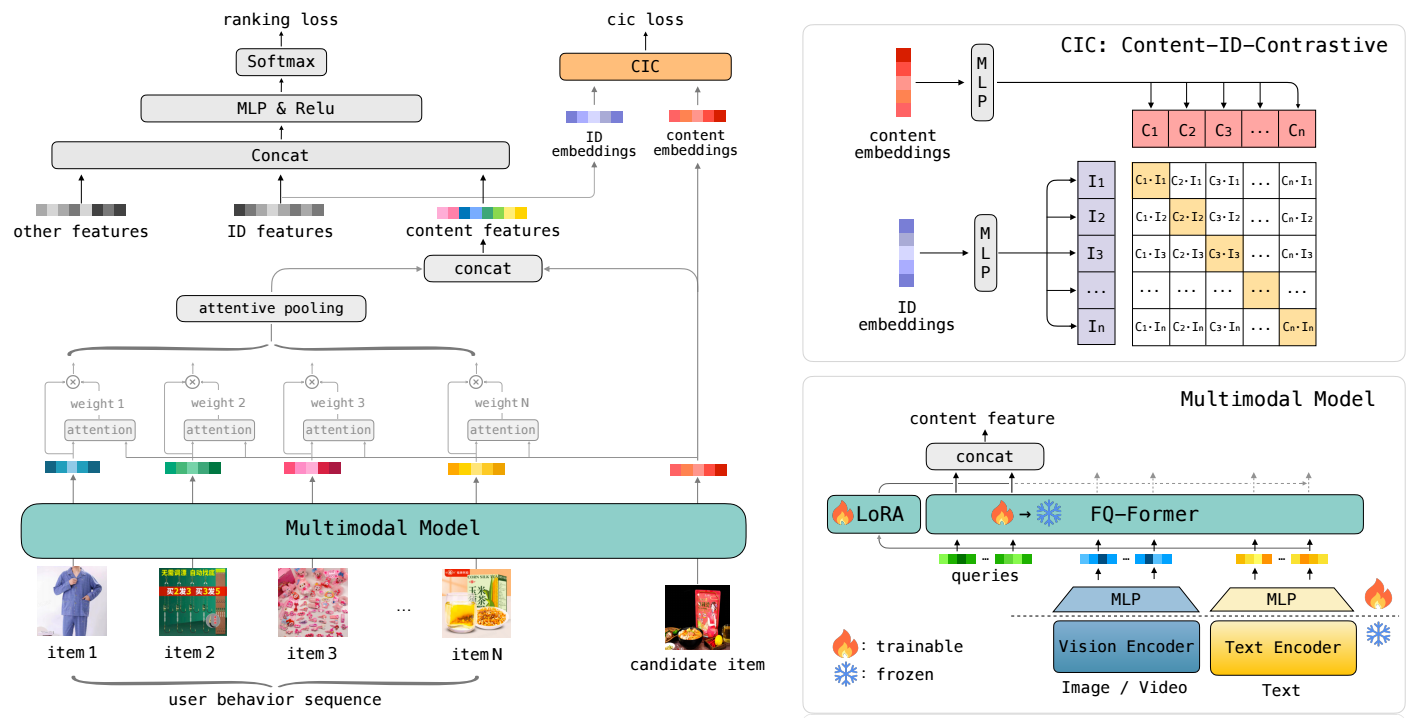

End-to-end training of Multimodal Model and ranking Model

概

本文提出了一个 End-to-End 的多模态模型 (虽然实际上模态 encoder 依旧是不训练的), 利用 Fusion Q-former 进行特征融合.

主要内容

- 由于我只对 Fusion Q-former 感兴趣, 这里只是简单介绍下它的流程:

-

对每个 item, 通过 Vision/Text Encoder 得到对应的模态 embeddings:

注意, 这里假设每个 item 有 M 个图片和 K 个文本描述.

-

通过 FQ-Former 进行特征融合:

其中 表示某个 query, 所以每个 item 最后只有固定长度的特征 (即使图片和文本数量不一致).

-

整个序列的 item 通过上述方式得到 embeddings 后, 通过 attentive pooling 得到 content features.

-

content features 结合其它 features 可以用于后续的 raning.

-

此外, 训练的时候, 要求 ID features 和 content features 对齐 (类似 CLIP).

-

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-05-28 DEFENSE-GAN: PROTECTING CLASSIFIERS AGAINST ADVERSARIAL ATTACKS USING GENERATIVE MODELS

2020-05-28 Obfuscated Gradients Give a False Sense of Security: Circumventing Defenses to Adversarial Examples