How to Learn Item Representation for Cold-Start Multimedia Recommendation

概

作者以往的多媒体推荐对于 cold items 在训练阶段没有足够的重视, 提出细分的训练目标加以纠正.

符号说明

- , user embeddings;

- , item embeddings;

- , item collaborative (ID) embedding;

- , item content embedding

Motivation

-

在多媒体推荐中, 我们常常用

为 item 的 embedding, 其通过函数 将 collaborative/content embeddings 融合在一起 (比如通过拼接的方式).

-

在测试的时候, 对于那些冷启动的 items, 常常使用

来代替.

-

但是, 由于训练中并没有实际上接触过 这种反事实的处理方式, 所以实际上, 可能会导致 train/test 的一个 gap.

-

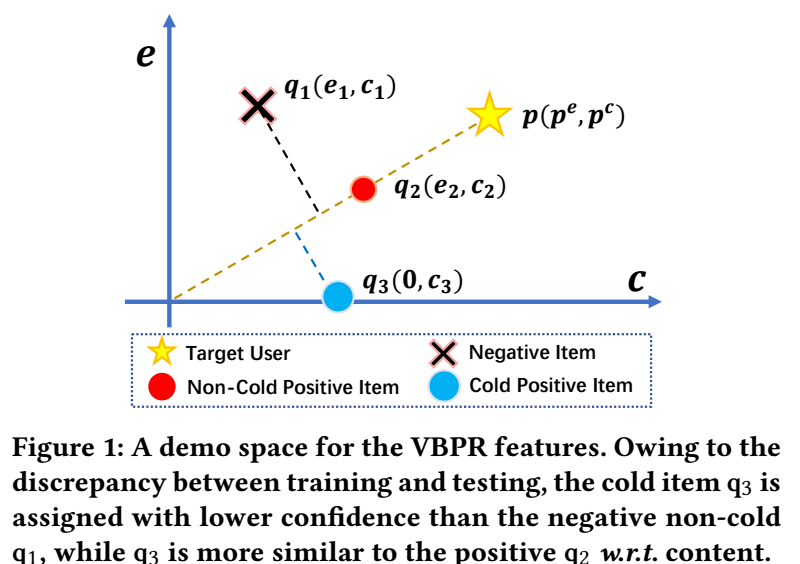

如上图所示:

- 是 non-cold item 但是用户 并不喜欢;

- 是 non-cold item 且用户 喜欢;

- 是 cold item 且用户 喜欢.

-

由于上述的 gap 的存在, 导致简单的设定 collaborative embedding 为 0 并不那么可靠. 我们需要在训练中让模型意识这一点.

Multi-Task Pairwise Ranking (MTPR)

-

定义

分别为 Normal Representaion 和 Counterfactual Representation.

-

对于用户 , 对于正负样本 , 我们可以得到四种情况下的预测:

-

此时, 应用 BPR, 得到四种损失:

-

可以理解:

- NN: 实际上就是最普通的情况, 这种实际上主要针对的是 non-cold items 的优化;

- CC: 实际上针对的是所有的 items 的优化;

- NC/CN: 实际上在训练的过程中, 将 cold/non-cold items 的 gap 抹去了.

-

最后 MTPR 就是这四个损失的加和:

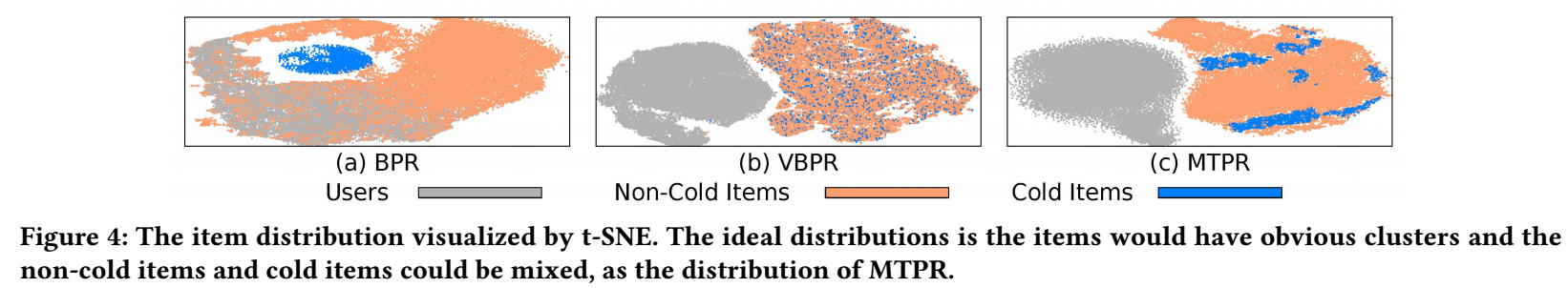

- 如上图所示, 作者展示通过 MTPR 训练后的 t-sne 的可视化情况, 此时 cold items 本身成簇, 同时又和 non-cold items 混合在一起.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2023-05-11 Towards Deeper Graph Neural Networks

2022-05-11 Data Poisoning Attacks on Factorization-Based Collaborative Filtering

2019-05-11 matplotlib 进阶之Legend guide