Towards Foundation Models for Knowledge Graph Reasoning

目录

概

如何从不同领域的图中学习的有价值的可迁移的信息是通往 graph foundation model 的根本. 本文在多关系建模问题 (主要围绕知识图谱推理) 上给出了一个极为简单却有效的方案.

符号说明

- , nodes;

- , edge types;

- , edges, 表述为 triplet .

- , knowledge graph;

ULTRA (a method for Unified, Learnable, and TRAnsferable KG representations)

- 只是图谱的推理问题是回答如下的问题:

-

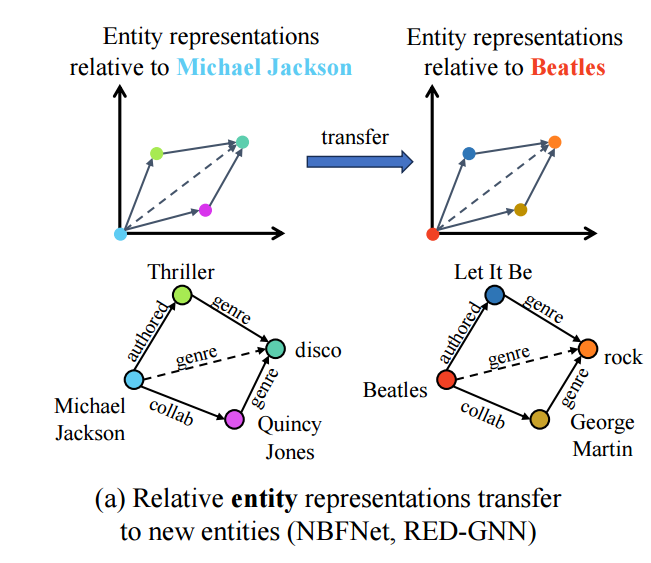

Transductive: 如上图所示, 我们可以得出一个比较直接的结论. 一步步地,

- Michael Jackson 创作了 (authored) Thriller, 属于 disco 流派 (genre);

- 他的合作者 Quincy Jones 属于 disco 流派;

- 则我们可以推断出 Michael Jackson 的流派也是 disco.

- 倘若模型学到了这种结构关系, 那么我们很容易也能得出:可以推断出: .

-

但是学到这种关系的模型往往无法直接运用到一些别的领域上, 经过关系的模式是非常相似的. 比如:

-

几乎是一样的推理规则, 但是由于这些 entities 或者 edge types 未曾见过, 导致模型无法直接应用.

-

本文提出的 ULTRA 来一般性的学习这些关系间的关系, 然后介绍如何推广到 inductive 的环境中.

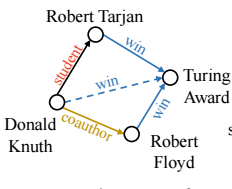

Relation Graph Construction

- ULTRA 将知识图谱 转换为新的图 :

- ;

- 包括:

- tail-to-head (t2h): 说明 中存在 ;

- head-to-head (h2h): 说明 中存在 ;

- head-to-tail (h2t): 说明 中存在 ;

- tail-to-tail (t2t): 说明 中存在 ;

- 的确定根据如上的关系.

-

上图给了一个实际的例子.

-

大部分的基于 GNN 的推理都离不开邻接矩阵, 我们来说明如何得到 的邻接矩阵. 首先, 我们定义 的邻接矩阵为 . 每一条边 , 实际上我们都可以拆成:

于是, 我们可以构建得到:

满足:

-

则

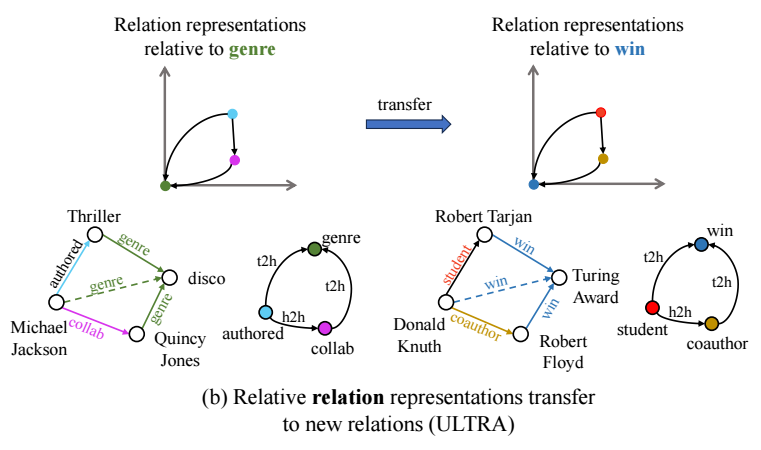

Conditional Relation Representations

-

现在, 我们来将怎么依靠 训练和推理. 主要是依靠一些 inductive learning 方法, 本文基于 NBFNet:

注意到, 上面的过程中不涉及特定的 node features, 而是仅为 node 初始化为 其余为 , 故而可以推广到任意图. 其它的细节请看 NBFNet.

-

假设我们通过 (1) 在多个 relation graphs (涉及不同的领域) 训练好, 然后我们想要在一个新的图 上进行推理怎么办?

- 将这个新的图 转换为 relation graph, 然后用之前的模型在其上推理, 得到表示 . 注意, 这个表示是 query 依赖的.

- 作者额外再利用一个 NBFNet 进行 link prediction:

-

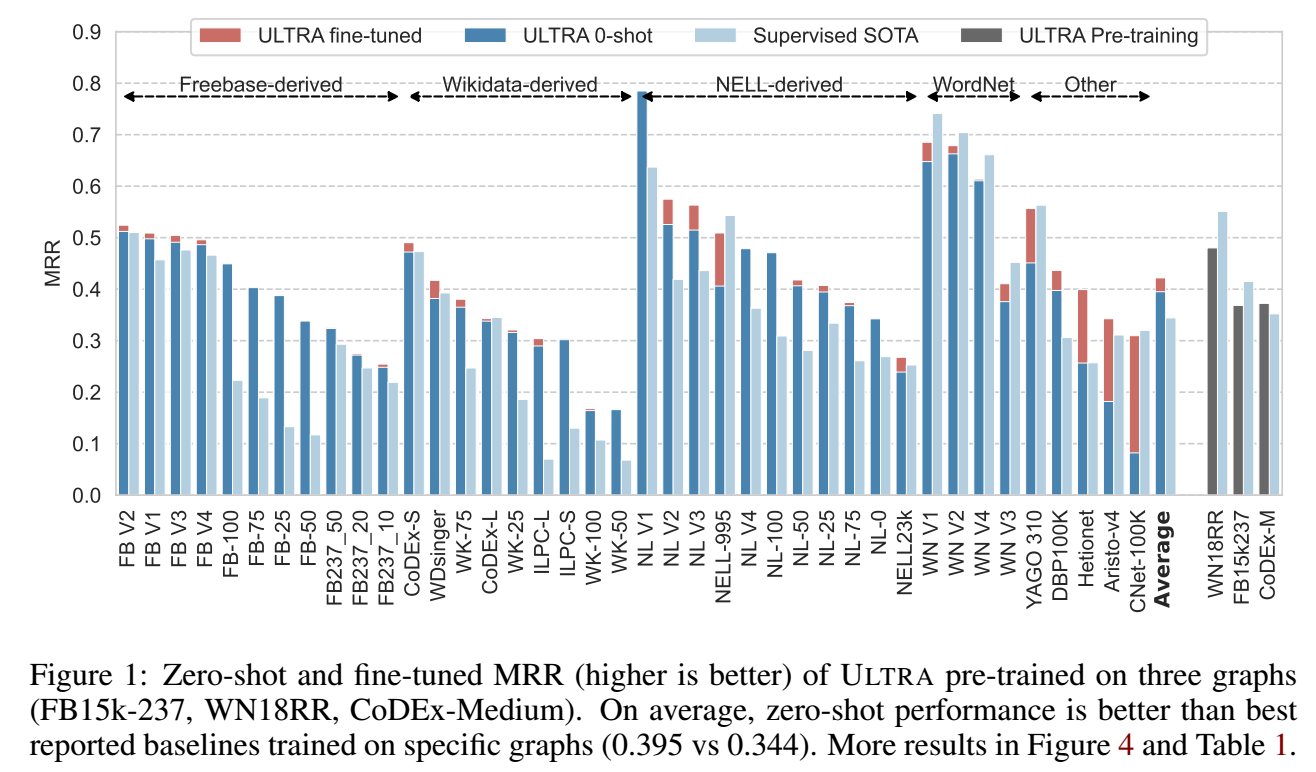

需要注意, 上面两个阶段所涉及的参数都可以在一些数据集上预训练, 然后直接应用在下游的一些任务上, 从而实现 zero-shot 的推理. 也可以在下游任务进行一些微调. 具体的训练方式, 作者采取 BCE 进行训练.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix