Graph Neural Networks with Learnable and Optimal Polynomial Bases

Guo Y. and Wei Z. Graph neural networks with learnable and optimal polynomial bases. ICML, 2023.

概

自动学多项式基的谱图神经网络.

符号说明

- , node set, ;

- , edge set;

- , normalized adjacency matrix;

- , normalized Laplacian matrix;

- , node features.

Motivation

-

一般的普通神经网络可以表述为如下的形式:

其中 通常是多项式基.

-

特别的, 通常关于非负的权重函数 正交, 即

-

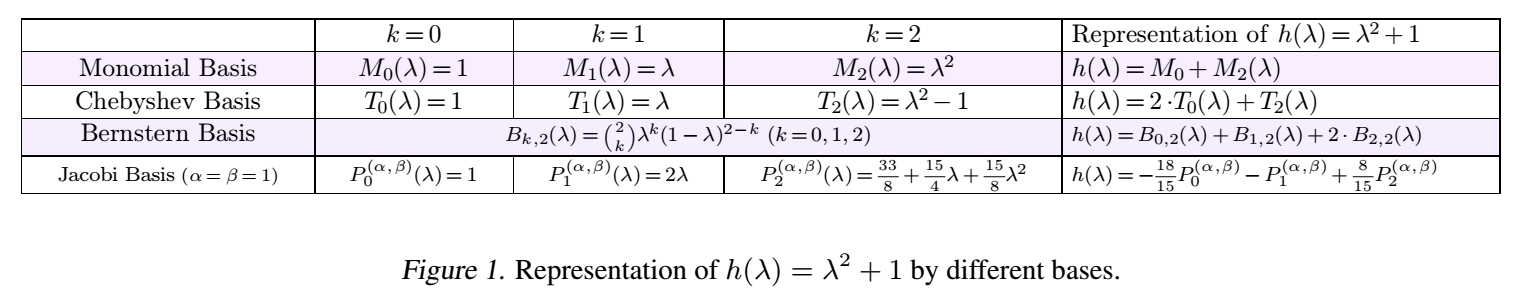

一些常见的多项式基如下所示:

-

大部分叫的上名字的多项式基都被考虑过了, 当然因为这些叫的上名字的多项式基或多或少都有一些比较好的性质, 本文的一个想法是, 不能够自己学一个多项式基呢?

FavardGNN

-

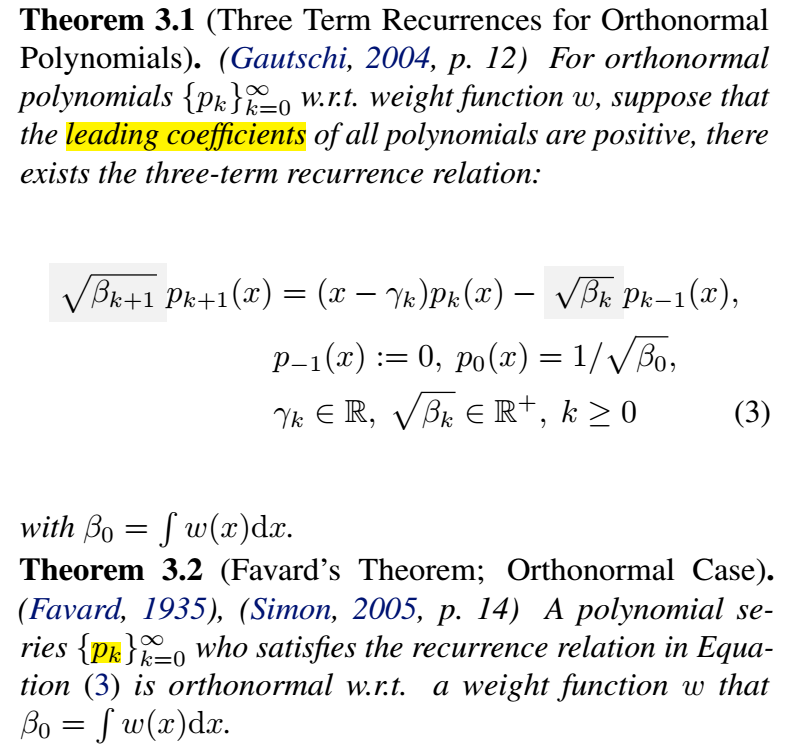

首先, 有如下的两个定理:

-

即, 对于任意的正交多项式基, 我们能够构造出 three-term recurrence 的迭代公式, 反之, 一旦我们构造出了这样的迭代公式, 也就确定了一个(正交)多项式基.

-

其实, 如果对 Chebyshev, Jacobi 不陌生的同学已经发现, 这些多项式基的定义, 本身就是 three-term recurrence 形式的.

-

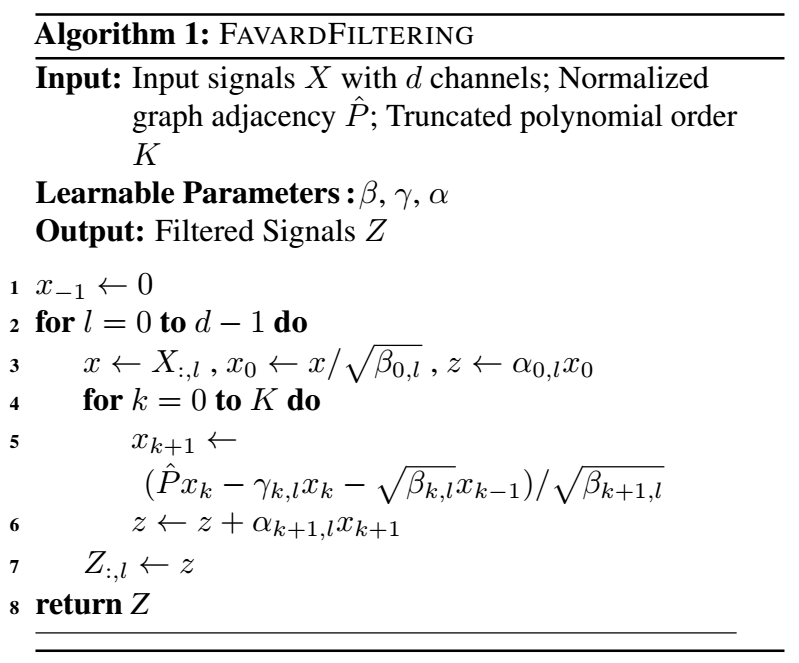

总而言之, 只要我们将 视作可学习的参数, 则我们就可以自动地学习一个比较好的多项式基. 当然了 所对应的可学习参数需要保证是非负的.

-

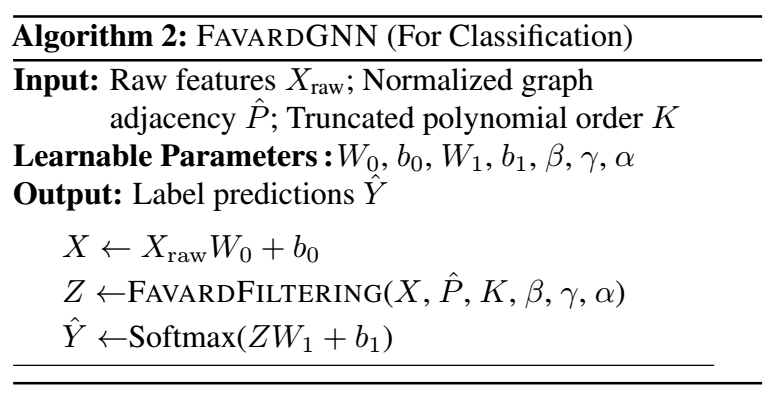

于是, 由此导出的 FavardGNN 便可表示为:

注: 作者还讨论了一种加了额外限制的多项式基, 有兴趣的可以回看原文.

代码

[official]

分类:

Neural Networks

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-12-02 FineGAN