Guo Z., Shiao W., Zhang S., Liu Y., Chawla N. V., Shah N. and Zhao T. Linkless link prediction via relational distillation. ICML, 2023.

概

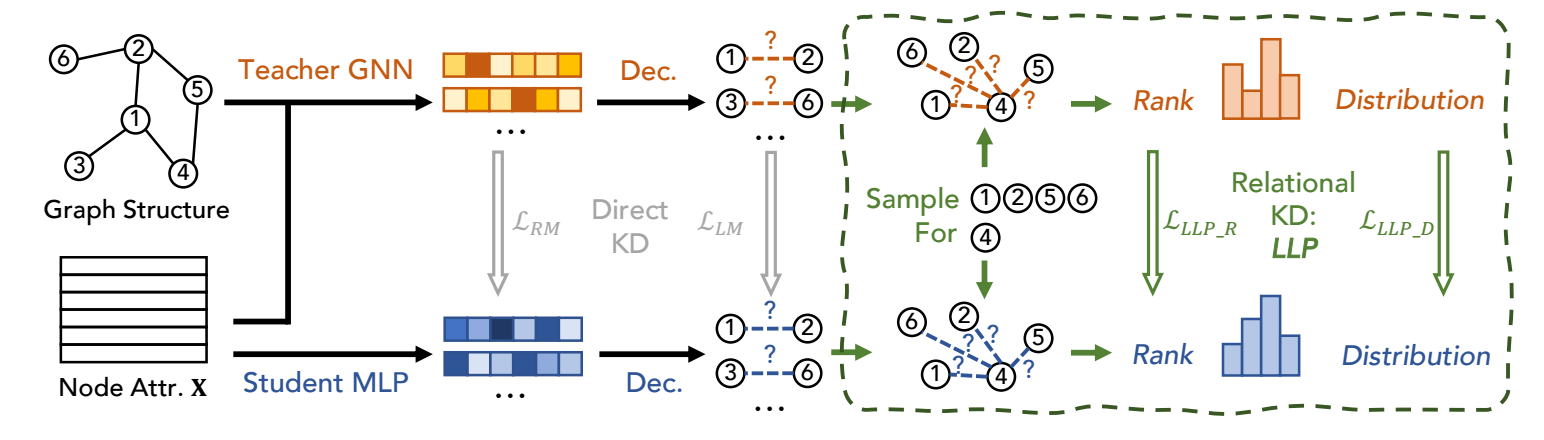

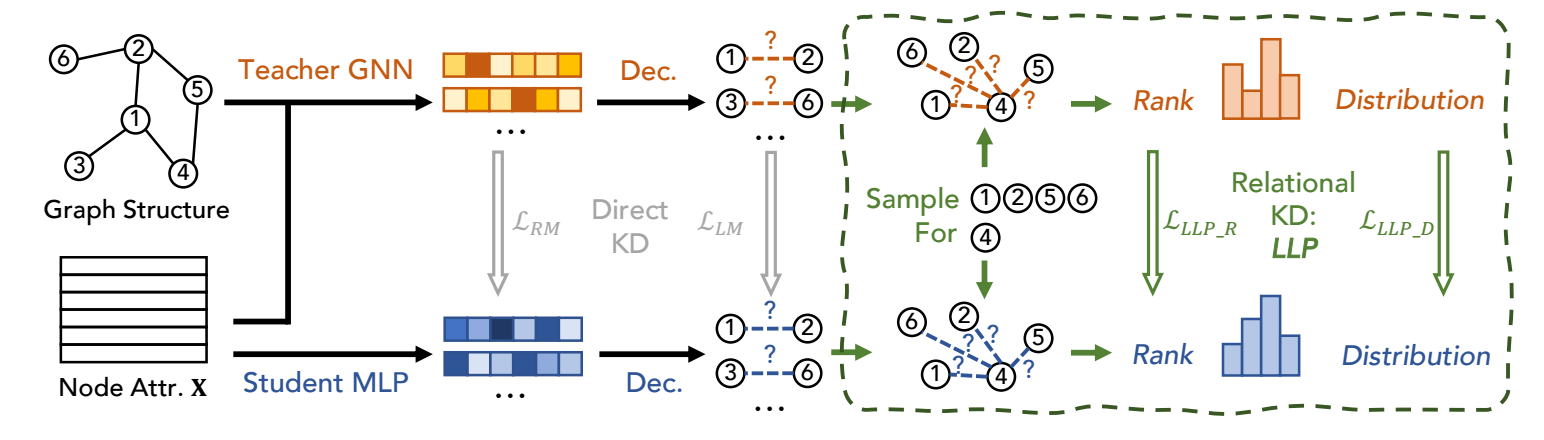

从 GNN 教师模型蒸馏到 MLP 学生模型.

符号说明

- G=(V,E), 无向图;

- A∈{0,1}N×N, 邻接矩阵;

- X∈RN×F, node features;

- E−=(V×V)∖E.

- H∈RN×D, 结点表示.

LLP

-

LLP 假设教师模型是一个 GNN 模型 (因为通过它所得的结点表示有比较好的结构信息), 然后希望通过蒸馏将这些信息蒸馏给学生模型.

-

想法很简单, 令:

^yij=σ(Decoder(hi,hj))

为对结点 vi,vj 间存在边的概率预测. 通过下面的两种方式, 拉近教师模型和学生模型的分布.

-

Rank-based Matching:

LLLP_R=∑v∈V∑^yv,i,^yv,jmax(0,−r⋅(^yv,i−^yv,j)+δ),

其中

r=⎧⎪

⎪⎨⎪

⎪⎩1 if ytv,i−ytv,j>δ,−1 if ytv,i−ytv,j<−δ,0 otherwise.

想法其实很简单, 就是要求学生模型模型教师模型的排序 (以一定的 margin δ), 如果不满足给予一定的惩罚.

-

Distribution-based Matching:

LLLP_D=∑v∈V∑i∈Cvexp(ytv,i/τ)∑j∈Cvexp(ytv,j/τ)logexp(^yv,i/τ)∑j∈Cvexp(^yv,j/τ).

即一般的 logits 的蒸馏. Cv 是需要采样的, 以免过多的计算量. 采样方式如下:

- 通过随机游走采样局部近似的点, 记为 CNv;

- 随机采样结点, 记为 CRv;

- 最后 Cv=CNv∪CRv.

-

最后的训练损失为:

L=α⋅Lsup+β⋅LLLP_R+γ⋅LLLP_D.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2022-11-06 Diffusion Improves Graph Learning