Graph Neural Networks with Adaptive Residual

概

基于 UGNN 框架的一个更加鲁棒的改进.

符号说明

- , 邻接矩阵;

- .

- ;

AirGNN

-

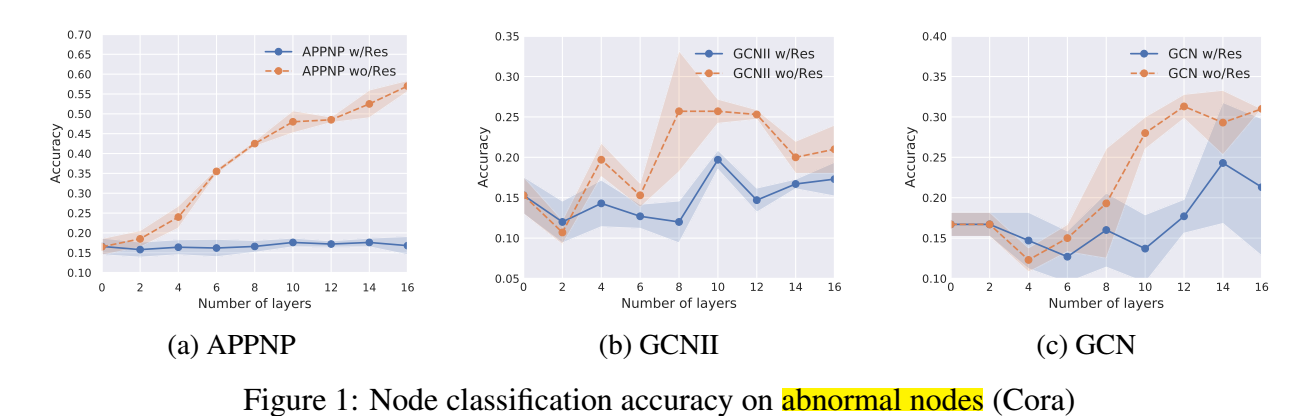

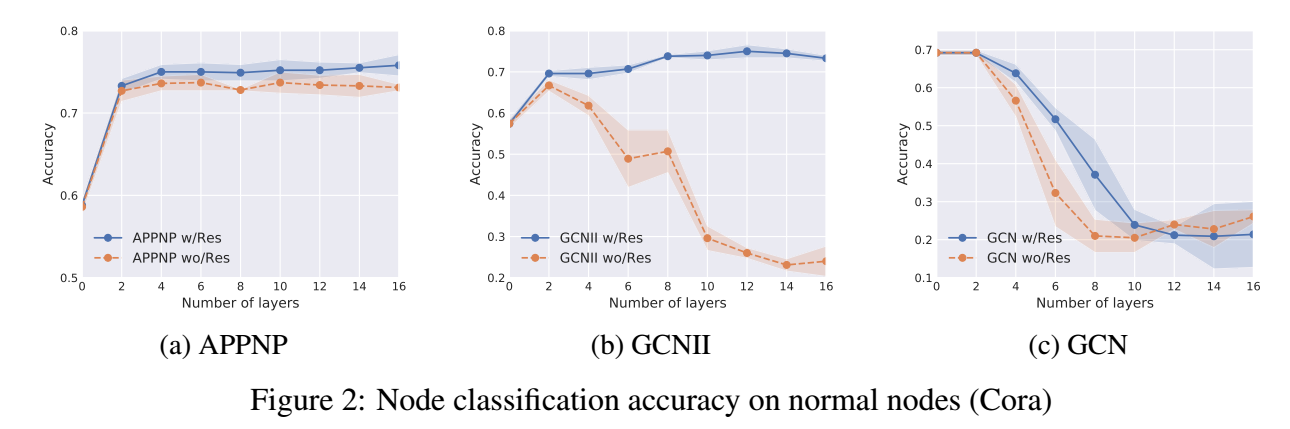

下面是在不同的图任务上的一个训练结果:

-

可以发现, 残差连接可以帮助 GNNs 利用更多的层去区别正常的结点, 但是却使得在异常结点上的分类恶化.

-

我们可以这样认为, 简单的没有残差连接的图网络能够平滑结点表示, 所以此时随着层数的加深, 对于异常结点的分类会更好. 相反, 如果加了残差连接, 最后的结点表示始终会受到一开始的异常结点表示的影响, 所以结果并不太好.

-

但是, 我们也不能直接移除残差连接, 因为这是加深 GNN 的几乎必须的技巧.

-

一般的 GCN 都可以归结为如下的方式:

-

, 我们知道, 对于异常值是敏感的, 所以作者转而改写成如下的更加鲁棒的方式:

其中

-

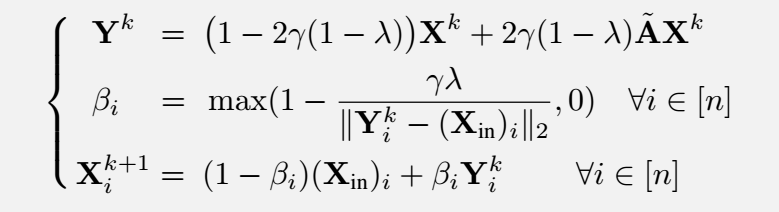

通过 proximal gradient descent 来求解上面的问题, 得到如下的迭代方式:

-

一个直观的理解是:

- 当结点 的特征异常的时候, 通常 比较大;

- 这就导致 比较大;

- 此时 更多由它的邻居决定 (即 ), 否则由它本身 决定.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-10-31 Adversarial Self-Supervised Contrastive Learning