Ma C., Ma L., Zhang Y., Sun J., Liu X. and Coates M. Memory augmented graph neural networks for sequential recommendation. AAAI, 2021.

概

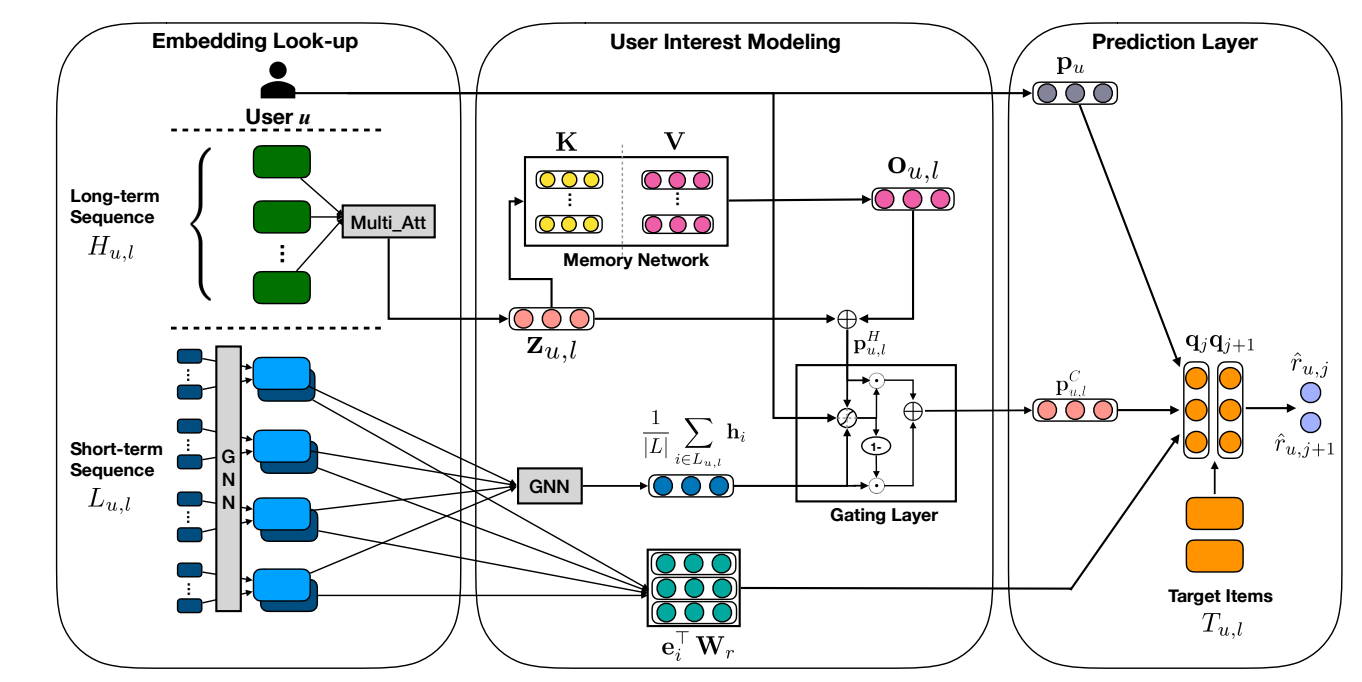

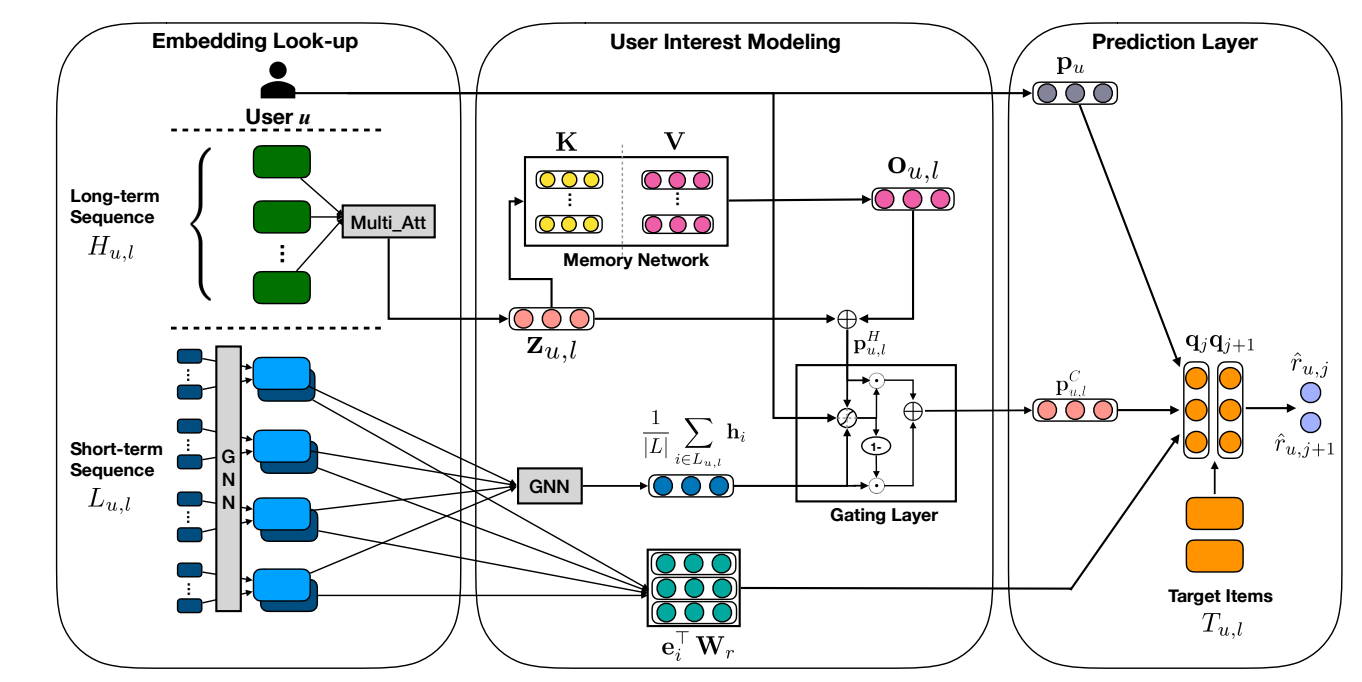

用图提取 short-term interest, 用 memory network 提取 long-term interest.

符号说明

- Su=(I1,I2,…,I|Su|), 用户 u 的交互序列;

- pu, 用户 u 的 embedding;

- hi, item i 的 embedding;

MA-GNN

- 总体来说, MA-GNN 分为三条路:

- Short-term interest;

- Long-term interest;

- User embedding.

Short-term Interest Modeling

-

首先, 将序列 Su 切分成长度为 |L 的多个子序列:

Lu,l=(Il,Il+1,…,Il+|L|−1),

训练中, 我们会用该子序列去预测接下来的 |T| items.

-

子序列 Lu,l 可以理解为某一阶段的用户的短期兴趣, MA-GNN 利用 Item Graph 来建模这一部分. 对于序列 Lu,l, 对于结点 u≠v∈Lu,l, 两个结点间存在边若 d(u,v)<3, d(u,v) 表示在序列中 (u,v) 之间的最小的间隔. 如上图所示, 设经过行归一化后的邻接矩阵为 A.

-

接着, 我们用两层的图网络来提取 short-term interest:

hi=tanh(W(1)⋅[∑k∈NiekAi,k;ei]),∀i∈Lu,lpSu,l=tanh(W(2)⋅[1|L|]∑i∈Lu,ihi;pu).

这里 Ni 是限定 Lu,l 中的一阶邻居, [⋅;⋅] 是拼接操作.

Long-term Interest Modeling

-

首先定义

Hu,l=(I1,I2,…,Il−1),

为 Lu,l 之前的交互信息.

-

首先通过注意力得到一个向量表示:

Hu,l:=Hu,l+PE(Hu,l),Su,l=softmax(W(3)atanh(W(1)aHu,l+(W(2)apu)⊗1ϕ))∈Rh×|Hu,i|Zu,l=tanh(Su,l⋅HTu,l)∈Rh×dzu,l=avg(Zu,l)∈Rd.

其中 Hu,l 为对应 item 的向量表示矩阵, PE(⋅) 为 sinusoidal positional encoding, ⊗ 表示外积.

-

接下来, 将 query zu,l 通过 Memory network

si=softmax(zTu,l⋅ki),ou,l=∑isivi,pHu,l=zu,l+ou,l.(1)(2)(3)

其中 ki,vi 分别来自 K,V∈Rd×m 的第 i 列. 我们可以认为, K,V 中学习到了一些不同的偏好的原型, 通过加权求和, 我们找到了对于 u 的 l 之前的偏爱的建模.

Interest Fusion

-

最后, 通过 LSTM 来将二者融合:

gu,l=σ(W(1)g⋅1|L|∑i∈Lu,lhi+W(2)g⋅pHu,l+W(3)g⋅pu),pCu,l=gu,l⊙1|L|∑i∈Lu,lhi+(1d−gu,l)⊙pHu,l.

-

并通过 (q 是可训练的参数):

^ru,j=pTu⋅qj+(pCu,l)Tqj+1|L|∑i∈Lu,leTiWrqj.

-

利用 BPR 损失进行训练.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· AI技术革命,工作效率10个最佳AI工具

2022-07-07 A Framework for Understanding Sources of Harm throughout the Machine Learning Life Cycle