Chamberlain B. P., Shirobokov S., Rossi E., Frasca F., Markovich T., Hammerla N., Bronstein M. M. Hansmire M. Graph neural networks for link prediction with subgraph sketching. In International Conference on Learning Representations (ICLR), 2023.

概

本文分析了原先的 MPNN 架构以及 subgraph GNN 在 link prediction 任务上的局限性, 以此提出了 ELPH (Efficient Link Prediction with Hashing) 用以结合二者.

符号说明

-

V, nodes;

-

E, edges;

-

G=(V,E), undirected graph;

-

d(u,v), shortest walk length;

-

S=(VS,ES), subgraph, 满足

ES={(u,v)∈E|u,v∈VS}.

-

Skuv=(Vuv,Euv), 由边 (u,v) 引出的 k-hop subgraph, 其中 Vuv 是 u,v 的 k-hop neighbors.

必要的定义

同构与自同构-graph-level (G1≅G2): 假设 G1=(V1,E1),G2=(V2,E2) 为两个简单图, 称它们是同构的若存在一双射 φ:V1→V2 满足:

(u,v)∈E1⇔(φ(u),φ(v))∈E2,∀u,v∈V1.

进一步, 若 G1=G2, 则称它们为自同构的.

直观上来讲, 两个图同构, 就是存在一一对应的点具有相同的结构.

G-自同构-node-level (u∼Gv): 假设 G=(V,E) 为一简单图, u,v 为其中的两个点, 称它们是等价的若存在一双射 φ:V→V 满足:

(a,b)∈E⇔(φ(a),φ(b))∈E,∀a,b∈V.

且

u=φ(v).

G-自同构-edge-level ((u1,v1)∼G(u2,v2)): 假设 G=(V,E) 为一简单图, (u1,v1),(u2,v2) 为其中的两条边, 称它们是等价的若存在一双射 φ:V→V 满足:

(a,b)∈E⇔(φ(a),φ(b))∈E,∀a,b∈V.

且

u2=φ(u1),v2=φ(v1).

Motivation

-

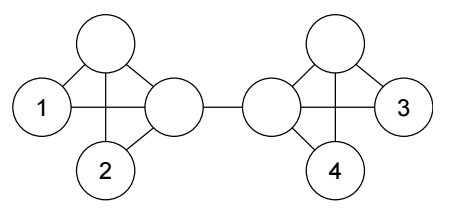

首先给出一个事实, 即 u1∼Gu2∧v1∼v2⇏(u1,v1)∼G(u2,v2), 如上图所示:

- 所有的点都是自同构的;

- 比如取 u1=u2=n0,v1=n1,v2=n2, 若 (u1,v1)∼G(u2,v2), 则有 (n0,n2)∈E, 这是错的.

-

但是现在的 MPNN, 强调自己具有和 WL-Test 相当的表达能力, 恰恰意味着不能够很好地解决这个问题 (对于 link prediction 而言).

-

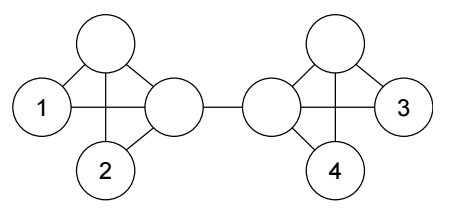

如上图所示, 依赖 WL 算法, 倘若我们连接 (1, 2), 那么必定也要连接 (1, 4):

-

因为倘若两个结点 v2∼Gv4 那么 WL 算法会为两个上同样的色, 可以看成是赋予相同的特征, 不妨设为 z2=z4=z;

-

此时, 一般的 link prediction 会通过:

suv=ϕ(zu,zv)

计算 score, 就会有

s12=s14=ϕ(z1,z).

-

此时, 若 (1, 2) 被连接, 那么 (1, 4) 也应当被连接, 但是这和直观上的理解是不符的.

-

当然了, 需要说明的是, 上面的例子有其特殊性, 在实际中, 每个结点都有它的结点 (或者赋予 embedding), 这就导致实际上很难出现 zu=zv 的情况 (不考虑 over-smoothing).

-

现有的一些基于 subgraph 的方法通过为结点排序来解决这一问题 (见 Palette-WL, SEAL), 但是 subgraph 的提取是复杂的, 且不易并行计算.

ELPH

-

定义

Auv[du,dv]:=|{n∈V:d(n,u)=du,d(n,v)=dv}|,Bkuv[d]:=∞∑dv=k+1Auv[d,dv].

-

ELPH 的每一层为 (共 k 层):

e(l)u,v={Buv[l],Auv[du,l],Auv[l,dv]:∀du,dv<l},x(l)u=γ(l)(x(l−1)u,□v∈N(u){ϕ(l)(x(l−1)u,x(l−1)v,e(l)u,v)}),

其中 □ 是某种 permutation-invaiant aggregation function, 比如 (sum, mean, max). x 是结点特征.

-

最后通过如下方式进行 link prediction:

p(u,v)=ψ(x(k)u⊙x(k)v,{Buv[d]})

-

总的来说, ELPH 既有 node features, 也有 'edge' features.

-

需要注意的是, 在实际中, A,B 的计算是比较复杂的, 所以作者采用的是一种近似方法, 首先注意到:

Au,v[du,dv]=|Ndu(u)∩Ndv(v)|−∑x≤du∑x≠y≤dv|Nx(u)∩Ny(v)|,Bkuv[d]=|Nd(u)|−Bkuv[d−1]−d∑i=1d∑j=1Auv[i,j],

其中 Nd(u):={v∈V:d(v,u)≤d}. 注: 说实话, 我不是很能理解为什么 B 有这样的迭代公式, 我自己推导出来的结果是:

Bkuv=|Nd(u)|−|Nd−1(u)|−k∑j=1Auv[d,j].

-

注意, 即使如此, |Nd(u)| 和 |Ndu(u)∩Ndv(v)| 的计算依然是复杂的, 作者通过 MinHash 和 HyperLogLog 来近似它们.

-

通过 HyperLogLog 近似任意集合的大小 |S|:

-

通过 MinHash 近似 Jaccard similarity.

代码

datasketch: hyperloglog; hyperloglog++; minhash

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix