Difformer: Empowering Diffusion Models on the Embedding Space for Text Generation

概

本文发现并改进了原先 Diffusion 模型的缺点 (针对文本生成任务).

符号说明

- , source sentence;

- , target sentence;

- 前向过程:其中 将离散的 token 映射到 embedding 空间.

- 反向过程:一般, 方差和前向保持一致, 然后我们实际上拟合的是

主要内容

-

Diffusion 在文本生成之上的应用大抵为优化如下的损失:

前者是普通的 diffusion 损失, 后者是用于离散到连续的对齐.

-

问题1: 可学习的 embeddings: 和 image, video 不同的是, embedding 是可学习的, 这可能导致训练的不稳定.

-

解决办法1: 如上图所示, 我们用不同时刻 t 的预测 来靠近 , 即

来替代 .

-

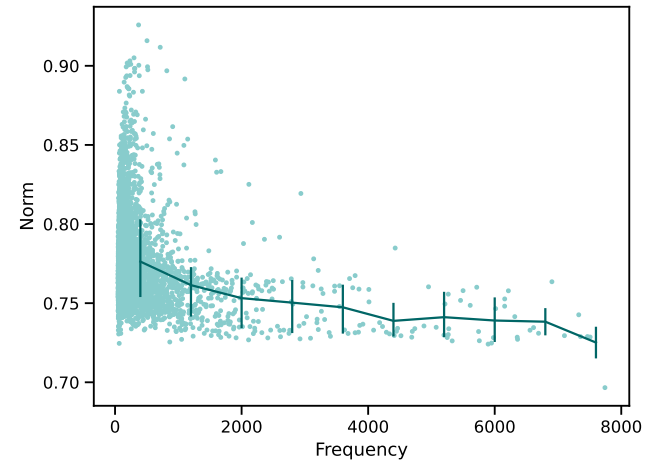

问题2: embedding 的 norm 不一致: 由于词频不一致, 作者发现训练过程中高频词的 norm 会普遍大一点. 此时加入相同量级的噪声对于信号的干扰程度就不一致了:

-

解决办法2: 故作者在 embedding 之后加了一个 embedding normalization 层 (不过看起来对实际效果的提升不是特别大):

-

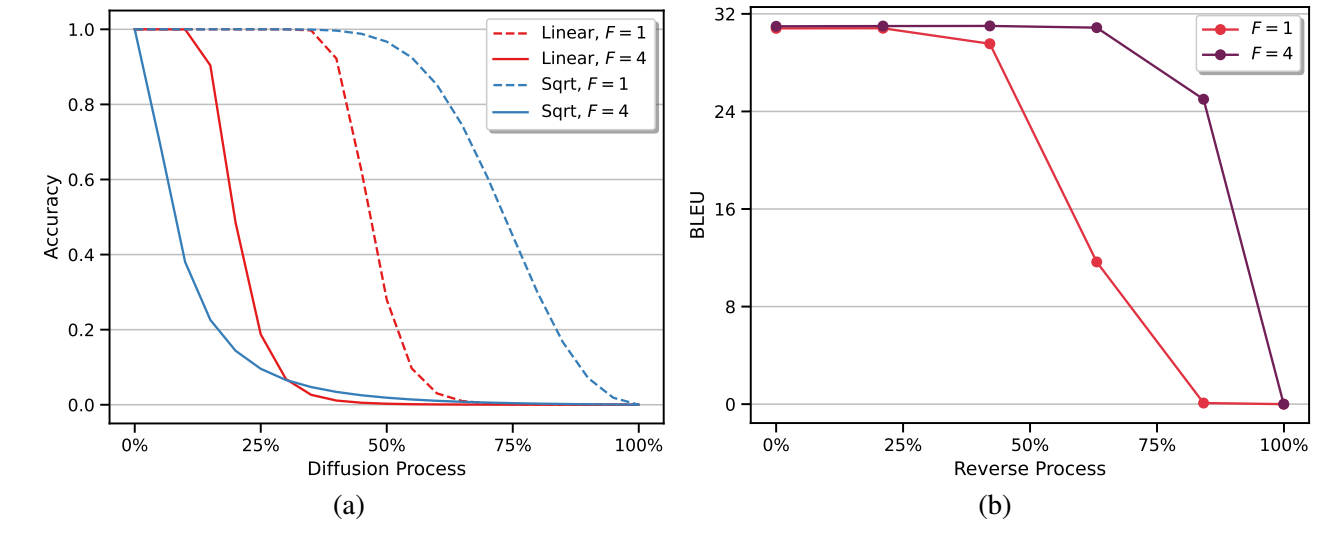

问题3: noise schedule 导致扩散过程的大部分阶段都是'无意义'的: 作者发现, 对于一般的前向过程和 noise schedule 而言, 整个过程的大部分时间的干扰效果都是很差的, 此时很难充分训练 (特别是对于 sqrt 这种 schedule):

-

解决办法3: 作者对整体的扰动的方差进行一个扩张:

一般的扩散 , 作者发现 会产生相当不错的结果.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 开源Multi-agent AI智能体框架aevatar.ai,欢迎大家贡献代码

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· AI技术革命,工作效率10个最佳AI工具

2021-03-27 MADE: Masked Autoencoder for Distribution Estimation