本文梳理一下 VAE -> Flow -> Diffusion 的过程 [9]. 需要声明的是, 个人是没有进行过这方面的实践的, 相关的理论只是也比较匮乏, 这里只是一个对这些从事贝叶斯网络研究满怀敬意的人的纸上谈兵了. 扩散模型没有被时间洪流所掩埋, 真是让人感动的事情.

符号说明

- x∈Rd, 数据向量, 服从某个分布;

- 我们通常以 p(x),q(x) 来表示某种分布;

- |A|,det(A), 矩阵 A 的行列式;

- ∇f,∇⋅f, 梯度算子;

- KL(p∥q), KL 散度;

前言

-

无论是 VAE, 还是 Flow, 亦或是现在流行的 Diffusion 模型, 都是在建模生成模型 p(x):

- 有了概率模型 p(x), 我们就可以从中采样 (虽然, 如何采样本身也是一个问题), 这就是很好玩的图像生成的来源;

- 倘若我们还能够建模 p(x,y) (这里 y 是某个, 比如标签), 我们还可以做条件采样 (根据 p(x|y)), 或者分类任务 ^y:=argmaxyp(y|x).

-

遗憾的是, 我们从接下来的一些章节中可以发现, 这是一个相当困难的问题.

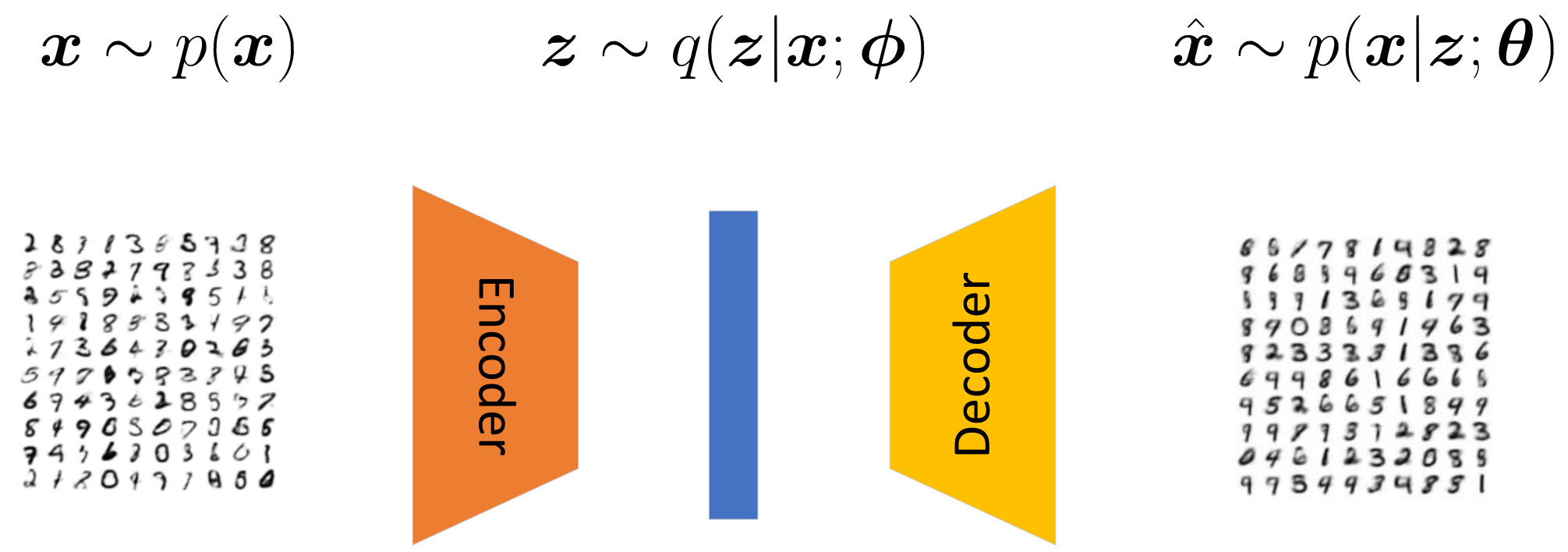

VAE

-

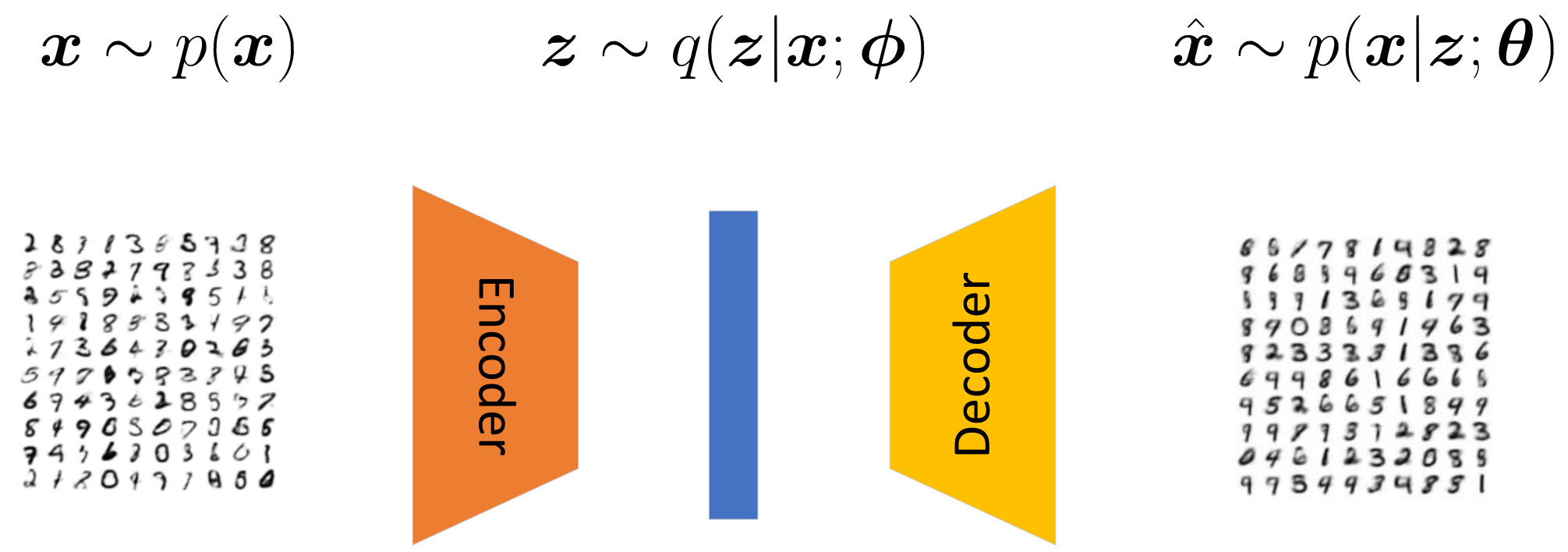

VAE [1] (即变分自编码) 的思路是, 首先将样本 x 映射到一个低维的空间中, 隐特征 z 服从一个分布, 我们需要从中采样 (如果不采样就变成自编码了), 然后再经过 decoder 将隐变量 z 映射回到源空间.

-

我们的目标是构建 p(x;θ) 去拟合真实的分布 p(x), 但是仔细想, 我们很难直接用现存的简单的分布来建模, 所以我们通常转而利用一个联合分布 p(x,z;θ) 来建模, 同时希望

p(x;θ)=∫zdzp(x,z;θ)≈p(x).

-

具体的, 作者希望构建一个 decoder 来建模 p(x|z;θ):

- 比如, 我们将其建模为 ^x|z∼N(x;μθ(z),σθ(z)I), 这里 μθ,σθ 分别建模了均值和方差;

-

然后我们通过极大对数似然优化

maxθEp(x)[logp(x;θ)]≈N∑i=1logp(xi;θ).

-

但是, 还是那个问题, 我们通常是写不出 p(x;θ) 的显式形式的, 所以 VAE 的思路是采用 ELBO.

-

注意到

logp(x;θ)=log∫zdzp(x,z;θ)=log∫zdzp(x,z;θ)⋅q(z|x;ϕ)q(z|x;ϕ)=logEqϕ[p(x,z;θ)q(z|x;ϕ)]≥Eqϕ{log[p(x,z;θ)q(z|x;ϕ)]}←Jensen's Inequality=Eqϕ{log[p(x|z;θ)p(z)q(z|x;ϕ)]}=Eqϕ{[logp(z)q(z|x;ϕ)+logp(x|z;θ)]}=Eqϕ[logp(x|z;θ)] reconstruction term −KL(qϕ(z|x)∥p(z))prior matching term.(1)

最后两项分别为重构项和先验匹配项. 最大化 ELBO 实际上是最大化的下界.

-

实际上,

logp(x;θ)−[Eqϕ[logp(x|z;θ)]−KL(qϕ(z|x)∥p(z))]=KL(qϕ(z|x)∥p(z|x)),

即这个下界的优劣取决于我们的 encoder 对于后验分布 p(z|x) 拟合得好不好.

Flow

注: 这里 |⋅| 表示绝对值, 在下文中, 我们会用 |A|:=det(A).

VAE -> Diffusion

-

Diffusion 的理论框架 [3] 其实和 FLow [2] 是同一年的 ICML 上被提出来的, 只能说英雄所见略同啊.

-

VAE 有一个很强的愿望 (我不清楚原作者是否在意这个部分), 就是希望提取出一个隐变量 z, 且隐变量 z 和样本 x 是强相关的. 但是实际上, 只要我们找到一个联合分布 p(x,z;θ) 满足

∫zdzp(x,z;θ)≈p(x)

成立, 那么这个就可以做我们的分布. 只是通常这样做, 我们很难找到一个简单的容易拟合也容易采样的分布.

-

换言之, 理论上隐变量 z 只是 VAE 的一个副产物 (基于前人美好的设想, 认为这样有助于生成模型的学习, 毕竟隐变量的维度比较低, 比较容易避免维度灾难的问题).

-

事实上, 给定数据分布 p(x) 和一个先验分布 p(z), 存在无穷多的后验分布 q(z|x;ϕ) 使得所对应的联合分布 p(x,z)=p(x)q(z|x;ϕ) 满足边际分布 p(z). 同理, 对于 p(x|z;θ) 也有同样的观点. 这说明, VAE 其实拟合的是一个不定的问题, pθ,qϕ 并没有一个确切的方向去学习. 这或许会导致训练起来不是那么高效 (个人看法).

-

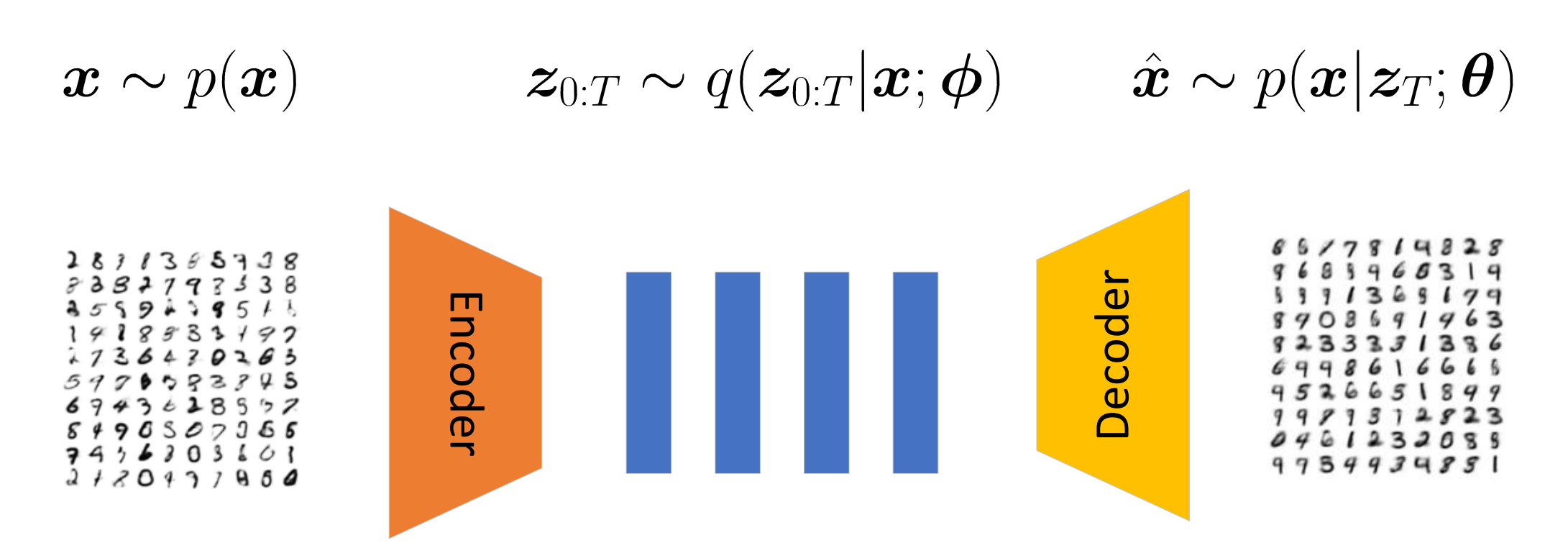

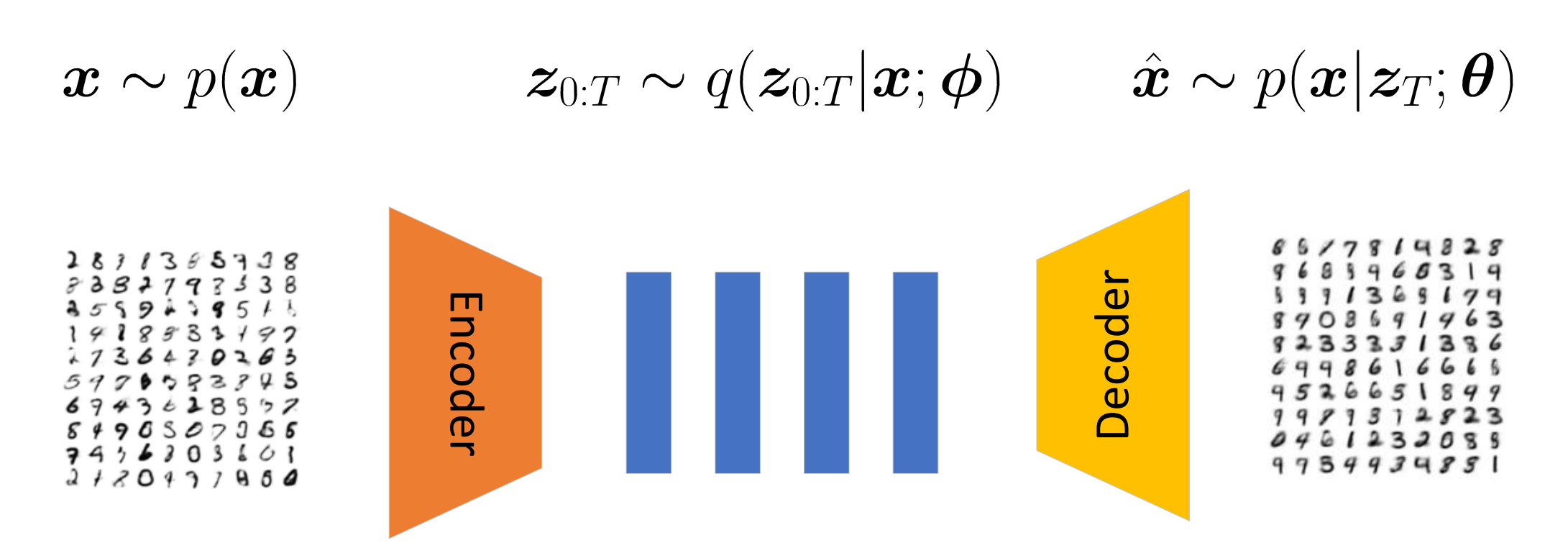

抛开对隐变量的执念, 我们只需要固定 qϕ 或者 pθ 然后专心拟合另外一个就可以了. 于是, DPM 实际上就是构造了 q, 它保证

p(x0)=∫dz1:Tq(x0,z1:T)

的严格成立. 如此以来, 我们只需要转型负责 pθ 的构造和拟合即可. 当然为了上式构造方便, DPM 采用 zt=xt, 维度不变的设计. 当然, 我们失去了隐变量, 这一副产品.

-

这里需要特别说明的是, 虽然没了隐变量, 对 DPM 的操控也是可行的, 况且, 在普通的 VAE 的隐变量上直接操控通常也是困难的 (我们很难说清楚哪个维度到底对应了那些特征).

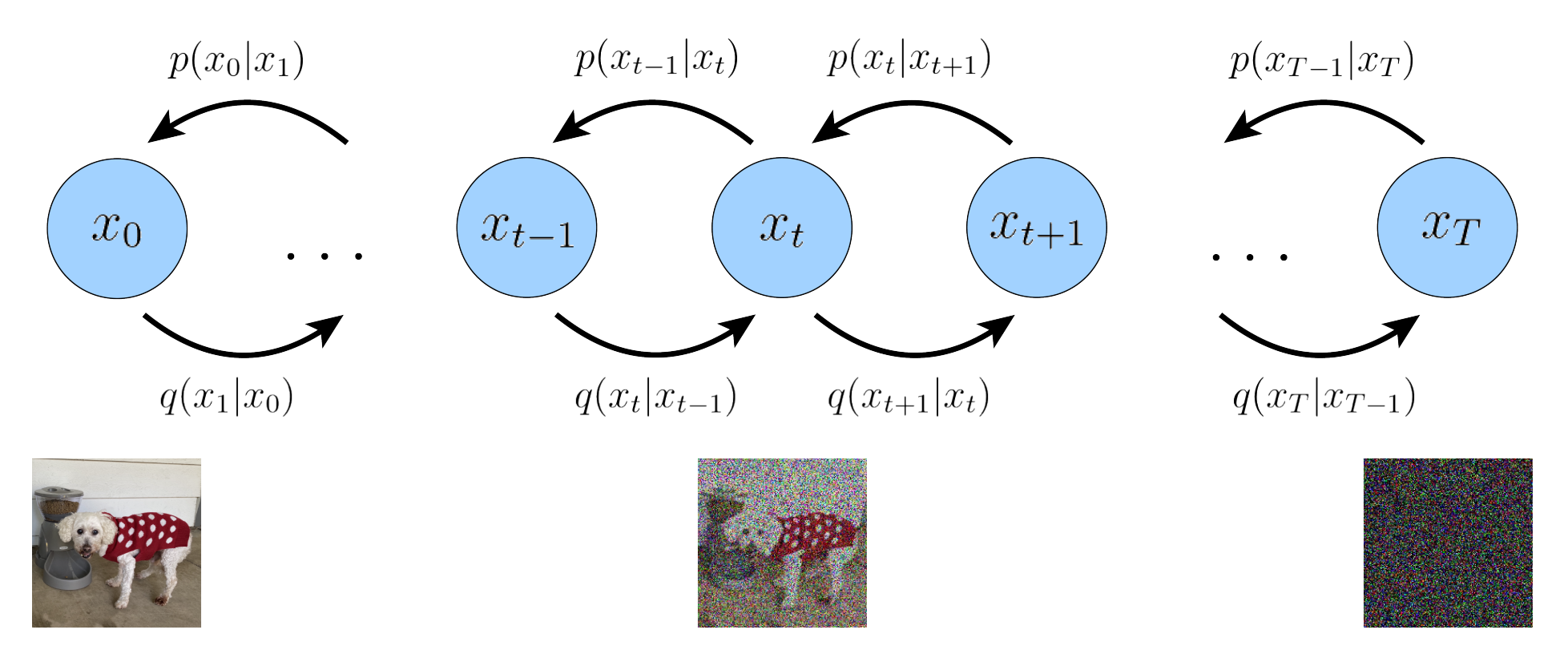

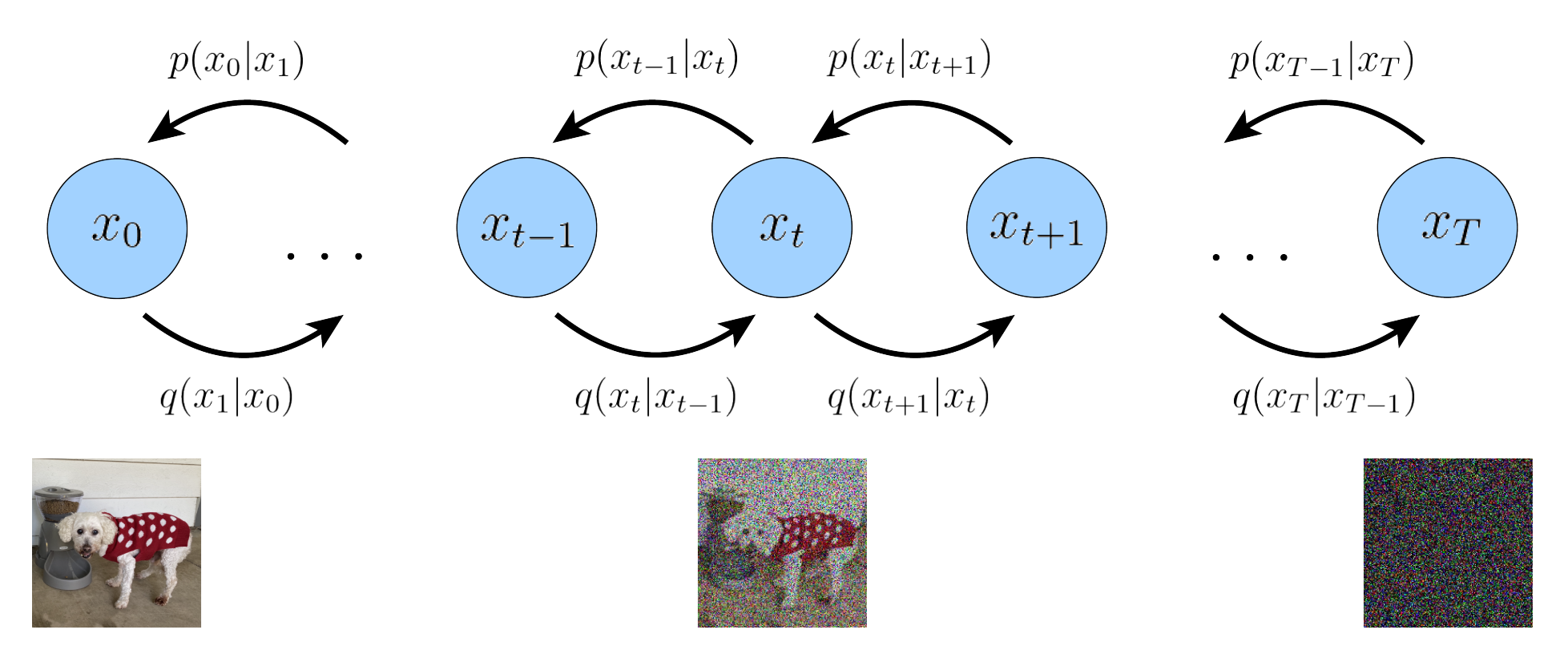

前向扩散过程

-

首先是一个前向扩散的过程, 我们在原始真实分布 p(x0) 的基础上, 构建一系列的中间过程

q(xt|xt−1),t=1,2,⋯T,

具体的, 比如 (一会儿我们会看到这么设计的用处)

q(xt|xt−1)∼N(xt;√1−βtxt−1,βtI).

这里 βt 是扩散率. 需要特别注意的是, 这里的一步步逼近是确定的, 并非是美好的期望, 所以这里我们这个扩散过程并没有拟合的问题. 实际上, 我们可以显式地求解出 q(xt|x0) 来.

-

注意到

xt=√1−βtxt−1+√βtϵ,←ϵ∼N(0,I)=√1−βt(√1−βt−1xt−2+√βt−1ϵ′)+√βtϵ=√1−βt√1−βt−1xt−2+√1−βt√βt−1ϵ′+√βtϵ=√1−βt√1−βt−1xt−2+√1−(1−βt)(1−βt−1)ϵ←Q1?=⋯=(∏ts=1√1−βs)x0+√1−∏ts=1(1−βs)ϵ,(4)

Q1 的部分是因为 ϵ′,ϵ 独立同分布, 二者的和依旧是正态分布, 于是:

cov(√1−βt√βt−1ϵ′+√βϵ,√1−βt√βt−1ϵ′+√βϵ)=cov(√1−βt√βt−1ϵ′,√1−βt√βt−1ϵ′)+cov(√βϵ,√βϵ)=(1−βt)(βt−1)I+βtI=(1−(1−βt)(1−βt−1))I.(5)

最后的最后可以通过归纳法来得到, 这里不多赘述了.

-

由此可知

q(xt|x0)⇔N(xt;[t∏s=1√1−βs]x0,[1−t∏s=1(1−βs)]I).(6)

我们可以令 ¯αt:=∏ts=1αs,αs:=1−βs, 则

q(xt|x0)⇔N(xt;√¯αtx0,(1−¯αt)I).(7)

此外还有性质

(1−¯αt−1)(1−βt)+βt=(1−¯αt−1)αt+βt=αt−¯αt+βt=1−¯αt.(8)

-

此外, 我们还可以求出 q(xt−1|xt,x0):

q(xt−1|xt,x0)=q(xt|xt−1,x0)q(xt−1|x0)q(xt|x0)=q(xt|xt−1)q(xt−1|x0)q(xt|x0)← 马氏性 ∝q(xt|xt−1)q(xt−1|x0)← 关注核即可∝exp{−12(1−¯αt−1)βt[(1−¯αt−1)∥xt−√1−βtxt−1∥2+βt∥xt−1−√¯αt−1x0∥2]}∝exp{−12(1−¯αt−1)βt[(1−¯αt)∥xt−1∥2−2(1−¯αt−1)√αtxTtxt−1−2√¯αt−1βtxT0xt−1]}.(9)

于是, 根据核可知, 分布为高斯分布, 且

q(xt−1|xt,x0)⇔N(xt−1;√¯αt−1(1−αt)x0+√αt(1−¯αt−1)xt1−¯αt=:μt(xt,x0),(1−αt)(1−¯αt−1)1−¯αt=:σ2tI).(10)

反向采样过程

-

反向采样过程即是上述过程的一个逆过程, 从 p(xT) 出发, 从联合分布

p(x0:T;θ)=p(xT)T∏t=1p(xt−1|xt;θ),(11)

中即可采样得到一组序列

xT,xT−1⋯x0,

我们期望通过 θ (故反向采样过程是需要训练的) 使得最后的 x0 是服从真实分布 p(x0) 的.

-

自然地, 和 VAE, Flow 的方式一样, 我们希望通过对数似然来优化

logp(x0)=log∫x1:Tdx1:Tp(x0:T;θ)=log∫x1:Tdx1:Tp(x0:T;θ)⋅q(x1:T|x0)q(x1:T|x0)=logEq(x1:T|x0)[p(x0:T;θ)q(x1:T|x0)]≥Eq(x1:T|x0)log[p(x0:T;θ)q(x1:T|x0)]← Jensen's Inequality =Eq(x1:T|x0)log[p(xT)∏Tt=1p(xt−1|xt;θ)∏Tt=1q(xt|xt−1)]=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(xT|xT−1)+∑T−1t=1logp(xt|xt+1;θ)q(xt|xt−1)}=Eq(x1:T|x0)[logp(x0|x1;θ)]+Eq(x1:T|x0)[logp(xT)q(xT|xT−1)]+Eq(x1:T|x0)[∑T−1t=1logp(xt|xt+1;θ)q(xt|xt−1)]=Eq(x1|x0)[logp(x0|x1;θ)]+Eq(xT−1:T|x0)[logp(xT)q(xT|xT−1)]+∑T−1t=1Eq(xt−1:t+1|x0)[logp(xt|xt+1;θ)q(xt|xt−1)]=Eq(x1|x0)[logp(x0|x1;θ)]reconstruction term−Eq(xT−1|x0){KL(q(xT|xT−1)∥p(xT))prior matching term }−∑T−1t=1Eq(xt−1,xt+1|x0){KL(q(xt|xt−1)∥p(xt|xt+1);θ)} consistency term (12)

注意到:

reconstruction term: 最大化这个即最小化重构损失;prior matching term: 最小化这个即最小化 q(xT|xT−1) 和先验分布 p(xT) 的距离 (当然, 因为本身不包含 θ, 所以想要这个足够小, 就只有选择合适的 βt);consistency term: 最小化这个, 即要求两个序列在 xt,t=1,…,T1 处的分布是一致的.

-

通常, 我们为了估计上面的下界, 我们会用蒙特卡洛采样, 但是注意到 (12) 的 consistency 需要一次性采样 xt−1,xt+1, 所以是极其不稳定的.

-

为此, 我们考虑引入 (9) 来解决这一问题.

logp(x0)=log∫x1:Tdx1:Tp(x0:T;θ)=log∫x1:Tdx1:Tp(x0:T;θ)⋅q(x1:T|x0)q(x1:T|x0)=logEq(x1:T|x0)[p(x0:T;θ)q(x1:T|x0)]≥Eq(x1:T|x0)log[p(x0:T;θ)q(x1:T|x0)]← Jensen's Inequality =Eq(x1:T|x0)log[p(xT)∏Tt=1p(xt−1|xt;θ)∏Tt=1q(xt|xt−1)]=Eq(x1:T|x0)log[p(xT)p(x0|x1;θ)∏Tt=2p(xt−1|xt;θ)q(x1|x0)∏Tt=2q(xt|xt−1,x0)]← 马氏性 =Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(x1|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt|xt−1,x0)}=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(x1|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt−1|xt,x0)q(xt|x0)q(xt−1|x0)}←(9)=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(x1|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt−1|xt,x0)+∑Tt=2logq(xt−1|x0)q(xt|x0)}=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(x1|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt−1|xt,x0)+logq(x1|x0)q(xT|x0)}=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(x1|x0)+logq(x1|x0)q(xT|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt−1|xt,x0)}=Eq(x1:T|x0){logp(xT)p(x0|x1;θ)q(xT|x0)+∑Tt=2logp(xt−1|xt;θ)q(xt−1|xt,x0)}=Eq(x1:T|x0)[logp(x0|x1;θ)]+Eq(x1:T|x0)[logp(xT)q(xT|x0)]+∑Tt=2Eq(x1:T|x0)[logp(xt−1|xt;θ)q(xt−1|xt,x0)]=Eq(x1|x0)[logp(x0|x1;θ)]+Eq(xT|x0)[logp(xT)q(xT|x0)]+∑Tt=2Eq(xt−1:t|x0)[logp(xt−1|xt;θ)q(xt−1|xt,x0)]=Eq(x1|x0)[logp(x0|x1;θ)]−L1 reconstruction term−KL(q(xT|x0)∥p(xT))L0 prior matching term −∑Tt=2Eq(xt|x0){KL(q(xt−1|xt,x0)∥p(xt−1|xt;θ)}L2:T consistency term (13)

各损失的设计与处理

现在我们已经有了

L0:=KL(q(xT|x0)∥p(xT))L1:=Eq(x1|x0)[logp(x0|x1;θ)]Lt:=Eq(xt|x0){KL(q(xt−1|xt,x0)∥p(xt−1|xt;θ)}t=2,…,T.

piror matching term

L0:=KL(q(xT|x0)∥p(xT)).

-

这实际上是统一前向的过程. 给定 p(x0), q(x1:T|x0)=∏Tt=1q(xt|xt−1), 我们实际上已经确定了联合分布

q(x0:T),

自然也就确定了边际分布

q(xT).

-

但是比较尴尬的是, 我们已经提前确定好了先验分布 p(xT)=N(0;I) (因为它好采样), 所以我们是需要 q(xT)≈p(xT) 来保证一个和谐统一的. L0 大体上就是做的这么一个事情.

-

DDPM 通过设计合适的 βt 来使得 L0 比较小.

-

由 (6) (7) 可知:

q(xt|x0)⇔N(xt;[t∏s=1√1−βs]x0,[1−t∏s=1(1−βs)]I)⇔N(xt;√¯αtx0,(1−¯αt)I).(14)

-

既然我们希望它接近标准正态分布, 这就意味着

¯α→0.

-

我们惊奇地发现, 只要 βt∈(0,1), 且步数 T 足够多, 这个条件总是能够被满足的. 当然一个较小的 βt 容易更快的收敛 (但这不意味着反向的过程是更快的).

-

这一步的完成预告我们成功地完成且固定了联合分布 q(x0:T) (而且边际分布满足我们的要求), 而我们接下来所要做的, 仅仅是通过一些方法来拟合这个联合分布, 使得采样是便利的, 可能的.

-

需要注意的是, 也有 βt 或 αt 是可训练的情况, 后面我们会介绍其中一种情况.

reconstruction term

L1:=Eq(x1|x0)[logp(x0|x1;θ)].

- 这实际上是在要求我们反向的边界对齐 [3].

- 把 x1 看成是隐变量 z, 它的处理过程可以和 VAE 中的一样.

consistency term

-

对于 Lt, 它的处理其实和 VAE 中的就非常类似了.

-

我们假设建模 p(xt−1|xt;θ) 为 N(xt−1;μθ(xt,t),σ2tI), 即方差和 q 的是一致的 (也有用学习的或者说插值的方法来玩的 [14]);

-

不加推导地给出

KL(N(x;μ,Σ)∥N(x;μ′,Σ′)=12[log|Σ′||Σ|−d+tr(Σ′−1Σ)+(μ′−μ)TΣ′−1(μ′−μ).](15)

-

故

Lt≈KL(q(xt−1|xt,x0)∥p(xt−1|xt;θ)⇔12σ2t∥μθ(xt,t)−μt(xt,x0)∥22,(16)

此处的等价是指我们移除了和 θ 无关的元素.

-

既然根据 (10) 可知:

μt(xt,x0)=√¯αt−1(1−αt)x0+√αt(1−¯αt−1)xt1−¯αt,(17)

且对于 μθ(xt,t), xt 也是可用的, 那么为了更好的用 μθ(xt,t) 逼近 (16), 我们完全可以令

μθ(xt,t)=√¯αt−1(1−αt)xθ(xt,t)+√αt(1−¯αt−1)xt1−¯αt,

然后直接用网络来得到 xθ(xt,t) 并去拟合 x0.

此时我们可以得到

Lt≈12σ2t¯αt−1(1−αt)2(1−¯αt)2[∥xθ(xt,t)−x0∥22].(18)

Consistency term 的不同理解

通过不同角度, 我们可以对不同版本 consistency term, 这有助于我们从不同的角度去理解 DPM.

Signal-to-noise ratio (SNR)

-

我们可以从信噪比 SNR [8] 去理解 consistency term.

-

我们来仔细看看 (17) 中的系数:

12σ2t¯αt−1(1−αt)2(1−¯αt)2=12(1−αt)(1−¯αt−1)1−¯αt¯αt−1(1−αt)2(1−¯αt)2←(10)=1−¯αt2(1−αt)(1−¯αt−1)¯αt−1(1−αt)2(1−¯αt)2=12¯αt−1(1−αt)(1−¯αt−1)(1−¯αt)=12¯αt−1(1−¯αt)−¯αt(1−¯αt−1)(1−¯αt−1)(1−¯αt)=12{¯αt−11−¯αt−1−¯αt1−¯αt}.(19)

-

注意到, q(xt|x0)⇔N(xt;√¯αx0,(1−¯αt)I), 所以根据信噪比的定义 (μ/σ 似乎更为常见):

SNR=μ2σ2.(20)

-

故实际上这个系数为

12(SNRt−1−SNRt),(21)

其中

SNRt=¯αt1−¯αt.

-

我们知道, 前向过程是一个加噪的过程, 所以 SNRt 是随着 t 递减的. 所以有的人就想 [8], 我们不要人为地给定 αt 了, 让我们也来学习它吧. 于是把 SNRt 构建成

SNR(t)=exp(−ωη(t))(22)

的形式了. 其中 ω(⋅) 是一个关于 t 单调递增的网络, η 是它的参数.

-

于是

¯αt=sigmoid(−ωη(t)),1−¯αt=sigmoid(ωη(t)).(23)

第二种

-

根据 (10):

μt(xt,x0)=√¯αt−1(1−αt)x0+√αt(1−¯αt−1)xt1−¯αt,(24)

以及

xt=√¯αx0+√1−¯αϵ⇒x0=xt−√1−¯αtϵ√¯α.(25)

-

故代入 (25) 到 (24) 中容易得到

μt(xt,x0)=1√αtxt−1−αt√1−¯αt√αtϵ.(26)

-

倘若反向过程我不是直接拟合 xθ(xt,t) 而是拟合 ϵθ(xt,t), 则 (17) 变成

Lt≈12σ2t(1−αt)2αt(1−¯αt)[∥ϵθ(xt,t)−ϵ∥22].(27)

-

其实这一种形态才是 DDPM 所推荐的形态, 而且似乎这种方式效果更佳.

采样

-

我们先来稍稍讲一下采样的事情.

-

既然

p(xt−1;xt;θ)⇔N(xt−1;μθ(xt,t),σ2tI).(28)

这里 μθ 可以是直接拟合, 也可以是通过 xθ 拟合, 也可以通过残差 ϵθ 拟合.

-

那么自然地

xt−1=μθ(xt,t)+σtz,z∼N(0,I),t=1,2,…T.(29)

-

具体地:

- 对于 (17):

μθ(xt,t)=√¯αt−1(1−αt)xθ(xt,t)+√αt(1−¯αt−1)xt1−¯αt;(29)

- 对于 (27):

μt(xt,t)=1√αtxt−1−αt√1−¯αt√αtϵθ(xt,t).(30)

-

其实还有一个问题, 就是我们必须循规蹈矩地按照前向地过程反向地来一遍吗? 其实是不用的, 甚至 t 都不一定需要精准匹配前向过程, 只是此时我们需要估计 αt (如果不是可学习的话), 可以通过插值等方法实现 [14].

Score Matching

在引出最后的 score-based DPM 前, 让我们首先了解 score matching [10].

我们可以用

p(x;θ)=1Zθe−fθ(x)(28)

来表示任意的分布? 其中 fθ(x) 通常被称为是 energy function, 鼎鼎大名的能量函数. 这种定义有什么好处呢, 首先我们定义 score function 为:

sθ(x):=∇xlogp(x;θ)=−∇xfθ(x).(29)

有了它, 结合 Langevin dynamics 就可以进行采样了 (实际上这是一步没有接受概率部分的 LMC 采样)

xt←xt−1+η2sθ(xt−1)+√ηz,z∼N(0,I),(30)

其中 η 表示采样的步长.

容易知道, N(μ,σ2I) 的 score function 为

μ−xσ2,(31)

取步长 η=2σ2, 可得

xt←μ+√2σz.(32)

这其实和 (29) 的形式就非常一致了.

-

既然 score function 这么有用, 甚至有了 score function 就和知道了分布没什么本质区别, 那么我们可以直接拟合它不就好了. 于是目标就成了

minθ12Ep(x)[∥sθ(x)−∇xlogp(x)∥22],(33)

-

但是我们不知道数据的分布 p(x) 自然也无法知道目标 ∇xp(x), score matching 实际上就是解决这个问题, 它证明 (33) 实际上等价于

minθEp(x)[tr(∇xsθ(x))+12∥sθ(x)∥22],(34)

此时我们就可以用蒙特卡洛采样来近似了.

-

Denosing Score Matching 是一种更加鲁棒的 score matching, 他认为在实际中我们采样得到的数据处在一个低维的流形中, 故当我们采用

minθ1NN∑i=1[tr(∇xisθ(xi))+12∥sθ(xi)∥22],(35)

来近似 (34) 的时候, 会导致 sθ(x) 在高密度的区域估计的比较好, 在低密度的区域估计的比较差. Denosing Score Matching 实际上是估计 qσ(~x)=∫dxqσ(~x|x)p(x), 它实际上等价于

minθ12Eqσ(~x|x)p(x)[∥sθ(~x)−∇~xlogqσ(~x|x)∥22].(36)

借此, 我们可以期待 sθ∗(~x) 接近 ∇~xlogqσ(~x). 特别地, 当 σ 足够小的时候, 所得的 sθ∗(x)≈∇xlogp(x).

Score-based Generative Models

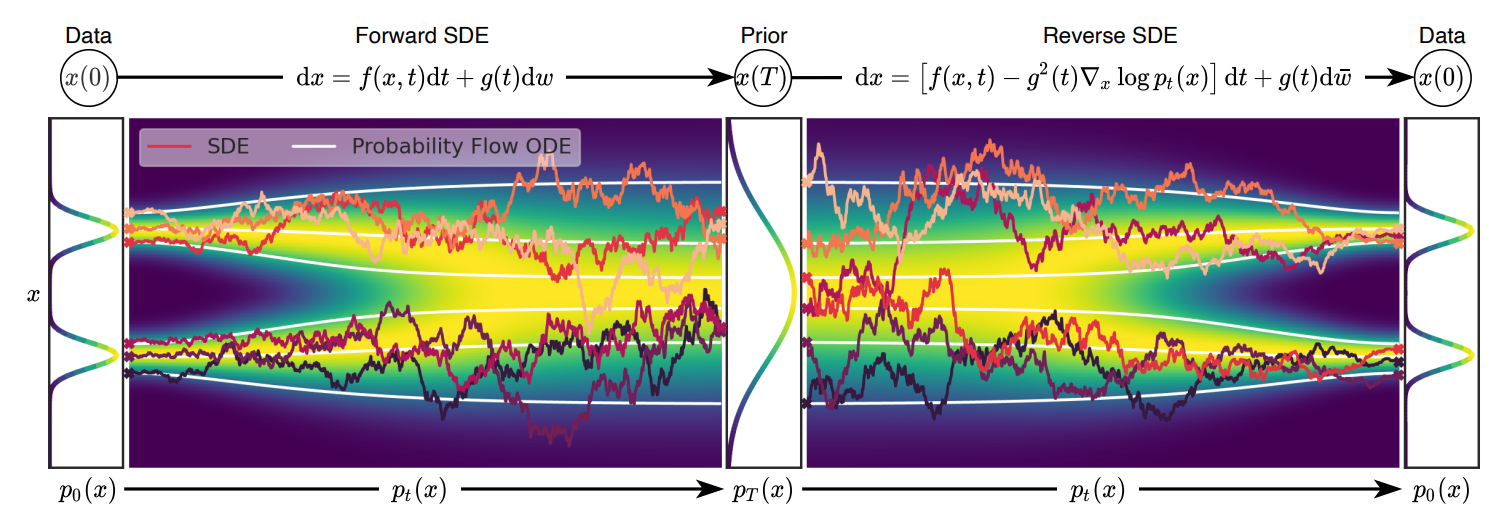

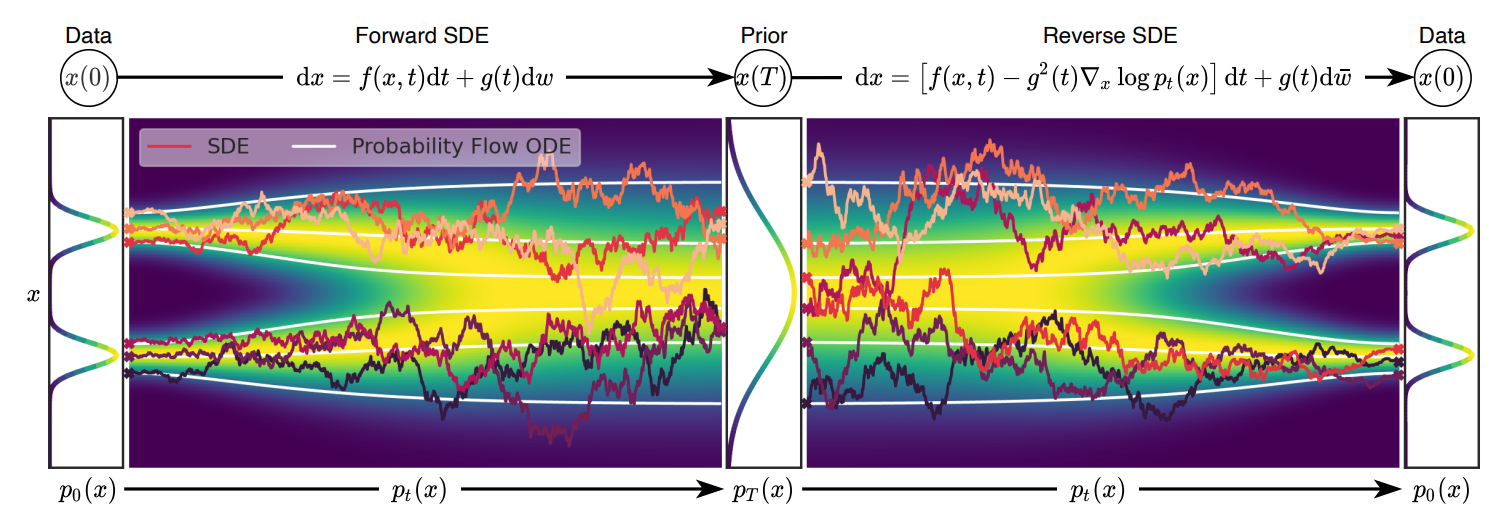

- 一种很有意思的观点是, 是把上述的离散的过程 k=0,1,…,K 抽象为一个连续的随机过程.

- 首先需要声明一点, 假设我们考虑连续时间段 [0,1], 然后我们从中采样了一些点 t0=0<t1<⋯<tK=1 (这也是为啥上面我用 k 而非 t 表示的原因, 以免大家混淆). 更具体地, 取 tk=kT.

- 现在, 我们将离散的过程连续化:

-

注意到 (DDPM 的前向扩散过程)

xk=√1−βkxk−1+√βkzk−1zk−1∼N(0,I).(38)

-

定义

β(t),t∈[0,1](39)

其满足

β(tk)=Tβk.(40)

-

则 (38) 可以改写为

xk=√1−βkxk−1+√βkzk−1zk−1∼N(0,I)⇒x(tk)−x(tk−1)=(√1−β(tk)/T−1)x(tk−1)+√β(tk)/Tz(tk−1)⇒x(tk)−x(tk−1)=(√1−β(tk)/T−1)x(tk−1)+√β(tk)/Tz(tk)← 独立同分布 ⇒x(t+Δt)−x(t)=(√1−β(t+Δt)Δt−1)x(t)+√β(t+Δt)Δtz(t)←Δt=1T⇒dx(t)=−12β(t)x(t)dt+√β(t)dw←Δt→0.(41)

这里 dw 特指 Wiener process 中的增量, 既满足:

- w(t+Δt)−w(t)∼N(0,ΔtI);

- w(t+Δt)−w(t)⊥⊥w(s),s<t

- limΔt→0w(t+Δt)=w(t).

-

令 e(t):=E(x(t)), 根据 (39) 可知

e(t+Δt)−e(t)=(√1−β(t+Δt)Δt−1)e(t)+0⇒de(t)=−1β(t)e(t)dt⇒e(t)=e0e−12∫t0β(τ)dτ←令e(0)=e0.(42)

故 x(t) 的条件期望为 e0e−12∫t0β(τ)dτ.

-

同理可得, x(t) 的(条件)协方差 (给定起始值 Σ(0)=Σt 为

dΣ(t)=β(t)(I−Σ(t))dt⇒Σ(t)=I+e−∫t0β(τ)dτ(Σ0−I).(43)

-

在 e(0)=μ0=x0,Σ(0)=Σ0=0 的情况下:

q(x(t)|x0)⇔N(x(t);x0e−12∫t0β(τ)dτ,I−e−∫t0β(τ)dτI),(44)

当 ∫t0β(τ)dτ→+∞ 的时候 (这实际上就是 DDPM 所设计的)

q(x(t)|x0)→N(x(t);0,I).(45)

通常, 这种方差不发散的情况成为 variance preserving, 其实还有 variance exploding 的情况, 比如 SMLD [5].

-

此外, 特别注意到, e−∫t0β(τ)dτ 和我们之前定义的 SNR(t)=e−ωη(t)是如此相似.

一般化

-

上述的过程, 实际上是将 DPM 的扩散过程和一个 SDE 联系起来了, [7] 中给出了一个更加一般化的形式:

dx(t)=ξ(x,t)dt+κ(x,t)dw(t),(46)

其中

ξ(⋅,t):Rd→Rd,(47)

代表均值的偏移程度,

κ(⋅,t):Rd→Rd×d

服务于 Wiener 过程.

-

自然地, 我们可以通过指定不同 ξ,κ 来获得不同的 DPMs (当然, 前提是你能够据此推导出条件分布 q(xt|x0), 这样才能运用 (50) 来求解).

-

现在的问题是, 前向扩散过程如此描述了, 那逆向的过程怎么办呢? 幸运的是, 我们可以显式地给出 (43) 的逆过程

dx(t)={ξ(x,t)−[∇x⋅[κ(x,t)κ(x,t)T]]1d−κ(x,t)κ(x,t)T∇xlogp(xt)}dt+κ(x,t)dw.(48)

-

倘若我们利用 sθ∗(xt,t) 比较好地估计了 ∇xlogp(xt), 那么我们就可以利用一些数值方法去近似 (46) 了, 比如 (这个有很多的, 详情可以参考 [7])

xt=xt+1−{ξ(xt+1)−[∇x⋅[κ(xt+1)κ(xt+1)T]]1d−κ(x,t)κ(xt+1)Tsθ∗(xt+1,t+1)}+κ(xt+1)zt+1.(49)

-

此时我们可以发现, 我们所要做的就是通过 sθ(xt,t) 来拟合 ∇xlogp(xt), 这实际上是 denosing score matching 做的事情. 即

minθEp(xt)[∥sθ(xt,t)−∇xlogp(xt)∥22]⇔minθEp(x0)q(xt|x0)[∥sθ(xt,t)−∇xlogq(xt|x0)∥22]⇔minθEp(x0)q(xt|x0)[∥sθ(xt,t)−x0−xtσ2t∥22].(50)

注: 这里的 σt 不是 (10) 中的, 是根据方程推导出来的条件分布 q(xt|x0), 此处我们取了一个条件分布恰好满足高斯分布的特例 (如 DDPM (42) 那样).

-

最后, 对于 score-based DPM 而言, 我们通常采用如下的损失

minθ∑tλtLt(θ),(51)

权重 λt 主要是用来平衡尺度的差异, 需要尽可能保持一致 [5].

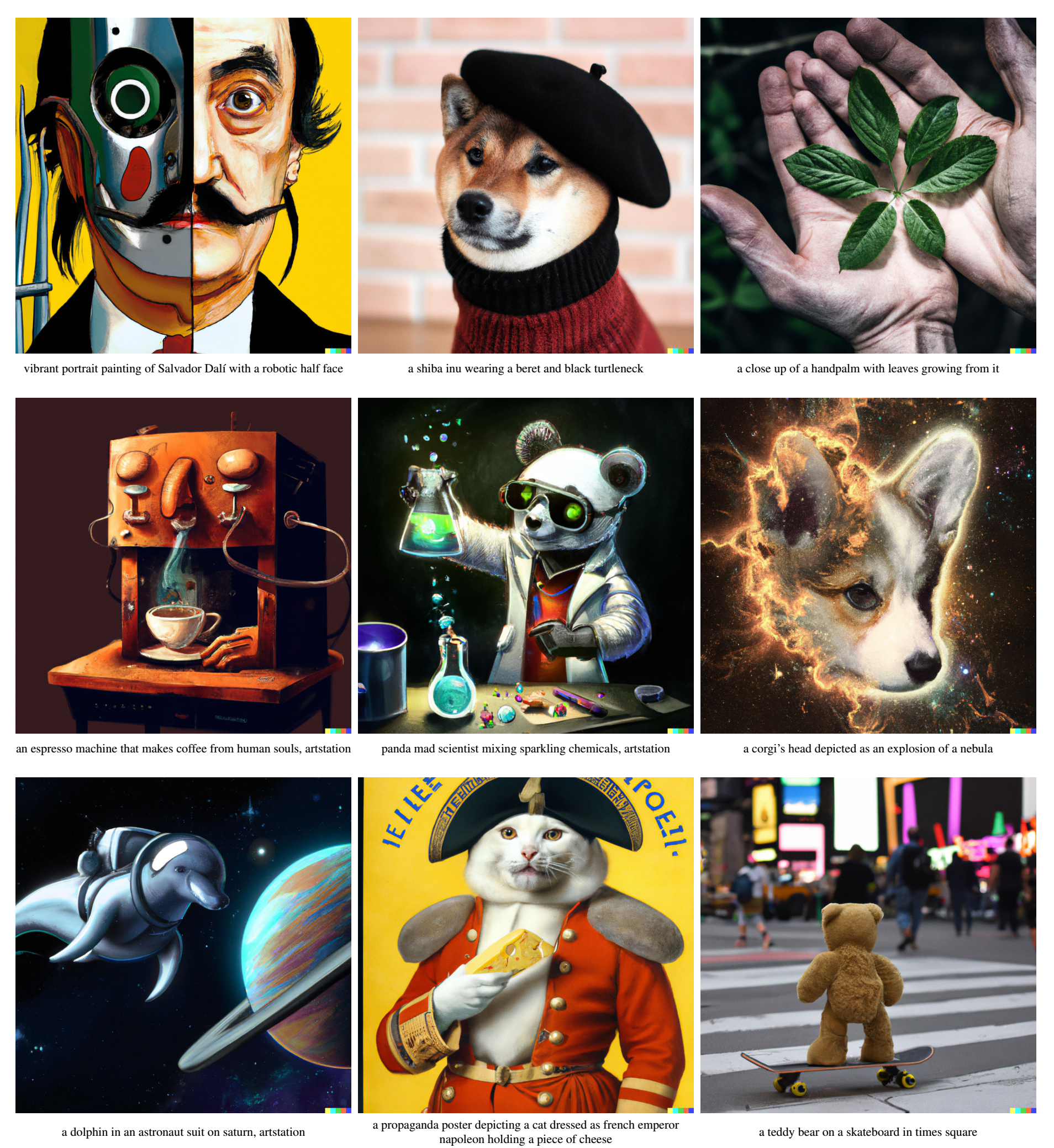

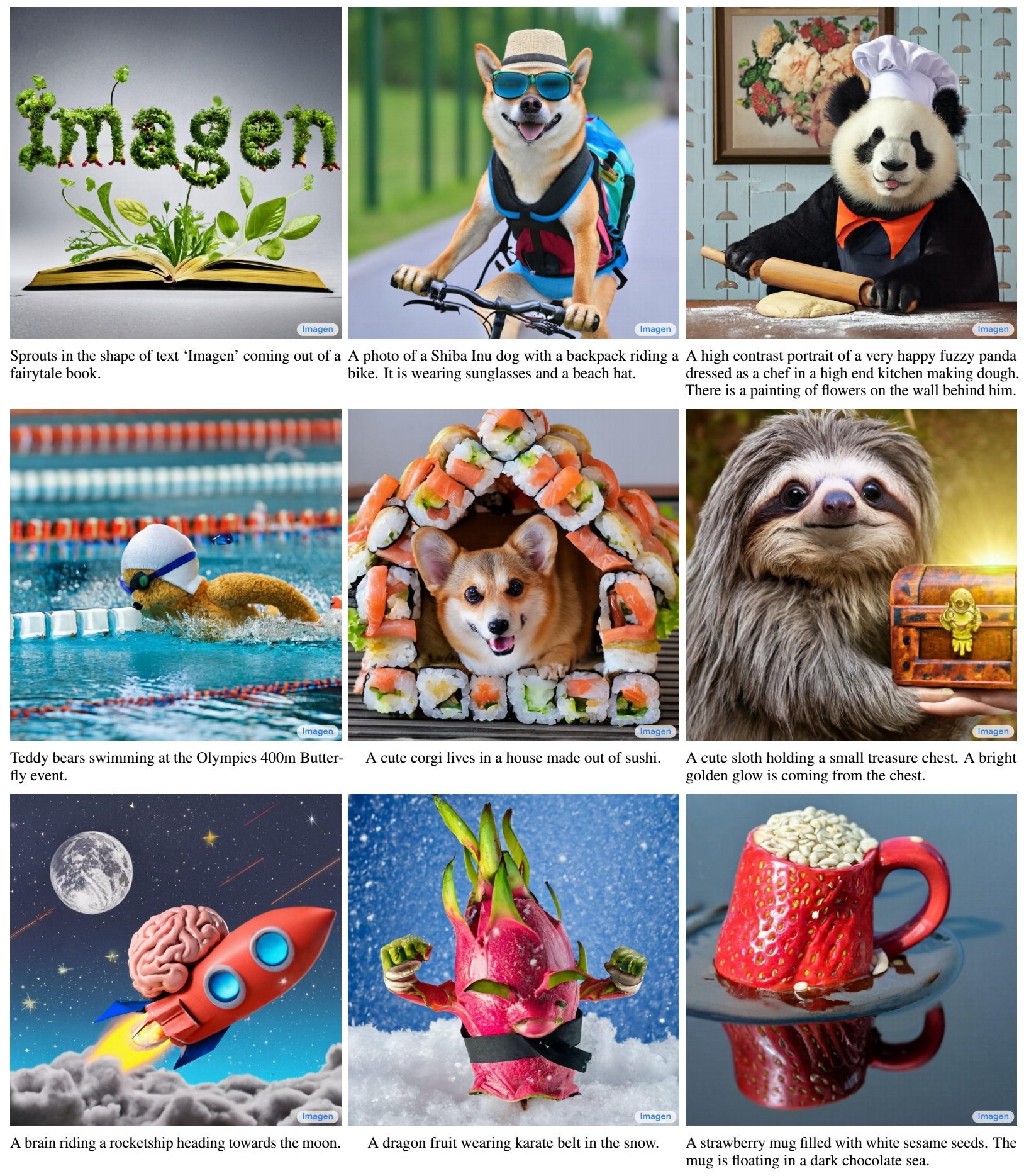

条件生成模型

-

很多时候, 我们需要构建条件概率模型 p(x|c) 并从中进行采样 [11, 12, 13, 14], 比如经典的 text-image [13];

-

一种直接的手段就是保持前向不变, 在后向的时候拟合条件概率分布:

p(x0:T|c)=p(xT)T∏t=1p(xt−1|xt,c;θ).(52)

对应不同的 DPMs, 就会需要拟合

μθ(xt,c,t),sθ(xt,c,t).(53)

-

比较困惑我的一个问题是, 为什么保持前向不变呢? 我是这般想的, 实际上我们应该采取如下的方案:

q(x0:T|c)=p(x0|c)T∏t=1q(xt|xt−1,c),(54)

但是因为前向扩散的过程导致 c→x0→xt−1→xt, 所以根据马氏性

q(xt|xt−1,c)=q(xt|xt−1).(55)

所以前向过程的参数的推导啥的是不需要变的.

Classifier Guidance

-

首先我们根据 score-based DPMs 来推导如何利用额外的分类器来条件采样 [7].

-

注意到

∇xtlogp(xt|y)=∇xtlogp(xt)p(y|xt))p(y)=∇xtlogp(xt) unconditional score +∇xtlogp(y|xt))adversarial gradient.(56)

第一部分可以通过之前的方法拟合, 第二部分可以训练一个分类器 (如果可以的话). 更一般地, 可以通过

∇xtlogp(xt) unconditional score +λ⋅∇xtlogp(y|xt))adversarial gradient.(57)

来控制多样性和准确性.

-

这种 Classifer Guidance 方法的好处就是, 我们可以在一个进行训练好的普通 DPM 上, 自己训练一个分类器, 然后引导采样即可.

-

不过这个分类器不同于一般的分类器, 它需要在 xt 这种被扰动的情况下也能正确估计 p(y|xt) 的能力, 这个可能不是那么容易做到的.

-

此外注意到, 这里我用了 y 而非向量 c, 因为后者的分类器就更加难以定义和衡量了.

Classifier-Free Guidance

-

很多时候 c|xt 的分类器很难构造 (特别是需要针对从清楚到模糊的所有样本), 此时我们可以再绕一步回到起始 [11, 12]

∇xtlogp(xt|c)←(1−λ)∇xtlogp(xt) unconditional score +λ∇xtlogp(xt|c))conditional score.(58)

如此一来, 避免了分类器的构造, 而且可以通过调节 λ 来平衡多样性和准确性.

-

此外, 我们不需要训练两个单独的 DPMs (一个条件的, 一个非条件的), 实际上我们只需要拟合

μθ(xt,c,t),(59)

并假设

μθ(xt,t)=μθ(xt,c=∅,t),(60)

即可.

总结

我们首先回顾了 VAE, 和基于 Flow 的 VAE, 由此更好地理解基于 VAE 的 DPM, 它的 consistency term 的不同变种可以帮助我们更好地理解 DPM. 最后, 我们又从 SDE 的角度连续化了 DPM, 通过了解前向的扩散过程和后面显式的逆过程, 构建不同的 DPM 只需要注意 ξ,κ 的设计即可. 整个 Score-based DPM 的核心就是 ∇xp(xt) 的拟合, 这用到了 Denosing Score Matching 的技巧.

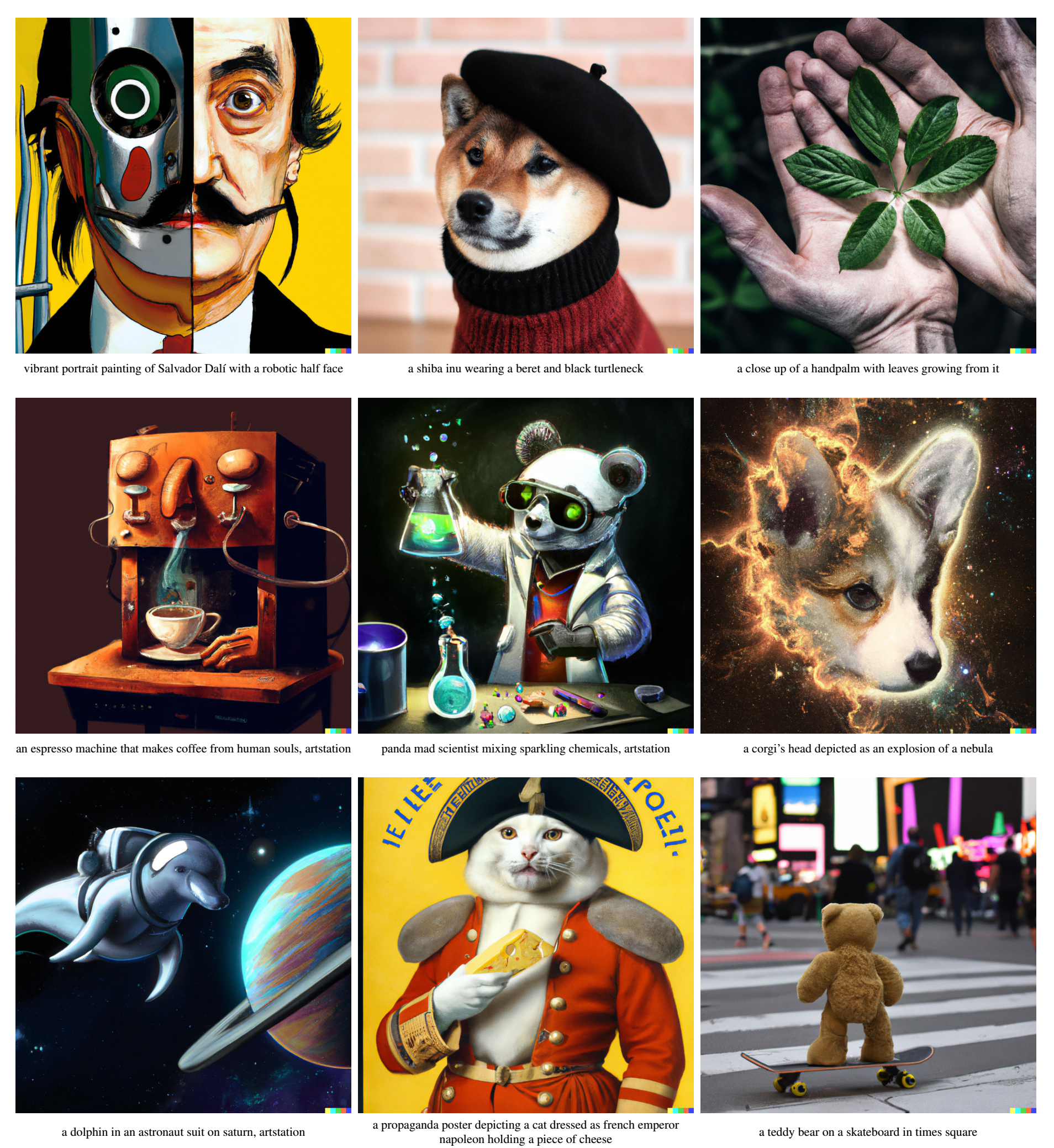

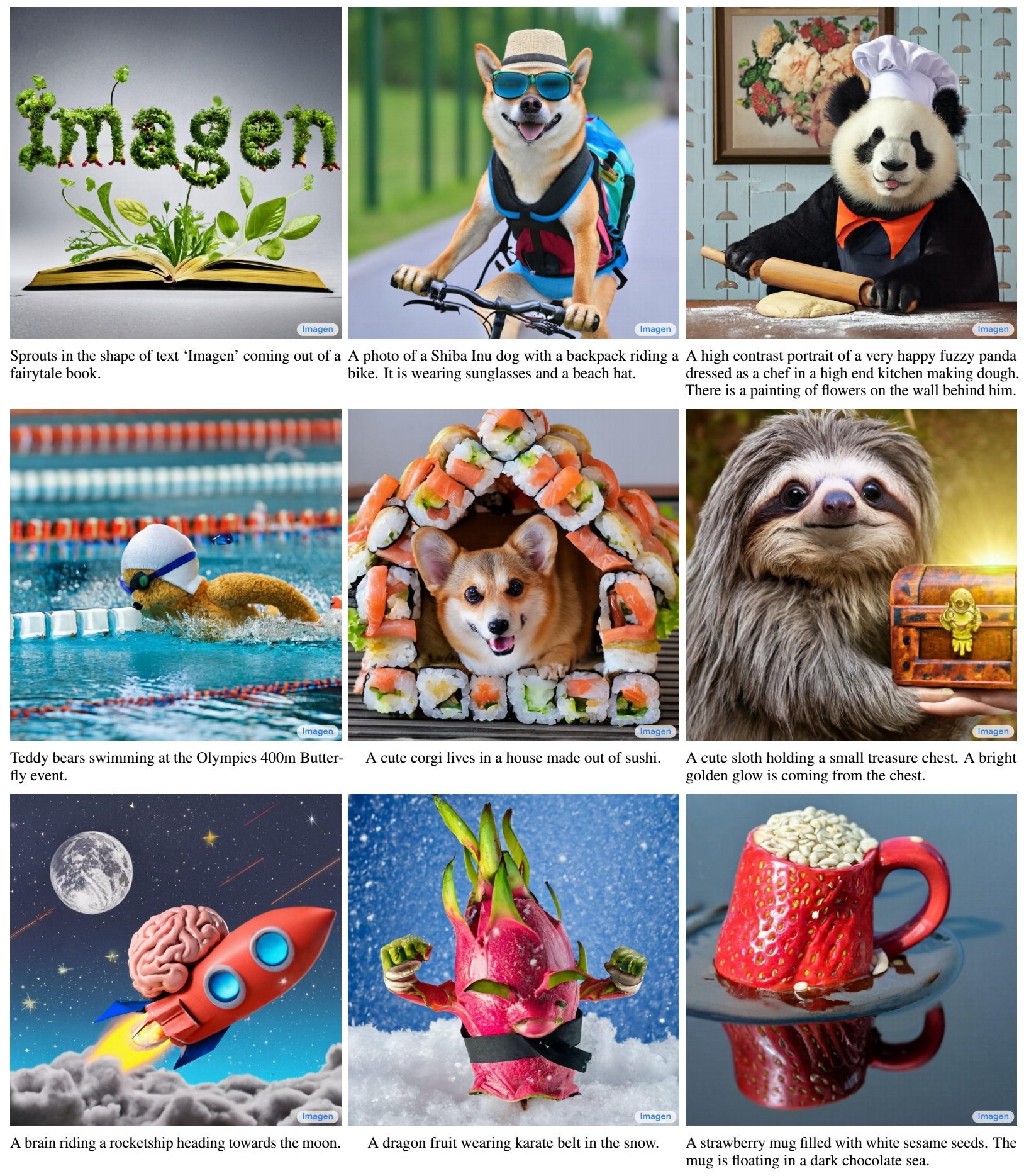

最后, 让我们领略一下 DPM 的魅力吧.

References

[1] Kingma D. P., Welling M. Auto-encoding variational bayes. International Conference on Learning Representations (ICLR), 2013.

[2] Rezende D., Mohamed S. Variational inference with normalizing flow. In International Conference on Machine Learning (ICML), 2015.

[3] Sohl-Dickstein J., Weiss E., Maheswaranathan N. and Ganguli S. Deep unsupervised learning using nonequilibrium thermodynamics. In International Conference on Machine Learning (ICML), 2015.

[4] Kingma D., Salimans T., Jozefowicz R., Chen X., Sutskever I. and Welling M. Improved variational inference with inverse autoregressive flow. In Advances in Neural Information Processing Systems (NIPS), 2016.

[5] Song Y. and Ermon S. Generative modeling by estimating gradients of the data distribution. In Advances in Neural Information Processing Systems (NIPS), 2019.

[6] Ho J., Jain A. and Abbeel P. Denoising diffusion probabilistic models. In Advances in Neural Information Processing Systems (NIPS), 2020.

[7] Song Y., Sohl-Dickstein J., Kingma D. P., Kumar A., Ermon S. and Poole B. Score-based generative modeling through stochastic differential equations. In International Conference on Learning Representations (ICLR), 2021

[8] Kingma D. P., Salimans T., Poole B., and Ho, J. Variational diffusion models. arXiv preprint arXiv:2107.00630, 2021.

[9] Luo C . Understanding diffusion models: a unified perspective. arXiv preprint arXiv:2208.11970, 2022.

[10] Hyv"{a}rinen A. Estimation of non-normalized statistical models by score matching. Journal of Machine Learning Research, 2005.

[11] Ho J. and Salimans T. Classifier-free diffusion guidance. In Advances in Neural Information Processing Systems (NIPS), 2021.

[12] Ho J., Saharia C., Chan W., Fleet D. J., Norouzi M. and Salimans T. Cascaded diffusion models for high fidelity image generation. arXiv preprint arXiv:2106.15282, 2021.

[13] Saharia C., Chan W., Saxena S., Li L., Wang J., Denton E., Ghasemipour S. K. S., Ayan B. K., Mahdavi S. S., Lopes R. G., Salimans T., Ho J., Fleet D. J. and Norouzi M. Photorealistic text-to-image diffusion models with deep language understanding. arXiv preprint arXiv:2205.11487, 2022.

[14] Nichol A. and Dhariwal P. Improved denoising diffusion probabilistic models. arXiv preprint arXiv:2102.09672, 2021.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix