Zhu M., Wang X., Shi C., Ji H. and Cui P. Interpreting and unifying graph neural networks with an optimization framework. In International World Wide Web Conference (WWW), 2021.

概

将 GNN 和 优化联系起来, 并提出了一个统一框架.

符号说明

- G=(V,E), 图;

- n=|V|;

- X∈Rn×f, features;

- A, 邻接矩阵;

- D, degree matrix;

- ~A=A+I,~D=D+I;

- ^~A=~D−1/2~A~D−1/2;

- ~L=I−^~A, normalized Laplacian.

统一的框架

-

大部分 GNN 的遵循如下的形式:

Z=PROPAGATE(X;G;K)=⟨Trans(Agg{G,Z(k−1)})⟩K,

其中:

Z(0)=X,

Agg(⋅) 代表 feature aggregation 过程, Trans(⋅) 代表 feature transformation 过程 (通过激活函数和可学习的参数 W), 而 ⟨⟩K 则是最后将不同层的输出耦合起来的一种方式, 最后得到输出特征 Z.

-

实际上, 这些 GNN 的目的无非是:

O=minZ{ζ∥F1Z−F1H∥2FOfit+ξtr(ZT~LZ)Oreg}.

即:

1. 通过 Ofit 和不同的 graph convolutional kernels F1,F2 从信号 H 中提取有用的信息;

2. 该信息需要满足约束条件 Oreg.

-

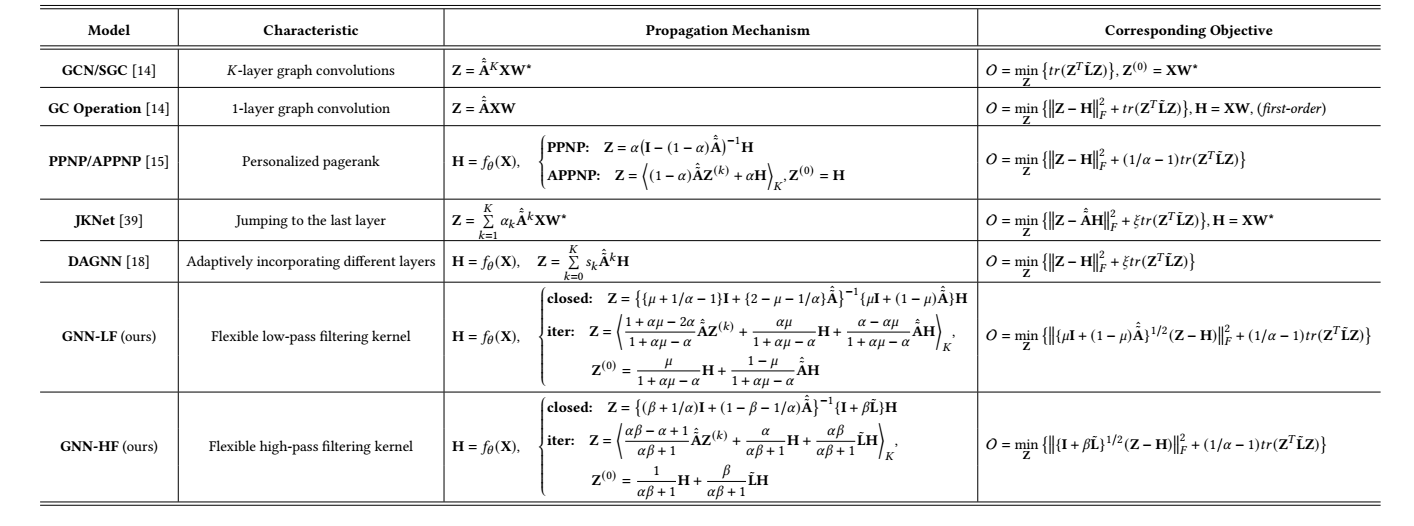

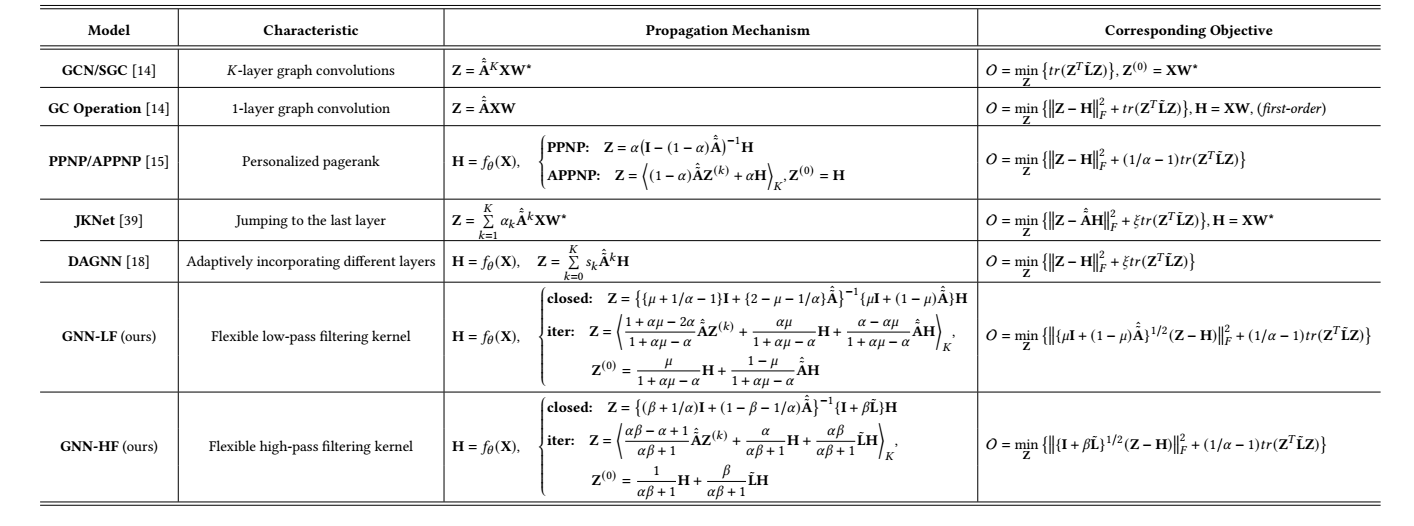

下面是作者总结的不同的 GNN 方法的对应结果:

Graph-LF/HF

-

作者认为 H 不可避免地包含噪声和不确定的信息, 所以希望人为设计低频, 高频 filters 来提取低频和高频信息:

-

为了提取低频信息, 作者令

F1=F2=(μI+(1−μ)^~A)−1/2,μ∈[1/2,1]

注: I 囊括全部信息, 而 ^~A 强调低频信息. 此外令

ζ=1,ξ=1/α−1,α∈(0,2/3)

以保证能用迭代逼近:

Z(k+1)=1+αμ−2α1+αμ−α^~AZ(k)+αμ1+αμ−αH+α−αμ1+αμ−α^~AH.

-

为了提取高频信息, 作者令

F1=F2=(I+β~L)−1/2,β∈(0,+∞).

这里 ~L 抓住高频信息. 此外令

ζ=1,ξ=1/α−1,α∈(0,1].

可以通过如下方式迭代逼近:

Z(k+1)=αβ−α+1αβ+1^~AZ(k)+α1+αβH+αβ1+αβ~LH.

-

这里 H=fθ(X), 是在原始特征的基础上通过 MLP fθ(⋅) 得到的非线性变换.

注: 作者是先给出显式解再给出迭代解的, 具体请回看论文.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2019-10-18 On the Optimization of Deep Networks: Implicit Acceleration by Overparameterization