Ding S., Wu P., Feng F., Wang Y., He X., Liao Y. and Zhang Y. Addressing unmeasured confounder for recommendation with sensitivity analysis. In ACM SIGKDD Conference on Knowledge Discovery and Data Mining (KDD), 2022

概

以往的鲁棒的 estimator 在存在 unmeasured confounder 的时候会导致 counfounding bias, 本文通过给定 bound 下的对抗训练来解决这一问题.

符号说明

- U, users;

- I, items;

- D=U×I, user-item pairs;

- xu,i, user-item feature;

- ou,i∈{0,1}, 1 表示 i 曝光给 u;

- ru,i, rating;

- O={(u,i)|(u,i)∈D,ou,i=1};

问题

-

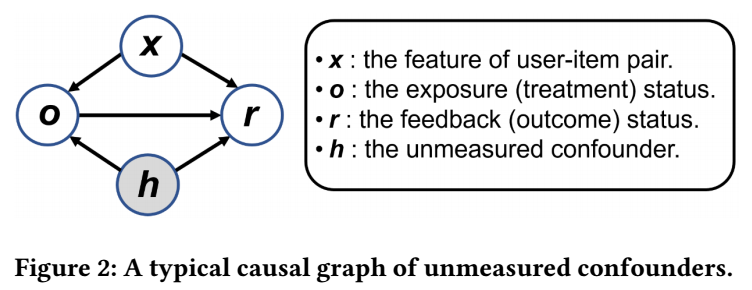

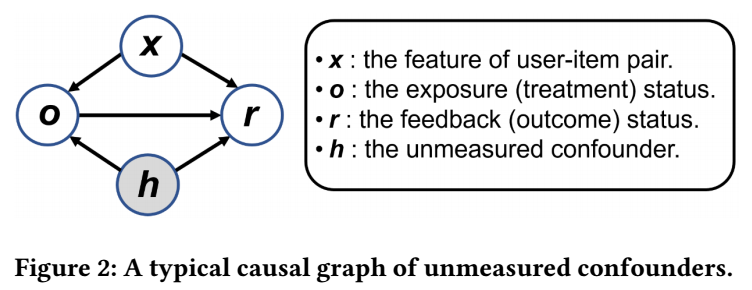

假设 o,x,y,h 满足上面的因果图, 其中 h 是一些无法观测的变量;

-

设想, 我们希望通过一个模型 fϕ(⋅) 来估计 r. 我们模拟的是这样的一个流程:

- 将 item i 曝光给 user u, 即 do(ou,i=1);

- 获得一个指标 ru,i(1):=ru,i|do(ou,i=1;

-

那么自然地, 我们希望 ^ru,i(1)=fϕ(xu,i) 能够逼近真实地 ru,i(1):

minϕLideal(ϕ)=1|D|∑(u,i)∈Deu,i,

其中

eu,i:=(^ru,i(1)−ru,i(1))2;

-

但是, 由于只有部分 O 曝光, 故实际上我们只能优化:

Lreal(ϕ)=1|O|∑(u,i)∈Oeu,i;

-

倘若, 我们能够知道确切的 propensity score:

~pu,i=P(ou,i=1|xu,i,hu,i),

则可以通过

LIPS(ϕ)=1|D|∑(u,i)∈Dou,ieu,i~pu,i

来优化, 注意到该式关于 o 的期望:

E[LIPS]=Ex,hEo,r(1)[ou,ieu,i]~pu,i=Ex,hEo[ou,i]Er(1)[eu,i]~pu,i←r(1)⊥⊥o|x,h=Ex,h~pu,iEr(1)[eu,i]~pu,i=Ex,h,r(1)[eu,i]=E[Lideal].

故这说明该估计量是无偏的.

-

但是由于 h 是不可观测的, 故 ~pu,i 也是难以估计的; 而之前的方法, 多半假设因果图中不存在无法观测的变量, 并用

^pu,i=P(ou,i=1|xu,i),

来替代 ~pu,i. 虽然颇有成效, 但在理论上, 该估计量是有偏的, 因为

r(1)/⊥⊥o|x,

故之前的推导就失效了.

本文方法

-

假设我们用逻辑斯蒂回归去拟合 ^p, 即

^pu,i=P(ou,i=1|xu,i)=exp(m(xu,i))1+exp(m(xu,i)),

其中 m(⋅) 是任意的函数;

-

类似地, 用加性模型

~pu,i=P(ou,i=1|xu,i,hu,i)=exp(m(xu,i)+φ(hu,i))1+exp(m(xu,i)+φ(hu,i)),

拟合真实的 propensity score;

-

|m(x)+φ(h)| 的大小和能量有关, 作者假设没观测到 confounders 的能量是有限的, 被控制在 |φ(h)|≤logΓ,Γ≥1, 若 Γ=1, 这意味着不辞你在 confounders;

-

此时

1Γ≤(1−^p)~p^p(1−~p)=exp(φ(h))≤Γ,

于是

au,i≤~wu,i:=1~pu,i≤bu,i,au,i=1+(1/^pu,i−1)/Γ,bu,i=1+(1/^pu,i−1)Γ

-

到此, 我们知道到了 ~wu,i 的和 ~pu,i 无关的一个上下界, 我们可以从上下界范围内采样合适的点来帮助训练, 作者采取的是对抗训练的思路, 每次采样最恶劣的点:

minϕLRD−IPS(ϕ)=maxW∈W1|D|∑(u,i)∈Dou,ieu,iwu,i,(12)

其中

W:={W∈R|D|+:au,i≤wu,i≤bu,i}

wu,i 为 W 的元素;

-

可以期待, 这种方式使得训练更加鲁棒.

Q: 似乎 (12) 中仅仅取到了上界 ?

注: 作者还提出了一个 BRD (Benchmarked RD Framework) 的版本:

LBRDIPS(ϕ)=maxW∈W1|D|∑u,iou,i(eu,i(ϕ)−eu,i(^ϕ(0)))wu,i,

其中 eu,i(^ϕ(0)) 是已有的一个方法的估计结果. 其实细想, 注意到

eu,i(ϕ)>eu,i(^ϕ)

的时候, wu,i 取 bu,i, 即因为这部分和 baseline 的结果差的还比较远, 所以加强了权重, 而当

eu,i(ϕ)<eu,i(^ϕ)

之后, wu,i 取了 au,i, 即因为在 u,i pair 上的表现已经比 baseline 更好了, 所以继续好下去可能反而容易造成过拟合之类的, 所以就加了一个小的权重. 话说这个技术应该有别的论文给出吧.

注: 与其它方法的结合这里就不提了.

代码

[official]

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2020-08-19 Inverse/Implicit Function Theorem