Exploring Architectural Ingredients of Adversarially Robust Deep Neural Networks

概

本文是对现有的残差网络结构的探索, grid search一个鲁棒的结构.

主要内容

大家普遍认为越大的模型鲁棒性能会越好, 某种程度上如此, 但是现有的WRN(Wide ResNet)是为干净精度设计的, 对于鲁棒性并不是最优的.

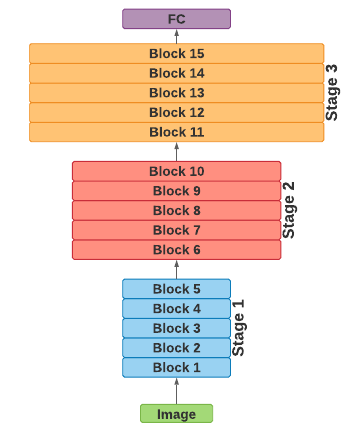

现在的WRN有三个stage:

其越到后面越宽(即卷积核个数越多).

比如标准的WRN-34-10, 每个stage有5个block, 均乘上了factor=10.

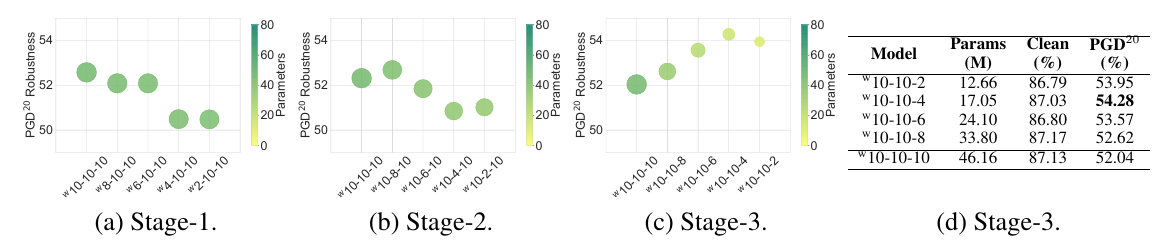

本文便是探究block数量(即网络深度), 以及factor(即宽度)的影响.

深度

由上图可知, 削弱最后一个stage能够有效提升鲁棒性.

宽度

同样的, 削弱最后一个stage能够有效提升鲁棒性.

结合二者, 作者发现, 宽度比深度更有效, 维持10-10-4的比例的模型是最优的.

若进一步改为20-20-8(同比例scale), 鲁棒性接近饱和.

感觉给人的启示是, 最后一stage不能有太强的表达能力, 为什么?

我感觉还是残差连接的原因啊.

浙公网安备 33010602011771号

浙公网安备 33010602011771号