Radford A., Narasimhan K., Salimans T. and Sutskever I. Improving language understanding by generative pre-training. 2018.

Devlin J., Chang M., Lee K. and Toutanova K. BERT: Pre-training of deep bidirectional transformers for language understanding. In Conference the North American Chapter of the Association for Computational Linguistics Human Language Technologies (NAACL-HLT), 2019.

概

两个经典的NLP的预训练模型.

主要内容

GPT

就是普通的transformer, 注意的是tokens之间的联系方式是auto-regressive的:

P(xi|xi−k,⋯,xi−1;θ).

即每个token仅与之前的tokens有关.

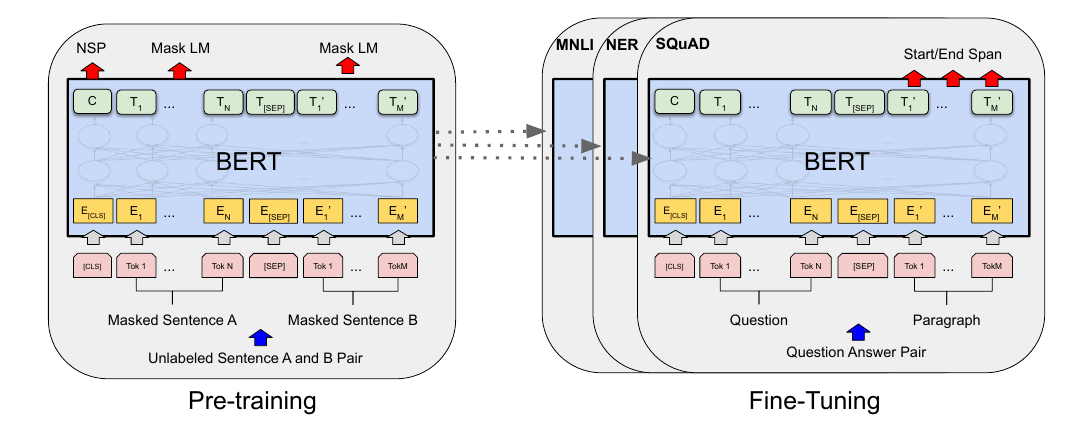

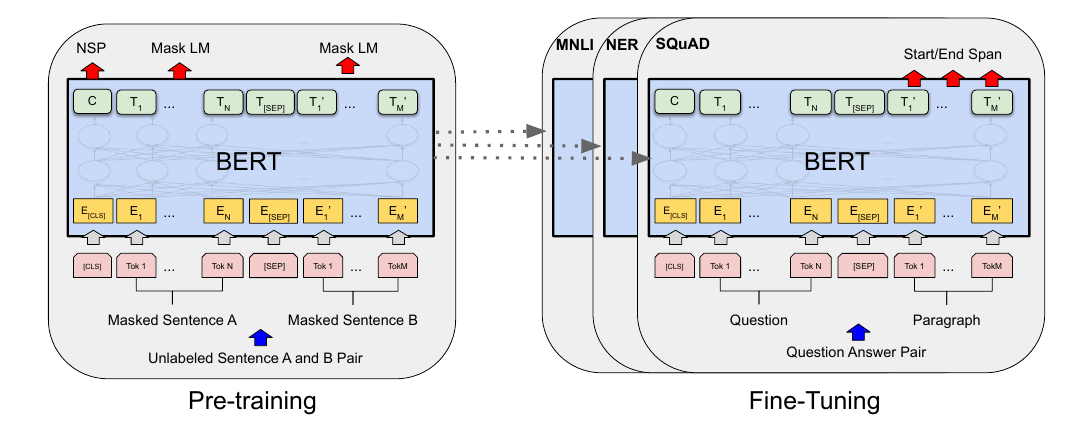

BERT

与GPT最为不同的是, BERT并非是auto-regressive的, 即其认为一个词可以通过上下文关联起来:

P(xi|X),

在实际中, BERT对部分的词mask掉, 相当于用别的词来推断:

P(xi|xj,∉M).

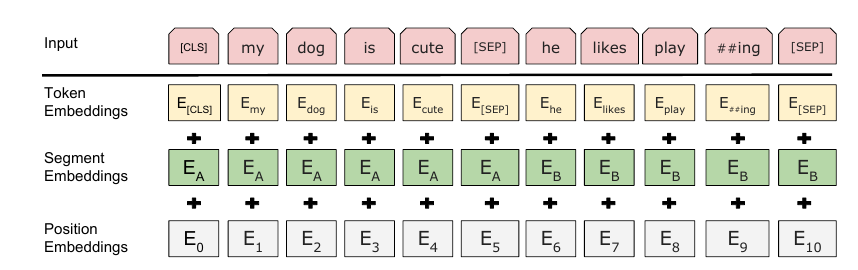

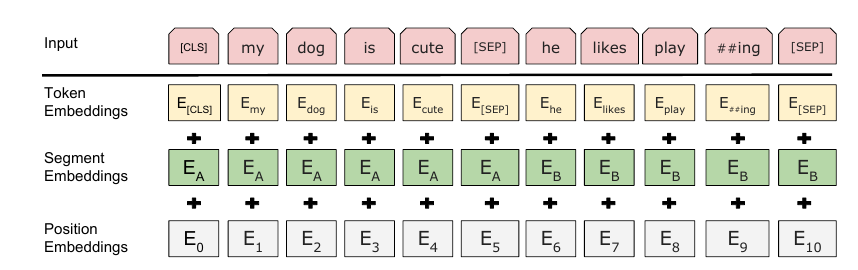

切除了普通的positional embeddings, 额外增加了segment embeddings, 用来标记不同的句子. 这么设计是认为很多下游任务都能通过两个部分的结构来表示.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

2019-06-20 Proximal Algorithms 7 Examples and Applications