Uncovering the Limits of Adversarial Training against Norm-Bounded Adversarial Examples

Uncovering the Limits of Adversarial Training against Norm-Bounded Adversarial Examples

概

暴力美学, 通过调参探索adversarial training的极限.

主要内容

实验设置

模型主要包括WRN-28-10, WRN-34-10, WRN-34-20, WRN-70-16;

优化器为SGD(nesterov momentum), 1/2, 3/4 epochs处 lr /= 10, weight decay 5e-4;

对抗训练用的是PGD-10, 步长为2/255\(\ell_{\infty}\)和15/255\(\ell_{2}\).

损失的影响

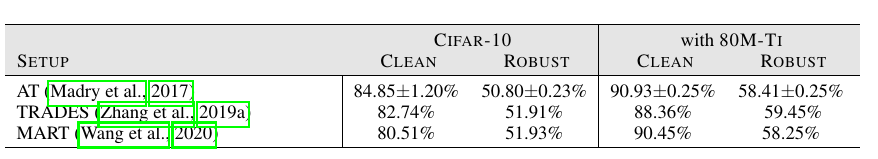

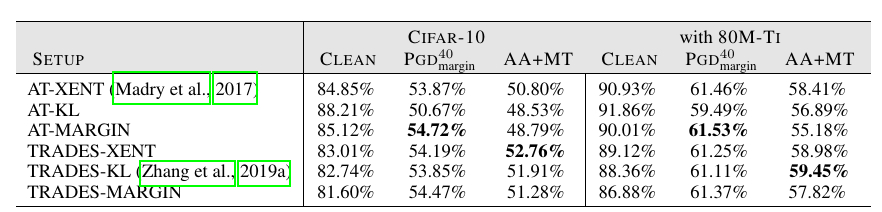

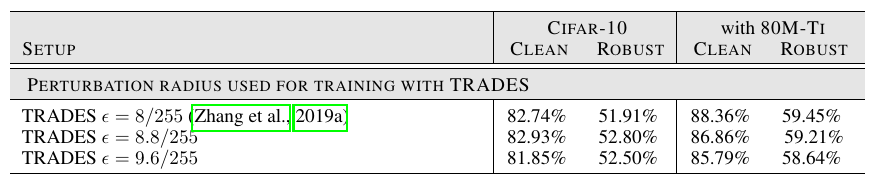

实际上就是比较不同方法的区别(包括外循环的损失和内循环构造对抗样本的损失, TRADES稍优):

额外的数据

有很多方法用了无标签数据作为额外的数据来进行训练并取得了很好的效果.

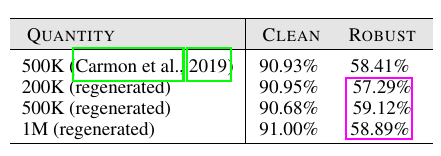

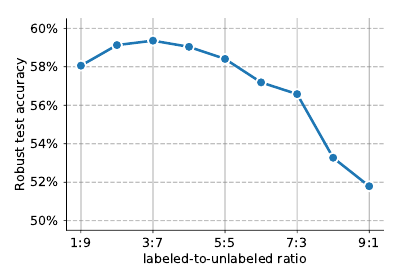

上表作者比较的是无标签数据的量, 显示过多的数据并不能一直增加鲁棒性.

上图关注的是有标签数据和无标签数据之前的比例关系, 显然无标签数据似乎更能带来鲁棒性(这与无监督训练更具鲁棒性是一致的).

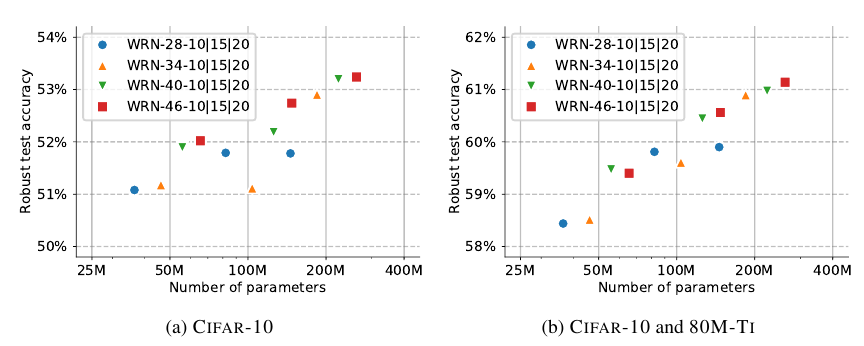

网络结构

从上图可知, 网络越大鲁棒性越好.

其他的一些tricks

-

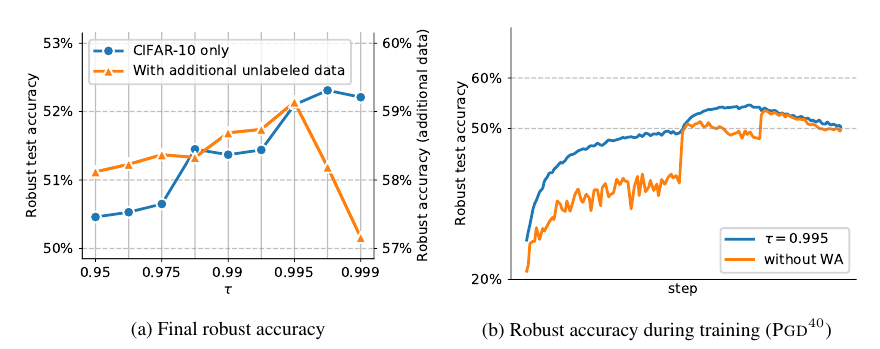

Model Weight Averaging: 作者发现这个对提高鲁棒性很有帮助, 且这方面缺乏研究

-

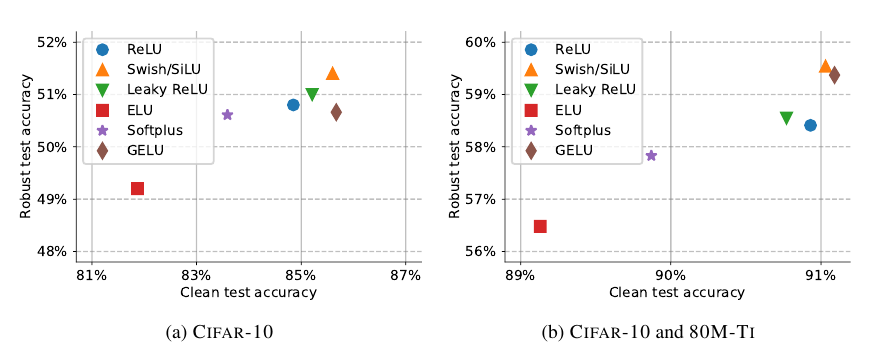

激活函数: Swish/SiLu表现不错, 整体相差不大.

-

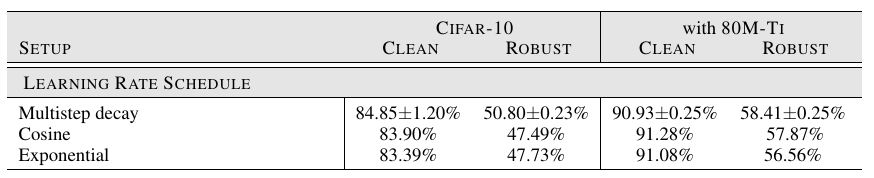

Learning Rate Schedule: 常用的multistep decay表现最好.

-

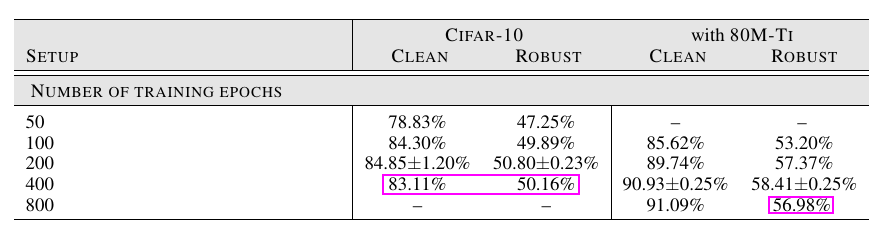

训练次数: 并非越大越好, 实际上已经有最新工作指出对抗训练存在严重的过拟合.

-

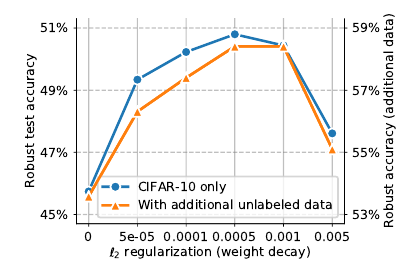

正则化(weight decay): \(\ell_2\)正则化, 即weight decay在对抗训练中有重要作用.

-

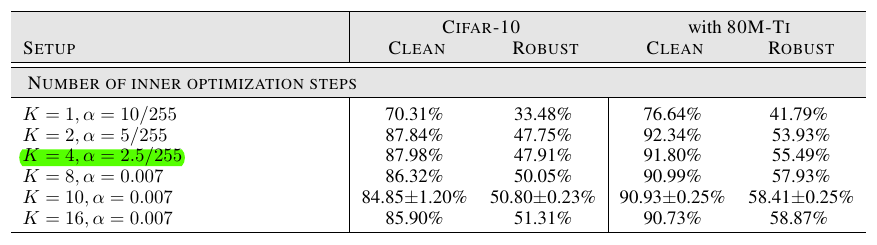

构造对抗样本所需的steps: 步数越多鲁棒性越好, 但是这是一个trade-off, 伴随着干净数据集的正确率下降

-

构造对抗样本的epsilon: 有类似上面的结论, 太大了二者都会下降.

-

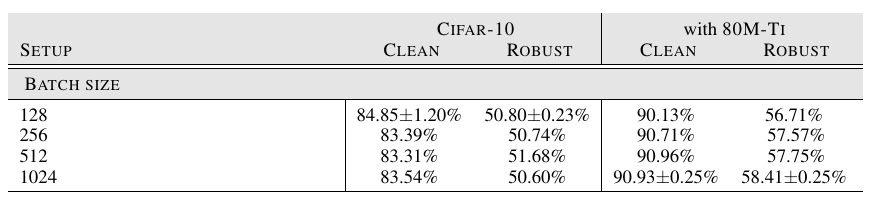

Batch Size: 同样并非越大越好.

-

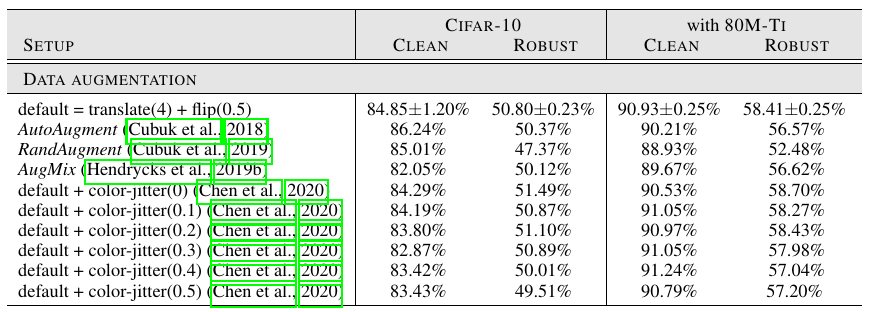

Augmentation: 似乎对于对抗训练意义不大, 但是个人在实验中发现这对防止过拟合有一定效果.

-

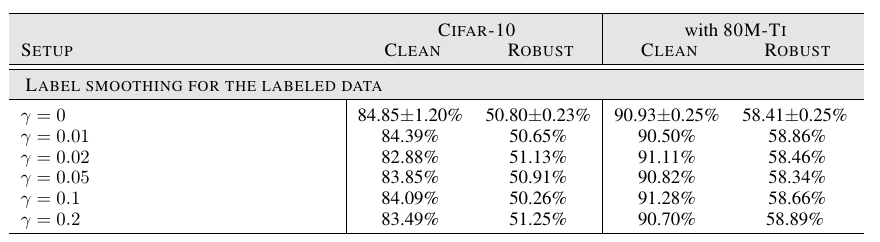

Label Smoothing: 几乎没影响