ZFNet: Visualizing and Understanding Convolutional Networks

ZFnet的创新点主要是在信号的“恢复”上面,什么样的输入会导致类似的输出,通过这个我们可以了解神经元对输入的敏感程度,比如这个神经元对图片的某一个位置很敏感,就像人的鼻子对气味敏感,于是我们也可以借此来探究这个网络各层次的功能,也能帮助我们改进网络。

论文结构

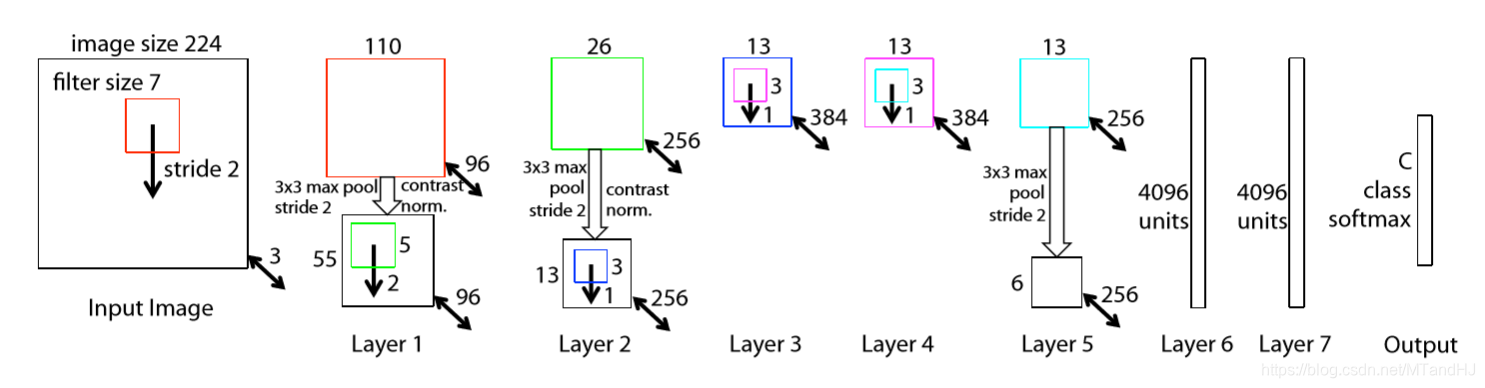

- input: , filter size: 7, filter count: 96, stride: 2, padding: 1, 我觉得是要补一层零的,否则输出是109而不是110-->ReLU --> maxpool: size: , stride: 2, 似乎这里也要补一层零, 否则 --> contrast normalized;

- input: , filter size: 5, count: 256, stride: 2, padding: 0 --> ReLU --> maxpool: size: , stride: 2, padding: 1--> contrast normlized;

- input: , filter size: 3, count: 384, stride: 1, padding: 1 --> ReLU

- input: , filter size: 3, count: 384, stride: 1, padding: 1 --> ReLU

- input: , filter size: 3, count: 256, stride: 1, padding: 1 --> ReLU --> maxpool: size: 3, stride: 2, padding: 0 --> contrast normlized?

- input: -- > 4096 -- > ReLU -- > Dropout(0.5)

- input: 4096 -- > 4096 --> ReLU -- > Dropout(0.5)

- input: 4096 --> numclass ...

反卷积

网上看了很多人关于反卷积的解释,但是还是云里雾里的.

先关于步长为1的,不补零的简单情况进行分析吧, 假设:

input: ,

kernel_size: ,

stride: 1,

padding: 0

此时输出的大小应当满足:

现在,反卷积核大小依旧为, 那么我们需要补零为多少才能使得反回去的特征大小为.

即:

即我们要补零.

如果stride 不为1呢?设为, 那么:

按照别的博客的说话,需要在特征之间插入零那么:

如果我们希望(至于为什么希望我不清楚):

如果还有补零:

但是回去的时候我们是不希望那个啥补零的,所以:

不变,

如果, 结果为:

最大的问题是什么,是why! 为什么要这样反卷积啊?

分类:

Neural Networks

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 三行代码完成国际化适配,妙~啊~

· .NET Core 中如何实现缓存的预热?