本节介绍一些例子.

LASSO

考虑如下问题:

min(1/2)∥Ax−b∥22+γ∥x∥1,

其中x∈Rn,A∈Rm×n.

proximal gradient method

proximal gradient method 是:

xk+1:=proxλg(xk−λ∇f(xk))

令f(x)=(1/2)∥Ax−b∥22,g(x)=γ∥x∥1, 则

∇f(x)=AT(Ax−b),proxγg(x)=Sγ(x),

其中Sγ(x)是soft-thresholding.

ADMM

很自然的方法,不提了.

矩阵分解

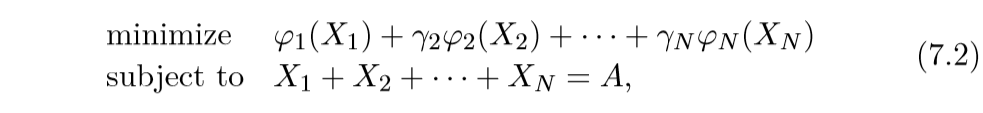

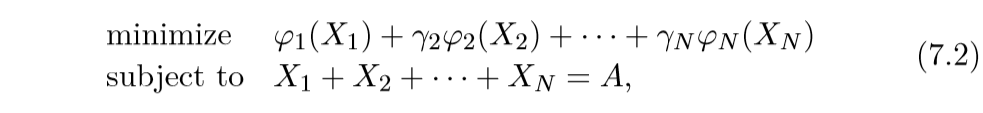

一般的矩阵分解问题如下:

其中X1,…,XN∈Rm×n为变量,而A∈Rm×n为数据矩阵.

不同的惩罚项φ会带来不同的效果.

- φ(X)=∥X∥2F, 这时,矩阵元素往往都比较接近且小

- φ(X)=∥X∥1, 这会导致稀疏化

- φ(X)=∑j∥xj∥2, 其中xj是X的第j列, 这会导致列稀疏?

其他的看文章吧.

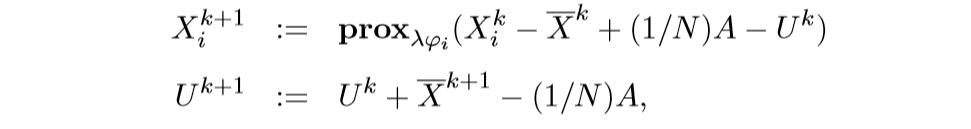

ADMM算法

令

f(x)=N∑i=1φi(Xi),g(X)=IC(X),

其中X=(X1,…,XN), 并且:

C={(X1,…,XN|X1+…+XN=A}.

根据之前的分析,容易知道:

ΠC=(X1,…,XN)−¯X+(1/N)A,

其中¯X是X1,…,XN的各元素的平均.

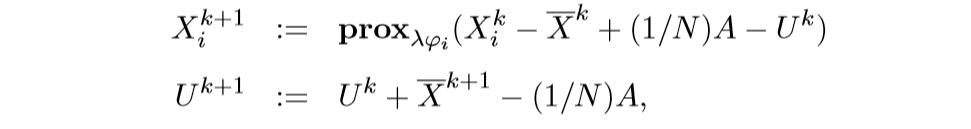

最后算法总结为:

多时期股票交易

其问题是:

minT∑t=1ft(xt)+T∑t=1gt(xt−xt−1),

其中xt,t=1,…,T表示第t个时期所保持的股份,期权,而ft则表示对应的风险,gt表示第t个时期交易所需要耗费的资源.

考虑如下分割:

f(X)=T∑t=1ft(xt),g(X)=T∑t=1gt(xt−xt−1),

其中X=[x1,…,xT]∈Rn×T.

随机最优

为如下问题:

minK∑k=1πkf(k)(x),

其中π∈RK+是一个概率分布,满足1Tπ=1.

利用第5节的知识,将此问题化为:

minK∑k=1πkf(k)(x(k))s.t.x(1)=…=x(K).

再利用ADMM就可以了.

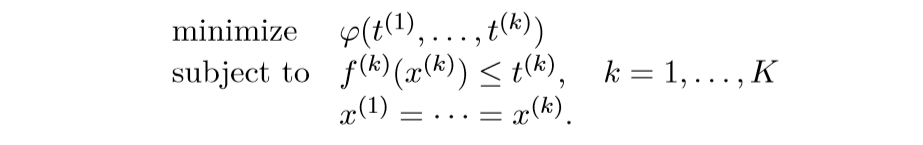

Robust and risk-averse optimization

鲁棒最优,特别的, 最小化最大风险:

minmaxk=1,…,Kf(k)(x).

更一般的:

minφ(f(1),…,f(K)(x)),

其中φ为非降凸函数.

method

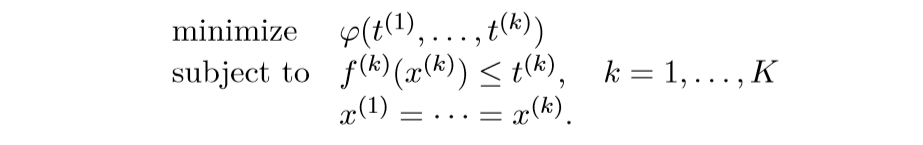

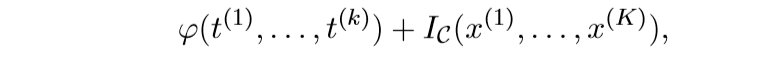

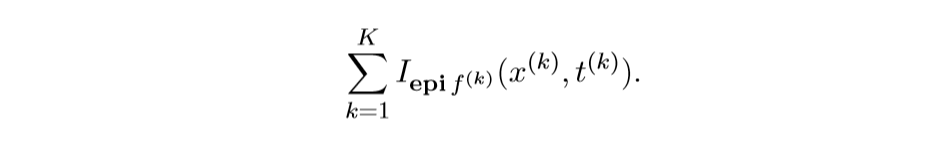

将上面的问题转化为:

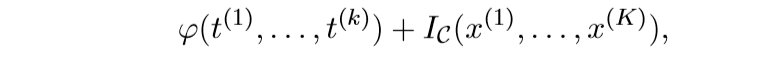

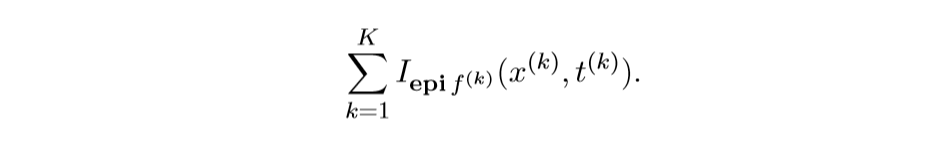

将

视作f

而

作为g,再利用ADMM求解即可.

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· Manus重磅发布:全球首款通用AI代理技术深度解析与实战指南

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· 【自荐】一款简洁、开源的在线白板工具 Drawnix