Hadoop综合大作业

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

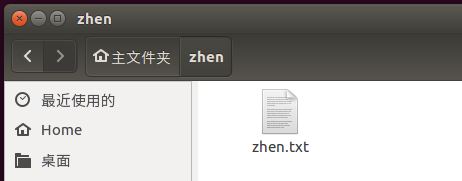

将英语长篇小说的文本文件下载并放于虚拟机 /home/hadoop/zhen 目录下:

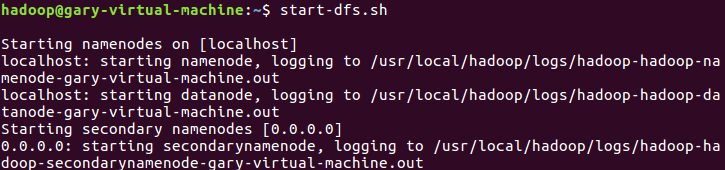

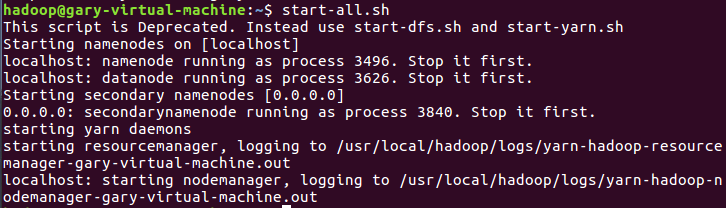

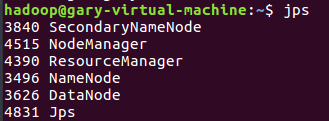

启动hadoop:

上传到hdfs/data文件中:

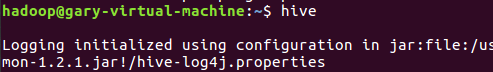

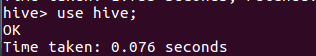

启动Hive

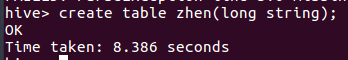

在hive数据库创建表 zhen:

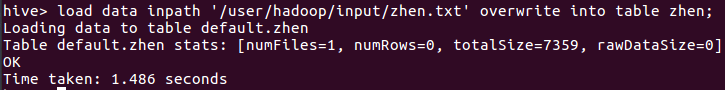

导入文本zhen.txt:

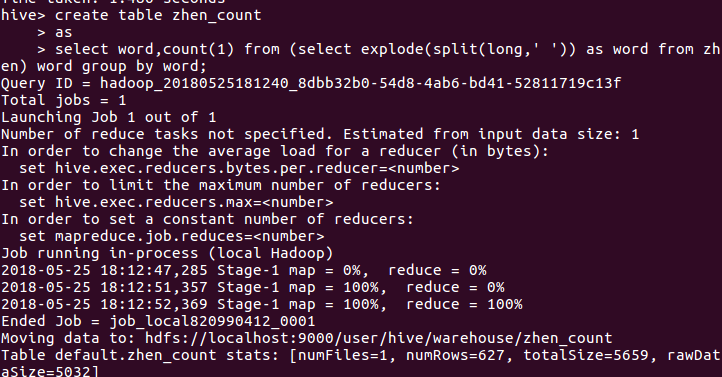

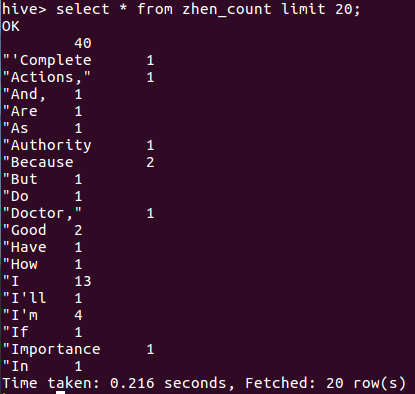

进行词频统计并保持到表 zhen_count

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

首先在我之前的爬虫大作业上获取产生的数据。

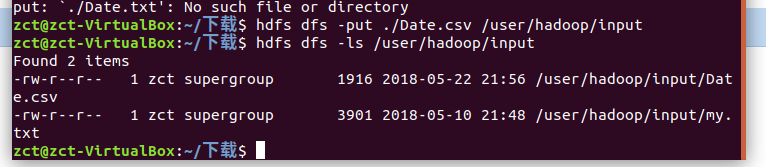

将数据以csv格式上传到hdfs

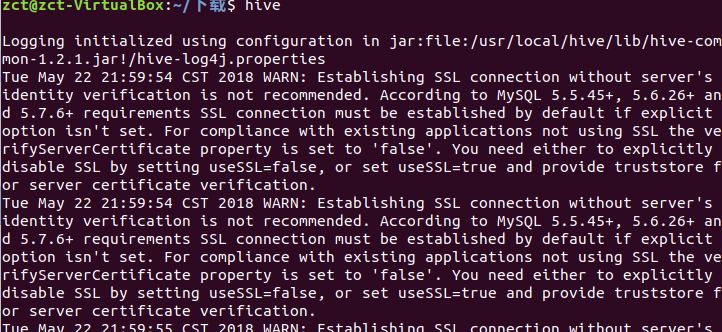

启动hive

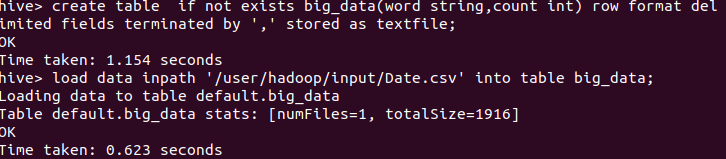

创建表将csv数据导入到表中

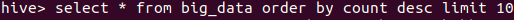

查看前10个数据

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】博客园社区专享云产品让利特惠,阿里云新客6.5折上折

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步