第25章: Kubernetes使用Ceph(rbd cephfs)作为Pod存储

#

| ceph-csi版本 | kubernetes版本 | ceph版本 |

|---|---|---|

| cephcsi:v3.2.2 | v1.20.4 | 15.2.15 octopus (stable) |

1 PV 与 PVC 概述#

对外部存储资源创建和使用的抽象,使得存储作为集群中的资源管理,PV又分为静态供给和动态供给,由于静态供给需要提前创建一堆PV,维护成本

较高,所以企业一般使用动态供给。

(2) PersistentVolumeClaim(PVC)持久卷申请

让用户不需要关心具体的Volume实现细节,只需要定义PVC需要多少磁盘容量即可。

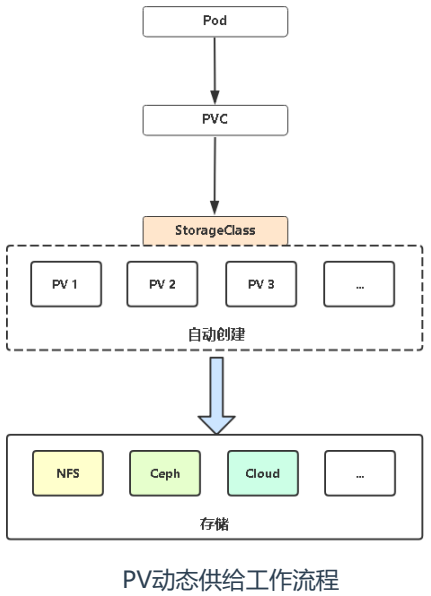

(3) PV动态供给工作流程

动态供给主要是能够自动帮你创建pv,需要多大的空间就创建多大的pv,k8s帮助创建pv,pvc就直接使用api调用存储类来寻找pv。

如果是存储静态供给的话,会需要我们手动去创建pv,而动态供给主要的一个实现就是StorageClass存储对象,其实它就是声明你使用哪

个存储,然后帮你去连接,再帮你去自动创建pv。如果没有足够的资源,找不到合适的pv,那么pod就会处于pending等待的状态。

PersistentVolume 子系统为用户和管理员提供了一组 API,将存储如何供应的细节从其如何被使用中抽象出来。为了实现这点,引入了一些新的资源

和概念:

# PV(PersistentVolume,持久卷)

是集群中的一块存储,可以由管理员事先供应,或者使用存储类(StorageClass)来动态供应。持久卷是集群资源,就像节点也是集群资源一样。

# PVC(PersistentVolumeClaim,持久卷申领)

表达的是用户对存储的请求,PVC申领请求特定的大小和访问模式的PV卷。

# StorageClass(存储类)

集群管理员需要能够提供不同性质的PersistentVolume,并且这些PV卷之间的差别不仅限于卷大小和访问模式,同时又不能将卷是如何实现的这些细节

暴露给用户,为了满足这类需求,就有了存储类(StorageClass)资源。

# volume

卷的核心是一个目录,其中可能存有数据,Pod 中的容器可以访问该目录中的数据。

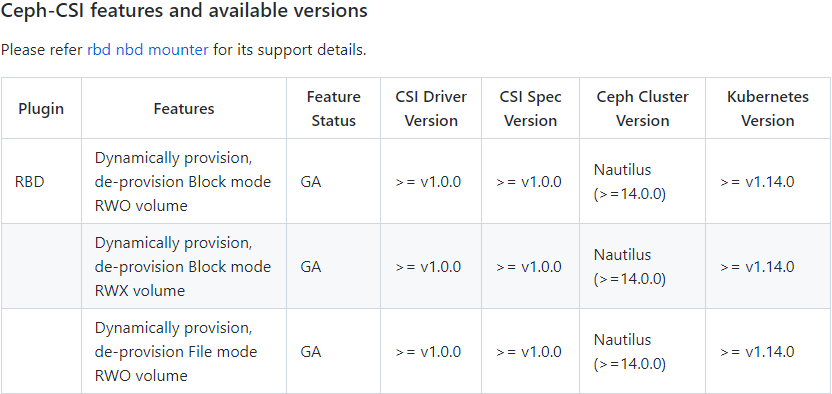

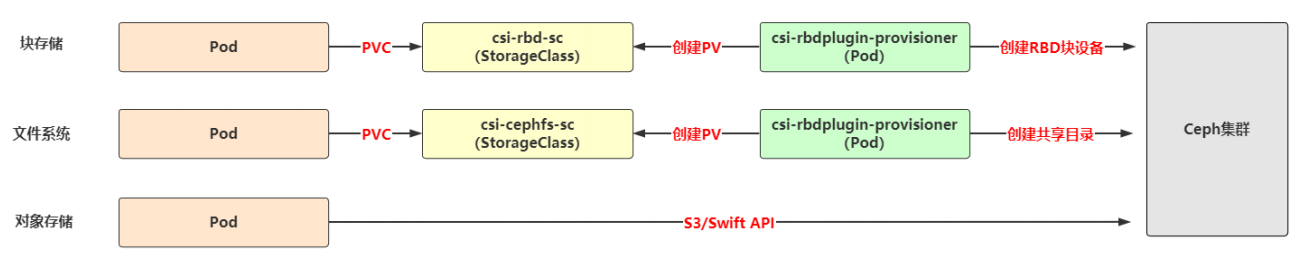

2 ceph-csi 自动供给程序#

ceph-csi是ceph官方维护的PV供给程序,专门用于在Kubernetes中使用RBD、CephFS为Pod提供存储。

项目地址: https://github.com/ceph/ceph-csi

3 Pod使用RBD块存储#

(1) 关于部署,RBD YAML文件在"deploy/rbd/kubernetes"目录,需要做如下改动

1) 全部统一命名空间到 ceph-csi

2) 将镜像转存到 docker hub (由于使用的镜像在国外,国内无法下载,先FQ将其下载后放再放到docker hub上)

3) 增加 secret.yaml 和 storageclass.yaml 文件

4) 将 csi-rbdplugin-provisioner.yaml 和 csi-rbdplugin.yaml 中关于 kms 的配置注释掉

(2) 在使用中,还需要根据自己集群环境修改

1) csi-config-map.yaml 修改连接ceph集群信息

2) secret.yaml 修改秘钥

3) storageclass.yaml 修改集群ID和存储池

(3) 部署

1) 从github上下载的yaml文件如下所示,然后全部统一命名空间到 ceph-csi

[root@k8s-master1 rbd]# ls -l

total 36

-rw-rw-r-- 1 root root 331 Jun 18 17:39 csi-config-map.yaml

-rw-rw-r-- 1 root root 1711 Jun 18 17:42 csi-nodeplugin-psp.yaml

-rw-rw-r-- 1 root root 603 Jun 18 17:41 csi-nodeplugin-rbac.yaml

-rw-rw-r-- 1 root root 1337 Jun 18 17:43 csi-provisioner-psp.yaml

-rw-rw-r-- 1 root root 2923 Jun 18 17:41 csi-provisioner-rbac.yaml

-rw-rw-r-- 1 root root 6876 Jun 18 17:42 csi-rbdplugin-provisioner.yaml

-rw-rw-r-- 1 root root 5630 Jun 18 17:42 csi-rbdplugin.yaml

2) 将镜像转存到 docker hub

csi-rbdplugin-provisioner.yaml

csi-rbdplugin.yaml

3) 增加 secret.yaml 和 storageclass.yaml 文件

[root@k8s-master1 rbd]# cat > secret.yaml << EOF

apiVersion: v1

kind: Secret

metadata:

name: csi-rbd-secret

namespace: ceph-csi

stringData:

userID: admin

userKey: AQDwAsxgatvdARAAkf2inKyubNr/IbzgPhJyGg==

EOF

[root@k8s-master1 rbd]# cat > storageclass.yaml << EOF

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: csi-rbd-sc

provisioner: rbd.csi.ceph.com

parameters:

clusterID: 57026ab3-a596-4c79-a33a-08c37153d462

pool: rbd-k8s

imageFeatures: layering

csi.storage.k8s.io/provisioner-secret-name: csi-rbd-secret

csi.storage.k8s.io/provisioner-secret-namespace: ceph-csi

csi.storage.k8s.io/controller-expand-secret-name: csi-rbd-secret

csi.storage.k8s.io/controller-expand-secret-namespace: ceph-csi

csi.storage.k8s.io/node-stage-secret-name: csi-rbd-secret

csi.storage.k8s.io/node-stage-secret-namespace: ceph-csi

csi.storage.k8s.io/fstype: ext4

reclaimPolicy: Delete

allowVolumeExpansion: true

mountOptions:

- discard

EOF

4) 将 csi-rbdplugin-provisioner.yaml 和 csi-rbdplugin.yaml 中关于 kms 的配置注释掉

[root@k8s-master1 rbd]# grep kms csi-rbdplugin-provisioner.yaml

#- name: ceph-csi-encryption-kms-config

# mountPath: /etc/ceph-csi-encryption-kms-config/

#- name: ceph-csi-encryption-kms-config

# name: ceph-csi-encryption-kms-config

[root@k8s-master1 rbd]# grep kms csi-rbdplugin.yaml

#- name: ceph-csi-encryption-kms-config

# mountPath: /etc/ceph-csi-encryption-kms-config/

#- name: ceph-csi-encryption-kms-config

# name: ceph-csi-encryption-kms-config

[root@k8s-master1 rbd]#

5) csi-config-map.yaml 修改连接ceph集群信息

# 修改连接Ceph集群的clusterID和monitors的地址

[root@k8s-master1 rbd]# vim csi-config-map.yaml

---

apiVersion: v1

kind: ConfigMap

data:

config.json: |-

[

{

"clusterID": "14912382-3d84-4cf2-9fdb-eebab12107d8",

"monitors": [

"172.16.1.31:6789",

"172.16.1.32:6789",

"172.16.1.33:6789"

]

}

]

metadata:

name: ceph-csi-config

namespace: ceph-csi

注: 获取ceph集群clusterID的方法为

[root@ceph-deploy ~]# ceph -s | grep id

id: 14912382-3d84-4cf2-9fdb-eebab12107d8

6) secret.yaml 修改秘钥

# 修改userKey

[root@k8s-master1 rbd]# vim secret.yaml

apiVersion: v1

kind: Secret

metadata:

name: csi-rbd-secret

namespace: ceph-csi

stringData:

userID: admin

userKey: AQArL5JhBEiAKRAAymBtomUPKP6M/BSI17oXyg==

注: 获取ceph集群admin密钥的方法为

[root@ceph-deploy ~]# ceph auth list | egrep "admin|key"

client.admin

key: AQArL5JhBEiAKRAAymBtomUPKP6M/BSI17oXyg==

7) storageclass.yaml 修改集群ID和存储池

# 修改clusterID和pool参数

[root@k8s-master1 rbd]# vim storageclass.yaml

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: csi-rbd-sc

provisioner: rbd.csi.ceph.com

parameters:

clusterID: 14912382-3d84-4cf2-9fdb-eebab12107d8

pool: rbd-k8s

imageFeatures: layering

csi.storage.k8s.io/provisioner-secret-name: csi-rbd-secret

csi.storage.k8s.io/provisioner-secret-namespace: ceph-csi

csi.storage.k8s.io/controller-expand-secret-name: csi-rbd-secret

csi.storage.k8s.io/controller-expand-secret-namespace: ceph-csi

csi.storage.k8s.io/node-stage-secret-name: csi-rbd-secret

csi.storage.k8s.io/node-stage-secret-namespace: ceph-csi

csi.storage.k8s.io/fstype: ext4

reclaimPolicy: Delete

allowVolumeExpansion: true

mountOptions:

- discard

注: 在ceph集群中创建rbd存储池的方法

[root@ceph-deploy ~]# ceph osd pool create rbd-k8s 64 64

[root@ceph-deploy ~]# ceph osd pool application enable rbd-k8s rbd

[root@ceph-deploy ~]# ceph osd pool ls detail

[root@ceph-deploy ~]# rbd ls rbd-k8s # 列表中没有创建任何rbd块设备

8) 应用yaml文件

[root@k8s-master1 rbd]# kubectl create namespace ceph-csi # 创建ceph-csi命名空间

[root@k8s-master1 rbd]# ls | xargs -i kubectl apply -f {}

(4) 检查

[root@k8s-master1 rbd]# kubectl get sc

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

csi-rbd-sc rbd.csi.ceph.com Delete Immediate true 3m33s

[root@k8s-master1 rbd]# kubectl get pod -o wide -n ceph-csi

NAME READY STATUS RESTARTS AGE IP NODE

csi-rbdplugin-95bs4 3/3 Running 0 6m31s 172.16.1.82 k8s-master2

csi-rbdplugin-b9qnd 3/3 Running 0 6m31s 172.16.1.81 k8s-master1

csi-rbdplugin-pb82h 3/3 Running 0 6m31s 172.16.1.84 k8s-node2

csi-rbdplugin-provisioner-fc66bb6-rvhcd 7/7 Running 0 6m31s 172.27.169.138 k8s-node2

csi-rbdplugin-provisioner-fc66bb6-tgkpj 7/7 Running 0 6m31s 172.27.36.68 k8s-node1

csi-rbdplugin-provisioner-fc66bb6-wclzw 7/7 Running 0 6m31s 172.27.159.135 k8s-master1

csi-rbdplugin-trffn 3/3 Running 0 6m31s 172.16.1.83 k8s-node1

[root@k8s-master1 rbd]#

# 可以看到ceph pv自动供给应用部署正常

(5) 测试

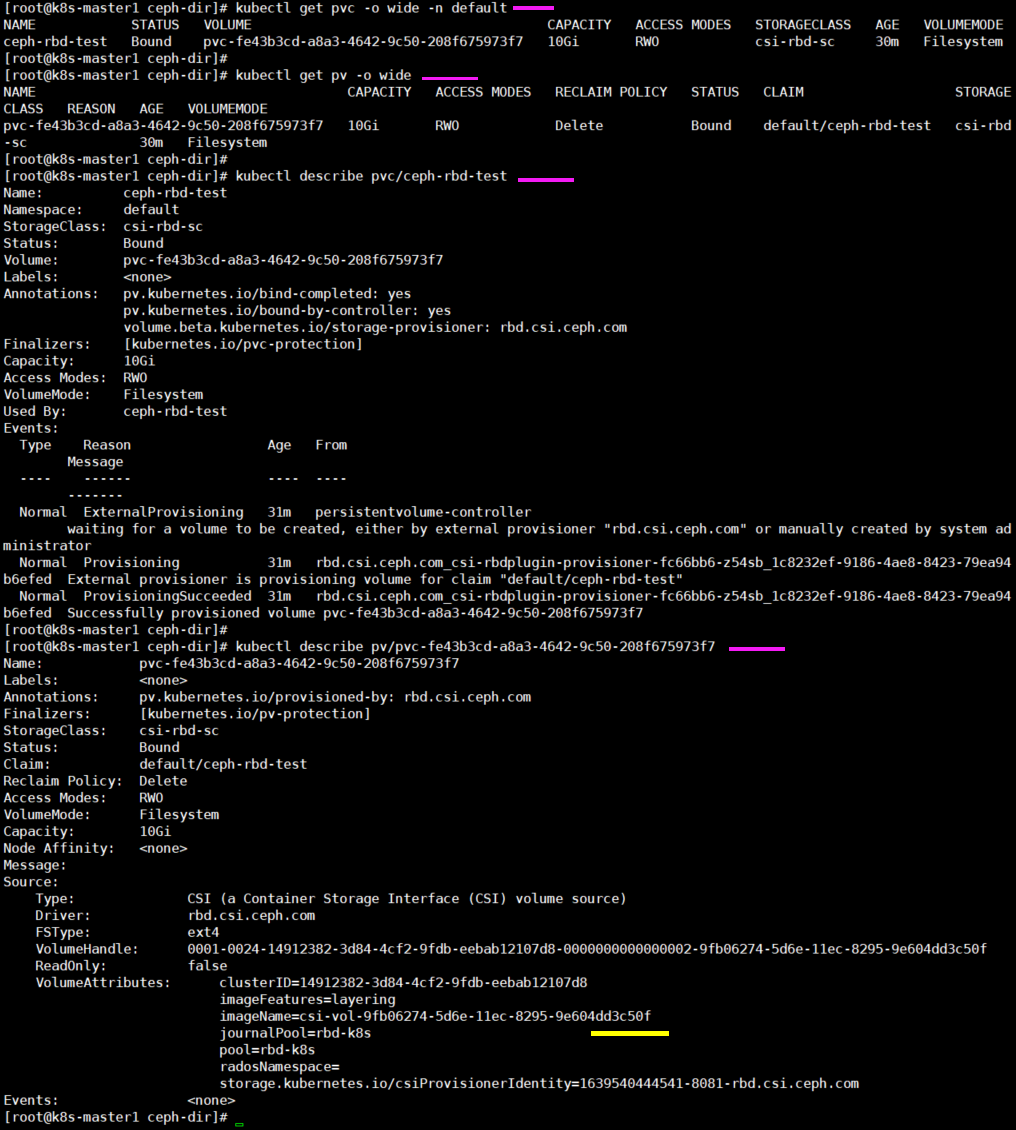

[root@k8s-master1 ceph-dir]# cat > rbd-pod-test.yaml << EOF apiVersion: v1 kind: Pod metadata: name: ceph-rbd-test spec: containers: - name: nginx image: nginx:latest volumeMounts: - name: www mountPath: /usr/share/nginx/html volumes: - name: www persistentVolumeClaim: claimName: ceph-rbd-test --- apiVersion: v1 kind: PersistentVolumeClaim metadata: name: ceph-rbd-test spec: accessModes: - ReadWriteOnce storageClassName: csi-rbd-sc resources: requests: storage: 10Gi EOF 2) 应用yaml文件 [root@k8s-master1 ceph-dir]# kubectl apply -f rbd-pod-test.yaml -n default 3) 查看pod [root@k8s-master1 ceph-dir]# kubectl get pod -o wide -n default NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES ceph-rbd-test 1/1 Running 0 36s 172.27.224.24 k8s-master2 <none> <none> 4) 在ceph集群中查看rbd列表 [root@ceph-deploy ~]# rbd ls rbd-k8s csi-vol-9fb06274-5d6e-11ec-8295-9e604dd3c50f [root@ceph-deploy ~]# rbd info rbd-k8s/csi-vol-9fb06274-5d6e-11ec-8295-9e604dd3c50f rbd image 'csi-vol-9fb06274-5d6e-11ec-8295-9e604dd3c50f': size 10 GiB in 2560 objects order 22 (4 MiB objects) snapshot_count: 0 id: 47d8d58a5c095 block_name_prefix: rbd_data.47d8d58a5c095 format: 2 features: layering op_features: flags: create_timestamp: Wed Dec 15 14:17:04 2021 access_timestamp: Wed Dec 15 14:17:04 2021 modify_timestamp: Wed Dec 15 14:17:04 2021 5) 进入测试pod内查看挂载信息 # 可以看到"ceph-rbd-test"容器内挂载了10G的硬盘rbd0到"/usr/share/nginx/html"目录上 [root@k8s-master1 ceph-dir]# kubectl exec -it pod/ceph-rbd-test -n default -- bash root@ceph-rbd-test:/# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 60G 0 disk |-sda1 8:1 0 200M 0 part |-sda2 8:2 0 2G 0 part `-sda3 8:3 0 57.8G 0 part /etc/hosts sr0 11:0 1 1024M 0 rom rbd0 253:0 0 10G 0 disk /usr/share/nginx/html root@ceph-rbd-test:/# exit 6) 查看pv、pvc信息 [root@k8s-master1 ceph-dir]# kubectl get pvc -o wide -n default [root@k8s-master1 ceph-dir]# kubectl get pv -o wide [root@k8s-master1 ceph-dir]# kubectl describe pvc/ceph-rbd-test -n default [root@k8s-master1 ceph-dir]# kubectl describe pv/pvc-fe43b3cd-a8a3-4642-9c50-208f675973f7

7) 在线扩容功能

当修改rbd-pod-test.yaml文件中pvc的需求大小为20G后再应用,相应的ceph集群的rbd块会自动扩容,但不支持缩容的操作。

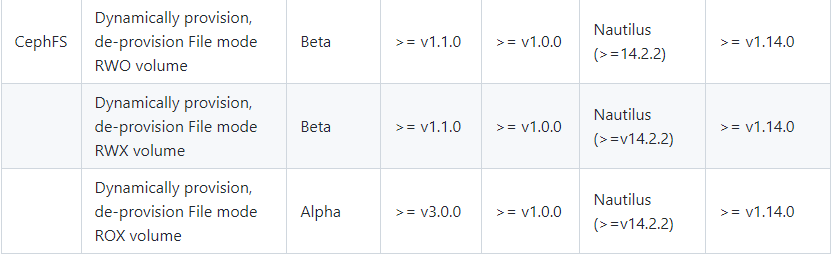

4 pod使用CephFS文件存储#

(1) 关于部署,CephFS YAML文件在"deploy/cephfs/kubernetes"目录,部署时YAML文件需做如下改动

1) 全部统一命名空间到ceph-csi-cephfs

2) 将镜像转存到docker hub

3) 增加secret.yaml和storageclass.yaml文件

(2) 在使用中,还需要根据自己集群环境修改

1) csi-config-map.yaml 修改连接ceph集群信息

2) secret.yaml 修改秘钥

3) storageclass.yaml 修改集群ID和文件系统名称

(3) 部署

1) 从github上下载的yaml文件如下所示,然后全部统一命名空间到 ceph-csi-cephfs [root@k8s-master1 cephfs]# ls -l total 36 -rw-rw-r-- 1 root root 5615 Jun 18 19:20 csi-cephfsplugin-provisioner.yaml -rw-rw-r-- 1 root root 5421 Jun 18 19:20 csi-cephfsplugin.yaml -rw-rw-r-- 1 root root 338 Jun 18 19:20 csi-config-map.yaml -rw-rw-r-- 1 root root 1760 Jun 18 19:20 csi-nodeplugin-psp.yaml -rw-rw-r-- 1 root root 646 Jun 18 19:20 csi-nodeplugin-rbac.yaml -rw-rw-r-- 1 root root 1383 Jun 18 19:20 csi-provisioner-psp.yaml -rw-rw-r-- 1 root root 3017 Jun 18 19:20 csi-provisioner-rbac.yaml 2) 将镜像转存到docker hub csi-cephfsplugin-provisioner.yaml csi-cephfsplugin.yaml 3) 增加secret.yaml和storageclass.yaml文件 [root@k8s-master1 cephfs]# cat > secret.yaml << EOF apiVersion: v1 kind: Secret metadata: name: csi-cephfs-secret namespace: ceph-csi-cephfs stringData: adminID: admin adminKey: AQDwAsxgatvdARAAkf2inKyubNr/IbzgPhJyGg== EOF [root@k8s-master1 cephfs]# cat > storageclass.yaml << EOF apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: csi-cephfs-sc provisioner: cephfs.csi.ceph.com parameters: clusterID: 57026ab3-a596-4c79-a33a-08c37153d462 pool: cephfs_data fsName: cephfs csi.storage.k8s.io/provisioner-secret-name: csi-cephfs-secret csi.storage.k8s.io/provisioner-secret-namespace: ceph-csi-cephfs csi.storage.k8s.io/controller-expand-secret-name: csi-cephfs-secret csi.storage.k8s.io/controller-expand-secret-namespace: ceph-csi-cephfs csi.storage.k8s.io/node-stage-secret-name: csi-cephfs-secret csi.storage.k8s.io/node-stage-secret-namespace: ceph-csi-cephfs reclaimPolicy: Delete allowVolumeExpansion: true mountOptions: - discard EOF 4) csi-config-map.yaml 修改连接ceph集群信息 # 修改连接Ceph集群的clusterID和monitors的地址 [root@k8s-master1 cephfs]# vim csi-config-map.yaml --- apiVersion: v1 kind: ConfigMap data: config.json: |- [ { "clusterID": "14912382-3d84-4cf2-9fdb-eebab12107d8", "monitors": [ "172.16.1.31:6789", "172.16.1.32:6789", "172.16.1.33:6789" ] } ] metadata: name: ceph-csi-config namespace: ceph-csi-cephfs 注: 获取ceph集群clusterID的方法为 [root@ceph-deploy ~]# ceph -s | grep id id: 14912382-3d84-4cf2-9fdb-eebab12107d8 5) secret.yaml 修改秘钥 # 修改adminKey [root@k8s-master1 cephfs]# vim secret.yaml apiVersion: v1 kind: Secret metadata: name: csi-cephfs-secret namespace: ceph-csi-cephfs stringData: adminID: admin adminKey: AQArL5JhBEiAKRAAymBtomUPKP6M/BSI17oXyg== 注: 获取ceph集群admin密钥的方法为 [root@ceph-deploy ~]# ceph auth list | egrep "admin|key" client.admin key: AQArL5JhBEiAKRAAymBtomUPKP6M/BSI17oXyg== 6) storageclass.yaml 修改集群ID和文件系统名称 # 修改clusterID、pool、fsName参数 [root@k8s-master1 cephfs]# vim storageclass.yaml apiVersion: storage.k8s.io/v1 kind: StorageClass metadata: name: csi-cephfs-sc provisioner: cephfs.csi.ceph.com parameters: clusterID: 14912382-3d84-4cf2-9fdb-eebab12107d8 pool: cephfs_data fsName: cephfs csi.storage.k8s.io/provisioner-secret-name: csi-cephfs-secret csi.storage.k8s.io/provisioner-secret-namespace: ceph-csi-cephfs csi.storage.k8s.io/controller-expand-secret-name: csi-cephfs-secret csi.storage.k8s.io/controller-expand-secret-namespace: ceph-csi-cephfs csi.storage.k8s.io/node-stage-secret-name: csi-cephfs-secret csi.storage.k8s.io/node-stage-secret-namespace: ceph-csi-cephfs reclaimPolicy: Delete allowVolumeExpansion: true mountOptions: - discard 注: 在ceph集群中创建rbd存储池的方法 # 部署MDS服务 首先要创建两个pool,一个是cephfs-data,一个是cephfs-metadate,分别存储文件数据和文件元数据,这个pg也可以设置小一点,这个根据OSD去 配置。 # cd /root/my-cluster/ # ceph-deploy mds create ceph-node01 ceph-node02 ceph-node03 # ceph mds stat # 查看mds节点状态 3 up:standby # 创建存储池 # ceph osd pool create cephfs_data 64 64 # ceph osd pool create cephfs_metadata 64 64 # ceph osd pool ls device_health_metrics rbd-k8s cephfs_data cephfs_metadata # 创建文件系统 格式: ceph fs new <fs_name> <metadata> <data> # ceph fs new cephfs cephfs_metadata cephfs_data # ceph fs ls # 查看创建后的cephfs name: cephfs, metadata pool: cephfs_metadata, data pools: [cephfs_data ] 7) 应用yaml文件 [root@k8s-master1 cephfs]# kubectl create namespace ceph-csi-cephfs # 创建ceph-csi-cephfs命名空间 [root@k8s-master1 cephfs]# ls | xargs -i kubectl apply -f {}

(4) 检查

[root@k8s-master1 cephfs]# kubectl get sc

NAME PROVISIONER RECLAIMPOLICY VOLUMEBINDINGMODE ALLOWVOLUMEEXPANSION AGE

csi-cephfs-sc cephfs.csi.ceph.com Delete Immediate true 2m44s

[root@k8s-master1 cephfs]# kubectl get pod -o wide -n ceph-csi-cephfs

NAME READY STATUS RESTARTS AGE IP NODE

csi-cephfsplugin-7kv9h 3/3 Running 0 5m35s 172.16.1.84 k8s-node2

csi-cephfsplugin-8zh5x 3/3 Running 0 5m35s 172.16.1.83 k8s-node1

csi-cephfsplugin-provisioner-7c454885fc-5xkm7 6/6 Running 0 5m33s 172.27.159.149 k8s-master1

csi-cephfsplugin-provisioner-7c454885fc-75rn4 6/6 Running 0 5m33s 172.27.36.76 k8s-node1

csi-cephfsplugin-provisioner-7c454885fc-wc6lv 6/6 Running 0 5m33s 172.27.169.154 k8s-node2

csi-cephfsplugin-skwnh 3/3 Running 0 5m35s 172.16.1.82 k8s-master2

csi-cephfsplugin-vxlj5 3/3 Running 0 5m35s 172.16.1.81 k8s-master1

# 可以看到ceph pv自动供给应用部署正常

(5) 测试

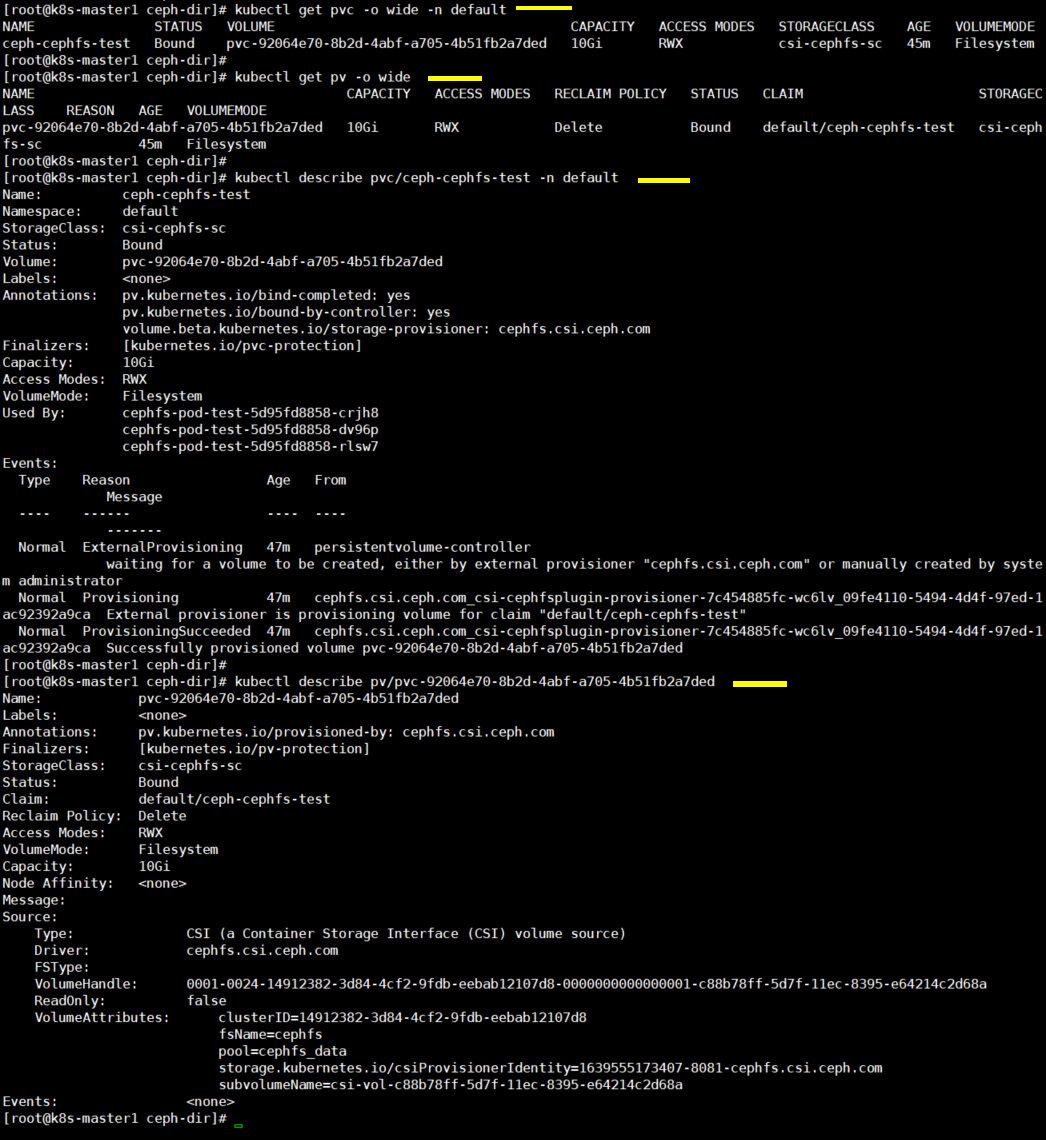

1) 测试yaml文件 [root@k8s-master1 ceph-dir]# cat > cephfs-deployment-test.yaml << EOF apiVersion: apps/v1 kind: Deployment metadata: name: cephfs-pod-test spec: replicas: 3 selector: matchLabels: app: nginx template: metadata: labels: app: nginx spec: containers: - name: nginx image: nginx volumeMounts: - name: www mountPath: /usr/share/nginx/html volumes: - name: www persistentVolumeClaim: claimName: ceph-cephfs-test --- apiVersion: v1 kind: PersistentVolumeClaim metadata: name: ceph-cephfs-test spec: accessModes: - ReadWriteMany storageClassName: csi-cephfs-sc resources: requests: storage: 10Gi EOF 2) 应用yaml文件 [root@k8s-master1 ceph-dir]# kubectl apply -f cephfs-deployment-test.yaml -n default 3) 查看pod [root@k8s-master1 ceph-dir]# kubectl get pod -o wide -n default NAME READY STATUS RESTARTS AGE IP NODE cephfs-pod-test-5d95fd8858-crjh8 1/1 Running 0 111s 172.27.224.26 k8s-master2 cephfs-pod-test-5d95fd8858-dv96p 1/1 Running 0 111s 172.27.224.25 k8s-master2 cephfs-pod-test-5d95fd8858-rlsw7 1/1 Running 0 111s 172.27.224.27 k8s-master2 4) 在ceph集群中查看cephfs信息 # 命令行挂载cephfs文件系统 [root@ceph-deploy ~]# mkdir -p /data/ [root@ceph-deploy ~]# mount -t ceph 172.16.1.31:6789,172.16.1.32:6789,172.16.1.33:6789:/ /data -o \ name=admin,secret=AQArL5JhBEiAKRAAymBtomUPKP6M/BSI17oXyg== # 查看volume,可以看到数据存储位置 [root@ceph-deploy ~]# tree /data/ /data/ └── volumes ├── csi │ └── csi-vol-c88b78ff-5d7f-11ec-8395-e64214c2d68a │ └── 6ab0685a-7414-4edd-9561-28bed0406035 │ └── index.html └── _csi:csi-vol-c88b78ff-5d7f-11ec-8395-e64214c2d68a.meta 4 directories, 2 files 5) 进入测试pod内查看挂载信息 # 可以看到创建的3个pod共享了cephfs存储池 [root@k8s-master1 ceph-dir]# kubectl exec -it pod/cephfs-pod-test-5d95fd8858-crjh8 -n default -- bash root@cephfs-pod-test-5d95fd8858-crjh8:/# df -hT Filesystem Type Size Used Avail Use% Mounted on ......(省略的内容) ceph-fuse fuse.ceph-fuse 10G 0 10G 0% /usr/share/nginx/html root@cephfs-pod-test-5d95fd8858-crjh8:/# exit exit [root@k8s-master1 ceph-dir]# kubectl exec -it pod/cephfs-pod-test-5d95fd8858-dv96p -n default -- bash root@cephfs-pod-test-5d95fd8858-dv96p:/# df -hT Filesystem Type Size Used Avail Use% Mounted on ......(省略的内容) ceph-fuse fuse.ceph-fuse 10G 0 10G 0% /usr/share/nginx/html root@cephfs-pod-test-5d95fd8858-dv96p:/# exit exit [root@k8s-master1 ceph-dir]# kubectl exec -it pod/cephfs-pod-test-5d95fd8858-rlsw7 -n default -- bash root@cephfs-pod-test-5d95fd8858-rlsw7:/# df -hT Filesystem Type Size Used Avail Use% Mounted on ......(省略的内容) ceph-fuse fuse.ceph-fuse 10G 0 10G 0% /usr/share/nginx/html root@cephfs-pod-test-5d95fd8858-rlsw7:/# exit exit [root@k8s-master1 ceph-dir]# 6) 查看pv、pvc信息 [root@k8s-master1 ceph-dir]# kubectl get pvc -o wide -n default [root@k8s-master1 ceph-dir]# kubectl get pv -o wide [root@k8s-master1 ceph-dir]# kubectl describe pvc/ceph-cephfs-test -n default [root@k8s-master1 ceph-dir]# kubectl describe pv/pvc-92064e70-8b2d-4abf-a705-4b51fb2a7ded

5 小结#

(2) pvc,pv总结

官方文档:

https://kubernetes.io/docs/concepts/storage/persistent-volumes/#access-modes

1) pv独立于pod存在,pv是全局资源,pvc是局部资源(在pod使用的命名空间下)。

2) pv可以创建动态pv或者静态pv,动态pv不需要手动去创建,静态pv需要手动创建。

3) 访问模式

ReadWriteOnce # 卷可以被一个节点以读写方式挂载。ReadWriteOnce访问模式也允许运行在同一节点上的多个Pod访问卷。

ReadOnlyMany # 卷可以被多个节点多个Pod以只读方式挂载。

ReadWriteMany # 卷可以被多个节点多个Pod以读写方式挂载。

ReadWriteOncePod # 卷可以被单个Pod以读写方式挂载。如果你想确保整个集群中只有一个Pod可以读取或写入该PVC,请使用ReadWriteOncePod

访问模式。这只支持CSI卷以及需要Kubernetes 1.22以上版本。

在CLI中,访问模式缩写为 RWO - ReadWriteOnce、ROX - ReadOnlyMany、RWX - ReadWriteMany、RWOP - ReadWriteOncePod

4) pv回收策略

当用户不再使用其存储卷时,他们可以从 API 中将 PVC 对象删除,从而允许该资源被回收再利用。PersistentVolume 对象的回收策略告诉集

群,当其被从申领中释放时如何处理该数据卷,pv支持的回收策略有Retain、Recycle、Delete。pv静态供给和pv动态供给下,单独删除pod后

pvc不会被删除,使用"kubectl delete -f rbd-pod-test.yaml"或"kubectl delete pvc/pvcname"的方式会删除pvc。

pvc被删除后pv根据pv回收策略对pv和资源进行相应的操作,单独操作pv(例如: 删除)不会对pv资源产生影响。nfs只支持Retain、Recycle策略,

ceph只支持Retain、Delete策略。

# Retain策略(保留,默认策略)

在删除pvc后PV变为Released不可用状态,若想重新被使用,需要管理员删除pv,重新创建pv,删除pv并不会删除存储的资源,只是删除pv对象而

已,若想保留数据,请使用该Retain策略。

回收策略Retain使得用户可以手动回收资源,当PersistentVolumeClaim对象被删除时,PersistentVolume卷仍然存在,对应的数据卷被视为

"已释放(released)",由于卷上仍然存在着前一申领人的数据,该卷还不能用于其他申领,管理员可以通过手动回收该卷。使用命令编辑pv,删除

绑定信息"claimRef:"下的"resourceVersion"和"uid"键,即可重新释放PV使其状态由Released变为Available(但是引用的pvc不变,删除

"claimRef:"的所有内容可以被其它pvc引用)编辑命令为"kubectl edit pv/pvname"。

# Recycle策略(回收)

删除pvc自动清除pv中的数据,效果相当于执行 rm -rf /thevolume/*,删除pvc时pv的状态由Bound变为Available,此时可重新被pvc申请

绑定。警告: 回收策略Recycle会被废弃,取而代之的建议方案是使用动态供应。

# Delete策略(删除)

在删除pvc后pv被删除并删除存储上的对应存储资源,例如AWS EBS、GCE PD、Azure Disk、OpenStack Cinder Volume等。

对于支持Delete回收策略的卷插件,删除动作会将PersistentVolume对象从Kubernetes中移除,同时也会从外部基础设施(如AWS EBS、GCE PD、

Azure Disk、Cinder卷)中移除所关联的存储资产,动态供应的卷会继承其StorageClass中设置的回收策略,该策略默认为Delete,管理员需要根

据用户的期望来配置StorageClass,否则PV卷被创建之后必须要被编辑或者修改。

修改方法:

# kubectl edit pv/pvname

# kubectl patch pv <your-pv-name> -p '{"spec":{"persistentVolumeReclaimPolicy":"Retain"}}'

5) storageClassName

在pvc的请求存储大小和访问权限与创建的pv一致的情况下,根据storageClassName进行与pv绑定,常用在pvc需要和特定pv进行绑定的情况下。

例如,当有创建多个pv、pvc设置存储的大小和访问权限一致时,且pv、pvc没有配置storageClassName时,pvc会根据存储大小和访问权限去随

机匹配,如果配置了storageClassName会根据这三个条件进行匹配,当然也可以用其他方法实现pvc与特定pv的绑定如标签。

.JPG)

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 无需6万激活码!GitHub神秘组织3小时极速复刻Manus,手把手教你使用OpenManus搭建本

· C#/.NET/.NET Core优秀项目和框架2025年2月简报

· 葡萄城 AI 搜索升级:DeepSeek 加持,客户体验更智能

· 什么是nginx的强缓存和协商缓存

· 一文读懂知识蒸馏