在学习正则化时经常碰到 范数(norm)这个概念,所以想去了解一下这个到底是什么东东,他在机器学习等领域发挥了什么作用额。

参考了网络上多位大神的文章,记录一下自己的理解,以备后续查阅。

范数(Norm)是一个函数,其赋予某个向量空间(或矩阵)中的每个向量以长度或大小。所以实际就是一个函数,用来表示向量空间或者矩阵中的向量的大小的,只不过表示的方式不一样所以也就有了什么L0 L1 L2 和更加一般的Lp范数。对于零向量,另其长度为零。直观的说,向量或矩阵的范数越大,则我们可以说这个向量或矩阵也就越大。经常见到向量范数和矩阵范数,||x||, 和||X||,其中x和X分别表示向量和矩阵。微信上有个公众号感觉解读的很好,贴过来。主要参考这两篇文章,注明出处

向量范数:https://mp.weixin.qq.com/s/bfASw9wvFzKUmvLYckYIFQ

矩阵范数:https://mp.weixin.qq.com/s/Q8qRgNrNdesjc7RrLhaK6A

既然讲范数,那就按照惯例,给出常用范数的定义----(不用知道他们都是什么,就知道有这么个名词先,慢慢一点点的理解)

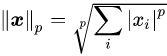

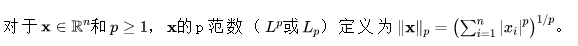

一般将任意向量 的

-范数定义为

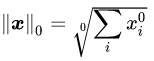

根据 -范数的定义,当

,我们就有了

-范数,即

-------表示向量

-------表示向量 中非0元素的个数

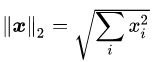

根据 -范数的定义,当

时,任意向量

的

-范数为

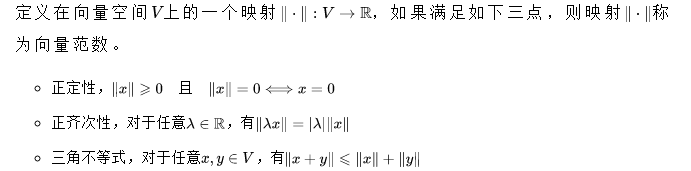

先说向量范数: 向量范数的定义

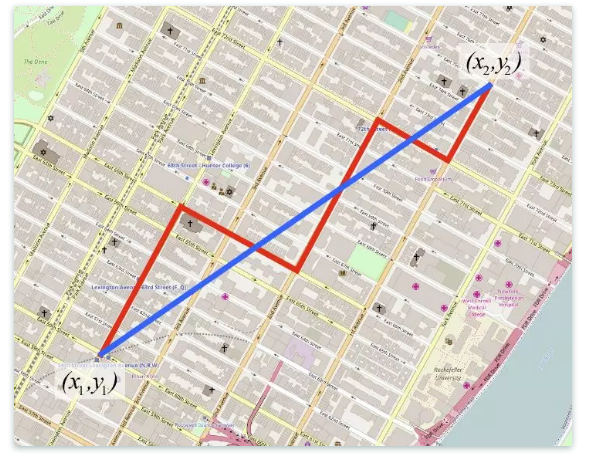

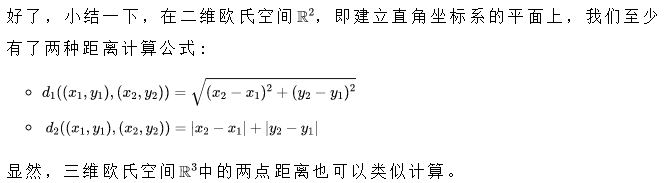

看一眼这个城市的地图,如果我们要测量两点之间的距离,在地图坐标系里我们可以直接按照蓝线计算,但是在城市里实际车开过的距离应该是红线。所以距离可以表示成 ,这个距离被称为曼哈顿(Manhattan)距离,或者taxicar距离德等,反正就是指在城市中taxi走的距离。

,这个距离被称为曼哈顿(Manhattan)距离,或者taxicar距离德等,反正就是指在城市中taxi走的距离。

然后,数学家将这种特殊的情况推广到一般去,

(闵可夫斯基距离)

(闵可夫斯基距离)

常用的范数,也就是上式定义的p=1,p=2,和p=∞时,p=∞也有自己的名字--切比雪夫距离;

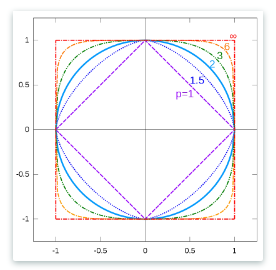

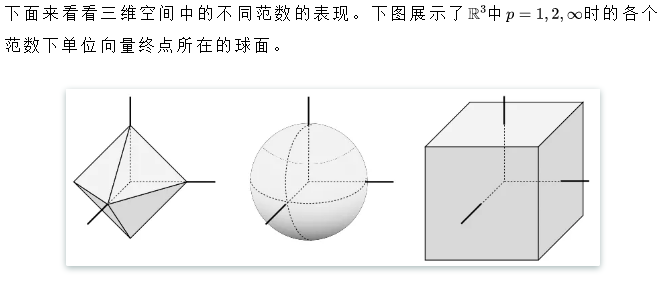

下图展示了p取不同的值时各个范数下单位向量终点的轨迹(这个图还是很有意思的)

向量范数就到这里,关于矩阵范数的可以去看上面提到的公众号文章。

-----------------------------------------------------------------------------------------------------------------------------------------------

浙公网安备 33010602011771号

浙公网安备 33010602011771号