TransH 学习笔记

TransH

paper : Knowledge Graph Embedding by Translating on Hyperplanes

论文

What is TransH ?

这篇文章是由中山大学与微软研究院联合发表的工作,文章主要解决了 TransE 模型不能很好的解决 1-n 、 n-1 、 n-n 这种关系的问题。 TransH 中的 H 是指 hyperspace (超平面)。

Method

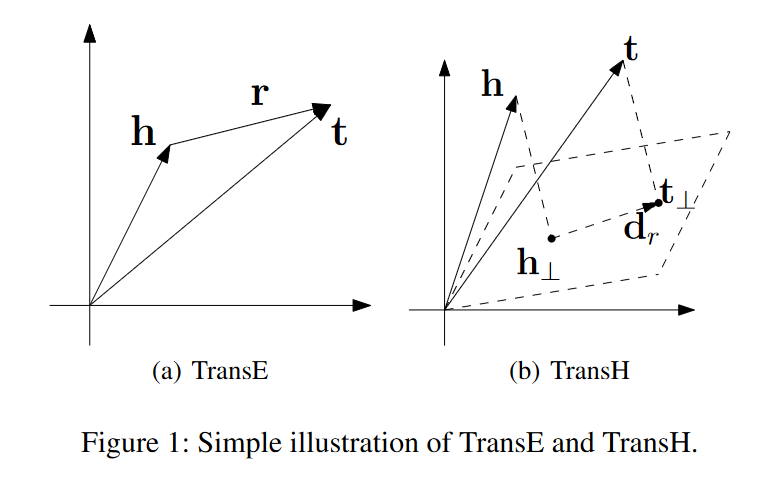

文章继续沿用了 TransE 中的一些方法,将 头实体 h 和 尾实体 t 依旧用一个向量表示。关系 r 用两个向量表示,与 TransE 不同的是,TransH 将头尾实体向量投影到关系向量 r 所在的超平面 hyperspace 中,如下图所示。

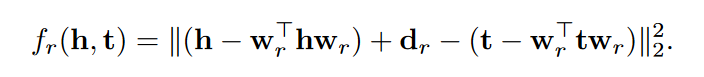

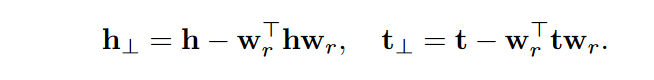

头尾实体的投影操作如下:

其中 wr 为 normal vector ,它的二范数 = 1,用于头尾实体的投影。

dr 为关系 r 的embedding,用于计算得分。

(疑问) 原文说通过限制 ‖wr‖2 = 1,可以轻松的得到投影公式,我不理解。

By restricting ‖wr‖2 = 1, it is easy to get :

然后用投影之后的头尾实体计算得分:

Loss function

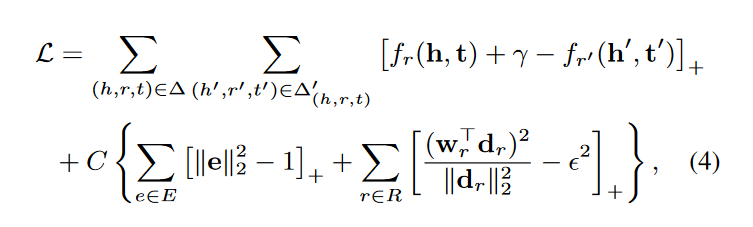

TransH 对实体和关系的向量加了很多的约束,训练同样使用 随机梯度下降法 SGD。

negative sampling

TransH 是首次提出 unif 和 bern 采样方法的工作。原始的负采样方法是从实体集中随机抽取一个实体替换到 golden triplet 中生成负样本,但是这样做有可能会得到假阳(false negative)的负样本。对于这种情况,文章的解决策略是:对于 1-N 的关系,赋予更高的概率替换头实体,而对于 N-1 的关系,赋予更高的概率替换尾实体。

Experiments

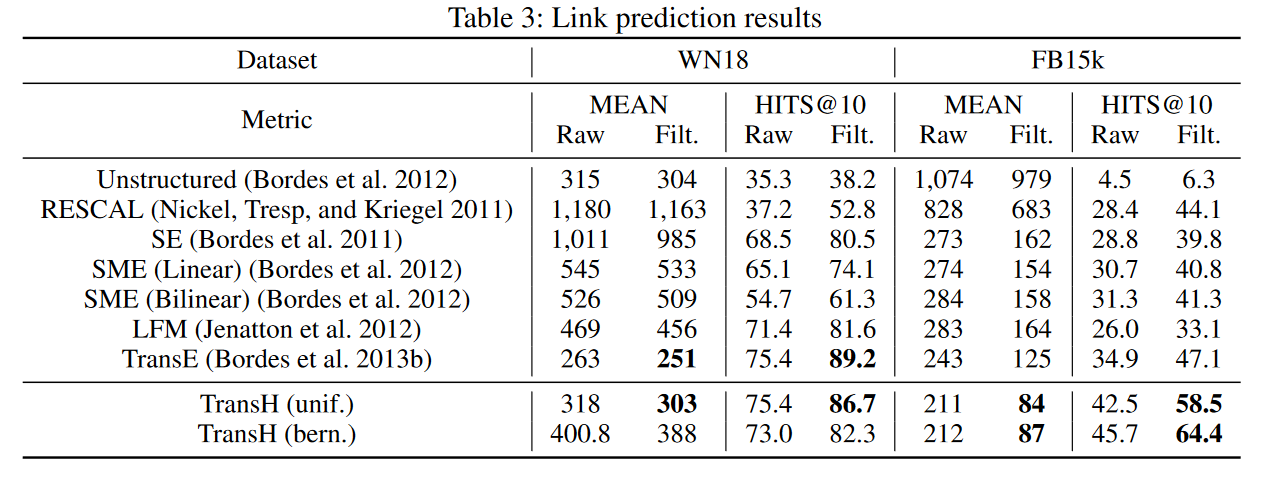

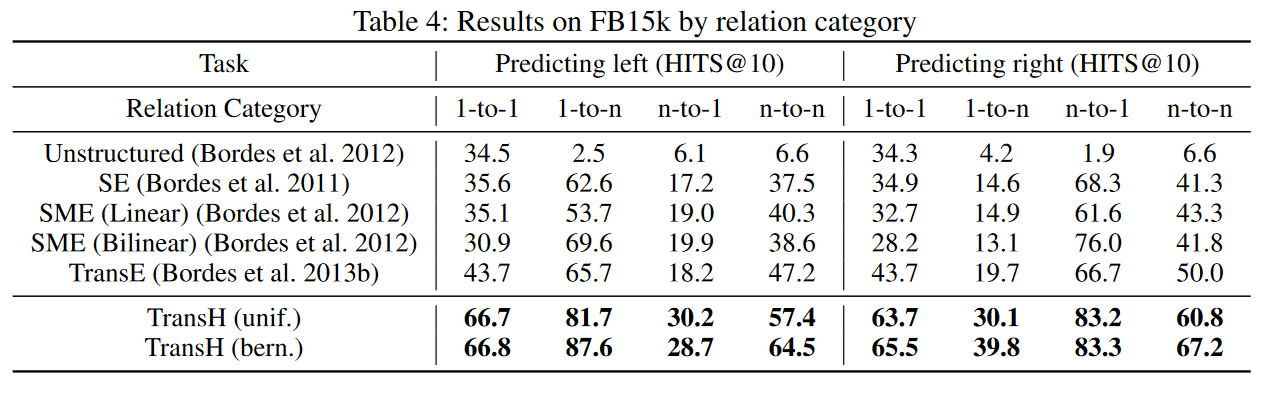

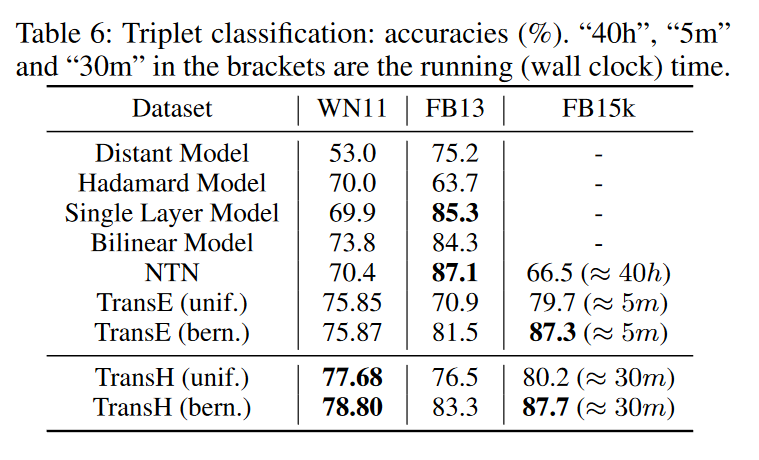

论文的实验进行了链接预测、三元组分类和关系抽取三项实验。

summary

TransH 解决了 TransE 模型不能很好的解决 1-n 、 n-1 、 n-n 这种关系的问题,另外提出了新的采样方法,将翻译的操作由低维平面拓展到了超平面,也是非常有效的。

浙公网安备 33010602011771号

浙公网安备 33010602011771号