【译】大模型能推理吗?

原作:梅拉妮·米切尔

/Gemini翻译/

我们应该如何看待当今大型语言模型的推理能力?正如上面的标题所示,关于这些庞大的预训练神经网络是否已经达到类人推理能力,或者它们的技能实际上是否“只是海市蜃楼”,争论正酣。

推理是人类智能的核心方面,而强大的领域无关推理能力长期以来一直是人工智能系统的一个关键目标。虽然大型语言模型 (LLMs) 并未被明确训练为推理,但它们表现出了有时看起来像推理的“涌现”行为。但这些行为实际上是由真正的抽象推理能力驱动的,还是由其他一些不太强大且不可泛化的机制(例如,通过记忆其训练数据,然后将给定问题中的模式与训练数据中发现的模式进行匹配)驱动的?

为什么这很重要?如果 LLMs 中出现了强大的通用推理能力,这将支持这样的说法:此类系统是实现可信赖通用智能的重要一步。另一方面,如果 LLMs 主要依赖于记忆和模式匹配,而不是真正的推理,那么它们将不可泛化——我们不能相信它们在“分布外”任务(那些与它们在训练数据中看到的任务不够相似)上表现良好。

什么是“推理”?

“推理”一词是一个总括性术语,其中包括演绎、归纳、外推、类比、常识和其他解决问题的“理性”或系统方法的能力。推理通常是一个涉及组成多个推理步骤的过程。推理通常被认为需要抽象——也就是说,推理能力并不局限于某个特定示例,而是更一般的。如果我能推理加法,我不仅可以解决 23+37,还可以解决遇到的任何加法问题。如果我学会在 10 进制中加法,并且还了解其他进制,我的推理能力使我能够快速学会在任何其他进制中加法。

LLMs 中的“思维链”推理

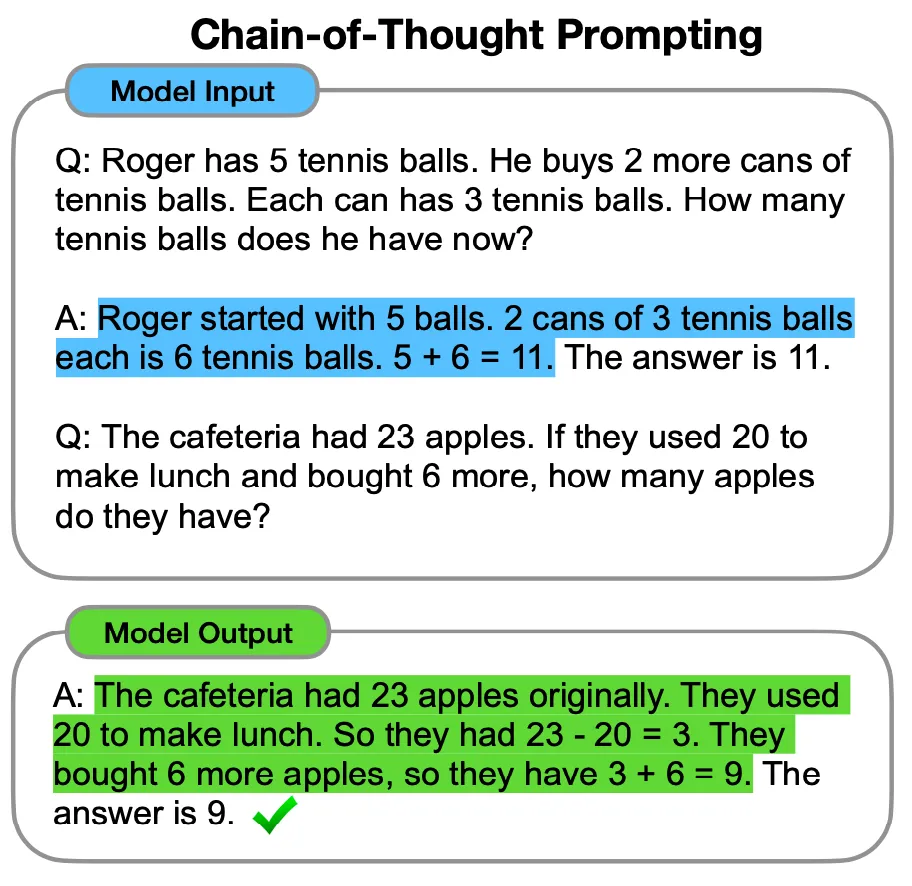

在过去几年中,大量论文声称 LLMs 具有推理能力(Huang 和 Chang 给出了一项最近的调查)。其中一篇最有影响力的论文(来自 Google Research 的 Wei 等人)提出,所谓的“思维链”(CoT)提示引发了这些模型中复杂的推理能力。CoT prompt 给出了一个或多个问题的示例以及解决该问题所需的推理步骤,然后提出了一个新问题。LLM 然后将输出文本,该文本遵循一组类似的推理步骤,然后再输出答案。Wei 等人的论文中的这个数字给出了一个示例:

Wei 等人对包含数学文字问题、常识推理问题和其他领域的数据集测试了 CoT 提示方法。在许多情况下,CoT 提示显著提高了 LLMs 在这些数据集上的性能。

CoT 提示的两个缺点是:(1) 人类提示者需要花费一些精力来构建此类提示;(2) 通常,能够构建一个 CoT 示例以包含在 prompt 中,要求提示者已经知道如何解决给 LLM 的问题!

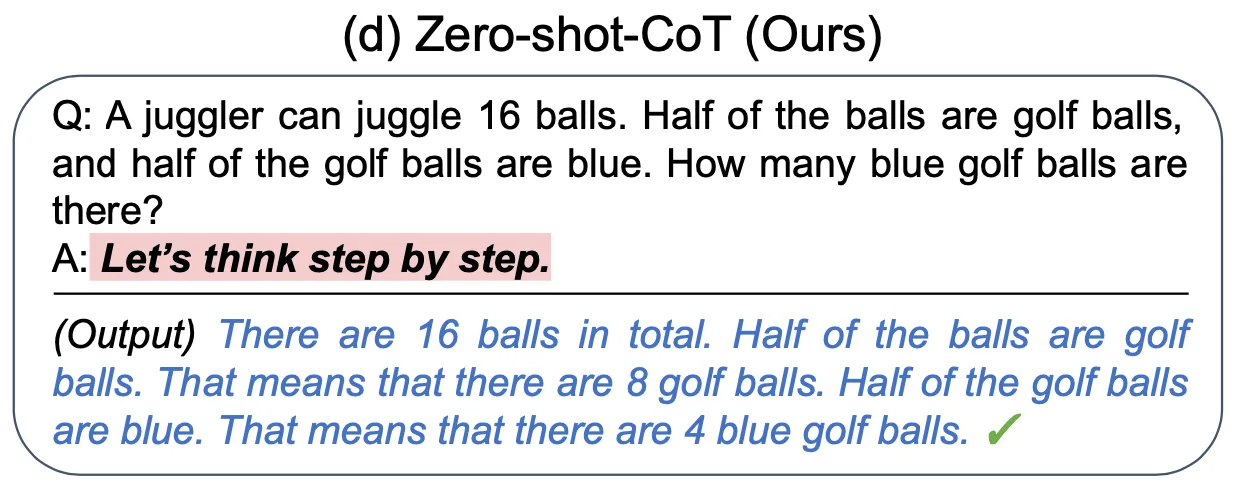

后续论文提出,可以通过省略 CoT 示例来避免这些问题,只需向 LLM 提出问题,并添加短语“让我们一步一步思考”。以下是该论文中的一个示例:

令人惊讶的是,对 prompt 的这个简单补充——称为“零样本 CoT 提示”——与没有添加“让我们逐步思考”的提示相比,极大地提高了 LLM 在几个推理基准上的性能。

无论是使用示例还是“让我们逐步思考”,为什么 CoT 提示对 LLMs 都有如此显著的影响? 有趣的是,虽然有很多假设,但这个问题尚未得到明确的解答。

在 CoT 提示下生成的推理步骤是否忠实于实际推理过程?

虽然上述 CoT 和零样本 CoT 提示的示例展示了语言模型生成了看起来像是对给定问题进行正确逐步推理的文本,但人们可以询问模型生成的文本是否“忠实”——也就是说,它是否描述了 LLM 用于解决问题的实际推理过程? LLMs 未经训练来生成准确反映其自身内部“推理”过程的文本;它们仅接受训练来生成对 prompt 做出回应时听起来合理的文本。那么,生成的文本与 LLM 得出答案的实际过程之间有什么联系?

不同的研究人员已经解决了这个问题。在一项研究中,研究人员发现,在某些情况下,“CoT 解释可以系统地错误地表示模型预测的真实原因。”另一项研究发现,有趣的是,“随着模型变得更大、功能更强大,它们在我们研究的大多数任务上产生的可靠推理更少。”

事实上,原始思想链提示论文的作者魏等人注意到了这个警告:“[A] 虽然思想链模拟了人类推理者的思维过程,但这并不能回答神经网络是否实际上是‘推理’,我们把它作为一个开放的问题。”

如果LLMs没有推理,它们在做什么?

如果事实证明 LLMs 实际上并不是为了解决我们给它们的问题而进行推理,那么它们还能用什么其他方法来解决这些问题呢?几位研究人员已经表明,LLMs 在解决涉及在其训练数据中更频繁出现的术语或概念的问题方面明显更胜一筹,这导致了这样的假设:LLMs 不会执行稳健的抽象推理来解决问题,而是(至少部分地)通过识别与其给定的提示文本匹配或类似或以其他方式相关的训练数据中的模式来解决问题。

例如,Razeghi 等人的一项研究表明,一些基于 GPT 的LLMs(在已知语料库上预训练)在涉及预训练语料库中经常出现的数字的算术问题上比那些出现频率较低的数字要好得多。这些模型似乎缺乏一般的算术能力,而是依赖于一种“记忆”——匹配他们在预训练中看到的文本模式。该研究的作者指出,鉴于这样的结果,“任何不考虑预训练数据的推理评估都难以解释,并且我们需要重新审视语言模型相对于其预训练数据的评估,然后再对模型的泛化能力做出任何结论超出预训练数据。”作为一个明显的例子,康奈尔大学的本科生研究员 Horace He 在 Twitter 上发帖称,在编程挑战数据集上,GPT-4 解决了 10 个在 2021 年之前发布的问题(GPT-4 的预训练截止日期)和 0 个在 2021 年之后发布的问题。GPT-4 在 2021 年之前的挑战中取得成功,这似乎是由于它记住了在训练数据中看到的问题,而不是从头开始推理问题。

Wu 等人撰写的一篇引人入胜的论文通过他们所谓的“反事实任务”探究了“记忆”假设。这个想法是采用一个 LLM 表现良好的推理任务,并创建该任务的一个变体(“反事实版本”),该变体需要相同的抽象推理能力,但可能在 LLM 的训练数据中出现的频率较低。

作为一个示例,GPT-4 非常擅长执行给定 prompt 中的 Python 计算机代码片段。在 Python 中,列表和其他数据结构使用“零索引”,这意味着,例如,列表 L 的第一个元素称为 L[0]。如果 L = [“orange”, “banana”, “apple”],则 L[0] = “orange”,L[1] = “banana”,依此类推。一些其他编程语言使用“一索引”——在这些语言中,L[1] 等于“orange”,L[2] 等于“banana”,等等。

了解 Python 的人类程序员大概能够轻松适应使用一索引而不是零索引的 Python 假设版本。这样做将是一种非常简单的关于代码的抽象推理形式。

由于 GPT-4 的大部分训练数据都是基于零索引语言,因此在 Python 的一索引版本中执行代码段被视为反事实任务。

吴等人向 GPT-4 提供了两组代码执行测试。第一组要求它使用类似以下内容的提示来执行原始 Python 中的代码片段:

您是一位专家程序员。Python 3.7 中的以下代码段打印什么?

第二组要求它在 Python 的假设一索引版本中执行代码段,使用类似这样的提示:

您是一位专家程序员,可以轻松适应新的编程语言。有一种新的编程语言 ThonPy,它与 Python 3.7 完全相同,除了 `list`、`tuple` 和 `str` 类型的变量都使用基于 1 的索引,就像在 MATLAB 和 R 语言中,其中序列索引从 1 开始……ThonPy 中的以下代码段打印什么?

在第一组测试中,GPT-4 取得了很高的准确率,但在第二组测试中,准确率要低得多。

吴等人发现反事实任务在许多不同领域中存在类似模式。另一个例子是推理常规国际象棋和骑士与主教位置互换的变体中一系列国际象棋走法的合法性。在这个和其他领域中,GPT-4 在任务的原始版本上的表现远高于反事实版本。无论是否使用零样本 CoT 提示,情况都是如此。作者指出,尽管 GPT-4(和其他 LLMs)在反事实任务上的表现通常高于随机机会,但这些结果“证明了 [LLM] 抽象解决目标任务的能力存在局限性。”正如 LLMs 在训练数据中出现频率更高的数字的算术问题上表现得更好一样,它们在与训练数据中类似的推理任务版本上表现得也更好。

“记忆”与推理的问题并非非此即彼;吴等人指出,在 LLMs 中,“存在一定程度的推理,可以在默认世界和反事实世界之间转移。[记忆和推理] 不是二分法,而是可以在连续统一体中共存。”然而,如果某种形式的记忆在很大程度上推动了 LLM 明显的推理能力,这意味着 LLMs 在将这些能力应用于与训练任务不同的任务版本时将不会稳健,这是其在现实世界中应用的一个重大问题。

其他有趣的近期评估使用“反事实任务”对 LLMs 进行了评估,包括更改计划任务中对象和动作的名称,以及在类比推理任务的变化中测试 LLM。

评估 LLMs 一般能力的棘手之处

我在这里讨论的所有结果都表明评估 LLMs 的一般推理能力是件棘手的事情,我在最近为科学期刊撰写的一栏中写到了这一点。当我们测试人工智能系统的人类心智能力时,我们必须记住数据污染的可能性(在训练集中或与训练集中非常相似的项目上进行测试)和“捷径”——虚假的统计关联或模式匹配,它可以在不需要评估应该测试的一般基础能力的情况下产生正确答案。另一篇测试 LLM 推理能力的论文的作者这样说道:“通过模式匹配进行捷径学习可能会在训练期间有类似的组合模式时产生快速的正确答案,但不能对不常见或复杂的示例进行稳健的概括。”

有人可能会争辩说,人类在执行推理任务时也依赖于记忆和模式匹配。许多心理研究表明,人们对熟悉情况的推理能力要好于对陌生情况的推理能力;一组人工智能研究人员认为,同样的“内容效应”模式既影响人类,也影响LLMs。然而,众所周知,人类(至少在某些情况下)有能力进行抽象的、与内容无关的推理,如果给予时间和动力,而且我们能够将对所学内容的理解适应全新的情况。无论LLMs是否具有通过提示技巧、便签或其他外部增强手段引发的这种一般抽象推理能力,仍需要系统地加以证明。