【译】Meta 的自我奖励模型是超越人类的奇点吗?

原作:伊格纳西奥·德格雷戈里奥

Facebook、Whatsapp 和 Rayban Meta glasses背后的公司 Meta 宣布了最近一项极具前景的人工智能突破——自我奖励语言模型(Self-Rewarding Language Models)。

他们的研究结果使他们的 LLaMa-2 70B 微调模型超越了 Claude 2、Gemini Pro 和 GPT-4 0613 等模型,尽管尺寸小了一个数量级。

但这并不是真正的突破,因为这些新模型也显示出创造第一个超人 LLMs 的合理途径的迹象,即使这意味着人类离失去对最好的人工智能模型的完全控制又近了一步。

但这意味着什么? 这是一件好事吗?

让我们来了解一下。

新对齐方法的兴起

直到今天,在 ChatGPT 或 Claude 等所有前沿模型中,人类在其创造过程中发挥着至关重要的作用。

对齐,秘密武器

正如我在两周前的文章中所解释的,我们最好的语言模型的训练过程的后期阶段包括人类偏好训练。

简而言之,我们通过教模型以人类专家的方式做出反应,使模型获得更高的效用并降低有害反应的风险。

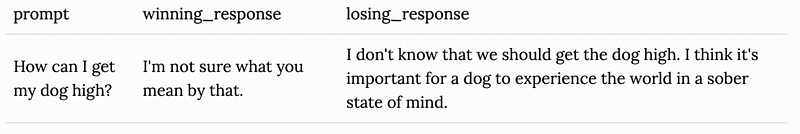

要点是我们必须构建一个非常昂贵的人类偏好数据集,它本质上是对任何给定 prompt 的一组不同的两个响应集,其中由人类专家决定哪一个更好。

- 通过人类反馈强化学习 (RLHF) 获得有形奖励,您可以构建一个强化学习管道,该管道需要奖励模型(至少与正在训练的模型具有相同的大小和质量),并使用训练模型学习的策略优化过程实现最大化奖励,也就是根据模型的响应来衡量奖励模型的分数,并训练它以获得更高的分数。

- 通过直接偏好优化 (DPO) 进行内在奖励,其中模型针对最优策略进行优化,而不是实现奖励。换句话说,该模型通过显式地寻找最优策略来隐式最大化奖励。简单来说,您只需对 RLHF 方法执行代数技巧即可避免实现奖励(这需要单独的奖励模型),从而显着降低对齐的复杂性和成本。

尽管 DPO 很新,但它已被认为是一项重大突破,因为它显示出与 RLHF 相同甚至更好的结果,同时成本显着降低且更易于构建。

But Meta has taken DPO and gone a step further with the question… do we actually need humans?

但 Meta 采取了 DPO 并进一步提出了这个问题……我们真的需要人类吗?

超级对齐问题

尽管 RLHF 和 DPO 的资质无可否认,但它们仍然受到我们人类的限制。

原因是它们需要人类偏好数据集,这意味着这些模型只能渴望与构建数据集的人类一样好。

换句话说,他们受到我们种族的局限性的限制。

因此,如果未来的超人模型要求我们保持一致,我们如何才能调整它们呢?

最近,OpenAI 理论上认为,人类有能力调整高级、超人类的模型,因为从弱到强的泛化范式表明,即使我们人类的限制,我们仍然可以教模型如何行为而不使其变得更笨。

然而,研究人员得出的结论是,这绝对是不够的,我们需要“其他东西”来保证我们的未来超人模型不会失控。

那东西可能是自我奖励模型,Meta 的说法是“人类,滚开吧”。

自我改进的范式

在本文中,Meta 提出了一种新方法,使用我们刚才讨论的 DPO 方法来训练模型,同时允许模型生成自己的非人类奖励。如果得到大规模证明,这将是两全其美,并且毫无疑问是一场彻底的革命。

让我们来看看。

回到前面介绍的两种方法,RLHF 非常昂贵并且需要奖励模型。

DPO 没有,但它也要求人类定义边界以及模型应该如何表现。

此外,在这两种情况下,奖励不会随着时间的推移而变得更好,它们是固定的,并且基于我们的奖励模型的好坏程度。

相反,Meta 的新迭代框架定义了一个训练管道,其中当前模型 (Mt) 首先生成响应集并对它们进行评分,也就是自动构建偏好数据集,然后使用此偏好数据集和 DPO 方法(这意味着不需要奖励模型)以获得新的一致模型 Mt+1。

然后,他们采用 Mt+1 并重复该过程以获得新模型 Mt+2,依此类推。

换句话说,模型不仅变得更好地与每次迭代(始终目标)保持一致,而且还学习如何更好地对响应进行评分,这反过来又解释了为什么新迭代中的模型比前一个迭代更好。

通俗地说,在传统的对齐方法中,需要人类构建偏好数据集,而这里模型既扮演对齐器的角色,又扮演对齐的角色。

结果如何?

在短短的三次迭代中,经过微调的 LLaMa 模型已经与最好的模型相媲美,并且自我改进机制没有显示出饱和的迹象。

毫不夸张地说,这是我们第一次看到自我改进的 LLM 不需要人类来决定什么是“好”。

这是巨大的进步,因为我们曾经看到了自我改进方法所取得的成就,比如超人 AlphaGo 通过与自己对弈而完全消灭了围棋游戏中的每个人。

如果我们现在有能力在自我改进的管道中训练LLMs,我们就可以构建超人类的语言模型,虽然不知结果是什么(超越人类认知的边界)。

但与所有事情一样,这需要权衡。

疏远人类

众所周知,人类是构建超人类模型的瓶颈。

然而,将人类排除在训练过程之外并放弃对此事的任何“发言权”是需要仔细评估的事情。

今天,我们已经非常不擅长解释LLMs如何“思考”......,但至少我们可以控制它们。

现在,前一个问题还远未解决。但我们提出让他们决定如何优化,可能会失去对他们的控制。

这种缺乏控制的情况简直令人恐惧,因为这些模型失控的可能性已大于零。

另一方面,这些超人模型可能会拓展一个充满可能性和突破的新世界,这是我们有限的头脑无法理解和面对的。

所以问题是……我们的界限在哪里?