论文翻译:2020_DARCN_A Recursive Network with Dynamic Attention for Monaural Speech Enhancement

论文地址:基于动态注意的递归网络单耳语音增强

论文代码:https://github.com/Andong-Li-speech/DARCN

引用格式:Li, A., Zheng, C., Fan, C., Peng, R., Li, X. (2020) A Recursive Network with Dynamic Attention for Monaural Speech Enhancement. Proc. Interspeech 2020, 2422-2426

摘要

听觉动态注意理论已经证明,对于连续语音加工,动态注意有助于优先加工。据此,我们提出了一种动态注意和递归学习相结合的单声道语音增强框架DARCN。除了主干降噪网络外,我们还设计了一个独立的子网络,它自适应地产生衰减分布来控制整个主干网络中的信息流。引入递归学习,通过多阶段网络来动态减少可训练参数的数量,其中每一阶段的中间输出用记忆机制进行精化。通过这样做,可以获得更灵活和更好的估计。我们在TIMIT语料库上进行了实验。实验结果表明,提出的体系结构在PESQ和STOI得分方面都比目前最先进的模型获得了一致更好的性能

关键词:单声道语音增强、递归学习、注意力U-Net、动态注意力

1 引言

在实际环境中,纯净语音经常受到背景干扰的污染,这可能会显著降低自动语音识别[1]、说话人验证[2]和助听器[3]的性能。单声道语音增强的目的是在只有一个麦克风的情况下,从混合语音中提取目标语音[4]。近年来,由于深神经网络(DNNs)在建模复杂非线性方面的优越性能,即使在高度非平稳的噪声环境中,DNNs也显示出了良好的单耳语音增强性能[5]。典型的基于DNN的方法可以根据估计目标分为两类,一类是基于掩蔽的方法[6],另一类是基于谱映射的方法[7]

传统的DNN通常采用全连接(FC)层来降低噪声[6,7]。对于撞击的说话人类型化问题,陈等人提出了自己的看法。提出利用堆叠式长短期记忆(SLSTM)[8],它明显优于DNN。最近,各种具有复杂拓扑结构的卷积神经网络(CNNs)被提出[9,10,11,12],它们可以减少可训练参数的数量。最近,Tan et al.将卷积自动编码器(CAE)[13]和LSTM相结合,提出了卷积循环神经网络(CRN)[14],其中CAE帮助学习时频(T-F)模式,而LSTM有效地覆盖了动态序列相关性

最近提出了各种拓扑结构比较复杂的模型[10,11,12,14],这些模型的性能都得到了改善,但对于后面的两个方面,它们仍有一定的局限性。一方面,为了满足低延迟的要求,参数的数量往往受到部分限制,这严重限制了网络的深度。另一方面,深度的增加更有可能导致梯度消失问题。最近提出了渐进式学习[15,16],它将映射过程分解为多个阶段,实验结果表明,通过在不同阶段之间共享序列建模模块,大大减少了可训练参数的数量,并有效地保持了性能。基于这个概念,递归学习[17]是通过在多个阶段重用网络而提出的,每个阶段的输出通过记忆机制联系起来。它在不引入额外参数的情况下,进一步减轻了参数负担,加深了网络。

人类倾向于通过动态神经元电路产生适应性注意,以感知复杂的环境[18],这也可以由听觉动态参与连续语音处理的记忆[19,20,21]来描述。例如,当一个人听到来自真实环境的话语时,占主导地位的噪声成分越多,就需要越多的神经网络注意来弄清意思,反之亦然。这一现象揭示了听觉知觉系统的动力机制。受生理现象的启发,我们提出了一种将动态注意和递归学习相结合的新型网络DARCN,不同于以往的网络[10,11,12,14]为该任务设计的单一复杂网络,该框架由一个主子网络和一个辅助子网络并行组成,其中一个是降噪模块(NRM),另一个是注意力生成模块(AGM),该框架的工作流程如下:在每个中间阶段,将噪声特征和上一阶段的估计值结合到当前输入中。采用AGM生成注意集,然后通过逐点卷积和Sigmoid函数将该注意集应用于NRM。这样,AGM实际上是一种感知模块,可以灵活地调整NRM的权重分布,从而获得更好的噪声抑制性能。据我们所知,这是第一次将动态注意机制引入到特定任务中。

论文的其余部分结构如下。第2节阐述了这个问题。网络的体系结构在第3节中说明。第4节是数据集和实验设置。第五节给出了研究结果和分析,第六节得出了一些结论。

2 公式与符号

在时域中,噪声信号可以建模为$x(n)=s(n)+d(n)$,其中$n$是离散时间索引。使用短时傅立叶变换(STFT),可以进一步将其重写为:

$$公式1:X_{k,l}=S_{k,l}+D_{k,l}$$

其中$X_(k,l)$,$S_{k,l}$,$D_{k,l}$分别代表带噪语音、纯净语音和噪声,$k$代表的是频率bin的索引,$l$代表的是帧索引。在本研究中,网络用于估计频谱的幅度(MS),然后将其与噪声相位相加以恢复估计的频谱,并使用逆短时傅立叶变换(ISTFT)在时域中重建波形。

为简单起见,我们定义了本文中使用的主要记号。$|X|\in R^{T*F}$,$|S|\in R^{T*F}$,$|\tilde{S}^l|\in R^{T*F}$,$|\tilde{S}|\in R^{T*F}$分别表示噪声谱大小、纯净谱大小、第$l$级估计谱大小和最终估计纯净谱大小。T和F分别表示时间步长和特征长度。当使用递归学习时,上标$l$表示阶段索引,阶段数记为$Q$。

3 结构说明

3.1 分段循环神经网络

分段递归神经网络(SRNN)在文献[17]中首次提出,它是递归学习的核心组成部分。它可以利用记忆机制来聚合不同阶段的信息,记忆机制由两部分组成,即2维 Conv block和Conv-RNN block。第一部分尝试将输入的特征投影到一个潜在的表示中,然后用Conv-RNN更新当前阶段的状态。假设第$l$阶段的 2-D Conv 和 Conv-RNN 的输出分别表示为$\hat{h}^l$和$h^l$,则 SRNN 的推理公式为

$$公式2:\hat{\mathbf{h}}^{l}=f_{\text {conv }}\left(|\mathbf{X}|,\left|\tilde{\mathbf{S}}^{l-1}\right|\right)$$

$$公式3:\mathbf{h}^{l}=f_{\text {conv_rnn }}\left(\hat{\mathbf{h}}^{l}, \mathbf{h}^{l-1}\right)$$

其中,$f_{conv}$和$f_{conv\_rnn}$分别指2-D Conv和Conv-RNN。在本研究中,采用ConvGRU[22]作为RNN的单元,其计算过程如下:

$$公式4:\mathbf{z}^{l}=\sigma\left(\mathbf{W}_{z}^{l} \circledast \hat{\mathbf{h}}^{l}+\mathbf{U}_{z}^{l} \circledast \mathbf{h}^{l-1}\right)$$

$$公式5:\mathbf{r}^{l}=\sigma\left(\mathbf{W}_{r}^{l} \circledast \hat{\mathbf{h}}^{l}+\mathbf{U}_{r}^{l} \circledast \mathbf{h}^{l-1}\right)$$

$$公式6:\mathbf{n}^{l}=\tanh \left(\mathbf{W}_{n}^{l} \circledast \hat{\mathbf{h}}^{l}+\mathbf{U}_{n}^{l} \circledast\left(\mathbf{r}^{l} \odot \mathbf{h}^{l-1}\right)\right) $$

$$公式7:\mathbf{h}^{l}=\left(\mathbf{1}-\mathbf{z}^{l}\right) \odot \hat{\mathbf{h}}^{l}+\mathbf{z}^{l} \odot \mathbf{n}^{l}$$

其中$W$和$U$表示单元格的权重矩阵。$\sigma (·)$和$tanh(·)$分别表示S型和tanh激活函数。$\circledast $表示卷积运算符,$\odot $是元素乘法。请注意,为了记法方便,忽略了偏差。

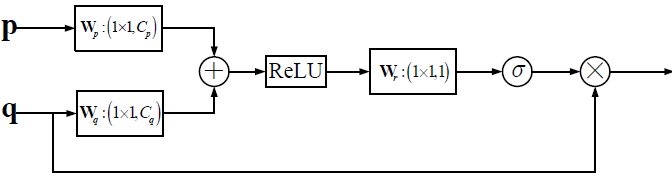

3.2 注意力门

Attention U-Net(AU-Net)最早是在[23]中提出的,用于提高分割相关任务的精度,在卷积编码器和解码器之间插入注意门(AG)。与标准U-Net相比,AU-Net具有自动抑制无关区域和突出重要特征的能力。由于频谱中含有丰富的频率成分,低频区域常以共振峰为主,而高频区域分布稀疏,因此需要区分不同权重的频谱区域,本文采用的AG示意图如图1所示。假设单元的输入为$p$和$q$,其中$p$和$q$分别表示解码层的特征及其在编码层中的对应特征。输出可以计算为:

$$公式8:\mathbf{y}=\mathbf{q} \odot \sigma\left(\mathbf{W}_{r} \circledast \operatorname{ReLU}\left(\mathbf{W}_{p} \circledast \mathbf{p}+\mathbf{W}_{q} \circledast \mathbf{q}\right)\right)$$

其中$W_p$、$W_q$和$W_r$是卷积核。请注意,该单元由两个分支组成,其中一个分支合并两个输入的信息并通过Sigmoid函数生成注意系数,另一个分支复制Q的信息并将系数相乘。在获得AG的输出后,将其与相应解码层沿信道维度的特征级联,作为下一解码层的输入。

图1:NRM采用的注意门结构。P表示解码层的特征,q表示编码层对应的特征。

$W_p$、$W_q$和$W_r$是二维卷积层,其内核大小为$1*1$。$C_p$和$C_q$为$p$和$q$的信道号,每次卷积运算后都使用批归一化

3.3 提出的架构

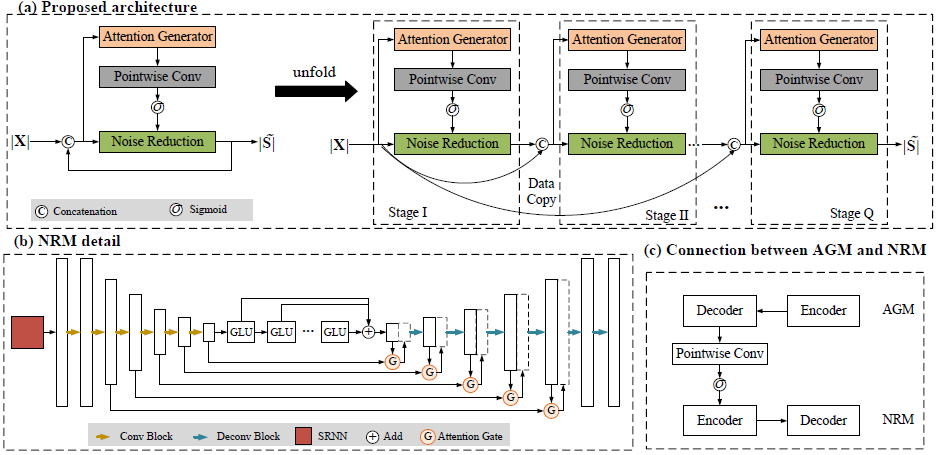

图2:提出的架构的示意图。(a)拟议的结构及其展开结构。该体系结构并行地包含两个部分,即AGM和NRM

(b)NRM的详细结构。(c) AGM和NRM之间的联系

图2-(A)描述了提出的体系结构的概述。它有两个模块,即AGM(Attention Generator Module)和NRM(Noise Reduction Module),这两个模块被设计成在整个过程中交错执行。该体系结构采用递归过程操作,即整个前向流可以分成多个阶段展开。在每一级中,将原始噪声谱和最后一级的估计值连接起来,作为网络输入。它被发送到AGM,生成当前注意力集合,代表当前阶段的注意力分布。随后将其应用于NRM,以控制整个网络中的信息流。NRM也接收输入来估计幅度谱(Magniude Spectrum, MS)。因此,AGM的输出动态地影响了最后阶段对MS的估计,即AGM能够根据来自降噪系统的先前反馈来重新加权注意力分布。

假设AGM和NRM的映射函数分别表示为$G_A$和$G_R$。模型的计算程序如下:

$$公式9:\mathbf{a}^{l}=G_{A}\left(|\mathbf{X}|,\left|\tilde{\mathbf{S}}^{l-1}\right| ; \theta_{A}\right)$$

$$公式10:\left|\tilde{\mathbf{S}}^{l}\right|=G_{R}\left(|\mathbf{X}|,\left|\tilde{\mathbf{S}}^{l-1}\right|, \mathbf{a}^{l} ; \theta_{R}\right)$$

其中,$a^l$是在阶段$l$产生的注意力集合。$\theta_A$和$\theta_R$表示用于AGM和NRM的网络参数。

在本研究中,我们使用一种典型的U-Net[24]拓扑结构来实现AGM,它由卷积编码器和解码器组成。编码器由五层连续的二维卷积组成,每个卷积层之后是批归一化(BN)[25]和指数线性单元(ELU)[26]。通过编码器的通道数为(16,32,32,64,64)。解码器是编码器的镜像表示,除了所有的卷积都被反卷积[27]替换以有效地增大映射大小之外。类似地,通过解码器的信道数是(64,64,32,32,16)。编码器和解码器的核大小、步长分别为(2,5)和(1,2)。类似于U-Net[24],引入了从编码器到解码器部分的跳跃连接来补偿编码过程中的信息丢失。

NRM的详细信息如图2-(B)所示。该算法由SRNN、AU-Net和一系列GLU[10]三部分组成,给定网络的输入大小为T×F×2,161为特征长度,2为输入信道数,SRNN后的输出大小为T×4×64,连续6个卷积块的输出大小为T×4×64。随后将其重塑为T×256。文[10]提出的6个级联GLU被设置为有效地探索上下文关联。将GLU的输出整形为T×4×64,然后送入解码器进行特征扩展和MS估计。AU-Net中编码器和解码器的通道数分别为(16,16,32,32,32,64,64)和(64,32,32,16,16,16,1)。NRM中的核大小和步长与AGM中的设置相同,除了最后一层,它采用逐点卷积,然后是Softplus作为非线性[28]来获得MS。注意,与标准U-Net中的直接跳过连接不同,来自编码器的特征映射在与解码特征连接之前与来自AG的门控系数相乘,这有助于在多个编码层中权衡特征的重要性。

AGM和NRM之间的联系如图2-(C)所示,其中AGM解码器每层中的特征通过逐点卷积和S型函数,并与NRM编码器相应层中的特征相乘。请注意,应用Sigmoid函数将值范围调整为(0,1)。

3.4 损失函数

由于网络经过多级训练,每一级都得到一个中间估计,累积损耗可定义为$L=\sum_{l=1}^{Q}\lambda_lD^l(\tilde{S}^l,S)$,其中$\lambda_l$是每级的加权系数,$D^l(·)$是第$l$级的损耗函数。在本研究中,我们设置$\lambda_l=1$,其中$l=1,...,Q$,即对每个训练阶段给予同样的重视。

4 实验步骤

4.1 数据集

实验是在TIMIT语料库上进行的[29]。分别选取了4856、800和100个纯净话语进行训练、验证和测试。在信噪比为-5dB~10dB,间隔为1dB的情况下建立训练和验证数据集,并在(-5dB,0dB,5dB,10dB)的信噪比条件下对模型进行测试。[17]中使用的130种噪声用于培训和验证。用NOISEX 92的另外5种噪声(BABBLE、F16、F2、M109和白色)来考察网络的泛化能力。所有收集到的噪声首先被串联成一个长向量。在每个混合过程中产生一个随机的切割点,然后在信噪比水平下将其与发音混合,从而分别创建4万、4000、800个噪声-纯净对用于训练、验证和测试。

4.2 基线

在本研究中,选择了四个网络作为基线,分别是SLSTM[8]、CRN[14]、GRN[10]和DCN[12],它们最近都达到了最先进的性能。对于SLSTM,将1024个单元的四个LSTM层叠加在一起,然后是一个FC层,以获得MS。SLSTM的输入包括当前帧和前一帧的拼接。CRN是CNN和LSTM相结合的一种实时体系结构。GRN和DCN是典型的具有门控机制的全卷积网络

4.3 参数设置

所有的声音都以16 kHz的频率采样。应用20ms汉明窗口,相邻帧重叠10ms。采用320点短时傅立叶变换,得到每帧161维的特征向量。所有模型均采用均方误差(MSE)准则进行训练,该准则由Adam[30]优化。学习率初始化为0.001,连续3次验证损失增加时学习率减半,10次验证损失增加时提前停止训练。所有的模型都经过了50个时期的训练。在发声级别将小批量设置为4。在小批量内,时间步长小于最长时间步长的话语用零填充

5 结果和分析

本节使用感知评估语音质量(PESQ)[31]和短时目标清晰度(STOI)得分[32]来评估不同模型的性能

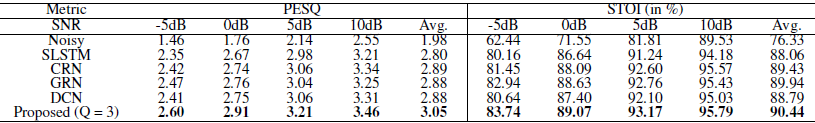

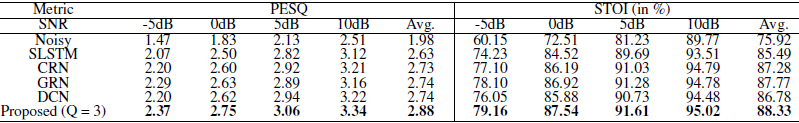

5.1 客观评价

表1和表2分别总结了不同模型在可见和不可见噪声情况下的结果。从这两张表中,可以观察到以下现象。首先,在可见和不可见噪声情况下,CRN、GRN、DCN和所提出的模型始终优于SLSTM。这是因为SLSTM只考虑了序列相关性,而忽略了对频谱恢复至关重要的隐式T-F模式,而且层叠LSTM容易由于梯度消失问题而产生衰减效应,从而限制了性能。其次,与基线相比,提出的体系结构在这两个指标上都有显著的改善。例如,当从CRN到所提出的模型时,对于所看到的案例,PESQ值平均提高了0.16,STOI平均提高了1.01%。在未知情况下也观察到了类似的趋势,表明所提出的模型具有良好的噪声泛化能力。第三,我们观察到GRN和DCN可以达到接近的性能。这可以解释为两个网络具有相似的拓扑,其中膨胀卷积与门控机制相结合用于序列建模。

表1:可见噪声情况下的实验结果。BOLD表示每种情况下的最佳结果。被提出的架构的阶段Q = 3的数量

表2:不可见噪声情况下的实验结果。BOLD表示每种情况下的最佳结果。被提出的架构的阶段Q = 3的数量

5.2 各阶段的影响

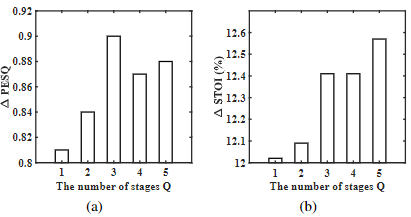

我们研究了阶段Q的影响,如图3所示。当Q≤为3时,随着Q的增加,PESQ值和STOI值都得到了一致的提高。这表明SRNN可以通过记忆机制有效地提高网络的性能。我们还发现,当Q从3增加到5时,PESQ值略有下降,而STOI仍有改善。这是因为使用了基于距离的有损MSE,损失函数和优化过程不能保证两个指标的一致优化,这与[17]中以前的研究是一致的。

图3:q级数的影响(a)不同q级下的PESQ改进(b)不同q级下的STOI改进。

所有的值都是针对未见噪声情况进行评估,并在不同信噪比下进行平均。

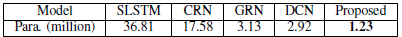

5.3 参数比较

表3总结了不同模型的可训练参数数量。可以看出,与其他基线相比,提出的模型极大地减少了可训练参数的数量。这证明了所提出的体系结构的卓越的参数效率。

表3:不同模型之间可训练参数个数。单位是百万。BOLD表示最低可训练参数。

6 结论

在复杂的情景中,人们通常会动态地调整注意力以适应连续说话环境的变化。基于这种神经现象,我们提出了一种动态注意和递归学习相结合的框架。为了自适应地控制降噪网络的信息流,设计了一个单独的子网络来更新每个阶段的注意力表示,并将其应用于主网络。由于采用递归范式进行训练,网络在多个阶段被重用。因此,我们逐步实现了精细化的估算。实验结果表明,与已有的强模型相比,该模型在进一步降低参数负担的同时,取得了更好的性能。

7 参考文献

[1] A. Graves, A.-r. Mohamed, and G. Hinton, Speech recognition with deep recurrent neural networks, in 2013 IEEE international conference on acoustics, speech and signal processing. IEEE, 2013, pp. 6645 6649. [2] D. A. Reynolds, T. F. Quatieri, and R. B. Dunn, Speaker verification using adapted gaussian mixture models, Digital signal processing, vol. 10, no. 1-3, pp. 19 41, 2000. [3] H. Dillon, Hearing aids. Hodder Arnold, 2008. [4] P. C. Loizou, Speech enhancement: theory and practice. CRC press, 2013. [5] D. Wang and J. Chen, Supervised speech separation based on deep learning: An overview, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 26, no. 10, pp. 1702 1726, 2018. [6] Y. Wang, A. Narayanan, and D. Wang, On training targets for supervised speech separation, IEEE/ACM transactions on audio, speech, and language processing, vol. 22, no. 12, pp. 1849 1858, 2014. [7] Y. Xu, J. Du, L.-R. Dai, and C.-H. Lee, A regression approach to speech enhancement based on deep neural networks, IEEE/ACM Transactions on Audio, Speech, and Language Processing, vol. 23, no. 1, pp. 7 19, 2014. [8] J. Chen, Y. Wang, S. E. Yoho, D. Wang, and E. W. Healy, Large-scale training to increase speech intelligibility for hearingimpaired listeners in novel noises, The Journal of the Acoustical Society of America, vol. 139, no. 5, pp. 2604 2612, 2016. [9] S.-W. Fu, T.-Y. Hu, Y. Tsao, and X. Lu, Complex spectrogram enhancement by convolutional neural network with multi-metrics learning, in 2017 IEEE 27th International Workshop on Machine Learning for Signal Processing (MLSP). IEEE, 2017, pp. 1 6. [10] K. Tan, J. Chen, and D. Wang, Gated residual networks with dilated convolutions for monaural speech enhancement, IEEE/ACM transactions on audio, speech, and language processing, vol. 27, no. 1, pp. 189 198, 2018. [11] A. Pandey and D. Wang, TCNN: Temporal convolutional neural network for real-time speech enhancement in the time domain, in ICASSP 2019-2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2019, pp. 6875 6879. [12] S. Pirhosseinloo and J. S. Brumberg, Monaural speech enhancement with dilated convolutions, Proc. Interspeech 2019, pp. 3143 3147, 2019. [13] V. Badrinarayanan, A. Handa, and R. Cipolla, Segnet: A deep convolutional encoder-decoder architecture for robust semantic pixel-wise labelling, arXiv preprint arXiv:1505.07293, 2015. [14] K. Tan and D. Wang, A convolutional recurrent neural network for real-time speech enhancement. in Interspeech, 2018, pp. 3229 3233. [15] T. Gao, J. Du, L.-R. Dai, and C.-H. Lee, SNR-Based Progressive Learning of Deep Neural Network for Speech Enhancement. in INTERSPEECH, 2016, pp. 3713 3717. [16] A. Li, C. Zheng, and X. Li, Convolutional Recurrent Neural Network Based Progressive Learning for Monaural Speech Enhancement, arXiv preprint arXiv:1908.10768, 2019.[17] A. Li, C. Zheng, R. Peng, and X. Li, A Time-domain Monaural Speech Enhancement with Recursive Learning, arXiv preprint arXiv:2003.09815, 2020. [18] S. Anderson, T. White-Schwoch, A. Parbery-Clark, and N. Kraus, A dynamic auditory-cognitive system supports speech-in-noise perception in older adults, Hearing research, vol. 300, pp. 18 32, 2013. [19] M. R. Jones, Time, our lost dimension: toward a new theory of perception, attention, and memory. Psychological review, vol. 83, no. 5, p. 323, 1976.

[20] N. Ballas, L. Yao, C. Pal, and A. Courville, Delving deeper into convolutional networks for learning video representations, arXiv preprint arXiv:1511.06432, 2015. [21] O. Oktay, J. Schlemper, L. L. Folgoc, M. Lee, M. Heinrich, K. Misawa, K. Mori, S. McDonagh, N. Y. Hammerla, B. Kainz et al., Attention u-net: Learning where to look for the pancreas, arXiv preprint arXiv:1804.03999, 2018. [22] O. Ronneberger, P. Fischer, and T. Brox, U-net: Convolutional networks for biomedical image segmentation, in International Conference on Medical image computing and computer-assisted intervention. Springer, 2015, pp. 234 241. [23] S. Ioffe and C. Szegedy, Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift, in International Conference on Machine Learning, 2015, pp. 448 456. [24] D.-A. Clevert, T. Unterthiner, and S. Hochreiter, Fast and accurate deep network learning by exponential linear units (elus), arXiv preprint arXiv:1511.07289, 2015. [25] H. Noh, S. Hong, and B. Han, Learning deconvolution network for semantic segmentation, in Proceedings of the IEEE international conference on computer vision, 2015, pp. 1520 1528. [26] H. Zheng, Z. Yang, W. Liu, J. Liang, and Y. Li, Improving deep neural networks using softplus units, in 2015 International Joint Conference on Neural Networks (IJCNN). IEEE, 2015, pp. 1 4. [27] J. S. Garofolo, L. F. Lamel, W. M. Fisher, J. G. Fiscus, and D. S. Pallett, DARPA TIMIT acoustic-phonetic continous speech corpus CD-ROM. NIST speech disc 1-1.1, NASA STI/Recon technical report n, vol. 93, 1993. [28] D. P. Kingma and J. Ba, Adam: A method for stochastic optimization, arXiv preprint arXiv:1412.6980, 2014. [29] I.-T. Recommendation, Perceptual evaluation of speech quality (PESQ): An objective method for end-to-end speech quality assessment of narrow-band telephone networks and speech codecs, Rec. ITU-T P. 862, 2001. [30] C. H. Taal, R. C. Hendriks, R. Heusdens, and J. Jensen, A shorttime objective intelligibility measure for time-frequency weighted noisy speech, in 2010 IEEE international conference on acoustics, speech and signal processing. IEEE, 2010, pp. 4214 4217.

浙公网安备 33010602011771号

浙公网安备 33010602011771号