论文翻译:2021_DNS_1th:Decoupling magnitude and phase optimization with a two-stage deep network

论文地址:两阶段深度网络的解耦幅度和相位优化

引用格式:Li A, Liu W, Luo X, et al. ICASSP 2021 deep noise suppression challenge: Decoupling magnitude and phase optimization with a two-stage deep network[C]//ICASSP 2021-2021 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP). IEEE, 2021: 6628-6632.

摘要

在真实声学环境下恢复被各种噪声污染的语音信号仍然是一项艰巨的挑战。 为此,我们提出了一种新的复杂应用去噪系统,该系统主要由两个管道组成,即两级网络和一个后处理模块。 提出第一个管道来解耦优化问题 w.r.t. 幅值和相位,即第一阶段只估计幅值,第二阶段进一步细化。 第二个管道旨在进一步抑制剩余的非自然失真噪声,这被证明可以充分提高主观质量。 在 ICASSP 2021 深度噪声抑制 (DNS) 挑战赛中,我们提交的系统在使用 ITU-T P.808 框架的平均意见得分 (MOS) 方面在实时轨道 1 中排名第一。

关键词:语音增强,两阶段,实时,后处理、复数域

1 引言

在实际场景中,环境噪声和房间混响可能会对自动语音识别(ASR)系统、视频/音频通信和助听设备的性能产生负面影响。针对撞击中存在的这些问题,人们已经提出了许多语音增强(SE)算法来有效地估计纯净的语音,同时充分抑制噪声分量[1]。近年来,深度神经网络(DNNs)向SE研究快速发展[2,3]。通过数据驱动的范例,SE任务可以表示为一个监督学习问题,网络试图在时频域中揭示噪声特征和清洁目标之间复杂的非线性关系。

在以往的研究中,只研究幅度的恢复,而直接结合噪声相位进行语音波形重构[2,3]。究其原因,有两方面的原因:其一,由于其结构不清晰,相位被认为是很难估计的。另一方面,以前的文献报道,相位的恢复并没有带来言语知觉质量的显著提高[4]。最近,相位在提高语音质量和清晰度方面的重要性不断受到重视[5]。

- Williamson et.al.[6]提出了复数比率掩模(CRM),该掩模既适用于实部,也适用于虚部,在理论上可以很好地估计幅值和相位。

- 然后,提出了复数谱映射技术,并要求网络直接估计RI(real and imaginary)谱,据报道,这种方法比基于掩蔽的方法获得了更好的语音质量[7]。

- 最近,基于时域方法开始蓬勃发展,其中原始波形既是输入又是输出[8]。这样就有效地避免了显式相位估计问题。

虽然第1、3方法在客观测试中都取得了令人印象深刻的性能,但我们求助于复数域方法,因为我们发现在INTERSPEECH 2020深度噪声抑制(DNS)挑战中,基于复数域的方法获得了比时域方法更好的平均优化分数(MOS)。我们将其原因归因于T-F 域比时域波形能更好地区分语音和噪声。

为了应对ICASSP 2021 DNS挑战赛[9]中更具挑战性的声学环境中的降噪问题,我们提出了一种新的SE系统,称为具有低复杂度后处理方案的两级复数网络(TSCN-PP)。它主要由两条管道组成。首先,设计了一种新颖的两级网络模型,它由两个子网络组成,即粗略幅值估计网络(CME-Net)和复数谱细化网络(CSR-Net)。

- CME-Net 对频谱幅度进行粗略估计,然后将其与噪声相位相耦合,得到粗略的复数谱。

- CSR-Net 接收粗估计谱和带噪语音谱作为输入来细化复谱。值得注意的是,CSR-Net的作用是双重的,

- 首先,它不是直接估计纯净语音的频谱,而是只捕获残差细节,即将估计的细节与输入相加,得到最终的细化频谱。

- 其次,由于仍有部分噪声成分存在,CSR-Net有助于进一步抑制残留噪声。

对于第二条管道,我们提出了低复杂度的后处理(PP)模块来进一步降低非自然残余噪声,这被证明是提高主观语音质量的重要步骤。

我们从两个角度解释了算法的设计原理。首先,由于单级网络的映射能力有限,往往不能很好地完成相对困难的任务,最近,文献[10,11,12]揭示了在许多任务中多阶段训练优于单阶段方法,如图像去噪和语音分离。其次,由于DNN的非线性特性,当测试集与训练条件不匹配时,可能会引入一些非线性失真。例如,由于SE模型的训练往往带有大范围的合成噪声-纯净语音对,当训练好的模型应用于更复杂的实际环境时,可能会引入一些不可取的非线性失真,从而大大降低了主观等价性。因此,若要避免可听语音失真,有必要采用PP模块进一步抑制残余噪声。在我们的主观实验中,我们确实发现,在使用PP后,整体主观素质可以得到持续的提高。

论文的其余部分结构如下。在第二节中,给出了所提出的两级网络模型和后处理模型。第三节给出了实验设置,第四节给出了实验结果,第五节给出了一些结论。

2 提出的TSCN-PP

2.1 符号

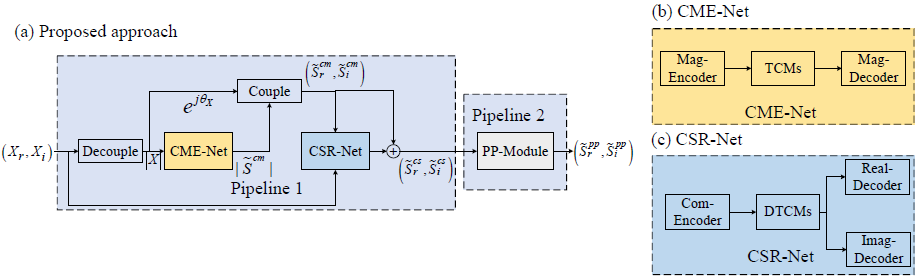

我们提出的算法框架如图1所示。本文将$(X_\tau ,X_i)$表示为带噪语音的复数谱,而$\left(\tilde{S}_{r \mid i}^{c m}, S_{r \mid i}\right)$、$\left(\tilde{S}_{r \mid i}^{c s}, S_{r \mid i}\right)$和$\left(\bar{S}_{r \mid i}^{p p}, S_{r \mid i}\right)$分别表示CME-Net、CSR-Net和PP-模块估计的实部和虚部。此外,还定义CME-Net、CSR-Net和PP-模块的映射函数为$F_{cm}$、$F_{cs}$和$F_{pp}$,参数集分别为$\Phi_{cm}$、$\Phi_{cs}$和$\Phi_{pp}$。

图1:处理流程。(a) 提出的带有后处理的两阶段框架;(b) CME-Net的网络框架;(c) CSR-Net的网络框架

2.2 两阶段网络

如图1所示,所提出的两级网络,即TSCN,由两个主要部分组成,即CME-Net和CSR-Net,CME-Net以噪声频谱的幅值作为输入特征,以纯净语音频谱的幅值作为输出,再与噪声相位耦合得到粗糙的复数谱(coarse complex spectrum, CSS),即$\left(\widetilde{S}_{r}^{c m}, \widetilde{S}_{i}^{c m}\right)$,在第二阶段,将CCS和原始噪声频谱连接起来作为CSR-Net的输入,然后网络估计残差频谱,将其直接添加到CCS中以获得精炼的对应物。 具体来说,在第一阶段 ,仅优化幅度并且可以去除大多数噪声分量。 在第二阶段,网络只需要修改相位,同时进一步细化幅度。 简而言之,计算过程是:

$$公式1:\left|\tilde{S}^{c m}\right|=\mathcal{F}_{c m}\left(|X| ; \Phi_{c m}\right)$$

$$公式2:\left(\tilde{S}_{r}^{c s}, \tilde{S}_{i}^{c s}\right)=\left(\tilde{S}_{r}^{c m}, \tilde{S}_{i}^{c m}\right)+\mathcal{F}_{c s}\left(\tilde{S}_{r}^{c m}, \tilde{S}_{i}^{c m}, X_{r}, X_{i} ; \Phi_{c s}\right)$$

其中,$\tilde{S}_{r}^{c m}=\Re(|\tilde{S}^{c m}| e^{j \theta_{X}}) $,$\tilde{S}_{i}^{c m}=\Im(|\tilde{S}^{c m}| e^{j \theta_{X}})$。

CME-Net和CSR-Net都采用与[13]相似的网络拓扑,包括门控卷积编码器、解码器和堆叠的时间卷积模块(Temporal Convolution Modules,TCM)[14]。编码器用来提取频谱特征,解码器用来重构频谱。注意,这里不使用长短期记忆(LSTM)作为序列建模的基本单元,而是使用堆叠的TCM来更好地捕获短期和长期序列依赖关系。

如图2(a)所示,在先前的TCM设置中,给定大小为(256,T)的输入,其中256和T分别表示通道数和时间步长,TCM首先使用1×1-Conv将输入投影到较高的通道空间,即512,然后应用深度扩张卷积(DD-Conv),输出1×1-Conv重新变为256。为便于澄清,省略了所有norm layers和激活函数。为了进一步降低参数负担,我们在这里提出了两种类型的轻量级TCM,如图2(b)-(c)所示。在图2(b)中,1×1-Conv将通道数压缩为64,然后是门控D-Conv,即将一个常规扩张卷积与另一个扩张分支相乘,其中应用Sigmoid函数将输出值缩放为(0,1)。2(c)是DTCM的改进版本,它应用了两个门D-Conv,并将来自两个分支的输出连接在一起。并不是说两个分支之间的扩张率是互补的,即如果一个分支的扩张率是$2^r$,那么另一个扩张率就变成$2^{M-r}$,这里M=5。理论上,大的扩张率意味着可以捕获长期相关性,而小的扩张率可以学习局部序列相关性。因此,这两个分支在训练过程中既建立了短序列相关性,又建立了长序列相关性。在本研究中,我们采用图2(c)中的TCM作为CME-Net的基本单元,而将图2(c)中的DTCM作为CSR-Net的基本单元。

图2所示。不同类型 TCM 之间的比较,为了说明方便,忽略了规范层和激活层。

(a) 原始TCN。 (b) 提议的轻量级TCM。 (c) 提议的轻量级双 TCM (DTCM)

2.3 损失函数

对于两级网络,采用以下策略对网络进行训练。首先,我们分别训练具有以下损失的CME-Net:

$$公式3:\mathcal{L}_{c m}=\left\|\left|\bar{S}^{c m}\right|-|S|\right\|_{F}^{2}$$

然后,加载CME-Net的预训练模型,并与CSR-Net进行联合优化,给出如下结果:

$$公式4:\mathcal{L}=\mathcal{L}_{c s}^{R I}+\mathcal{L}_{c s}^{M a g}+\lambda \mathcal{L}_{c m}$$

$$公式5:\mathcal{L}_{c s}^{R I}=\left\|\tilde{S}_{r}^{c s}-S_{r}\right\|_{F}^{2}+\left\|\tilde{S}_{i}^{c s}-S_{i}\right\|_{F}^{2}$$

$$公式6:\mathcal{L}_{c s}^{M a g}=\left\|\sqrt{\left|\tilde{S}_{r}^{c s}\right|^{2}+\left|\tilde{S}_{i}^{c s}\right|^{2}}-\sqrt{\left|S_{r}\right|^{2}+\left|S_{i}\right|^{2}}\right\|_{F}^{2}$$

其中$L_{cm}$和$L^{*}_{cs}$分别表示CME-Net和CSR-Net的损失函数。$\lambda$指的是权重损失系数,本文将其设置为0.1。注意,这里考虑了CSR-Net的两种类型的损失,即RI损失和幅值损失。这种灵感可以从两个方面来解释。首先,当这些分量逐渐优化时,震级一致性不能保证,即估计的震级可能偏离其最优优化路径[15]。其次,实验表明,当设置幅值约束时,可以获得一致的PESQ改善[16],这有助于语音质量。

2.4 后处理模块

在MSE作为损失函数的情况下,尽管语音质量有了显著的改善,但残余噪声分量可能会变得非常不自然,这可能会降低主观质量。为了通过深度学习方法提高增强语音的自然度,人们提出了许多函数,如尺度不变的信噪比(SI-SDR)[17]、语音质量评价的感知度量(PMSQE)[18]和具有残差噪声控制的MSE[19]。这些损失函数可以使残余噪声听起来比MSE更自然,从而在一定程度上改善了语音质量。

本文受[20,21,22]的启发,采用类似于[21]的极低复杂度的深度学习方法来进一步抑制管道1输出中的残留噪声。而不是使用 深度学习映射gain直接在管道 1 的估计纯净语音频谱上,我们使用该增益作为语音存在概率 (speech presence probability,SPP) 的估计来递归地估计噪声功率谱密度 (noise power spectral density,NPSD)。 使用估计的 NPSD,引入 MMSE-LSA 估计器来计算最终增益,然后用于抑制残余噪声。 为了进一步提高所提出的 PP 方案的鲁棒性,我们在估计 NPSD 之前使用基于倒谱的预处理方案来抑制谐波分量。 通过这样做,在大多数情况下可以避免 NPSD 的高估问题。

3 实验

3.1 数据集

在这项研究中,我们首先探索了 WSJ0-SI84 数据集 [23] 上不同模型之间的性能,以验证所提出的两阶段网络的性能优势。然后该模型连同后处理一起使用 ICASSP 2021 DNS-Challenge 数据集进行训练和评估,以评估其在更复杂和真实的声学场景中的性能。对于 WSJ0-SI84、5428 和 957 个纯净的话语,分别选择了 77 个说话者来建立用于训练和验证的数据集。对于测试集,选择了 150 个话语。请注意,测试集中的说话者信息未经训练。我们从 DNS-Challenge2 中随机选择 20,000 个噪声,形成一个 55 小时的噪声集用于训练。为了测试,选择了 4 个具有挑战性的噪声,即来自 NOISEX92 [24] 的 babble、cafe 和 white 以及来自 CHIME3数据集 [25] 的 factory1。在这项研究中,我们分别创建了 50,000 和 4000 个噪声清洁对用于训练和验证,SNR 范围从 -5dB 到 0dB。训练总时长约为100小时。模型评估选择了5个SNR,分别为-5dB、0dB、5dB、10dB和15dB。

对于ICASSP 2021 DNS Challenge,考虑的声学场景比INTERSPEECH 2020 DNS Challenge相对更复杂,包括混响效果、跨语言、情感和歌唱案例。 然而,许多提供的话语相对嘈杂,这会严重影响网络的训练收敛。 结果,我们丢弃了质量明显较差的话语。 总的来说,我们生成了一个持续时间为 517 小时的大型训练集,其中使用了大约 65,000 个提供的噪声,SNR 范围从 -5dB 到 25dB。 此外,考虑到真实环境中的混响效果,大约 30% 的话语在与不同的噪声信号混合之前与 100,000 个提供的合成和真实房间脉冲响应 (RIR) 进行卷积。 在本研究中,混响时间 T60 的范围为 0.3 到 1.3 秒。

3.2 超参数设置

所有的声音采样在16kHz。采用20ms Hanning窗口,连续帧之间重叠50%。利用320点FFT提取光谱特征。两个模型都由Adam[26]优化。当单独训练第一个模型时,初始化学习率(LR)设置为0.001。当两个模型联合训练时,LRs分别设置为0.001和0.0001。batch size在语音级别设置为8。注意,为了减少DNS-Challenge数据集的训练时间,我们直接对WSJ0-SI84上预训练的模型进行微调,以帮助模型快速适应新的数据集。

3.3 对比模型

在本研究中,我们将提出的两阶段网络与另一个先进的5个基线,即CRN [27], DARCN [12], TCNN [28], GCRN[7]和DCCRN[29]进行比较,分别给出如下:

- CRN:它是T-F域中的因果卷积循环网络。编码器和解码器分别采用5个卷积块和5个反卷积块。序列建模采用2个LSTM层,1024个单元。在保持噪声相位不变的情况下,只估计幅度。我们在[27]中保留了最好的配置,参数数量为17.58M。

- DARCN:它是T-F域中的因果卷积网络,将递归学习和动态注意机制结合在一起。将当前的估计输出反馈给输入,然后再利用网络来细化下一阶段的估计。我们将最佳配置保存在[12]中,参数个数为1.23M。

- TCNN:它是在时域定义的因果编码-TCMs-解码器拓扑。原始波形既是输入波形,也是输出波形。我们在[28]中保持相同的配置,参数的数量为5.06M。

- GCRN;它是CRN的高级版本,可以估计震级和相位。除了使用两个解码器进行RI估计外,它与CRN具有类似的拓扑结构。我们保持[7]中的最佳配置,参数数为9.06M

- DCCRN:在Interspeech 2020 DNS-Challenge实时跟踪中排名第一,其中CNN和RNN采用复数运算,使用SI-SDR作为损失函数。我们保持了[29]中的最佳配置,参数数量为3.72M。

- TSCN:编解码器部分设置5个(解卷积)块,每层中间通道数为64个,时频轴上核大小和步长分别为(2,3)和(1,2)。对于CME-Net,18个轻质TCM用于序列学习,而12个DTCM用于CSR-Net3。CME-NET的参数个数为1.96M,TSCN的参数个数为4.99M。

4 结果与分析

4.1 客观评价

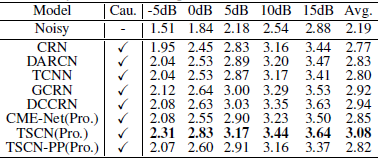

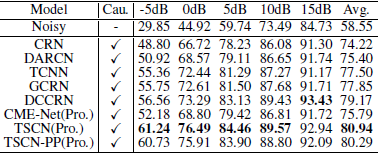

我们使用两个客观度量来评估不同模型的性能,即PESQ[30]和Estoi[31],它们与人类的感知质量和可理解性密切相关。结果见表1和表2,可以观察到后续现象。首先,建议的TSCN在PESQ和Estoi上都明显超过了其他基线。例如,与最先进的方法DCCRN相比,TSCN在PESQ和Estoi方面的平均表现分别为0.14和1.77%。这表明了该方法的优越性能。其次,对于相对较高的信噪比,DCCRN似乎相对更有利。例如,在-5dB内,TSCN比DCCRN获得了约0.23PESQ值的改善。然而,对于像15dB这样的高信噪比,PESQ分数是相似的。第三,当应用PP时,这两个度量的性能都会降低。这是因为这里设置PP是为了抑制一些令人不快的残余噪声分量,也可能会取消一些能量较低的语音分量。尽管如此,我们也认为实现PP是有益的,因为在低信噪比条件下,网络可能会产生一些“假”的频谱分量,这听起来并不令人愉快。我们期望PP能够有效地抑制负面影响,提高主观质量,这一点将在下一节得到验证。总体而言,提出的TSCN在客观指标上取得了令人印象深刻的性能,促使我们将其与PP一起用于DNS挑战评估

表1 基于PESQ的WSJ0-SI84数据集的客观结果。加粗表示每种情况下的最佳结果。“cau”表示系统是否是因果执行

表2 在WSJ0- SI84数据集上的ESTOI(in %)的客观结果。加粗 表示每种情况下的最佳结果

4.2 后处理的影响

为了验证PP的影响,我们进行了AB主观测试,程序类似于[19]。10名志愿者参与了测试。我们从DNS盲测试集中随机选取了10个语料,其中情感语料2个,英语语料3个,非英语语料3个,唱歌语料2个。提供两种处理类型,即TSCN和TSCN-PP。要求志愿者选择主观质量较好的首选项目。如果不能做出决定,还提供“平等”选项。测试结果如图所示。3.与TSCN相比,PP应用后,获得了一致的主观偏好。这表明客观计量学和主观选择之间存在差距,即尽管由于PP丢失了频谱信息而导致PESQ显著下降,但由于抑制了最不自然的残余噪声,仍然获得了一致的主观偏好。有趣的是,这一结论与[32]中的研究是一致的。

图 3. TSCN 和 TSCN-PP 之间的主观评价测试。 如果不能做出决定,也提供平等的选择。

4.3 在DNS-Challenge中的主观评价

在表3中,我们给出了组织者提供的符合ITU-TP.808标准[9]的主观结果。我们的方法总体上比基线模型高出0.17个MOS分数。此外,该方法在歌唱、声调和情感等特殊场景中也取得了令人印象深刻的表现,这些场景比传统的语音情况要难处理得多。

最后,我们对算法的处理时延进行了评估。在本研究中,窗口大小T=20ms,连续帧之间重叠ts=10ms。结果表明,算法时延td=T+ts=30ms,满足时延要求。注意,这项研究没有利用未来的信息,也就是说,系统是严格的因果关系。计算了TSCN-PP的平均处理时间为4.80ms,在Inteli5-4300U PC机上测试的TSCN-PP的平均处理时间为3.84ms。值得注意的是,尽管采用了两级网络,但由于我们将每个编码器和解码器的卷积通道数限制在64个,同时用可并行的TCM代替LSTM,所以推理效率仍然是有保证的

表3 基于P.808标准对DNS Challenge的主观评价

5 结论

在这个挑战中,我们提出了一种新颖的去噪系统,它由一个两级网络和一个低复杂度的后处理模块组成。对于两级网络,首先对幅值和相位进行解耦优化,即先粗略估计幅值,然后用第二级网络精化相位信息;为了获得更好的主观质量,我们还提出了一种轻量级的后处理模块来进一步抑制测试集与训练条件不匹配时产生的剩余非自然残余噪声。主观结果表明,对于ICASSP2021 DNS挑战赛的实时轨道1,所提出的算法在MOS中排名第一

6 参考文献

[1] Philipos C Loizou, Speech enhancement: theory and practice, CRC press, 2013.

[2] Y. Xu, J. Du, L-R. Dai, and C-H. Lee, A regression approach to speech enhancement based on deep neural networks, IEEE/ACM Trans. Audio Speech Lang. Proc., vol. 23, no. 1, pp. 7 19, 2014.

[3] D. Wang and J. Chen, Supervised speech separation based on deep learning: An overview, IEEE/ACM Trans.Audio Speech Lang. Proc., vol. 26, no. 10, pp. 1702 1726, 2018.

[4] D. Wang and J. Lim, The unimportance of phase in speech enhancement, IEEE Transactions on Acoustics, Speech, and Signal Processing, vol. 30, no. 4, pp. 679 681, 1982.

[5] K. Paliwal, K. W ojcicki, and B. Shannon, The importance of phase in speech enhancement, Speech Commun. , vol. 53, no. 4, pp. 465 494, 2011.

[6] D. Williamson and D. Wang, Time-frequency masking in the complex domain for speech dereverberation and denoising, IEEE/ACM Trans. Audio Speech Lang. Proc., vol. 25, no. 7, pp. 1492 1501, 2017.

[7] K. Tan and D. Wang, Learning complex spectral mapping with gated convolutional recurrent networks for monaural speech enhancement, IEEE/ACM Trans. Audio Speech Lang. Proc., vol. 28, pp. 380 390, 2020.

[8] A. D efossez, G. Synnaeve, and Y. Adi, Real Time Speech Enhancement in the Waveform Domain, in Proc. Interspeech 2020, pp. 3291 3295, 2020.

[9] C. Reddy, H. Dubey, V. Gopal, R. Cutler, S. Braun, H. Gamper, R. Aichner, and S. Srinivasan, ICASSP 2021 Deep Noise Suppression Challenge, arXiv preprint arXiv:2009.06122, 2020.

[10] W. Yu, Z. Huang, W. Zhang, L. Feng, and N. Xiao, Gradual network for single image de-raining, in Proc. of ACMM, 2019, pp. 1795 1804.

[11] A. Li, M. Yuan, C. Zheng, and X. Li, Speech enhancement using progressive learning-based convolutional recurrent neural network, Appl.Acoust. , vol. 166, pp. 107347, 2020.

[12] A. Li, C. Zheng, C. Fan, R. Peng, and X. Li, A recursive network with dynamic attention for monaural speech enhancement, in Proc. of Interspeech 2020, 2020.

[13] Y. Zhu, X. Xu, and Z. Ye, FLGCNN: A novel fully convolutional neural network for end-to-end monaural speech enhancement with utterance-based objective functions, Appl. Acoust. , vol. 170, pp. 107511, 2020.

[14] S. Bai, J. Kolter, and V. Koltun, An empirical evaluation of generic convolutional and recurrent networks for sequence modeling, arXiv preprint arXiv:1803.01271, 2018.

[15] S. Wisdom, J. Hershey, K. Wilson, J. Thorpe, M. Chinen, B. Patton, and R. Saurous, Differentiable consistency constraints for improved deep speech enhancement, in Proc. of ICASSP.IEEE, 2019, pp. 900 904.

[16] Z. Wang, P. Wang, and D. Wang, Complex spectral mapping for single-and multi-channel speech enhancement and robust ASR, IEEE/ACM Trans. Audio Speech Lang. Proc., vol. 28, pp. 1778 1787, 2020.

[17] J. L. Roux, S. Wisdom, H. Erdogan, and J. R. Hershey, SDR Half-baked or well done? , in Proc. of ICASSP, 2019, pp. 626 630.

[18] J. M. Martin-Do nas, A. M. Gomez, J. A. Gonzalez, and A. M. Peinado, A deep learning loss function based on the perceptual evaluation of the speech quality, IEEE Signal Process. Lett. , vol. 25, no. 11, pp. 1680 1684, 2018.

[19] A. Li, R. Peng, C. Zheng, and X. Li, A supervised speech enhancement approach with residual noise control for voice communication, Appl. Sci. , vol. 10, no. 8, pp. 2894, 2020.

[20] M. Tammen, D. Fischer, B. T. Meyer, and S. Doclo, DNNbased speech presence probability estimation for multi-frame single-microphone speech enhancement, in Proc. of ICASSP, 2020, pp. 191 195.

[21] Jean-Marc Valin, A hybrid DSP/deep learning approach to real-time full-band speech enhancement, in Proc. of MMSP. IEEE, 2018, pp. 1 5.

[22] X. Hu, S. Wang, C. Zheng, and X. Li, A cepstrum-based preprocessing and postprocessing for speech enhancement in adverse environments, Appl. Acoust. , vol. 74, no. 12, pp. 1458 1462, 2013.

[23] D. Paul and J. Baker, The design for the wall street journalbased CSR corpus, in Workshop on Speech and Natural Language, 1992, p. 357 362.

[24] A. Varga and H. Steeneken, Assessment for automatic speech recognition: II. NOISEX-92: A database and an experiment to study the effect of additive noise on speech recognition systems, Speech Commun. , vol. 12, no. 3, pp. 247 251, 1993.

[25] J. Barker, R. Marxer, E. Vincent, and S. Watanabe, The third chime speech separation and recognition challenge: Dataset, task and baselines, in Proc. of ASRU. IEEE, 2015, pp. 504 511.

[26] D. Kingma and J. Ba, Adam: A method for stochastic optimization, arXiv preprint arXiv:1412.6980, 2014.

[27] K. Tan and D. Wang, A convolutional recurrent neural network for real-time speech enhancement. , in Proc. of Interspeech, 2018, pp. 3229 3233.

[28] A. Pandey and D.Wang, TCNN: Temporal convolutional neural network for real-time speech enhancement in the time domain, in Proc. of ICASSP. IEEE, 2019, pp. 6875 6879.

[29] Y. Hu, Y. Liu, S. Lv, M. Xing, S. Zhang, Y. Fu, J. Wu, B. Zhang, and L. Xie, DCCRN: Deep complex convolution recurrent network for phase-aware speech enhancement, in Proc. of Interspeech 2020, 2020, pp. 2472 2476.

[30] A. Rix, J. Beerends, M. Hollier, and A. Hekstra, Perceptual evaluation of speech quality (PESQ)-a new method for speech quality assessment of telephone networks and codecs, in Proc. of ICASSP. IEEE, 2001, vol. 2, pp. 749 752.

[31] J. Jensen and C. Taal, An algorithm for predicting the intelligibility of speech masked by modulated noise maskers, IEEE/ACM Trans. Audio Speech Lang. Proc., vol. 24, no. 11, pp. 2009 2022, 2016.

[32] J. Valin, U. Isik, N. Phansalkar, R. Giri, K. Helwani, and A. Krishnaswamy, A perceptually-motivated approach for low-complexity, real-time enhancement of fullband speech, in Proc. of Interspeech 2020, 2020.

浙公网安备 33010602011771号

浙公网安备 33010602011771号