MPNN论文阅读笔记

arXiv:1704.01212v2 [cs.LG] 12 Jun 2017

MPNN 消息传递神经网络,专为图数据设计

其前向传播可划分为两个阶段:消息传递与读出

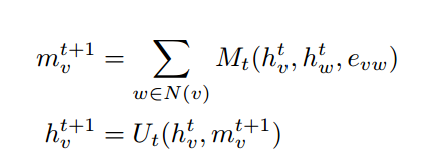

消息传播阶段如下:

Mt是t时刻的消息函数,Ut为t时刻的节点更新函数,evw是边vw的特征,htv是顶点v在t时刻的hidden feature,h0v则为最初的节点特征,经过消息的多次传递为节点学习到了特征的隐藏表示,同时结合了周围节点的特征信息与相关边的特征。

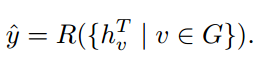

读出阶段如下:

R为一个节点特征的读出函数,值得注意的是这个函数应当与节点的状态排列无关,以排除图同构的影响

基于这个MPNN衍生了许多MPNNs;

Convolutional Networks for Learning Molecular Fingerprints, Duvenaud et al. (2015) 直接以边特征作为周边特征,通过concat来结合顶点自身特征,并为每个t和不同度的顶点构建可学习特征矩阵,最后readout步骤跳接前面每个时刻每个顶点的feature representation,并进入全连接层变换,最后激活。 缺点:concat步骤使得其无法学习点特征与边特征间的关联性

Gated Graph Neural Networks (GG-NN), Li et al.(2016) 为不同type的边设计了一个可学习的特征矩阵,同时以GRU门控单元作为节点更新函数,最后利用哈达玛积在readout阶段结合点特征与边特征

还有很多MPNNs的例子,可自行查阅论文,基本就是换各种节点更新函数,消息函数与最后的readout函数以适应下游任务。然而所有这些方法的缺点在于计算复杂度,即训练时间成本过高。

本文中提出对原有节点嵌入进行分解,把高维分解为多个低维,独立传递,最后readout阶段再将其组合还原,可以有效降低复杂度。理论最优复杂度为O(n2).