sublinear技巧

陈天奇的Training Deep Nets with Sublinear Memory Cost告诉我们,训练deep nets的时候,memory的最大的开销来自于储存用于backward的activation。这个很好理解,前向的时候,每一层的activation都要保存下来,用于计算backward。

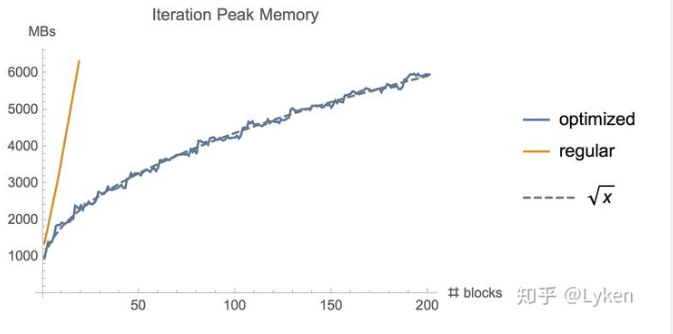

那么这个时候,一个简单的解决方案就是,我们隔着sqrt(n)层存一次activation,然后在需要的时候,我们再进行一次计算。这样的话,memory就大致省下来sqrt(n)倍。并且显存使用越多,省下来的越多。

reference

- https://arxiv.org/abs/1604.06174 Training Deep Nets with Sublinear Memory Cost.

- https://www.zhihu.com/question/274635237/answer/755102181

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· Manus的开源复刻OpenManus初探

· AI 智能体引爆开源社区「GitHub 热点速览」

· 从HTTP原因短语缺失研究HTTP/2和HTTP/3的设计差异

· 三行代码完成国际化适配,妙~啊~