sklearn机器学习 系列一 决策树 sklearn.tree

决策树是如何工作的:

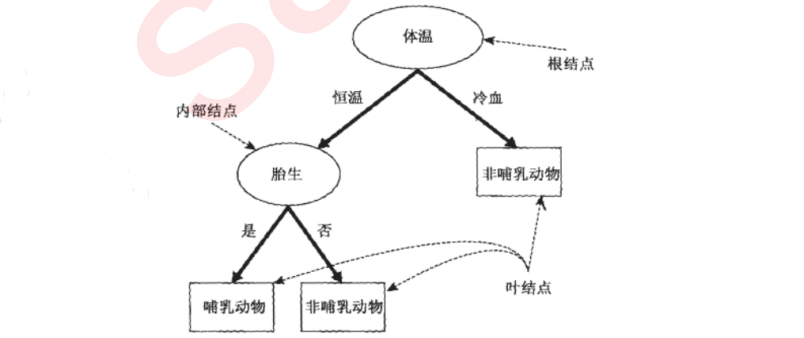

图一 图二

将数据根据特征分析,可以分成:根节点(初始节点)、中间节点、叶节点(无再可分节点)。

注:其实根据表格我们可以分析出来三个维度(表头、数据、标签),数据用来描述表头,表头用来反映标签。

微信群:回复K 进群

决策树算法的核心是要解决两个问题:

1)如何从数据表中找出最佳节点和最佳分枝?

2)如何让决策树停止生长,防止过拟合?

sklearn建模流程:

1)实例化算法对象 ——》 2)通过模型训练模型 ——》3)通过模型接口获取信息

代码如下:

from sklearn import tree #导入需要的模块 clf = tree.DecisionTreeClassifier() #实例化算法对象,需要使用参数 clf = clf.fit(X_train,y_train) #用训练集数据训练模型 result = clf.score(X_test,y_test) #打分,导入测试集,从接口中调用需要的信息

DecisionTreeClassifier() 函数:

class sklearn.tree.DecisionTreeClassifier (criterion=’gini’, splitter=’best’, max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, min_impurity_decrease=0.0, min_impurity_split=None, class_weight=None, presort=False)

参数解释:

criterion

为了要将数据转化为一棵树,决策树需要找出最佳节点和最佳的分枝方法,对分类树来说,衡量这个“最佳”的指标叫做“不纯度”。通常来说不纯度越低,决策树对训练集的拟合越好。现在使用的决策树算法在分枝方法上的核心大多是围绕在对某个不纯度相关指标的最优化上。 不纯度基于节点来计算,树中的每个节点都会有一个不纯度,并且子节点的不纯度一定是低于父节点的,也就是说,在同一棵决策树上,叶子节点的不纯度一定是最低的。 criterion这个参数正是用来决定不纯度的计算方法的。sklearn提供了两种选择:

criterion='entropy' #信息熵(Entropy) criterion='gini’#基尼系数(Gini Impurity)

比起基尼系数,信息熵对不纯度更加敏感,对不纯度的惩罚最强。信息熵的计算比基尼系数缓慢一些,因为基尼系数的计算不涉及对数。所以推荐建议使用基尼系数,但也不是不是绝对。不填默认基尼系数。

random_state

设置分枝中的随机模式的参数,默认None,在高维度时随机性会表现更明显,低维度的数据 随机性几乎不会显现。输入任意整数,会一直长出同一棵树,让模型稳定下来。

splitter

控制决策树中的随机选项的,有两种输入值,输入“best”,决策树在分枝时虽然随机,但是还是会 优先选择更重要的特征进行分枝(重要性可以通过属性feature_importances_查看),输入“random",决策树在分枝时会更加随机,树会因为含有更多的不必要信息而更深更大,并因这些不必要信息而降低对训练集的拟合。这也是防止过拟合的一种方式。当你预测到你的模型会过拟合,用这两个参数来帮助你降低树建成之后过拟合的可能性。当然,树一旦建成,我们依然是使用剪枝参数来防止过拟合。

代码练习:

#1.引入库文件 from sklearn import tree from sklearn.datasets import load_wine from sklearn.model_selection import train_test_split #2.获取sklearn自动红酒数据集 wine = load_wine() wine.data.shape wine.target #如果wine是一张表,应该长这样: import pandas as pd pd.concat([pd.DataFrame(wine.data),pd.DataFrame(wine.target)],axis=1) wine.feature_names wine.target_names #3. 分训练集和测试集 Xtrain, Xtest, Ytrain, Ytest = train_test_split(wine.data,wine.target,test_size=0.3) Xtrain.shape Xtest.shape #4. 建立模型 clf = tree.DecisionTreeClassifier(criterion="gini") clf = clf.fit(Xtrain, Ytrain) #apply返回每个测试样本所在的叶子节点的索引 print(clf.apply(Xtest)) #predict返回每个测试样本的分类/回归结果 print(clf.predict(Xtest)) score = clf.score(Xtest, Ytest) #返回预测的准确度 score #5.决策树 feature_name = ['酒精','苹果酸','灰','灰的碱性','镁','总酚','类黄酮','非黄烷类酚类','花青素','颜色强度','色调','od280/od315稀释葡萄酒','脯氨酸'] import graphviz dot_data = tree.export_graphviz(clf,out_file = None,feature_names= feature_name,class_names=["琴酒","雪莉","贝尔摩德"],filled=True,rounded=True) graph = graphviz.Source(dot_data) graph.save()#保存决策树 #特征重要性 clf.feature_importances_ [*zip(feature_name,clf.feature_importances_)] #我们的树对训练集的拟合程度如何? score_train = clf.score(Xtrain, Ytrain) score_train

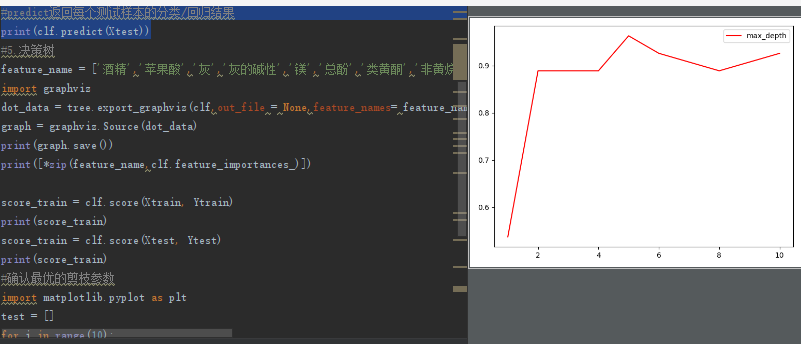

那具体怎么来确定每个参数填写什么值呢?这时候,我们就要使用确定超参数的曲线来进行判断了。

import matplotlib.pyplot as plt test = [] for i in range(10): clf = tree.DecisionTreeClassifier(max_depth=i+1 ,criterion="entropy" ,random_state=30 ,splitter="random" ) clf = clf.fit(Xtrain, Ytrain) score = clf.score(Xtest, Ytest) test.append(score) plt.plot(range(1,11),test,color="red",label="max_depth") plt.legend() plt.show()

可以根据显示图形确定参数选择:

加微信:wonter 发送:技术Q

医疗微信群:

加微信:wonter 发送:医疗Q

更多文章关注公众号:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 如何编写易于单元测试的代码

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 地球OL攻略 —— 某应届生求职总结

· 周边上新:园子的第一款马克杯温暖上架

· Open-Sora 2.0 重磅开源!

· 提示词工程——AI应用必不可少的技术

· .NET周刊【3月第1期 2025-03-02】