Chain TDNN/LSTM的拼帧索引、延时

TDNN模型示例

TDNN拼帧:

第8层:(0,3)

第7层:(-9,0)

第6层:(0,3)

第5层:(-6,0)

第4层:(0,3)

第3层:(-3,0)

第2层:(0,3)

第1层:(-3,0)

输出依赖

要在输出层处输出第1帧,各层需要的帧的时间索引如下:

第8层:1,4

第7层:-9,-6,1,4

第6层:-9,-6,1,4,7

第5层:-15,-12,-9,-6,-3,1,4,7

第4层:-15,-12,-9,-6,-3,1,4,7,10

第3层:-18,-15,-12,-9,-6,-3,1,4,7,10

第2层:-18,-15,-12,-9,-6,-3,1,4,7,10,13

第1层:-21,-18,-15,-12,-9,-6,-3,1,4,7,10,13

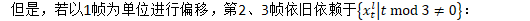

要在输出层处输出第2帧,各层需要的帧的时间索引如下:

第9层:2,5

...

第2层:-20,-17,-14,-11,-8,-5,-2,2,5,8,11,14

要在输出层处输出第3帧,各层需要的帧的时间索引如下:

第9层:3,6

...

第2层:-19,-16,-13,-10,-7,-4,-1,3,6,9,11,15

要在输出层处输出第4帧,各层需要的帧的时间索引如下:

第9层:4,7

...

第2层:-18,-15,-12,-9,-6,-3,1,4,7,10,13,16

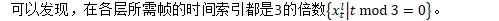

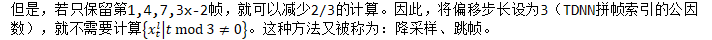

TDNN的拼帧索引

第一层不需要受到此限制

第9层:(0,3)

第8层:(-9,0)

第7层:(0,3)

第6层:(-6,0)

第5层:(0,3)

第4层:(-3,0)

第3层:(0,3)

第2层:(-3,0)

第1层:(-2,-1,0,1,2)

LSTM的延时

与TDNN类似,单向LSTM依赖于历史信息,双向LSTM(BLSTM)依赖于历史信息与未来信息

信息包括 记忆(Cell)与输出(Recurrent)

默认情况下,对于长度为T帧的语句,在t时刻:

LSTM依赖于

t时刻上一层的输出

BLSTM依赖于

t时刻上一层的输出

那么,在t-1时刻:

LSTM依赖于

t-1时刻上一层的输出

BLSTM依赖于

t-1时刻上一层的输出

依此类推:

LSTM将依赖于所有的历史信息

BLSTM将依赖于所有的信息(历史信息+未来信息)

也就是说,所有帧(T帧)都需要进行LSTM计算