机器学习-决策树

学习知识的步骤:

看书、摘抄、理解 ---------- 做题、实践、检验 ---------- “大妈级”语言讲述

参考文章:

《机器学习-周志华》

《统计学习方法-李航》

《机器学习实战-Peter Harrington》

《Pattern Recognition and Machine Learning》

1、决策树介绍:

选择所有特征属性中信息熵最大的特征,从根节点进行测试,根据测试结果将实例分配到其子节点,每一个子节点对应该特征的取值,如此递归对实例进行测试并分配,直至到达叶节点,最后将实例分类到叶节点中。

根节点:包含样本全集

叶节点:对应决策结果,即对应的实例分类

其他节点:对应特征属性测试

2、优缺点:

优点:

1.模型具有可读性,分类速度快,计算复杂度不高

2.可以处理连续和种类字段

3.无需领域知识以及参数假设

4.适合高维数据

5.对中间值的缺失不敏感

6.可以同时处理标称型和数值型数

缺点:

1.容易产生过拟合

2.容易忽略数据集中属性的相互关联

3.对于那些各类别样本数量不一致的数据,在决策树中,进行特征属性划分时,不同的判定准则会带来不同的属性选择倾向。即因不同的算法得到的结果可能不同

3、香农熵:

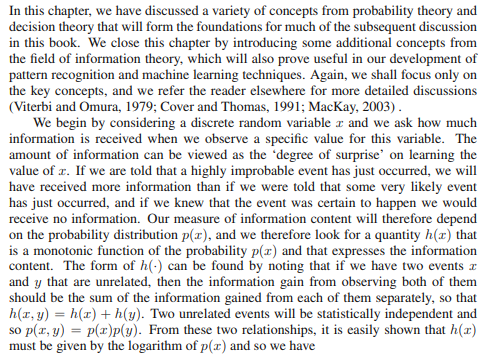

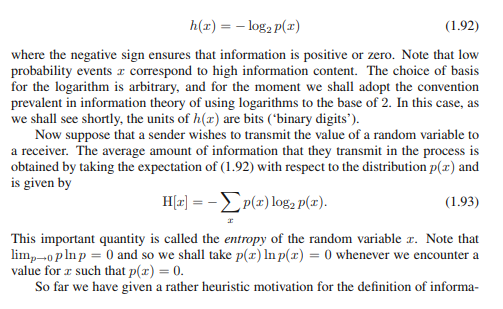

《Pattern Recognition and Machine Learning》p48页,讲述了香农熵公式的由来。

3.1 经验熵

对数据集进行分类的不确定性H(D)称为经验熵,其概率一般由数据估计(特别是极大似然估计)得到。

3.2 条件经验熵

特征属性A在给定条件下对数据集分类的不确定性H(D|A),其概率一般由数据估计(特别是极大似然估计)得到。