《科学技术史系列讲座》期末论文

注:这学期有一门课叫做《科学技术史系列讲座》,刚好自己对机器学习还有点兴趣,借着期末论文,写了一些深度学习方面的内容。其实对这方面涉猎很浅,理解不到位之处欢迎指教。

人工智能与深度学习

关键词

人工智能、机器学习、深度结构

前言

计算机(computer)是20世纪最伟大的科学技术发明之一,对人类的生产活动和社会活动产生了及其重要的影响,并以强大的生命力飞速发展。它的应用领域从最初的军事科研应用扩展到目前社会的各个领域,已形成规模巨大的计算机产业,带动了全球范围的技术进步,由此引发了深刻的社会变革。计算机已成为信息社会中必不可少的工具。它是人类进入信息时代的重要标志。

计算机科学(Computer Science)是系统性研究信息与计算的理论基础以及它们在计算机系统中如何实现与应用的实用技术的学科。它通常被形容为对那些创造、描述以及转换信息的算法处理的系统学习。计算机科学包含很多分支领域,如计算机图形学、计算复杂性理论、编程语言理论、程序设计、人机交互等等。

这次作业我将介绍计算机科学的分支——人工智能近几年来的一个热点话题,深度学习相关的研究与应用。在介绍深度学习之前,我将回顾人工智能中的主要理论与算法,以及深度学习的基础——图模型和经典的神经网络。最后,我会结合自己的理解,谈谈人工智能的未来,这是一个不仅仅让计算机科学家,同时也是科学技术史学家以及普通的计算机使用者都感兴趣的话题。

人工智能和机器学习

作为一个学科,计算机科学涵盖了从算法的理论研究和计算的极限,到如何通过硬件和软件实现计算系统的整个范围。一般而言,计算机科学的领域可以分为理论计算机科学和应用计算机科学。理论计算机科学包括计算理论、信息与编码理论、算法与数据结构、编程语言理论、形式化方法、并发,并行和分布式系统、数据库和信息检索。应用计算机科学包括人工智能、计算机系统结构与工程、计算机图形与视觉、计算机安全和密码学、计算科学、信息科学、软件工程等。

作为应用计算机科学的一个分支,人工智能(artificial intelligence)旨在创造可以解决计算问题,以及像动物和人类一样思考与交流的人造系统。为了让计算机具有类似人类一样思考和判断的能力,机器学习(machine learning)就显得尤其重要。机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。机器学习涉及概率论、统计学、凸分析等多门学科,目前已在模式识别(pattern recognition)、数据挖掘(data mining)、计算机视觉(computer vision)、自然语言处理(natural language processing)、语音信号处理(spoken language processing)、金融市场(financial market)、医学和生物学诊断(medical and biological diagnosis)甚至战略游戏(strategy game)中获得了广泛的运用。

如何理解机器学习?从工程的角度来说,人体是一个复杂的大系统。人通过感官感知外界的刺激,并由大脑判断做出选择,通过相应的动作作为回应。人工智能同样希望模拟这一过程,通过各式各样的传感器代替人的感官,通过机器学习的算法做出决策,最终通过计算机的输出结果、或者机器人的动作完成这一过程。机器学习的算法多种多样,最简单的如高中学过的最小二乘线性拟合,计算机接收到一组二维的输入数据,计算出相应的截距和斜率,并能够对未知的采样点进行估计,这就完成了一项最简单的机器学习任务。

图模型(graphical models)

图模型,也叫概率图模型(probabilistic graphical models),在现代模式识别中扮演着重要的角色。它通过图论方法对复杂的概率模型进行建模,不仅能够表征所有概率模型之间的依赖关系,更能方便的看出概率模型中深层次的结构与特点。下面通过一个简单的例子说明概率图的建立和表示。

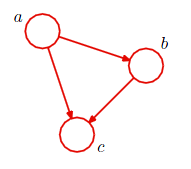

考虑三个随机变量 $a, b, c$ 的联合分布 $p(a, b, c)$ ,此分布可以写成如下的形式:

$p(a, b, c)=p(c|a, b)p(b|a)p(a)$

如果我们使用节点表示随机变量,有向边表示条件概率,则联合分布可以通过如下的图模型表出:

除了有向图之外,也可以用无向图来表示概率模型。这被称作马尔科夫随机场(Markov Random Fields)。

神经网络

生物学家和神经学家经过长期不懈的努力,通过对人脑的观察和认识,建立了神经元网络理论和神经系统结构理论。人工神经网络作为一种非线性的、与大脑智能相似的网络模型,也很好的弥补了以线性科学作为主导的经典数学和经典物理学。

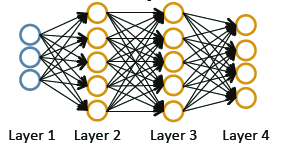

人工神经网络的研究始于20世纪40年代初,经历了兴起、高潮、萧条和平稳发展的阶段。最初的神经网络仅有单层结构,随着研究人员的深入分析,从数学上证明了这种网络功能有限,甚至不能解决异或这样简单的逻辑运算。在20世纪80年代和90年代初,神经网络被广泛运用,而90年代末其研究再次进入消退期。最近由于深度学习概念的提出,神经网络的研究再次复兴,是很多应用的最尖端技术。一个由四层神经元组成的神经网络如下图所示:

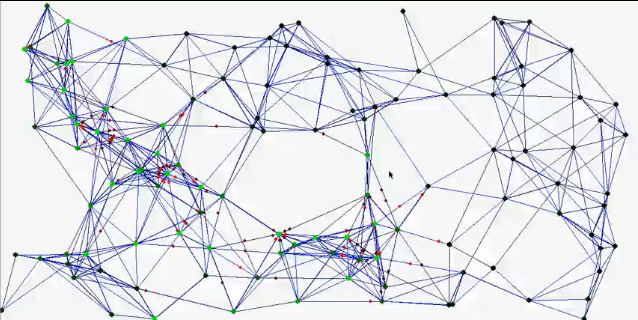

其中每一个黄色圆圈代表一个神经元(neuron),具有相同的功能,而左边的蓝色圆圈代表输入激励。这样的结构得到了生物观测的支持。随着理论工作的发展,神经网络的应用研究也取得了巨大进展,几乎人工智能的各个方面都能有所涉及。一个更为复杂的神经网络如下图所示:

深度学习的理论

神经网络研究的起起落落,几乎都是由这个领域的重大突破所影响的。当神经网络由单层推广到多层,误差反向递推算法等等都推动了神经网络的发展。自2000年以后,神经网络的研究再次进入低潮期,以至于曾经有段时间,人工智能方面的会议拒绝接受标题含有神经网络的文章,认为这个领域已经没有前途。近几年来的深度结构(deep architecture)再次给神经网络带来了希望。为此,世界各地都相继建立了研讨会促进深度学习的研究,如the 2011 ICML Workshop on Learning Architectures, Representations, and Optimization for Speech and Visual Information Processing, the 2009 ICML Workshop on Learning Feature Hierarchies, the 2008 NIPS Deep Learning Workshop, the 2009 NIPS Workshop on Deep Learning for Speech Recognition and Related Applications, Deep Learning for Speech and Language Processing in IEEE Transactions on Audio, Speech, and Language Processing (2011)

深度学习的兴起一方面源自2006年DBN(deep belief network)算法的提出。DBN是深度网络中的一个重要概念,常常被用来在训练阶段初始化深度网络,其计算复杂度较之前降低不少,并且初始化的效果也比较好。这和当年误差反向递推算法发明时引起神经网络的热潮一样。

另一方面,深度学习提供了一种全新的看待机器学习算法的方式。神作”Sparse Feature Learning for Deep Belief Networks”中有这么一段:

” Many unsupervised methods are based on reconstructing the input from the representation, while constraining the representation to have certain desirable properties (e.g. low dimension, sparsity, etc). Others are based on approximating density by stochastically reconstructing the input from the representation. We describe a novel and efficient algorithm to learn sparse representations, and compare it theoretically and experimentally with a similar machine trained probabilistically, namely a Restricted Boltzmann Machine. We propose a simple criterion to compare and select different unsupervised machines based on the trade-off between the reconstruction error and the information content of the representation. We demonstrate this method by extracting features from a dataset of handwritten numerals, and from a dataset of natural image patches. We show that by stacking multiple levels of such machines and by training sequentially, high-order dependencies between the input observed variables can be captured.”

上面这段话说了什么呢?换成简单的语言就是:非监督学习旨在发现数据中隐含的结构,以便得到比原始数据更适合的作为监督学习输入的表示。以往的非监督学习都是通过选取特定的特征,并施加期望的性质(稀疏性,低维度等)来学习这些特征之间的关系,这篇文章中提出了一种新的机制RBM(Restricted Boltzmann Machine)代替了以往神经网络中的神经元节点。通过这种RBM的层叠构造,可以从数据中逐渐的学习出之前未知的特征之间的联系!

如果还是不理解,不如这样来解释:热学中有非常有名的理想气体状态方程

$PV=\nu RT$

为了得出这一结论几百年前物理学家们经历了“提出假设—模型推导—实验验证”的过程,通过控制变量发现一些物理量之间存在着正比例或者反比例的关系。曾经最难的一个环节可能是设计恰当的实验进行验证。但随着机器学习的发展,未来基础科学发现规律的方式可能产生根本变化。科学家们只需采集大量的热力学数据,包含 等特征,然后基于传统的非监督学习,计算机就能得出这样的一个方程。而根据deep learning中的理论,借助RBM,科学家采集的数据中甚至可以不用包含方程中的这些特征,机器学习仍然能够得出基于这些特征的理想气体状态方程!

深度学习的应用

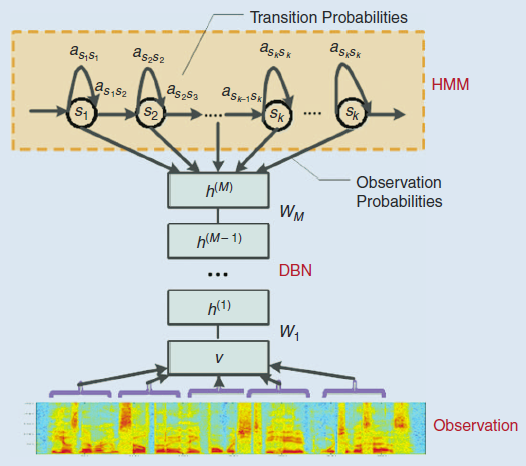

Dong Yu和Li Deng在2011年的文章”Deep Learning and Its Application to Signal and Information Processing”给深度学习这个领域提供了一个很好的综述。这篇文章指出以往机器学习的算法(研究深度学习的人有时将这些算法称作“肤浅学习”)的不足之处。并且介绍了深度学习的应用。下图展示了深度学习应用于语音识别的DBN-HMM模型框图:

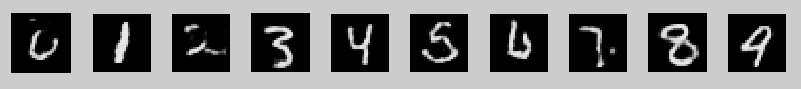

深度学习同样可以应用于图像,下图是通过深度网络产生的数字:

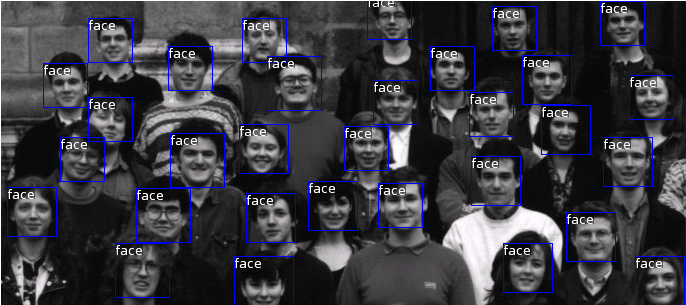

以及人脸识别:

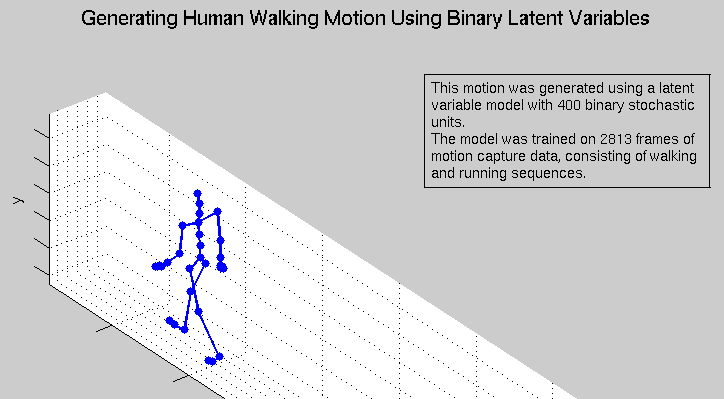

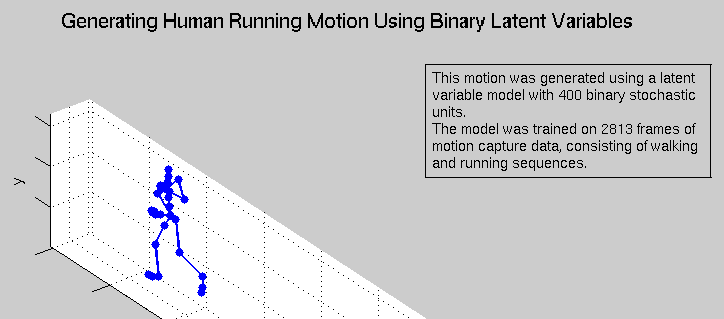

一个很有趣的展示是通过深度学习模拟人体走路和跑步时的样子,如下图所示:

人工智能的未来

未来的人工智能和机器学习将仍然依赖于运算速度和容量。可以想见,机器的感觉系统和人类也会很不一样。一方面,机器想要在人类感官范围(如视觉,听觉)内超越人类尚属困难,但另一方面,传感器可以让计算机感知到人类无法感知的内容,如红外线,电磁场等。未来的人工智能,正如Jeff Hawkins所说,将在10年内成为最热门的科技领域。而把智能等同于人类行为的“图灵测试”限制了我们的想象力。理解了什么是智能以后,我们可以制造出不仅仅是复制人类行为的、更有价值的智能机器,它将会成为神奇的工具,大幅度的扩展我们对宇宙的认识。

后记

在做这个题目之前,我对于人工智能的认识很肤浅。虽然学过一些相关课程,但对机器学习近几年来的热点尤其深度学习一无所知。这次作业过程中我认真阅读了机器学习和深度学习方面的一些书籍与论文,觉得很有长进。正确的将科学技术史和自己的专业结合起来看待能够疏通专业脉络,这是我觉得在作业中的最大收获,将对我今后进一步学习带来不小的帮助。

参考文献

[1] Pattern Recognition and Machine Learning, Christopher M. Bishop

[2] Spoken Language Processing, Xuedong Huang, Alejandro Acero, Hsiao-Wuen Hon

[3] Machine learning, online course offered by Prof. Andrew Ng, from Stanford University

[4] On Intelligence: How a New Understanding of the Brain will Lead to the Creation of Truly Intelligent Machines, Jeff Hawkins

[5] 《人工智能与知识工程》,陈世福、陈兆乾等编著 南京大学出版社

[6] 博客:http://deeplearning.net/

[7] 视频:Recent Developments in Deep Learning, http://www.youtube.com/watch?v=VdIURAu1-aU

[8] Neural Nets Simulation, http://www.youtube.com/watch?v=9U5_A4eNzCE&feature=related

[9] “Deep Belief Networks for phone recognition”, Abdel-rahman Mohamed, George Dahl, and Geoffrey Hinton

[10] “Sparse Feature Learning for Deep Belief Networks”, Marc Aurelio Ranzato, Y-Lan Boureau, Yann LeCun

[11] “Deep Belief Net Learning in a Long-Range Vision System for Autonomous Off-Road Driving”, Raia Hadsell, Ayse Erkan, Pierre Sermanet, Marco Scoffier, Urs Muller, Yann LeCun

[12] “Deep Learning and Its Applications to Signal and Information Processing”, Dong Yu and Li Deng

[13] “Expanding the Scope of Signal Processing”, Li Deng

[14] “Learning Deep Architectures for AI”, Yoshua Bengio

posted on 2011-12-21 23:40 J. V. King 阅读(1588) 评论(1) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号