ROC曲线与AUC计算总结

roc曲线

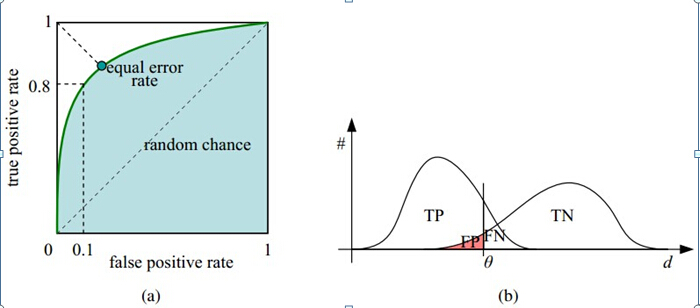

1、roc曲线:接收者操作特征(receiveroperating characteristic),roc曲线上每个点反映着对同一信号刺激的感受性。

横轴:负正类率(false postive rate, FPR),特异度,划分实例中所有负例占所有负例的比例;(1-Specificity)

纵轴:真正类率(true postive rate, TPR),灵敏度,Sensitivity(正类覆盖率)

2、针对一个二分类问题,将实例分成正类(postive)或者负类(negative)。但是实际中分类时,会出现四种情况.

(1)若一个实例是正类并且被预测为正类,即为真正类(True Postive ,TP)

(2)若一个实例是正类,但是被预测成为负类,即为假负类(False Negative, FN)

(3)若一个实例是负类,但是被预测成为正类,即为假正类(False Postive ,FP)

(4)若一个实例是负类,但是被预测成为负类,即为真负类(True Negative ,TN)

混淆矩阵如下,1代表正类,0代表负类:

| predict: 0 | predict: 1 | |

|---|---|---|

| label: 0 | TN | FP |

| label: 1 | FN | TP |

| 由上表可得出横,纵轴的计算公式: | ||

| (1)真正类率(True Postive Rate)TPR: TP/(TP+FN),代表分类器预测的正类中实际正实例占所有正实例的比例。Sensitivity | ||

| (2)负正类率(False Postive Rate)FPR: FP/(FP+TN),代表分类器预测的正类中实际负实例占所有负实例的比例。1-Specificity | ||

| (3)真负类率(True Negative Rate)TNR: TN/(FP+TN),代表分类器预测的负类中实际负实例占所有负实例的比例,TNR=1-FPR。Specificity | ||

| 假设采用逻辑回归分类器,其给出针对每个实例为正类的概率,那么通过设定一个阈值如0.6,概率大于等于0.6的为正类,小于0.6的为负类。对应的就可以算出一组(FPR,TPR),在平面中得到对应坐标点。随着阈值的逐渐减小,越来越多的实例被划分为正类,但是这些正类中同样也掺杂着真正的负实例,即TPR和FPR会同时增大。阈值最大时,对应坐标点为(0,0),阈值最小时,对应坐标点(1,1)。 | ||

| 如下面这幅图,(a)图中实线为ROC曲线,线上每个点对应一个阈值。 | ||

|

||

| 横轴FPR:1-TNR,1-Specificity,FPR越大,预测正类中实际负类越多。 | ||

| 纵轴TPR:Sensitivity(正类覆盖率),TPR越大,预测正类中实际正类越多。 |

理想目标:TPR=1,FPR=0,即图中(0,1)点,故ROC曲线越靠拢(0,1)点,越偏离45度对角线越好,Sensitivity、Specificity越大效果越好。

如何画roc曲线

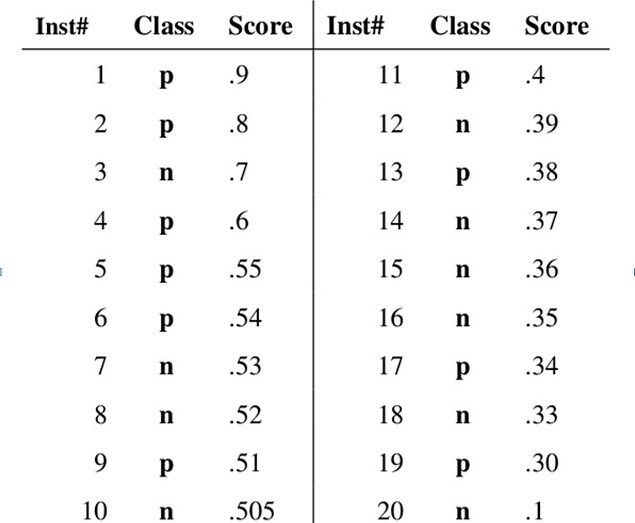

假设已经得出一系列样本被划分为正类的概率,然后按照从大到小排序,下图是一个示例,图中共有20个测试样本,“Class”一栏表示每个测试样本真正的标签(p表示正样本,n表示负样本),“Score”表示每个测试样本属于正样本的概率。

首先统计出,一共含有10个正样本、10个负样本。 首先,以(0,0)为初始起点。

接下来,我们从高到低,依次将“Score”值作为阈值threshold,当测试样本属于正样本的概率大于或等于这个threshold时,我们认为它为正样本,否则为负样本。从第一个样本开始(标签为positive正类),设该样本的Score值为阈值,则该样本之后的样本(还剩余9个positive、10个negative)判为负样本,计算得TPR=1/10=0.1,FPR=0/10=0.0,即ROC曲线(0, 0.1)点;再选择第二个样本点(标签为positive正类)的Score作为阈值,大于等于该阈值的样本(2个positive)判为正样本,小于该阈值(还剩余8个positive、10个negative)的判为负样本,计算TPR=2/10=0.2,FRP=0/10=0.0,可在ROC图画出该点。

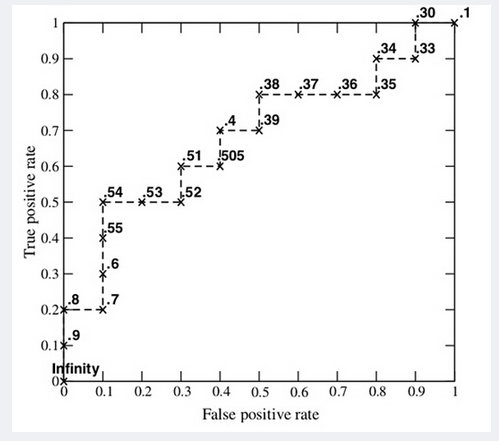

这样一来,我们一共得到了20组FPR和TPR的值,将它们画在ROC曲线的结果如下图:

我们可以大致推断出,当新样本真实分类为Positive时候,阶梯数值向上一个单位((1/真实正样本总数));当新样本真实分类为negative时候,阶梯水平向右移动一个单位(1/真实负样本总数)。

两种ROC曲线画法:

上面是将样本的预测Score从大到小排列,从第一个Socre作为阈值,依次遍历所有Score。先得出全判负类时TPR,FPR的值,最后得出全判正类的TPR,FPR的值,画ROC曲线对应的先画出(0,0)点,最后再画出(1,1)点;

另外一种方法是,将样本的预测Score从小到大排列,从第一个Socre作为阈值,依次遍历所有Score。先得出全判正类时TPR,FPR的值,最后得出全判负类的TPR,FPR的值,画ROC曲线对应的先画出(1,1)点,最后再画出(0,0)点。

AUC(Area under Curve):Roc曲线下的面积,介于0.1和1之间。

AUC作为数值可以直观的评价分类器的好坏,值越大越好。

首先AUC值是一个概率值,当你随机挑选一个正样本以及负样本,当前的分类算法根据计算得到的Score值将这个正样本排在负样本前面的概率就是AUC值,AUC值越大,当前分类算法越有可能将正样本排在负样本前面,从而能够更好地分类。

计算代码

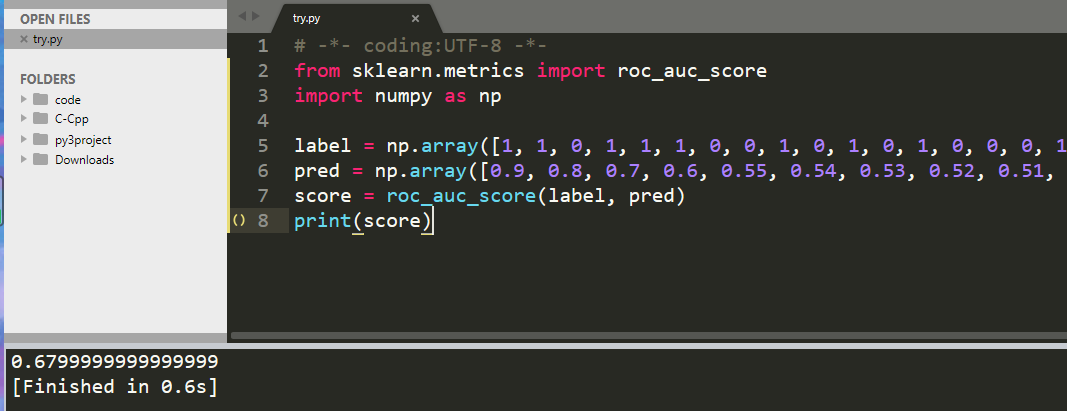

直接调库sklearn :

from sklearn.metrics import roc_auc_score

以刚才图片中的数值为例子:

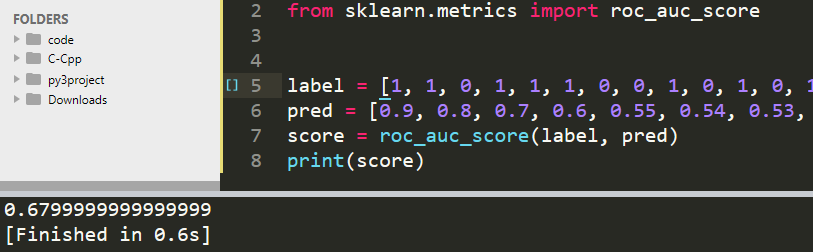

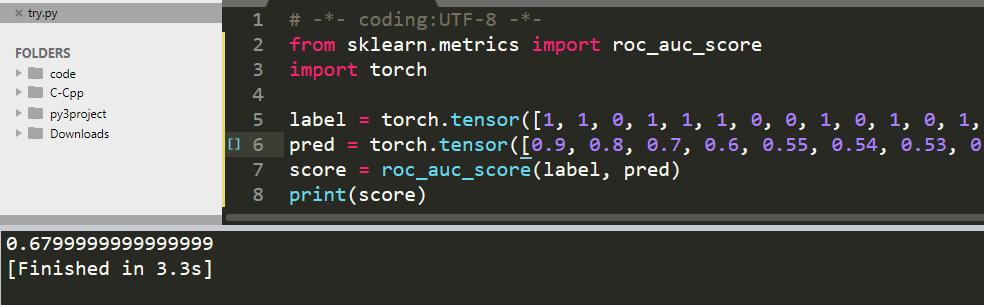

from sklearn.metrics import roc_auc_score

import numpy as np

label = np.array([1, 1, 0, 1, 1, 1, 0, 0, 1, 0, 1, 0, 1, 0, 0, 0, 1, 0, 1, 0])

pred = np.array([0.9, 0.8, 0.7, 0.6, 0.55, 0.54, 0.53, 0.52, 0.51, 0.505, 0.4, 0.39, 0.38, 0.37, 0.36, 0.35, 0.34, 0.33, 0.30, 0.1])

score = roc_auc_score(label, pred)

print(score)

改变类型为列表:

改变类型为pytorch张量:

参考

https://blog.csdn.net/taotiezhengfeng/article/details/80456110