机器学习笔记04(Logistic Regression)

Logistic Regression

思路:

1、逻辑回归 vs 线性回归(Logistics Regression VS Linear Regression )

2、生成模型 vs 判别模型(Generative Model VS Discriminative Model)

3、逻辑回归 vs 深度学习(Logistics Regression VS Deep Learning)

前面已经学过 Regression ,其建立的 model 是 Linear model,现在与Logistics Regression对比学习。

此节与上节内容联系比较紧密,可回头复习一下。

1、逻辑回归 vs 线性回归(Logistics Regression VS Linear Regression )

什么是逻辑回归:

- 逻辑回归是解决分类问题的一种算法

- 它与linear regression 形式上有点像(本质上是在线性模型外面“裹”一个sigmoid激活函数,来表示概率的函数)

- 它是一种判别模型,与前面说的生成模型不同

- 它是深度学习的基础

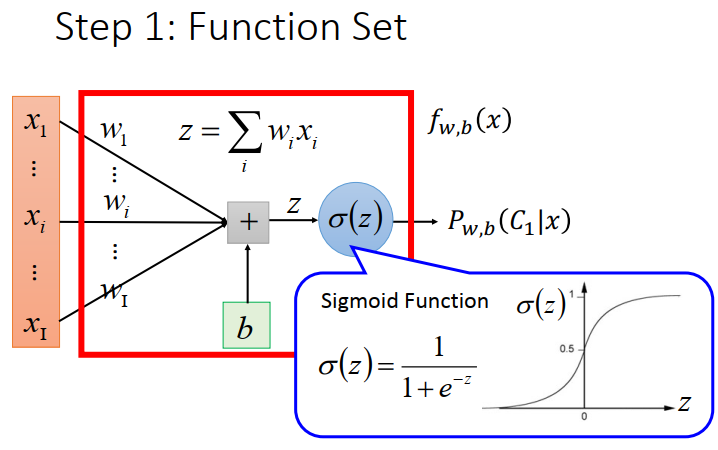

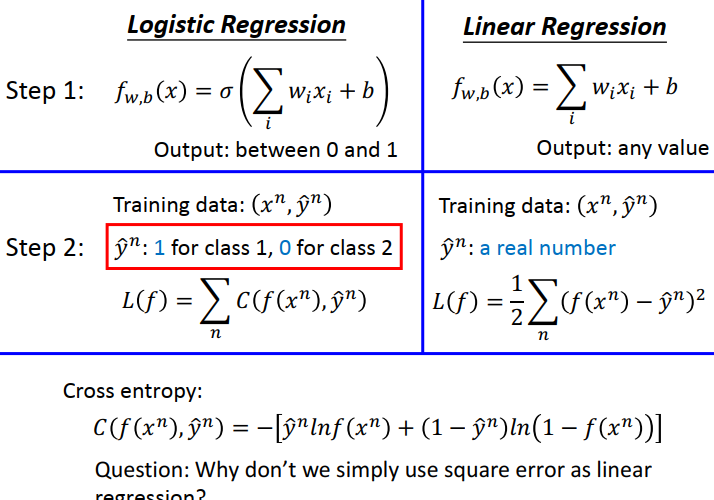

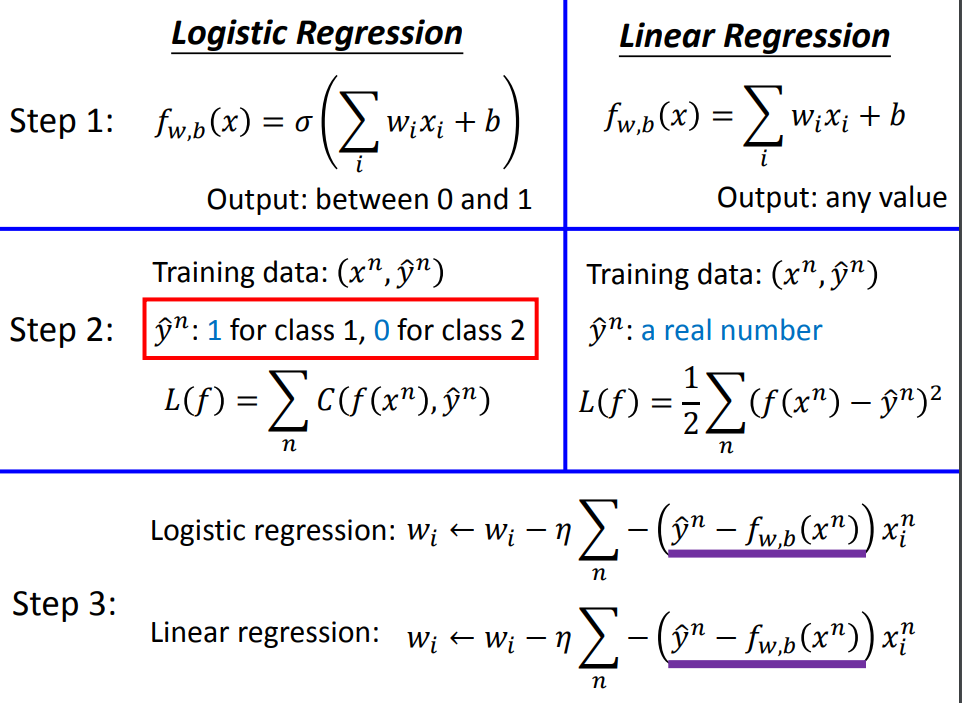

1)model 不同

model 对比:

2)Loss Function 不同

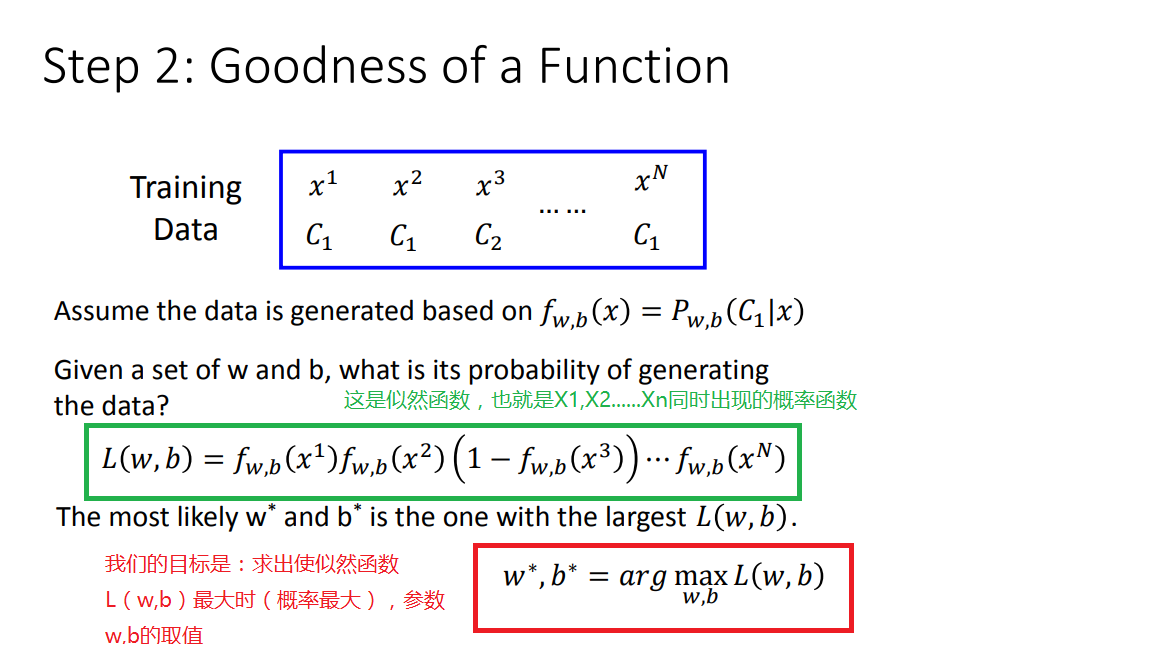

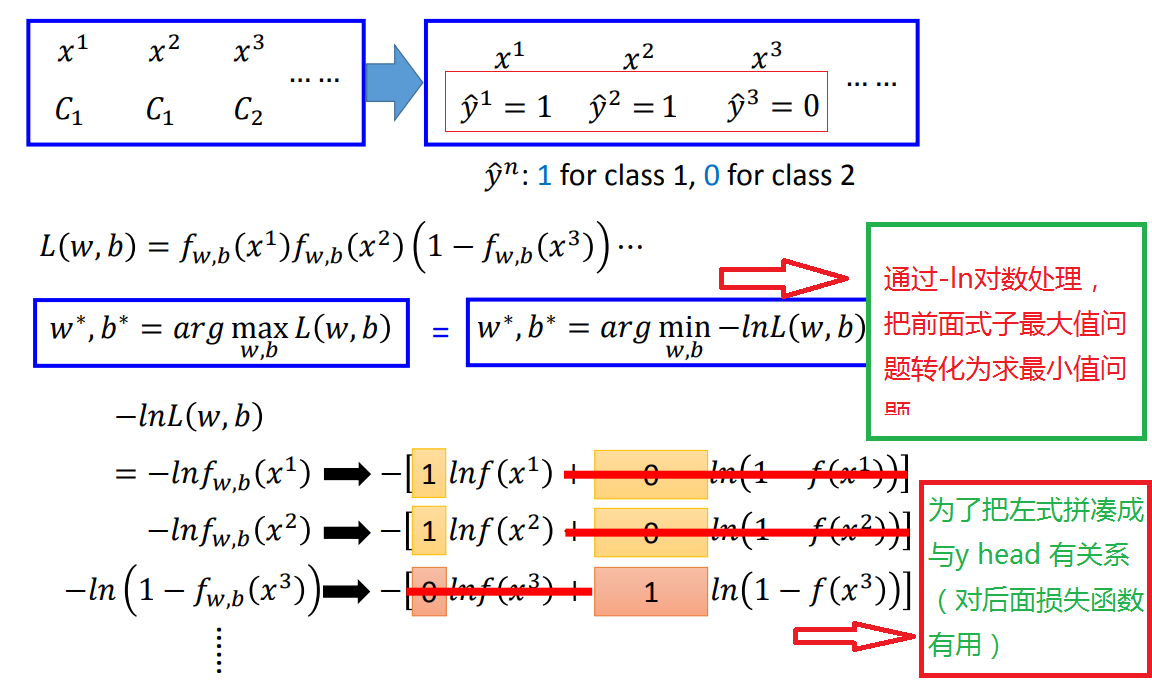

回顾我们线性回归的Loss函数中是跟训练数据(x1,y^1)中的y^1的差值平方和,那么逻辑回归是否也要建立与y^的联系呢。

下面就要开始拼凑了!

Loss function对比:

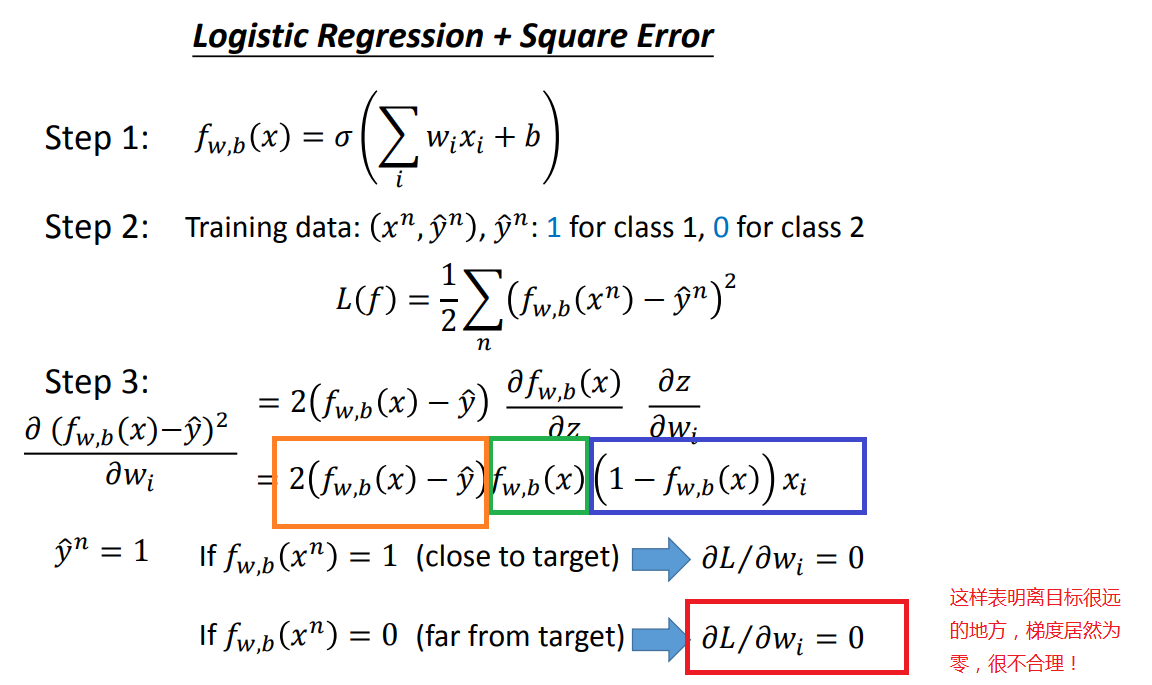

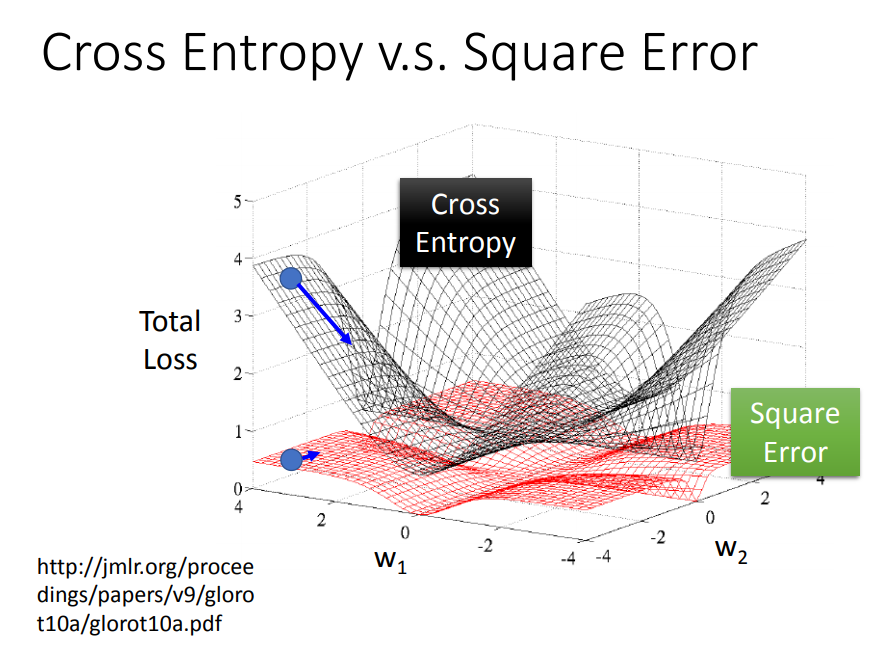

为什么不是用平方差?

3)step 3 是类似的

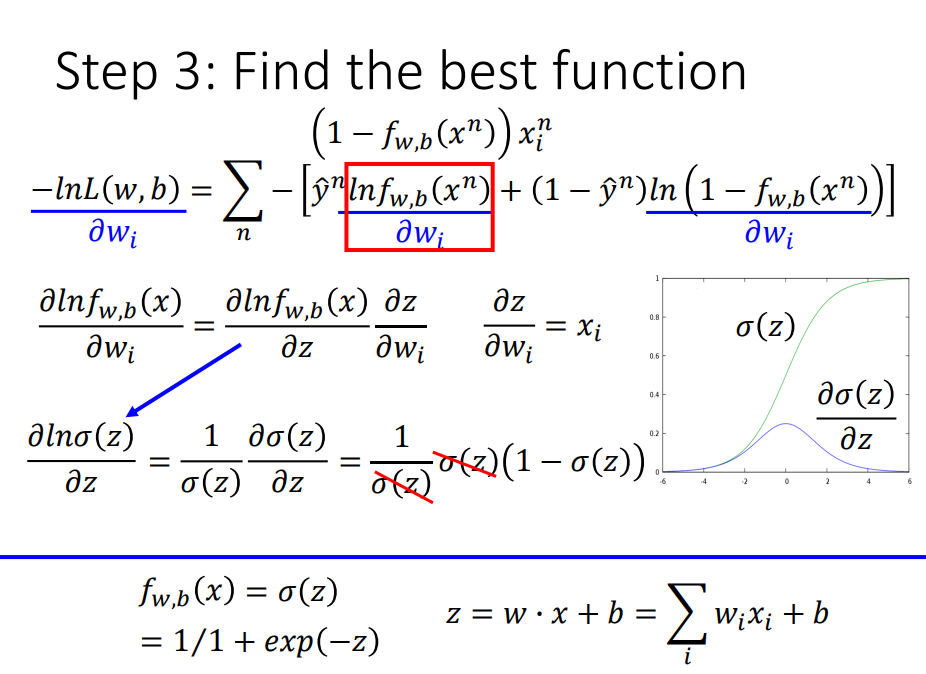

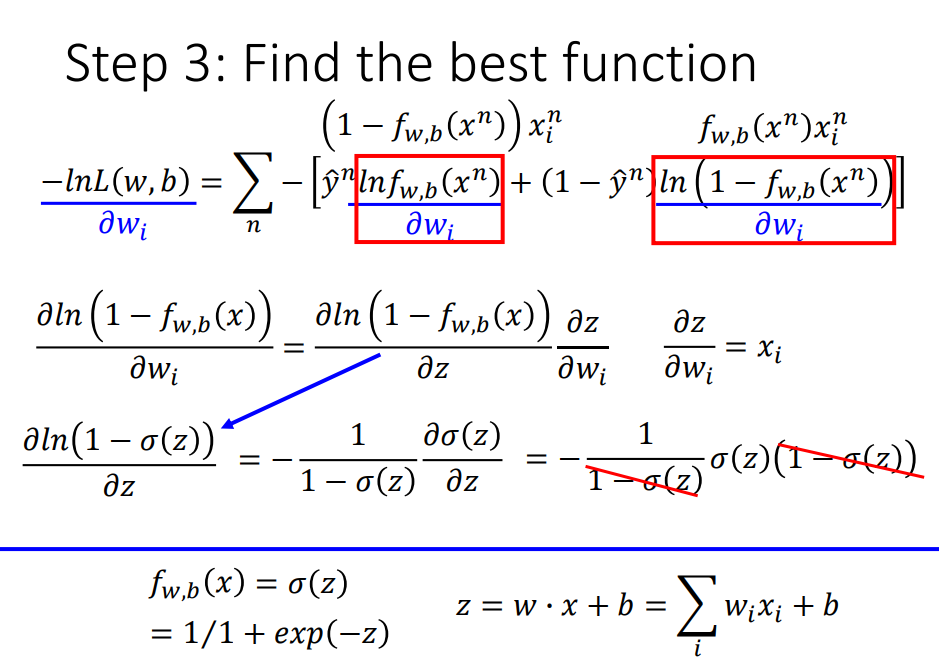

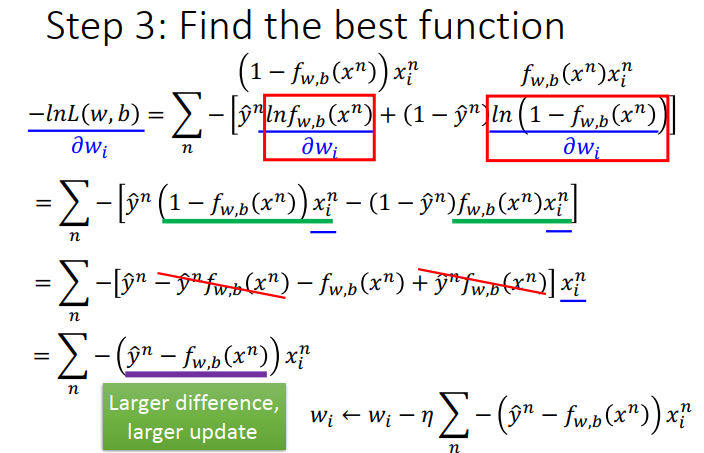

先算左边(红色框)的偏导,再算右边红色框的偏导,再整理式子:

对比:

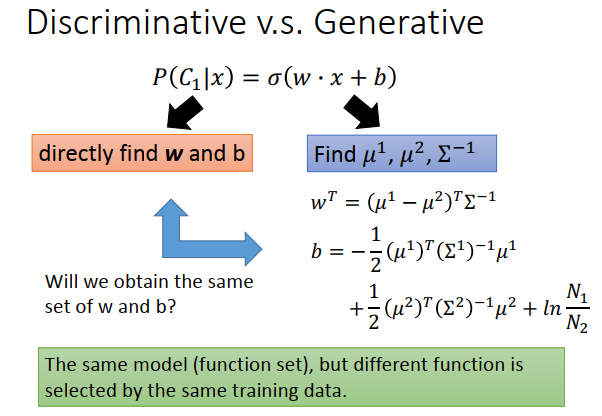

2、生成模型 vs 判别模型(Generative Model VS Discriminative Model)

两种不同的model,得到的 w,b 的参数不同。

但一般来说,判别模型表现得会比生成模型好,为什么?

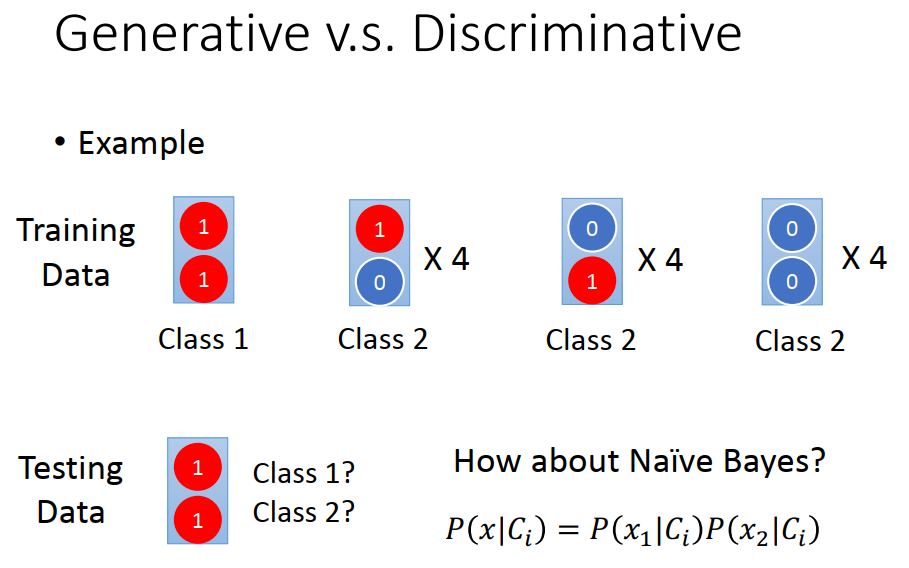

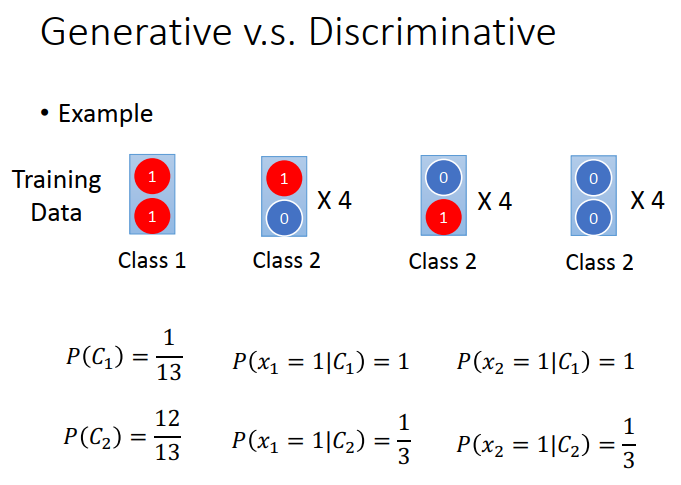

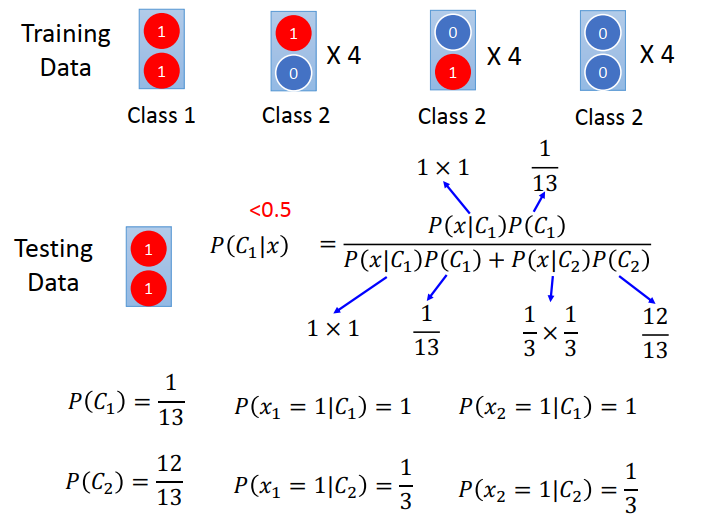

举例

生成模型是基于假想的概率模型的,如果样本不平衡的话,计算出来的概率是会有误差的

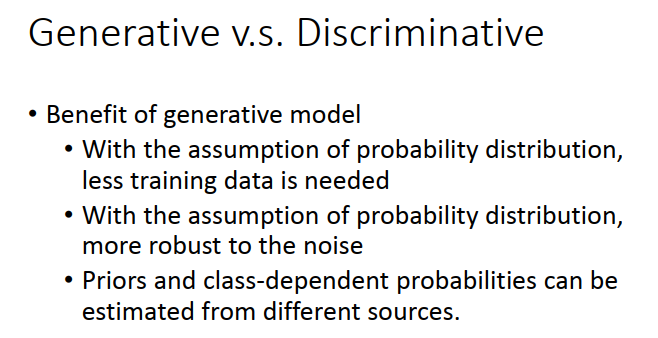

但是生成模型也有优点:

1、样本量少的时候表现比判别模型好,因为它能自己脑补出一个假想模型

2、噪声对它影响较小,因为它没有过分依赖数据,它是按照自己假想模型走的

3、逻辑回归 vs 深度学习(Logistics Regression VS Deep Learning)

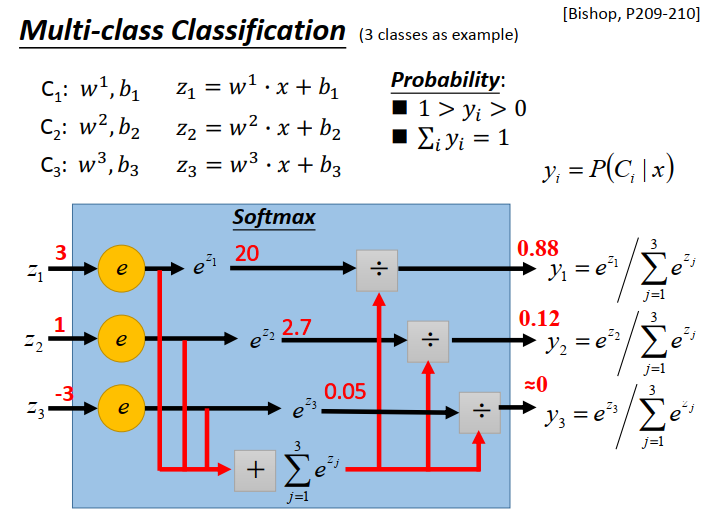

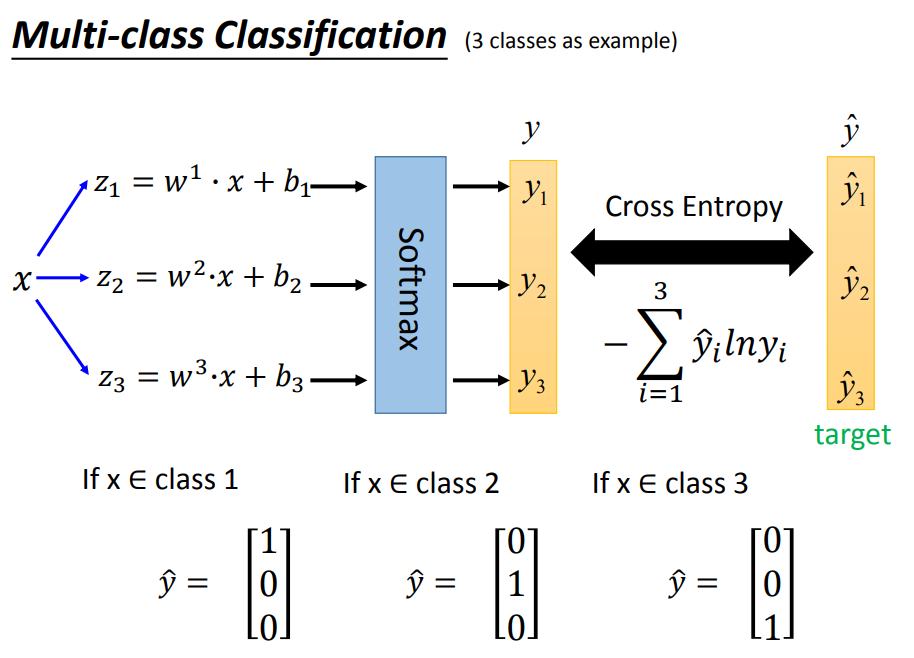

逻辑回归是解决分类问题的,实际中的问题大多是多分类的问题,多分类问题会用到softmax

以下面三分类问题为例:

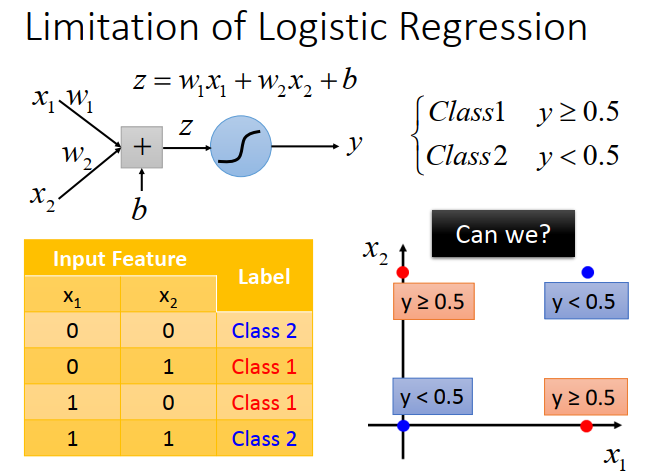

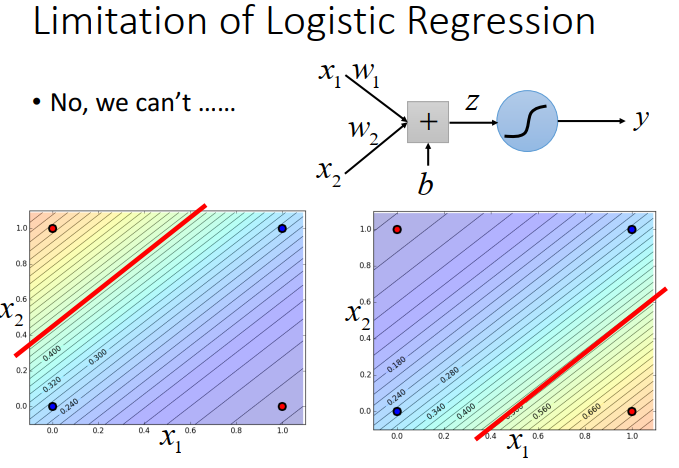

逻辑回归是有它的局限性的,这时候就需要深度学习了!

举例:

我们要用逻辑回归方法分类出下面的红点与蓝点,是需要用特征工程的方法的,而特征工程是需要我们人为地去建立一个特征函数去把这些点转化,实际上是比较难的,或者说比较费工夫的。

但是,实际中,我们很难自己去找所有的特征转换,因此就需要用到深度学习。

将在下面一节学习!!!