LiV-GS: LiDAR-Vision Integration for 3D Gaussian Splatting SLAM in Outdoor Environments

arxiv |哈工大发布 LiV-GS:户外环境中基于3D高斯泼溅的LiDAR-视觉集成SLAM系统

【LiV-GS: LiDAR-Vision Integration for 3D Gaussian Splatting SLAM in Outdoor Environments 】

LiV-GS: LiDAR-Vision Integration for 3D Gaussian Splatting SLAM in Outdoor Environments

摘要:我们提出了 LiV-GS,这是一种室外环境中的 LiDAR 视觉 SLAM 系统,利用 3D 高斯作为可微分的空间表示。值得注意的是,LiV-GS是第一个在大规模室外场景中将离散稀疏激光雷达数据与连续可微高斯图直接对齐的方法,克服了传统激光雷达测绘中固定分辨率的限制。该系统使用前端跟踪的共享协方差属性将点云与高斯图对齐,并将法线方向集成到损失函数中以细化高斯图。为了可靠且稳定地更新 LiDAR 视场外的高斯分布,我们引入了一种新颖的条件高斯约束,将这些高斯分布与最近的可靠高斯分布紧密对齐。有针对性的调整使 LiV-GS 能够以 7.98 FPS 的速率实现快速、准确的映射以及新颖的视图合成。大量的对比实验证明了LiV-GS在SLAM、图像渲染和建图方面的优越性能。成功的跨模态雷达-LiDAR 定位凸显了 LiV-GS 在跨模态语义定位和高斯地图对象分割方面的应用潜力。

一、简介

SLAM(同步定位与建图)对于大规模场景重建至关重要,它基于精确定位重建观察到的场景。作为场景重建的两种常用传感器,激光雷达和相机塑造了SLAM技术的发展。传统的激光雷达 SLAM 利用点云中的几何和精确深度信息来实现精确定位。最近出现的神经辐射场 (NeRF) [1] 和 3D 高斯分布 (3DGS) [2] 通过更详细的环境表示丰富了视觉 SLAM。点云、体素和面元等传统地图表示在地图绘制中受到有限分辨率的影响 [3],而隐式神经场需要昂贵的计算资源。相比之下,3DGS 使用高斯椭球体作为高效地图,允许自适应空间特征表示和快速渲染。考虑到精确 SLAM 和逼真场景重建的需求,3D 高斯喷射作为一种有效结合激光雷达和相机传感器优势的强大方法应运而生。

室外 SLAM 和场景重建面临着独特的挑战,例如照明变化和无界深度尺度,这使得基于 RGBD 的室内解决方案不够充分 [4]-[8]。虽然激光雷达在室外环境中精确距离测量方面表现出色,由于激光雷达点云的稀疏性和不连续性,在不同视图之间保持像素对应关系具有挑战性。手持测绘等现有方法依赖重复测绘来增强图像深度,这对于仅从相机角度捕获单个视图的移动机器人平台来说是不切实际的。

最后,我们介绍 LiV-GS,这是一个 SLAM 框架,它使用 3D 高斯空间表示来无缝集成 LiDAR 和相机图像。我们的方法通过将渲染的高斯协方差与当前观测值对齐来估计机器人姿态,并在后端校正漂移并更新高斯图。为了克服无界场景中视觉和激光雷达之间的深度连续性问题,我们提出了一种基于激光雷达点云的高斯分割方法,确保地图更新时的适当分布约束。

我们的研究贡献总结如下:

1)我们提出了一种使用3D高斯表示的统一激光雷达相机室外SLAM框架,在高精度定位过程中实现增量建图和高质量的新视图合成;

2)我们引入了有效的高斯-LiDAR对准方法,包括用于稳定跟踪的法线方向约束以及基于密度和法线一致性的加权机制以考虑不同高斯的可靠性;

3)我们提出了用于地图更新的条件高斯分布约束,允许使用LiDAR先验传播可靠的高斯分布来表示整个场景,甚至包括LiDAR点不可用的对象或片段。

二.相关工作

A. 大规模重建

大规模场景重建的现有任务依赖于已知的姿态和稀疏点云来渲染环境。对于无界大场景,主要改进集中在从鸟瞰 (BEV) 角度约束高斯贴图、利用细节层次 (LoD) 或划分渲染区域以加速渲染并增强计算稳定性。在 3D Gaussian Splatting 的原始工作的基础上,[9] 提出了一种树状结构,它使用视图内的投影尺寸来选择性地包含或排除特定节点,从而提高渲染效率。研究工作 DoGaussian [10] 通过分区渲染技术引入了改进。 [11]中的GaussianCity创新地处理了通过将视觉视角转换为 BEV 并采用编码-解码策略进行高效处理来生成点云。 Octree-GS [12]利用八叉树数据结构来有效管理场景的多级细节。 EfficientGS [13] 结合了选择性致密化策略,并在球谐函数 (SH) 中应用稀疏阶增量。 GaussianPro [14] 引入了高斯渐进传播方法,使用深度和法线约束来有效渲染大型无纹理场景区域。

B. 基于3DGS的LiDAR-视觉融合

LiDAR数据的集成显着增强了3DGS在大规模场景重建方面的能力。 LiDAR 的利用涉及使用从 LiDAR SLAM 获得的点云地图和姿态作为初始输入,取代传统的 SfM 数据。例如,DrivingGaussian [15] 提取图像特征并投影合并的 LiDAR 扫描帧,从而增强特征集成。 3DGS-ReLoc [16] 和 Gaussian-LIC [17] 使用来自 LiDAR 点云和相应图像的直接输入来训练 3D 地图,从而实现更详细的环境模型。 LIV-GaussianMap [18] 通过采用显式八叉树结构来推进点云管理,而 TCLC-GS [19] 构建隐式特征网格的分层八叉树,使用颜色投影进行进一步的 3DGS 优化。 LetsGo [20] 将细节级别 (LoD) 渲染集成到 3DGS 中,使用各种分辨率的高斯函数来有效地表示 3D 场景。

另一种方法将 3DGS 直接集成到 SLAM 流程中。例如,MM-Gaussian[21]使用点云配准算法来估计相机位姿,并将这些点云直接合并到地图中以增强优化。该方法实现了增量建图的可视化,并利用高保真场景重建来逆向优化姿态,同时实现接近最优的定位精度和建图质量。这些方法共同强调了 LiDAR 在完善 3D 重建过程中的关键作用。

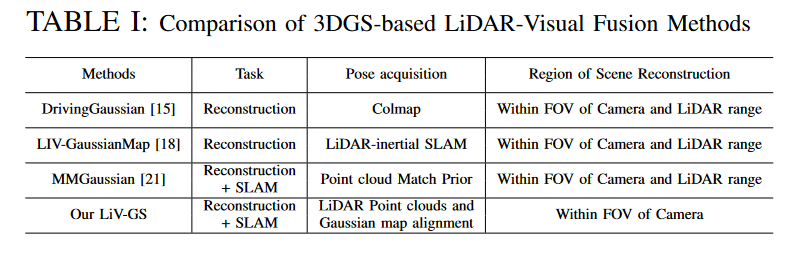

与我们的研究最密切相关的工作包括 DrivingGaussian [15]、LIV-GaussMap [18] 和 MMGaussian [21]。如表1所示,现有方法通常将SLAM和密集高斯建图的任务分开,其中要么使用LiDAR点云来代替SfM,要么将点云直接匹配为跟踪先验,然后通过渲染损失来优化姿态基于高斯映射。相比之下,我们的 LiV-GS 框架在集成高斯地图表示中优化了姿态估计和地图更新。此外,虽然现有的基于 3DGS 的室外 SLAM 方法仅关注捕获 LiDAR 点云和视觉像素的区域,但由于我们从 LiDAR 衍生出的新颖的高斯分裂方法,我们的方法可以高质量地重建 LiDAR 视场之外的场景。基于高斯。

三.方法

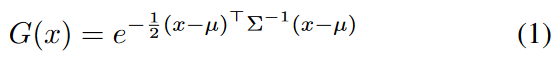

我们的 LiV-GS 是一种户外视觉 LiDAR SLAM 系统,采用 3D 高斯进行环境表示。高斯分布在数学上表示为:

其中 μ 和 Σ 分别表示高斯的均值和协方差矩阵。在我们的模型中,每个高斯由 gi = {α, c, μ, Σ} 定义,其中 α 表示不透明度,c 表示颜色,直接从原始像素数据导出。与[22]相同,为了简单和速度,我们省略了球谐函数。

A.系统概述

如图1所示,LiV-GS的整个系统包括四个模块:数据预处理、跟踪、优化和地图更新。来自激光雷达和视觉传感器的多模态测量集成在数据预处理中,然后输入前端跟踪模块。在前端,系统采用前一时刻渲染的高斯椭球体结合当前点云进行帧到地图匹配。关键帧通过视觉区域的共同可见性进行评估,并附加到高斯图上。然后在后端处理包含关键帧参数的高斯地图,以进行位姿优化和地图更新。高斯图通过最小化损失函数,结合高斯函数的分裂和剪枝操作不断更新高斯函数的参数。

图 1:系统概述:SLAM 系统包括跟踪和优化过程,共同支持高斯地图的视觉表示。

地图更新过程使用 LiDAR 深度和颜色监督来调整新的高斯。

在所提出的系统中,数据输入包括来自相机的图像和来自激光雷达传感器的点云。使用校准的外部数据集成这些输入,将时间对齐的 LiDAR 点云转换为深度图像。

该变换由以下方程控制:

![]()

其中P表示LiDAR点云中的点,RC L和tC L分别表示从LiDAR到相机坐标系的旋转矩阵和平移向量,K是相机的固有矩阵。这种转换将 LiDAR 数据与视觉数据对齐,促进从 RGB 角度实现统一的深度感知。

B. 前端跟踪

前端跟踪的主要挑战来自于如何将由颜色监督导出的可变密度高斯与具有固定分辨率的 LiDAR 点云对齐。受[4]、[23]和[24]的启发,我们采用点云和高斯的共享属性协方差作为集成的桥梁。确定每个激光雷达点的法线方向后,我们将其与高斯的最短轴对齐。为了进一步促进稳定跟踪,我们引入了高斯加权函数,该函数区分仅由颜色监督生成的高斯和那些也通过LiDAR深度中点云的误差计算和高斯匹配。

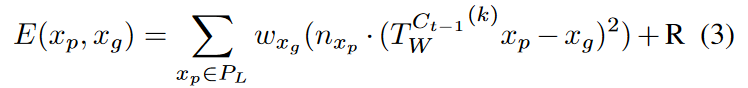

点云和高斯分布:最初,我们维护一个滑动窗口,从最近 10 次帧中过滤和选择高斯分布,同时屏蔽掉剩余的高斯分布。这个选择过程使高斯与我们关注的子地图内的匹配保持相关性。然后,我们利用增量误差最小化函数来确保平面和点之间的精确对应,如下所示:

其中xp表示LiDAR点云PL中的一个点,T Ct−1 W (k)对应于基于前一时刻的姿态到世界坐标系的第k次迭代后的当前姿态估计,xg表示高斯的中心最接近 T Ct−1 W (k)xp,nxp 是 xp 的法向量。 wxg是代表点xg的置信度的权重,下一段将详细介绍。

引入正则化项R进一步增强误差函数的稳定性和精度,该函数考虑了法线之间的方向误差:

![]()

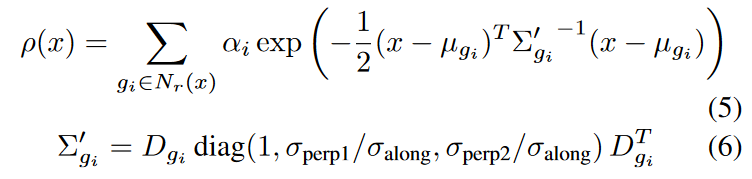

正则化项将乘以超参数进行调整,旨在加强法线的对齐。权重函数构造:点云的可靠权重与其密度密切相关,如图2所示。为了构造结合正态一致性和密度因子的权重函数,我们首先识别局部区域内所有最近的高斯分布中心球形区域 Nr(x),其中 x 是球体中心,r 是半径。这些高斯中心是通过最小化从点 x 到每个高斯中心 μgi 的距离来确定的。密度函数 ρ(x) 如下:

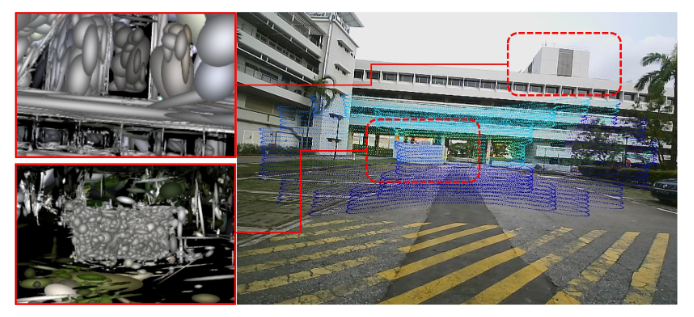

图 2:密度和权重之间的关系:仅基于颜色监督的高斯导致各向同性和稀疏高斯(左上)。

来自 LiDAR 的密集深度输入区域通常显示较高密度的高斯分布(左下)。

其中Σ′gi是重建的协方差矩阵,通过选择沿法线方向的最小方差σ和在垂直方向上的较大方差σperp来实现。 Dgi 是由法线及其垂线形成的正交基。由于优化过程中高斯法线的长度难以限制,因此我们对点云和高斯都引入了法线长度归一化,从而通过法线的稳定方向来保证跟踪算法的鲁棒性。

另外,由于(5)在匹配过程中涉及到每点高斯密度的计算,为了加快计算过程,我们在跟踪时简化了(5)中的密度函数计算:

对于每个点 x,我们计算当前高斯分布的正态分布 nxg 与局部平均正态分布 ̄ n 之间的一致性 C(x),即 C(x) = nxg · ̄ n。最终的权重函数W(x)定义为正态一致性和密度函数W(x) = C(x)ρ(x)的乘积。

共同可见性评估:我们通过评估当前关键帧和最后一个关键帧之间高斯函数的重叠来测量共同可见性。如果共同可见性低于指定阈值,则该帧将被指定为关键帧。为了保证前视视角下的快速跟踪始终将当前点云与足够的高斯椭球相匹配,将关键帧中的点云直接添加到高斯图上,使用像素颜色和沿着射线传播方向缩放点云协方差进行初始化。随后,后端通过将增强高斯图与先前关键帧的视角进行比较来优化增强高斯图,从而导致高斯图的增量更新。

C.后端优化

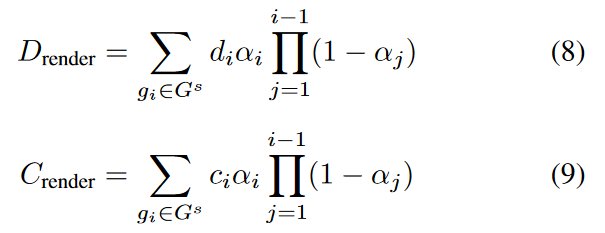

后端优化过程检索关键帧标识符序列及其相应的参数,并进行两轮优化。第一次仅限于滑动窗口内关键帧的位姿,而第二次旨在更新高斯图。 3D高斯图Gs的深度和颜色渲染过程推导如下:

其中 di 和 ci 表示沿相机光线到高斯 gi 的距离和颜色。用于优化高斯参数的损失函数设计为:

![]()

其中前两个术语在现有研究工作中常用:光度误差Epho表示视觉地面实况与渲染图像之间的差异,而几何误差Egeo衡量LiDAR深度输入与渲染深度图像之间的差异。第三项 Enormal = ∥σalong∥ 量化沿法线方向的平均方差的范数。

与室内 3D 高斯分布不同,室内 3D 高斯分布是由密集的 RGB-D 图像构建的堆叠高斯分布,而室外场景通常具有更大且稀疏的高斯分布。为了将高斯函数与物体表面紧密对齐,我们引入了法线损失 Enormal,它针对更短且更稳定的法线进行了优化。如图3所示,通过引入法线损失,3D高斯图的法线更加稳定,大大提高了渲染质量。

图 3:法线限制的效果:顶部:椭圆体可视化。中:渲染图像。底部:渲染的放大细节。

左侧比较(红色)说明不受控制的高斯增长导致显着的伪影。

右侧的比较(绿色)显示了由各向同性高斯分布引起的渲染图像中的间隙。我们的方法有效地防止了这些问题。

D. 地图更新

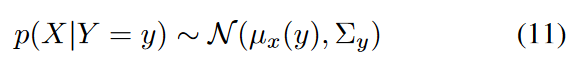

为了管理无界场景中天空的表示,我们采用类似于[9]的方法,用 100,000 个高斯基元初始化场景外的天空盒。随着高斯贴图的增量构建,该天空盒会动态更新。在地图初始化和更新期间,主要有两种类型的高斯:从颜色监督 X 导出的高斯和由 LiDAR 测量 Y 提供的高斯。我们引入条件高斯约束(CGC)来通过损失函数(10)调整颜色监督高斯的位置。对于通过颜色监督获得的每个点x,从以下选择最接近的高斯yLiDAR 测量的高斯集。此外,假设给定 y,x 服从高斯分布:

其中μx(y)是通过正态分布采样从高斯y分裂出新的高斯椭球的位置,Σy是高斯y的协方差。

条件高斯方程 (11) 调整 x 的均值 μx 和协方差 Σx,使它们与最接近的可靠高斯 y 更接近地对齐。从可靠高斯分裂出来的新高斯经过一轮后端优化后被认为是可靠高斯,这个过程一直持续到所有高斯都成为可靠高斯。如图4所示,新分割的点将严格遵循现有可靠点的分布模式,特别是在形状复杂或表面特征明显的区域。

图 4:通过条件高斯约束 (CGC) 进行分裂的效果。

我们的方法通过引入的 CGC 增强了图像中缺乏 LiDAR 深度输入的对象的高斯表示。

四.实验

在实验中,我们从定位精度、渲染质量和高斯图空间分布的可靠性三个方面评估LiV-GS,并将其与其他SOTA算法进行比较。

为了评估轨迹误差,我们使用开源工具rpg轨迹评估[25]来计算绝对轨迹误差(ATE)和相对误差(RE),测量ATE均方根误差(RMSE)漂移(m) 、平均平移 RMSE 漂移 (%) 和平均旋转 RMSE 漂移 (°/100 m)。

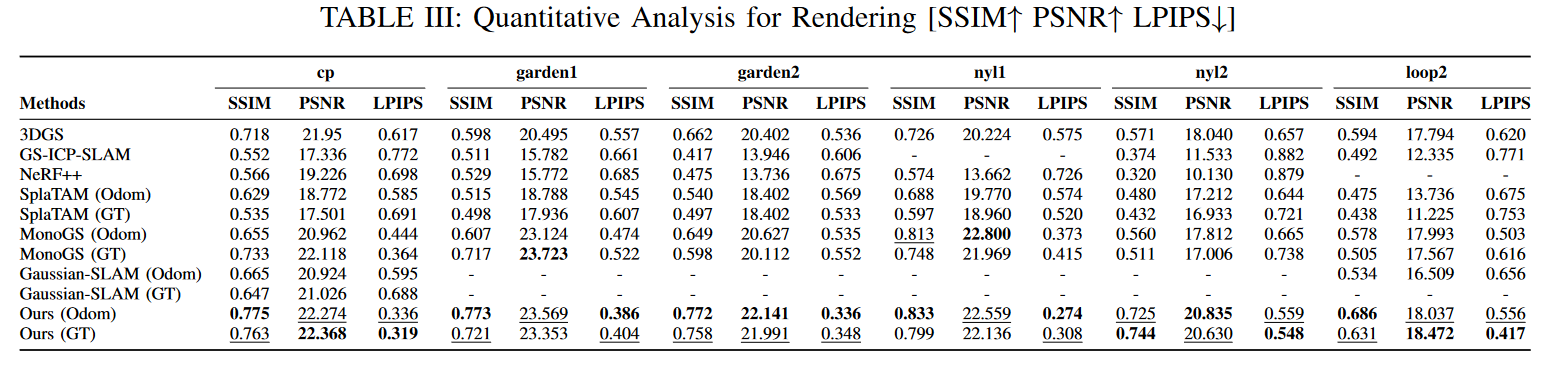

为了进行渲染评估,提取了每种算法的优化视点,并使用 SSIM、PSNR[dB] 和 LPIPS 指标与实际图像进行比较。

A.实现细节

LiDAR和图像数据使用时间戳进行同步,以及R3Live获得的轨迹[26]使用集成视觉、LiDAR 和 IMU 数据的算法作为地面实况。作为轨迹精度,LiV-GS与已建立的基于点云的几何SLAM算法HDL图SLAM[27]、基于图像特征的视觉SLAM算法ORB-SLAM3[28]和基于隐神经场的NeRF-LOAM[3]进行了比较],以及基于3D Gaussian Splatting的开源SLAM算法如MonoGS [22]、Gaussian-SLAM [29]、GSICP-SLAM [4] 和 SplaTAM [30]。使用 3DGS、NeRF++ [31]、MonoGS、Gaussian-SLAM、GS-ICP-SLAM 和 SplatTAM 等算法在 gtpose 及其里程计下进行图像渲染质量比较。所有算法均在配备 NVIDIA RTX 4090 GPU 的桌面上运行。

B. 数据集

为了有效评估我们的 LiV-GS,我们利用了开源大型数据集 NTU4DRadLM,其中包括三种不同类型传感器收集的数据:10Hz 的 LivoxHorizon LiDAR、分辨率为 640 × 480 的单目相机和4D毫米波雷达Eagle Ocuill G7。我们的方法不使用 IMU 数据。由于在长距离室外场景中保持光度一致性的挑战,我们将低速、公里长的场景分割为几个较短的序列。对于 cp 序列,我们使用了前 2400 个 LiDAR 相机对齐的图像,覆盖约 230 米。对于花园和尼尔序列,我们从每个序列的开头和结尾分别选择了 2100 和 2400 个图像,每个片段至少覆盖 220 米。此外,对于在人类驾驶车辆平台上记录的 Loop2 序列,我们选择了覆盖约 250 米的 300 帧。我们总共测试了六个序列来全面验证我们的 LiV-GS 方法。

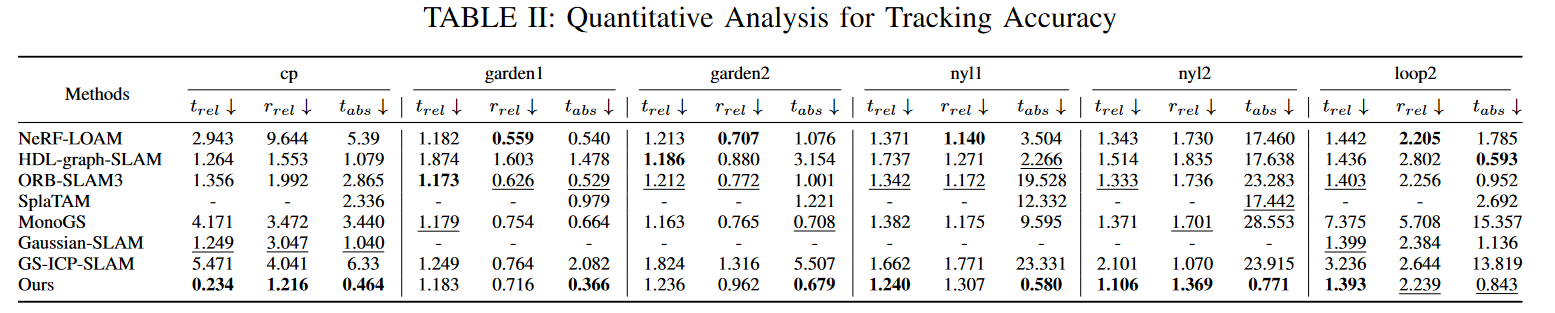

C. 跟踪精度评估

图 5 和表 II 分别显示了定位精度的定性和定量评估。我们的 LiVGS 展示了低速序列中最低的 ATE。然而,在高速序列循环2中,由于连续帧之间的位移较大以及高斯图优化不足导致的稀疏高斯分布,LiVGS的精度略低于NeRF-LOAM。 MonoGS、SplaTAM、GS-ICP-SLAM和GaussianSLAM都是为室内环境量身定制的,具有纹理良好的图像和密集的深度信息,但由于室外场景中获得的深度信息稀疏,它们在一些室外序列中会出现性能下降甚至失败。相比之下,我们的 LiV-GS 在大规模室外环境中跟踪一致且稳定。

图 5:在 NTU4DRadLM 数据集的四个序列上使用不同 SLAM 算法的轨迹比较。

此外,表 III 中的底部两行显示 LiVGS 里程计结果与地面实况结果之间的渲染差异最小,这进一步证明了 LiV-GS 里程计的高精度,因为更高的定位精度导致渲染质量损失更小。

D. 渲染评估

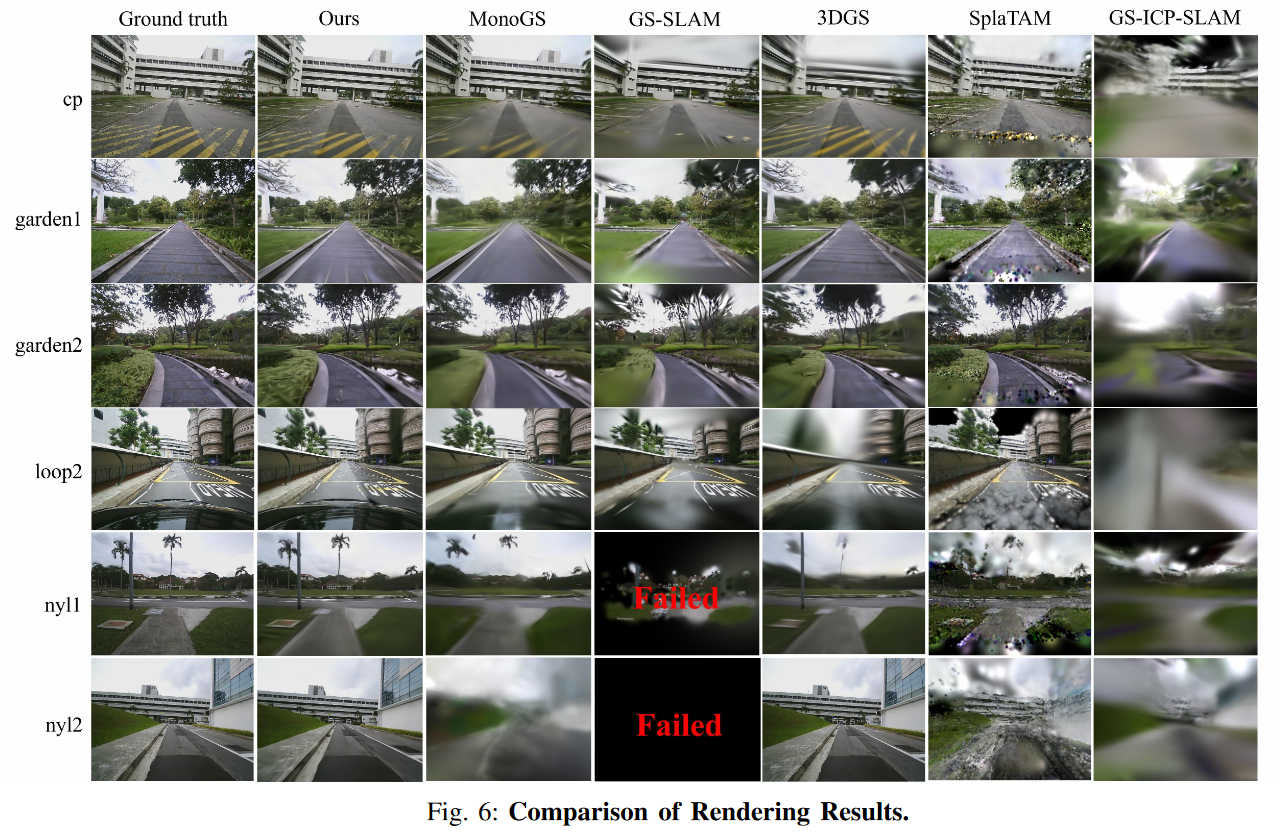

表 III 比较了在同一平台上实现的所有可重现的开源算法的渲染结果。 3DGS 和 NeRF++ 不执行姿态估计并利用 COLMAP 来获取初始输入。 SplaTAM、MonoGS 和 Gaussian-SLAM 依靠损失函数来优化姿态,因此我们将渲染结果复制两次:一次使用地面真实姿态,一次使用自己估计的姿态。

图6展示了图像渲染的定性结果,3DGS的渲染质量受到深度先验的缺乏和SLAM运动过程中获得的有限视角的影响。 LiVGS 渲染的图像表现出非凡的清晰度,捕捉到细微的细节,例如建筑结构和建筑物的轮廓、地面纹理、树木和灌木的树叶细节,甚至汽车引擎盖上的反射。渲染的保真度不仅证明了 LiV-GS 的有效性,还突显了其保留复杂视觉细节的能力。

图 6:渲染结果比较。

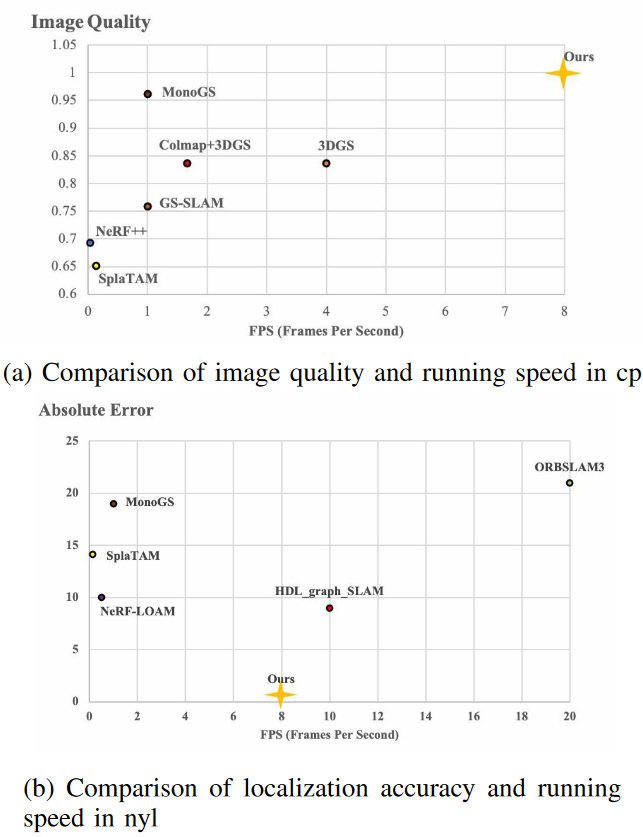

E.性能和运行时间之间的评估

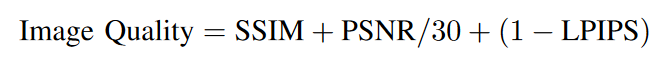

为了进一步估计LiV-GS的效率和性能之间的权衡,我们比较了运行时间和之前评估的性能指标之间的关系。直接使用ATE RMSE衡量定位精度,通过归一化综合得分计算各算法的图像质量:

如图所示。如图 7a 和 7b 所示,LiV-GS 在精度和渲染质量方面同时达到了最先进的性能,运行速度为 7.98 FPS,由于 LiDAR 采样率为 10 Hz,显示了其在实时 SLAM 应用中的潜力。

从各模块的运行时间来看,前端跟踪和关键帧选择模块平均每次运行时间为0.07 ms。当后端同时配置5个关键帧优化时,位姿优化和地图更新模块的平均运行时间分别为0.04 ms和0.09 ms。值得注意的是,我们的LiV-GS系统采用异步通信机制,因此整个系统的运行时间并不等于各个模块运行时间的总和。

图 7:性能指标和系统运行时间的比较。

FPS 计算为处理的帧总数与总时间的比率。 7.98 FPS 的值意味着平均一秒可以处理 7.98 个深度图和 RGB 图像。

F. 几何精度的定性分析

为了评估LiV-GS构建的高斯图的空间几何分布,我们进行了跨模态分析高斯地图上的毫米波雷达定位。与激光雷达不同,毫米波雷达的点云更加稀疏,分辨率较低,噪声较高。只有当激光雷达和图像生成的高斯地图的空间几何足够准确和可靠时,鲁棒的跨模态雷达定位才有可能。

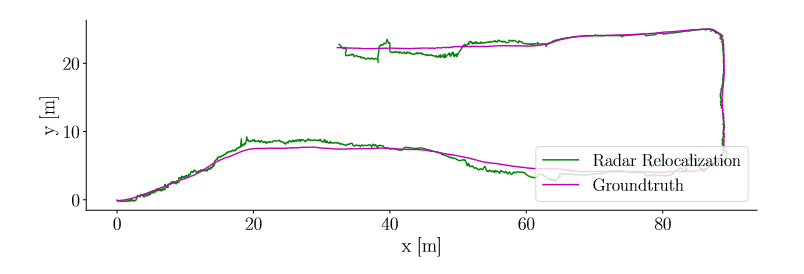

对于 NTU4DRadLM 数据集中的序列 cp,我们首先使用 LiV-GS 基于摄像机和 LiDAR 数据构建高斯图,然后使用 HDL 定位算法在高斯图上重新定位雷达数据 [27]。图 8 强调,即使使用跨模态雷达数据,也可以使用高斯地图始终实现准确定位。它证实了LiV-GS的高斯图提供了准确的几何结构信息,显示出其在全天候户外定位和导航等其他下游任务中的巨大潜力。

图 8:跨模态毫米波雷达定位轨迹的可视化。

G. 闭环验证

在本小节中,我们验证 LiV-GS 在闭环序列中的性能。我们从 R3Live [26] 提供的手持扫描数据集中截获了香港大学公园 00 数据的闭环序列,其中包括 30Hz 的 1280×1024 图像和 10Hz 的 Livox-Avia LiDAR 点云。

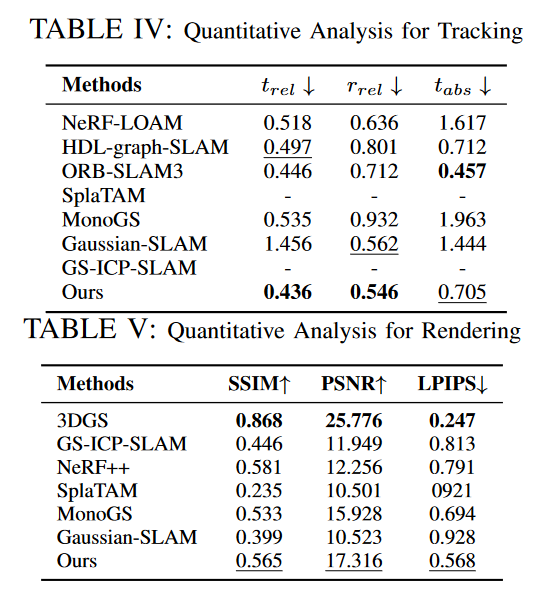

定量结果如表 IV 和 V 所示。在这个循环序列中,我们的 LiV-GS 仍然表现良好,但其性能偶尔落后于其他一些算法。原因之一是 LiV-GS 缺乏闭环检测模块来优化累积漂移。另一方面,由于 LiV-GS 不利用球谐函数来表示颜色。从闭环位置的不同视点观察同一场景的不同颜色可能会导致高斯椭球体的大量重叠,这可能会导致性能下降。如何解决闭环和颜色细化的问题将是我们未来研究的重点。

五、结论

我们提出了一种新颖的户外 SLAM 系统,利用 3D 高斯作为空间表示,集成 LiDAR 相机数据。该系统通过协方差将激光雷达点云与高斯地图紧密集成以进行跟踪,并使用视觉信息来优化全局高斯分布。条件高斯约束指导高斯椭球分裂,特别是对于由于激光雷达深度不可用而缺乏几何约束的高斯椭球。该方法利用视觉纹理连续性和激光雷达可靠性来构造具有一致深度约束的椭球体。

实验验证我们的系统实现了稳健、精确的定位,并且可以渲染清晰的场景图像。据我们所知,这是首次在室外环境中使用3D高斯地图成功实现跨模态雷达-激光雷达定位,标志着室外3DGS SLAM的巨大潜在应用。