大数据-hive 添加分区

1、静态分区

1> 添加一个

alter table t2 add partition (city=‘shanghai’);

2> 添加多个

alter table t2 add partition (city=‘chengdu’) partition(city=‘tianjin’);

3> 添加分区指定位置

alter table log_mess add partition (year =2013,month=2,day=2) location ‘/user/2013/02/02’; --新的分区不在 log_mess的子目录中

4> 修改表,分区路径重新指定

alter table log_mess partition(year =2012,month=1,day=2) set location ‘/user/2012/01/02’;

这个命令不会将数据从旧的路径转移走,也不会删除旧的数据

2、动态分区

3、分区注意细节

尽量不要使用动态分区,因为动态分区将会为每一个分区分配reducer数量,当分区数量多的时候,reducer数量

将会增加,对服务器是一种灾难

动态分区和静态分区的区别,静态分区不管有没有数据都将会创建该分区,动态分区是有结果集将创建,否则不创建

hive动态分区的严格模式和hive提供的hive.mapred.mode的严格模式。

hive提供我们一个严格模式:为了阻止用户不小心提交恶意hql

hive.mapred.mode=nostrict : strict

如果该模式值为strict,将会阻止以下三种查询:

(1)、对分区表查询,where中过滤字段不是分区字段。

(2)、笛卡尔积join查询,join查询语句,不带on条件 或者 where条件。

(3)、对order by查询,有order by的查询不带limit语句

————————————————

版权声明:本文为CSDN博主「大富的大数据之路」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/yaoyelinger0912/article/details/95781169

文末查看关键字,回复赠书

一、理论基础

1.Hive分区背景

在Hive Select查询中一般会扫描整个表内容,会消耗很多时间做没必要的工作。有时候只需要扫描表中关心的一部分数据,因此建表时引入了partition概念。

2.Hive分区实质

因为Hive实际是存储在HDFS上的抽象,Hive的一个分区名对应hdfs的一个目录名,并不是一个实际字段。

3.Hive分区的意义

辅助查询,缩小查询范围,加快数据的检索速度和对数据按照一定的规格和条件进行查询,更方便数据管理。

4.常见的分区技术

hive表中的数据一般按照时间、地域、类别等维度进行分区。

二、单分区操作

1.创建分区表

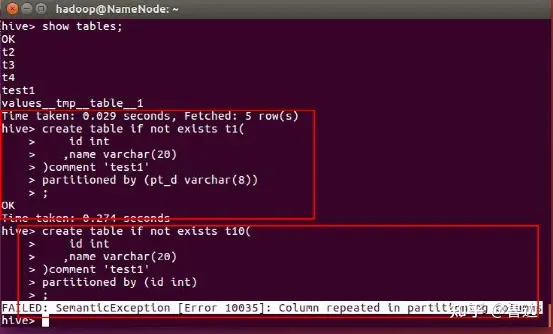

create table if not exists t1(

id int

,name string

,hobby array

,add map

)

partitioned by (pt_d string)

row format delimited

fields terminated by ','

collection items terminated by '-'

map keys terminated by ':'

;注:这里分区字段不能和表中的字段重复。 如果分区字段和表中字段相同的话,会报错,如下:

create table t10(

id int

,name string

,hobby array<string>

,add maptring,string>

)

partitioned by (id int)

row format delimited

fields terminated by ','

collection items terminated by '-'

map keys terminated by ':'

;报错信息:FAILED: SemanticException [Error 10035]: Column repeated in partitioning columns

报错信息

2.装载数据

需要加载的文件内容如下:

1,xiaoming,book-TV-code,beijing:chaoyang-shagnhai:pudong

2,lilei,book-code,nanjing:jiangning-taiwan:taibei

3,lihua,music-book,heilongjiang:haerbin执行load data

load data local inpath '/home/hadoop/Desktop/data' overwrite into table t1 partition ( pt_d = '201701');3.查看数据及分区

查看分区数据,使用和字段使用一致。

select * from t1 where pt_d = '201701';结果

1 xiaoming ["book","TV","code"] {"beijing":"chaoyang","shagnhai":"pudong"} 201701

2 lilei ["book","code"] {"nanjing":"jiangning","taiwan":"taibei"} 201701

3 lihua ["music","book"] {"heilongjiang":"haerbin"} 201701查看分区

show partitions t1;4.插入另一个分区

再创建一份数据并装载,分区=‘000000’

load data local inpath '/home/hadoop/Desktop/data' overwrite into table t1 partition ( pt_d = '000000');查看数据:

select * from t1;

1 xiaoming ["book","TV","code"] {"beijing":"chaoyang","shagnhai":"pudong"} 000000

2 lilei ["book","code"] {"nanjing":"jiangning","taiwan":"taibei"} 000000

3 lihua ["music","book"] {"heilongjiang":"haerbin"} 000000

1 xiaoming ["book","TV","code"] {"beijing":"chaoyang","shagnhai":"pudong"} 201701

2 lilei ["book","code"] {"nanjing":"jiangning","taiwan":"taibei"} 201701

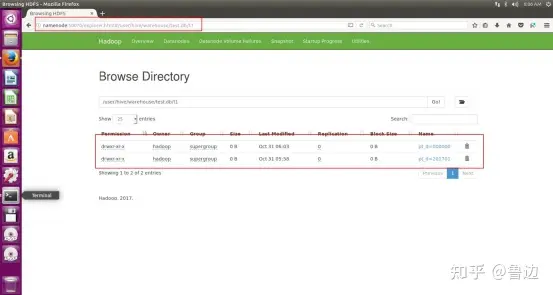

3 lihua ["music","book"] {"heilongjiang":"haerbin"} 2017015.观察HDFS上的文件

去hdfs上看文件

http://namenode:50070/explorer.html#/user/hive/warehouse/test.db/t1

可以看到,文件是根据分区分别存储,增加一个分区就是一个文件。

查询相应分区的数据

select * from t1 where pt_d = ‘000000’添加分区,增加一个分区文件

alter table t1 add partition (pt_d = ‘333333’);

删除分区(删除相应分区文件)

注意,对于外表进行drop partition并不会删除hdfs上的文件,并且通过msck repair table table_name可以同步回hdfs上的分区。

alter table test1 drop partition (pt_d = ‘20170101’);三、多个分区操作

1.创建分区表

create table t10(

id int

,name string

,hobby array<string>

,add maptring,string>

)

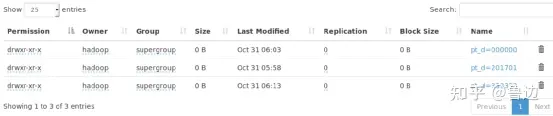

partitioned by (pt_d string,sex string)

row format delimited

fields terminated by ','

collection items terminated by '-'

map keys terminated by ':'

;2.加载数据(分区字段必须都要加)

load data local inpath ‘/home/hadoop/Desktop/data’ overwrite into table t10 partition ( pt_d = ‘0’);如果只是添加一个,会报错:FAILED: SemanticException [Error 10006]: Line 1:88 Partition not found ”0”

load data local inpath '/home/hadoop/Desktop/data' overwrite into table t10 partition ( pt_d = '0',sex='male');

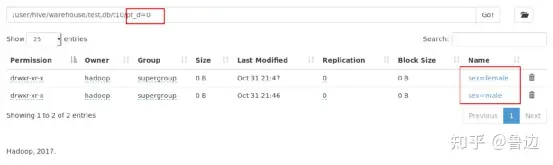

load data local inpath '/home/hadoop/Desktop/data' overwrite into table t10 partition ( pt_d = '0',sex='female');观察HDFS上的文件,可发现多个分区具有顺序性,可以理解为windows的树状文件夹结构。

四、表分区的增删修查 1.增加分区 这里我们创建一个分区外部表

create external table testljb (

id int

) partitioned by (age int);添加分区

官网说明:

ALTER TABLE table_name ADD [IF NOT EXISTS] PARTITION partition_spec [LOCATION 'location'][, PARTITION partition_spec [LOCATION 'location'], ...];

partition_spec:

: (partition_column = partition_col_value, partition_column = partition_col_value, ...)实例说明

- • 一次增加一个分区

altertable testljb addpartition(age=2); - • 一次增加多个同级(分区名相同)分区

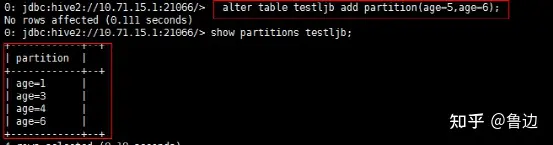

altertable testljb addpartition(age=3)partition(age=4); - • 注意:一定不能写成如下方式:

altertable testljb addpartition(age=5,age=6);如果我们show partitions table_name 会发现仅仅添加了age=6的分区。

这里猜测原因:因为这种写法实际上:具有多个分区字段表的分区添加,而我们写两次同一个字段,而系统中并没有两个age分区字段,那么就会随机添加其中一个分区。

父子级分区增加:

举个例子,有个表具有两个分区字段:age分区和sex分区。那么我们添加一个age分区为1,sex分区为male的数据,可以这样添加:

alter table testljb add partition(age=1,sex='male');2.删除分区

删除分区age=1

alter table testljb drop partition(age=1);注:加入表testljb有两个分区字段(上文已经提到多个分区先后顺序类似于windows的文件夹的树状结构),partitioned by(age int ,sex string),那么我们删除age分区(第一个分区)时,会把该分区及其下面包含的所有sex分区一起删掉。

3.修复分区

修复分区就是重新同步hdfs上的分区信息。

msck repair table table_name;4.查询分区

show partitions table_name;上一篇:数据仓库与数据集市建模

下期预告:hive的动态分区与静态分区

按例,我的个人公众号:鲁边社,欢迎关注

后台回复关键字 [hive],随机赠送一本鲁边备注版珍藏大数据书籍。

posted on 2023-08-10 21:11 ExplorerMan 阅读(2635) 评论(0) 收藏 举报

浙公网安备 33010602011771号

浙公网安备 33010602011771号